HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 17-18

|

|

|

- Ζήνων Καραβίας

- 7 χρόνια πριν

- Προβολές:

Transcript

1 HMY 795: Αναγνώριση Προτύπων Διαλέξεις Νευρωνικά Δίκτυα(Neural Networks) - συνέχεια

2 Minimum squared-error procedure for classification 1 ( T T wls = X X) X b= Xb Xw= b Logistic sigmoidal function Softmax function Logistic regression 2 classes T σ ( w x+ w ) = pc ( x) = σ ( a) 0 1 K classes g k T y= g( w x+ w ) T w x w = a= T ( w x ) ( ) + w0 = pck x = j p( x C ) pc ( ) 1 1 ln p ( x C2 ) pc ( 2 ) exp( αk ) exp( α ) j

3 Generalized logistic regression 2 classes Likelihood Cross-entropy error function ελαχιστοποίηση Επαναληπτικός υπολογισμός του w

4 Νευρωνικά δίκτυα (Neural networks): Αρχιτεκτονικές που μας προσφέρουν ευελιξία στην αναπαράσταση μη γραμμικών απεικονίσεων σε προβλήματα παλινδρόμησης/ ταξινόμησης της μορφής Δίκτυο πρόσω τροφοδότησης (feed-forward) 2στρωμάτων weights biases y = g( a ) k = 1, 2,..., K k k M D (2) (1) yk = g wkj h wjixi k = 1, 2,..., K j= 0 i= 0

5 Kolmogorov stheorem neural nets: Οποιαδήποτε συνεχής απεικόνιση y(x),όπου το xέχει διάσταση D μπορεί να αναπαρασταθεί ακριβώς από ένα δίκτυο τριών στρωμάτων με D(2D+1)μονάδες στο πρώτο στρώμα και 2D+1 στο δεύτερο -Universal approximation property of neural networks Επίσης ένα νευρωνικό δίκτυο με τρία στρώματα και συναρτήσεις ενεργοποίησης κατωφλίου ή σιγμοειδείς μπορεί να αναπαραστήσει σύνορα οποιασδήποτε μορφής με αυθαίρετη ακρίβεια Οι τιμές των συντελεστών w που αντιστοιχούν σε μια συγκεκριμένη απεικόνιση δεν είναι μοναδικές Συναρτήσεις ενεργοποίησης 0, a< 0 g( a) = 1, a 0 a a e e tanh( a) = = 2 σ ( a) 1 a a e + e

6 Συναρτήσεις σφάλματος Συνεχής έξοδος/έξοδοι Μοναδιαία συνάρτηση ενεργοποίησης στην έξοδο g(.) Πιθανοφάνεια Συνάρτηση σφάλματος E E y = a =y t a Ταξινόμηση 2 κλάσεις Συνάρτηση ενεργοποίησης Πιθανοφάνεια Συνάρτηση σφάλματος E a k k k k k k =y k t k N tn p( t x,w) = y( x,w) {1 y( x,w)} n= 1 n N n= 1 n 1 t { } E( w) = t ln y + (1 t )ln(1 y ) n n n n n

7 Ταξινόμηση Κ κλάσεις Συναρτήσεις ενεργοποίησης Πιθανοφάνεια Συνάρτηση σφάλματος E y = a =y t aa k k k k k N K = n= 1 k= 1 tnk p( T w) y nk

8 Εκπαίδευση δικτύου Error backpropagation Error backpropagationalgorithm: Πρώτη αναφορά το 1969, όμως εκτεταμένη εφαρμογή μετά το 1986 (Rumelhart, Hinton, Williams) Ο όρος προέρχεται από το ότι έχουμε διάδοση «σφαλμάτων» προς τα πίσω σε ένα δίκτυο σύμφωνα με τον αλγόριθμο Επαναληπτική διαδικασία με τρία βασικά διακριτά στάδια σε κάθε βήμα 1. Οι τιμές όλων των z k, y k του δικτύου υπολογίζονται από τις «τρέχουσες» τιμές των παραμέτρων 2. Οι παράγωγοι της συνάρτησης σφάλματος ως προς τα βάρη wυπολογίζονται με βάση τις «τρέχουσες» τιμές των τελευταίων 3. Οι παράγωγοι αυτές χρησιμοποιούνται για να ενημερωθούν οι τιμές των βαρών w(π.χ. gradient descent) Όπως θα δούμε η «διάδοση» των σφαλμάτων γίνεται στο στάδιο 1

9 Εκπαίδευση δικτύου Error backpropagation Στη γενική περίπτωση, έστω ότι έχουμε ένα δίκτυο πρόσω τροφοδότησης με (οποιεσδήποτε) συναρτήσεις ενεργοποίησης οι οποίες είναι διαφορίσιμεςκαι με συνάρτηση σφάλματος Ε(w) μπορεί να είναι π.χ. κάποια από αυτές που ήδη είδαμε Ο αλγόριθμος χρησιμοποιεί επανειλημμένα τον κανόνα αλυσίδας (chain rule) f ( nw ( )) f nw ( ) = w n w Σε μια γενική αρχιτεκτονική πρόσω τροφοδότησης, κάθε μονάδα υπολογίζει το γραμμικό συνδυασμό: και στη συνέχεια τον (στη γενική περίπτωση μη γραμμικό) μετασχηματισμό h της παραπάνω: Σημ: αν z 0 =1 περιλαμβάνονται και biases

10 Error backpropagation Ξεκινάμε από την έξοδο του δικτύου. Η συνάρτηση σφάλματος είναι: Θέλουμε να υπολογίσουμε την παράγωγο του E n ως προς τον συντελεστή w ji (2) (δεύτερο στρώμα). Από τον κανόνα αλυσίδας: (1) Ορίζοντας το σφάλμα δ j ως και επειδή η (1) γράφεται: j Για το στρώμα εξόδου όμως, είδαμε ότι και στις 3 περιπτώσεις συναρτήσεων κόστους(sum-ofsquares, cross-entropy, multi-class entropy) που εξετάσαμε έχουμε: δ j = yj tj οπότε η ποσότητα όντως αντιστοιχεί στο «σφάλμα» μεταξύ πρόβλεψης του δικτύου και παρατηρήσεων και στις 3 περιπτώσεις!

11 Error backpropagation Πηγαίνουμε ένα στρώμα πίσω. H παράγωγος ως προς τα βάρη του πρώτου στρώματος είναι: όπου ορίζουμε το σφάλμα για το πρώτο στρώμα παρόμοια με πριν, δηλ.: Η παράγωγος και το σφάλμα εξαρτώνται μόνο τις μονάδες του επόμενου στρώματος με τις οποίες υπάρχει σύνδεση. Τελικά: δ δ ak a z k j (2) j k = k h '( aj ) kwkj a δ = = z a δ k j k j j k Διάδοση σφαλμάτων προς τα πίσω (backpropagation) καθώς και Τελικά λοιπόν:

12 Μάλιστα για το πρώτο στρώμα έχουμε: άρα: Error backpropagation Πηγαίνοντας προς τα πίσω με τον ίδιο τρόπο μπορούμε να φτάσουμε μέχρι το στρώμα εισόδου και να υπολογίσουμε επαναληπτικά όλους τους συντελεστές (αν έχουμε παραπάνω στρώματα)

13 Error backpropagation Ο αλγόριθμος λοιπόν λειτουργεί ως εξής: 1. Αρχικοποίηση w(συνήθως τυχαίοι αριθμοί κοντά στο μηδέν) 2. Για οποιοδήποτε διάνυσμα εκπαίδευσης x n πηγαίνουμε προς τα μπροστά και υπολογίζουμε όλα τα zκαιaτου δικτύου: Βήμα 2 3. Υπολογίζουμε τα σφάλματα εξόδου από την: 4. Πηγαίνουμε προς τα πίσω και υπολογίζουμε τα σφάλματα δ = h'( a ) δ w j j k kj k 5. Υπολογίζουμε τις παραγώγους και ενημερώνουμε τις τιμές των συντελεστών Βήμα 4 w( k+ 1) = w( k) nk ( ) J ( w) Σημ: Οι συναρτήσεις ενεργοποίησης μπορεί να είναι διαφορετικές σε κάθε στρώμα/μονάδα

14 Error backpropagation Παράδειγμα: Δίκτυο 2 στρωμάτων, τετραγωνικό σφάλμα,μοναδιαίες συναρτήσεις ενεργοποίησης στην έξοδο (y k =α k ) και συναρτήσεις ενεργοποίησης για τις κρυμμένες μονάδες: Βήμα 2 για την οποία ισχύει: Συνάρτηση σφάλματος: 1. Αρχικοποίηση 2. Forward propagation

15 Error backpropagation 3. Σφάλμα εξόδου 4. Backpropagation για τις κρυμμένες μονάδες τα σφάλματα είναι: 5. Υπολογισμός παραγώγων και ενημέρωση Βήμα 4

16 Error backpropagation Και εδώ μπορούμε να έχουμε εκπαίδευση single-sample ή batch Ένα πέρασμα όλων των δεδομένων: epoch Single-sample/stochastic: τυχαία παρουσίαση αρχικοποίηση w(1), n(1), θ επιλογή τυχαίου δείγµατος E wji ( k+ 1) = wji ( k) nk ( ) w µέχρι J ( w) θ Online: παρουσίαση δειγμάτων με τη σειρά Batch k=1, αρχικοποίηση w(1), n(1), θ k=k+1 x n w ji n x n Em m= 1: N, w = w nk ( ), w ( k+ 1) = w ( k) + w w µέχρι J ( w) ji ji ji ji ji ji m x θ

17 The Jacobian matrix Τα στοιχεία του πίνακα αυτού ορίζονται ως: Μας δίνουν μια ιδέα της «ευαισθησίας» του δικτύου σε (μικρές) μεταβολές κάθε εισόδου x i Και αυτή η παράγωγος μπορεί να υπολογιστεί μεμε τον κανόνα αλυσίδας ως εξής: όπου το jπεριλαμβάνει όλες τις μονάδες με τις οποίες συνδέεται η είσοδος x i Επιπλέον είδαμε ήδη ότι: όπου lόλεςοι μονάδες που συνδέονται με τημονάδα j

18 Για σιγμοειδείς συναρτήσεις εξόδου: The Jacobian matrix Για συναρτήσεις softmax: δ: Kronecker delta

19 Hessian matrix Hessian: πίνακας των δεύτερων παραγώγων της συνάρτησης σφάλματος ως προς τις παραμέτρους ενός δικτύου 2 E Hij = wji wlk Επιτάχυνση εκπαίδευσης Κανονικοποίηση Bayesian networks Για Wσυνολικά βάρη και biases Ο(W 2 )υπολογισμοί Σε κάποιες περιπτώσεις απαιτείται η αντιστροφή της Hessian -προσέγγιση με διαγώνιο πίνακα (Bishop 5.4.1). Αν έχουμε Ν δείγματα το συνολικό σφάλμα είναι: N = n= 1 E E n Mπορούμε να υπολογίσουμε την Hessian σε κάθε σημείο και να αθροίσουμε. Για το δίκτυο δύο στρωμάτων, τα στοιχεία του πίνακα μπορούν να υπολογιστούν με τον ίδιο τρόπο που είδαμε για τις πρώτες παραγώγους (backpropagation- chain rule)

20 Τελικά προκύπτει Βάρη δεύτερου στρώματος Βάρη πρώτου στρώματος Hessian matrix Βάρη πρώτου και δεύτερου στρώματος όπου: και Ι jj τoστοιχείo (j,j )του μοναδιαίου πίνακα Εκτός από την προσέγγιση με διαγώνιο πίνακα, χρησιμοποιούνται και άλλες προσεγγίσεις (outer product approximation Bishop 5.4.2)

21 Κανονικοποίηση Αριθμός εισόδων/εξόδων: καθορίζεται από το πρόβλημα Αριθμός κρυμμένων μονάδων: καθορίζεται από το χρήστη με τη σειρά του καθορίζει την ικανότητα γενίκευσης του δικτύου Δυσκολία: Ύπαρξη τοπικών ελάχιστων, εξάρτηση από αρχικές συνθήκες

22 Κανονικοποίηση Όπως και στην παλινδρόμηση μπορούμε να θεωρήσουμε συνάρτηση σφάλματος της μορφής Έστω το δίκτυο 2 στρωμάτων με γραμμικές συναρτήσεις ενεργοποίησης εξόδου. Τι γίνεται αν εφαρμόσουμε γραμμικό μετ/σμό στην είσοδο ή/και στην έξοδο? Αν, μπορούμε να κρατήσουμε την απεικόνιση σταθερή αν

23 Παρομοίως, αν : Κανονικοποίηση Θα θέλαμε όταν το δίκτυο εκπαιδευτεί με τα αρχικά και τα μετ/σμένα δεδομένα, η απεικόνιση που προκύπτει να είναι συμβατή με τα παραπάνω Η απλή κανονικοποίηση ( ) δεν πληροί αυτή την προϋπόθεση. Όμως η: όπου W 1, W 2 τα σύνολα των βαρών του πρώτου και δεύτερου στρώματος (εκτός των biases)αν οι σταθερές λ 1 και λ 2 μετασχηματιστούν σύμφωνα με: λ a 1/2 1 1 λ c λ λ 1/2 2 2 είναι αμετάβλητη ως προς το γραμμικό μετασχηματισμό (όχι όμως και τη μετατόπιση) - Invariant regularizer under linear transformation

24 Κανονικοποίηση Η κανονικοποίηση αυτής της μορφής είναι ισοδύναμη με το να χρησιμοποιήσουμε εκ των προτέρων κατανομή για τα βάρη και να πάρουμε εκτίμηση MAP: Σημ: Η προηγούμενη σχέση δεν περιλαμβάνει τους συντελεστές bias, για τους οποίους μπορούμε να διαλέξουμε ξεχωριστές εκ των προτέρων κατανομές.

25 Τερματισμός εκπαίδευσης Άλλος ένας τρόπος ελέγχου της ισοδύναμης πολυπλοκότητας (effective complexity) ενός δικτύου είναι ο τερματισμός της εκπαίδευσης με βάση ένα σύνολο επικύρωσης (validation set)και η χρήση ενός τρίτου συνόλου (testing set) για τον υπολογισμό της απόδοσης Καμπύλες μάθησης (learning curves) Για τα δεδομένα εκπαίδευσης: μονοτονική μείωση, όχι όμως και για τα δεδομένα επικύρωσης Μάλιστα αν σταματήσουμε μετά από τεπαναλήψεις και η σταθερά μάθησης είναι n, η ποσότητα nτείναι αντιστρόφως ανάλογη με την σταθερά κανονικοποίησης λ

26 Πρακτικά ζητήματα Συναρτήσεις ενεργοποίησης Μη γραμμικές, συνεχείς hκαι h Για προβλήματα ταξινόμησης, μοντέλα βιολογικών νευρωνικών δικτύων saturated h(πχ σιγμοειδείς) Για προβλήματα παλινδρόμησης μη γραμμικότητες με μεγαλύτερο δυναμικό εύρος (π.χ. πολυωνυμικές ιστοσελίδα) Μονοτονικότηταεπίσης μπορεί να είναι επιθυμητή -καλύτερη συμπεριφορά της συνάρτησης σφάλματος ως προς τοπικά/ολικά ελάχιστα Γραμμικότητα για μικρές τιμές του ορίσματος Η σιγμοειδής σ(α)(ή ισοδύναμα η tanh(α)) πληροί αρκετές από τις παραπάνω και έχει χρησιμοποιηθεί αρκετά Αν οι συναρτήσεις ενεργοποίησης είναι π.χ. σιγμοειδείς ή πολυωνυμικές, κάθε δείγμα xμπορεί να επηρεάσει περισσότερες από μια μονάδες (global representation), αν όμως οι συναρτήσεις είναι τοπικές (π.χ. Γκαουσιανές radial basis function networks), λιγότερες μονάδες θα είναι ενεργέςγια κάθε δείγμα για λίγα δεδομένα εκπαίδευσης πιθανόν καλύτερα αποτελέσματα

27 Πρακτικά ζητήματα Κανονικοποίηση δεδομένων: Τα χαρακτηριστικά με μεγαλύτερες τιμές θα επηρεάζουν την επαναληπτική διαδικασία πολύ περισσότερο, δηλ. τα αντίστοιχα βάρη θα αλλάζουν πολύ πιο γρήγορα! Συνήθης πρακτική: κανονικοποίηση δεδομένων εισόδουώστε να έχουν μηδενική μέση τιμή και μοναδιαία τυπική απόκλιση (data standardization) Αρχικοποίηση βαρών: Δεν μπορούμε να διαλέξουμε w(0)=0! Γενικά θέλουμε να έχουμε ομοιόμορφη μάθηση, δηλ. όλα τα βάρη να συγκλίνουν περίπου μετά τον ίδιο αριθμό επαναλήψεων. Αν εφαρμόσουμε και κανονικοποίηση, οπότε έχουμε θετικές και αρνητικές τιμές χαρακτηριστικών συνήθως επιλέγουμε αρχικές τιμές μεταξύ -Wκαι W(πχ από μια ομοιόμορφη κατανομή), όπου το Wδεν πρέπει να είναι πολύ μικρό ή μεγάλο (αργή μάθηση/κορεσμός για σιγμοειδείς). Π.χ. αν έχουμε σιγμοειδείς συν. ενεργοποίησης μπορούμε να διαλέξουμε το W ώστε να βρισκόμαστε στη γραμμική περιοχή τους

28 Πρακτικά ζητήματα Σταθερές μάθησης: Εφόσον η σύγκλιση σε ολικό ελάχιστο δεν είναι εγγυημένη, η επιλογή μπορεί να επηρεάσει την ποιότητα της τελικής λύσης. Είδαμε ότι αν η συνάρτηση κόστους προσεγγιστεί από τετραγωνική μορφή, η βέλτιστη επιλογή είναι η αντίστροφη της Hessian(μέθοδος Newton), δηλ. για κάθε βάρος μπορούμε να χρησιμοποιήσουμε: 1 2 E nopt = 2 ή κάποια προσέγγιση αυτής (π.χ. διαγώνια) w ji Momentum: Επιταχύνει τη μάθηση σε περιοχές με μικρή κλίση της w( k+ 1) = w( k) + (1 α) w ( k) + α w( k 1) E όπου wbp ( k) = nk ( ) w ij bp x k Συνήθως α γύρω στο 0.9. Γενικά πιο ομαλή σύγκλιση Αριθμός στρωμάτων: Τρία στρώματα επιτυγχάνουν καθολική προσέγγιση, άρα στις περισσότερες περιπτώσεις δεν υπάρχει ανάγκη για παραπάνω, εκτός από ειδικές συνθήκες (π.χ. αν θέλουμε αμεταβλητότητα ως προς θέσηστη συνέχεια)

29 Αμεταβλητότητα (invariance) Σε πολλά προβλήματα αναγνώρισης προτύπων είναι επιθυμητό η πρόβλεψη του δικτύου να παραμένει αμετάβλητη όταν οι μεταβλητές εισόδου (features) μετασχηματίζονται είτε κατά πλάτος ή κατά θέση (scale/translation invariant) Ένας τρόπος είναι να έχουμε μεγάλο πλήθος δεδομένων εκπαίδευσης που καλύπτουν όλες τις περιπτώσεις (όχι πάντα εφικτό) Εναλλακτικά: Μπορούμε να δημιουργήσουμε «τεχνητά» πρότυπα ξεκινώντας από τα αρχικά δεδομένα εκπαίδευσης και εφαρμόζοντας μετασχηματισμούς που αντιστοιχούν στη ζητούμενη αμεταβλητότητα (π.χ. μετατόπιση, περιστροφή)

30 Αμεταβλητότητα (invariance) Εναλλακτικά: Κανονικοποίηση (tangent propagation Bishop) Προεπεξεργασίαδεδομένων (pre-processing): Επιλέγουμε χαρακτηριστικά των δεδομένων μας που παραμένουν αμετάβλητα υπό τους μετασχηματισμούς που μας ενδιαφέρουν πχ ροπές, principal component analysis Ενσωμάτωση της αμεταβλητότητας στη δομή του δικτύου π.χ. στην περίπτωση εικόνων, τα γειτονικά pixels είναι περισσότερο συσχετισμένα. Μπορούμε να έχουμε ένα στρώμα που εξάγει τοπικάχαρακτηριστικά (από μικρές περιοχές της αρχικής εικόνας) και τα ενσωματώνει στα επόμενα στρώματα.

31 Αμεταβλητότητα (invariance) Convolutional neural networks: Οι μονάδες στο στρώμα συνέλιξης λαμβάνουν πληροφορία από μικρές «γειτονιές» της αρχικής εικόνας, π.χ. 5x5 pixels. Όλες οι μονάδες συνδέονται με βάρη ίδιων τιμών με τις γειτονιές αυτές (weight sharing), άρα έχουμε 25 βάρη (+1 bias) και στην ουσία οι μονάδες «ανιχνεύουν» τα ίδια χαρακτηριστικά αλλά από άλλες περιοχές της εικόνας. Αν η εικόνα μετατοπιστεί, το χαρακτηριστικό θα μετατοπιστεί επίσης. Για περισσότερα χαρακτηριστικά περισσότερα στρώματα συνέλιξης. Subsampling layer: περαιτέρω αμεταβλητότητα Παρόμοια εκπαίδευση (backpropagation) Εφαρμογές σε αναγνώριση χειρόγραφων χαρακτήρων, προσώπων κλπ

32 Εκπαίδευση συναρτήσεων ενεργοποίησης Μέχρι στιγμής εξετάσαμε τον αλγόριθμο backpropagationγια την εκπαίδευση των βαρών μόνο Είδαμε όμως ότι οι αρχιτεκτονικές νευρωνικών δικτύων μπορούν να μας βοηθήσουν στην επιλογή συναρτήσεων βάσης από τα δεδομένα, δηλ. των φ j στον γενικό μετασχηματισμό Μπορούμε να εκπαιδεύσουμε π.χ. και τις συναρτήσεις ενεργοποίησης? Ναι backpropagation. Έστω π.χ. συναρτήσεις ενεργοποίησης με: Μπορούμε να εκπαιδεύσουμε και την παράμετρο λ υπολογίζοντας την ποσότητα: Επίσης μπορούμε να διαλέξουμε διαφορετικές παραμέτρους λ για κάθε κρυμμένη μονάδα ή/και στρώμα

33 Radial basis function networks Μια δημοφιλής κατηγορία νευρωνικών δικτύων χρησιμοποιεί τοπικές συναρτήσεις ενεργοποίησης - συνήθως Γκαουσιανές π.χ.:

34 Bayesian neural networks Μέχρι στιγμής χρησιμοποιήσαμε μέγιστη πιθανοφάνεια για την εκπαίδευση ενός δικτύου Κανονικοποίηση: ισοδύναμη με εκτίμηση MAP Μπορούμε να χρησιμοποιήσουμε και την Μπεϋζιανή θεώρηση Στην περίπτωση της γραμμικής παλινδρόμησης με Γκαουσιανόθόρυβο πήραμε αναλυτικά αποτελέσματα για τις εκ των υστέρων κατανομές των συντελεστών w και την προγνωστική κατανομή (predictive distribution) Εδώ δεν μπορεί να γίνει το ίδιο: προσεγγίσεις (variationalinference/laplace approximation) Στην περίπτωση συνεχούς μεταβλητής στόχου t η πιθανοφάνεια είναι: Κανονική εκ των προτέρων κατανομή για τα βάρη: Πιθανοφάνεια για Ν ανεξάρτητες παρατηρήσεις D={t 1,t 2,,t N }:

35 Εκ των υστέρων κατανομή: Bayesian neural networks Η κατανομή αυτή, λόγω της μη γραμμικής εξάρτησης του y(x,w)ως προς w δεν είναι κανονικήως προς w Ένας τρόπος (Laplace approximation) είναι να προσεγγίσουμε αυτή την κατανομή με κανονική, γύρω από το μέγιστο της εκ των υστέρων κατανομής (δηλ. της εκτίμησης MAP). Αυτό γίνεται ελαχιστοποιώντας την: Ισοδυναμία με κανονικοποίηση οι μερικές παράγωγοι υπολογίζονται με backpropagation. Η κανονική προσέγγιση της posterior δίνεται τότε από(laplace approximation): όπου Η: Hessian Μπορούμε προσεγγιστικά να πάρουμε αποτελέσματα επίσης για την προγνωστική κατανομή και τις υπερπαραμέτρους α,β(generalized likelihood Bishop 5.7.1)

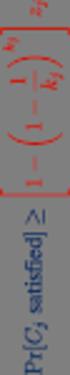

36 Bayesian neural networks Για δίκτυο ταξινόμησης σε 2 κλάσεις με σιγμοειδή συνάρτηση ενεργοποίησης εξόδου η πιθανοφάνεια είναι: Και πάλι θεωρούμε κανονική εκ των προτέρων κατανομή για τα βάρη με ακρίβεια α. Όπως και στην περίπτωση συνεχούς t υπολογίζουμε το w MAP ελαχιστοποιώντας (backpropagation) την: Κατόπιν, υπολογίζουμε την Hessian και η εκ των υστέρων κατανομή παίρνει και πάλι τη μορφή Το α μπορεί να υπολογιστεί μεγιστοποιώντας την περιθωριακή πιθανοφάνεια

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 17 18 Νευρωνικά Δίκτυα (Neural Networks) συνέχεια Minimum squared error procedure for classification 1 ( T T wls = X X) X b= X b Xw = b Logistic sigmoidal function

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 17 18 Νευρωνικά Δίκτυα (Neural Networks) συνέχεια Minimum squared error procedure for classification 1 ( T T wls = X X) X b= X b Xw = b Logistic sigmoidal function

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 15-16

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15 16 Λογιστική παλινδρόμηση (Logistic regression) Νευρωνικά Δίκτυα (Neural Networks) g ( x) = w x+ w T k k k0 1 ( T T WLS = X X) X T= X T Γραμμικές διαχωριστικές

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15 16 Λογιστική παλινδρόμηση (Logistic regression) Νευρωνικά Δίκτυα (Neural Networks) g ( x) = w x+ w T k k k0 1 ( T T WLS = X X) X T= X T Γραμμικές διαχωριστικές

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9 20 Kernel methods Support vector machines Εκπαίδευση νευρωνικών δικτύων backpropagation:. Υπολογισμός μεταβλητών δικτύου «τρέχον» w () () (2) (2) aj = wji xi ak

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9 20 Kernel methods Support vector machines Εκπαίδευση νευρωνικών δικτύων backpropagation:. Υπολογισμός μεταβλητών δικτύου «τρέχον» w () () (2) (2) aj = wji xi ak

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 11-12 Γραμμική παλινδρόμηση συνέχεια Γραμμική παλινδρόμηση συνέχεια Γραμμικές διαχωριστικές συναρτήσεις Γραμμική παλινδρόμηση (Linear regression) y = w + wx + + w

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 11-12 Γραμμική παλινδρόμηση συνέχεια Γραμμική παλινδρόμηση συνέχεια Γραμμικές διαχωριστικές συναρτήσεις Γραμμική παλινδρόμηση (Linear regression) y = w + wx + + w

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP)

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 3 Επιλογή μοντέλου Επιλογή μοντέλου Θεωρία αποφάσεων Επιλογή μοντέλου δεδομένα επικύρωσης Η επιλογή του είδους του μοντέλου που θα χρησιμοποιηθεί σε ένα πρόβλημα (π.χ.

HMY 795: Αναγνώριση Προτύπων Διάλεξη 3 Επιλογή μοντέλου Επιλογή μοντέλου Θεωρία αποφάσεων Επιλογή μοντέλου δεδομένα επικύρωσης Η επιλογή του είδους του μοντέλου που θα χρησιμοποιηθεί σε ένα πρόβλημα (π.χ.

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 13-14

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 13-14 Γραμμικές διαχωριστικές συναρτήσεις(συνέχεια) Επιλογή μοντέλου Δεδομένα επικύρωσης Κανονικοποίηση Bayes Model evidence(τεκμήριο): Η πιθανότητα να παρατηρήσουμε

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 13-14 Γραμμικές διαχωριστικές συναρτήσεις(συνέχεια) Επιλογή μοντέλου Δεδομένα επικύρωσης Κανονικοποίηση Bayes Model evidence(τεκμήριο): Η πιθανότητα να παρατηρήσουμε

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

HMY 795: Αναγνώριση Προτύπων. Διάλεξη 2

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Θεωρία πιθανοτήτων Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (αντίθετα με τις ντετερμινιστικές μεταβλητές)

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Θεωρία πιθανοτήτων Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (αντίθετα με τις ντετερμινιστικές μεταβλητές)

Το Πολυεπίπεδο Perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9 10 Γραμμική παλινδρόμηση (Linear regression) Μπεϋζιανή εκτίμηση για την κανονική κατανομή Γνωστή μέση τιμή μ, άγνωστη διασπορά σ 2. Ακρίβεια λ=1/σ 2 : conjugate

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9 10 Γραμμική παλινδρόμηση (Linear regression) Μπεϋζιανή εκτίμηση για την κανονική κατανομή Γνωστή μέση τιμή μ, άγνωστη διασπορά σ 2. Ακρίβεια λ=1/σ 2 : conjugate

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Διαχωριστικές συναρτήσεις Ταξινόμηση κανονικών

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Διαχωριστικές συναρτήσεις Ταξινόμηση κανονικών

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Επανάληψη Expectatio maximizatio for Gaussia mixtures. Αρχικοποιούμε τις άγνωστες παραμέτρους µ k, Σ k και π k 2. Υπολογίσμος των resposibilitiesγ(z k : γ ( z = k π ( x µ ˆ,

HMY 795: Αναγνώριση Προτύπων Επανάληψη Expectatio maximizatio for Gaussia mixtures. Αρχικοποιούμε τις άγνωστες παραμέτρους µ k, Σ k και π k 2. Υπολογίσμος των resposibilitiesγ(z k : γ ( z = k π ( x µ ˆ,

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 7-8 Μπεϋζιανή εκτίμηση - συνέχεια Μη παραμετρικές μέθοδοι εκτίμησης πυκνότητας Δυαδικές τ.μ. κατανομή Bernoulli : Εκτίμηση ML: Εκτίμηση Bayes για εκ των προτέρων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 7-8 Μπεϋζιανή εκτίμηση - συνέχεια Μη παραμετρικές μέθοδοι εκτίμησης πυκνότητας Δυαδικές τ.μ. κατανομή Bernoulli : Εκτίμηση ML: Εκτίμηση Bayes για εκ των προτέρων

ΔΙΚΤΥO RBF. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

Το μοντέλο Perceptron

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Πανεπιστήμιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήμιο Κύπρου Πολυτεχνική Σχολή Τμήμα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδημαϊκό έτος 2010-11 Χειμερινό Εξάμηνο Practice final exam 1. Έστω ότι για

Πανεπιστήμιο Κύπρου Πολυτεχνική Σχολή Τμήμα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδημαϊκό έτος 2010-11 Χειμερινό Εξάμηνο Practice final exam 1. Έστω ότι για

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 7 8 Μπεϋζιανή εκτίμηση συνέχεια Μη παραμετρικές μέθοδοι εκτίμησης πυκνότητας Εκτίμηση ML για την κανονική κατανομή Μπεϋζιανή εκτίμηση για την κανονική κατανομή Γνωστή

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 7 8 Μπεϋζιανή εκτίμηση συνέχεια Μη παραμετρικές μέθοδοι εκτίμησης πυκνότητας Εκτίμηση ML για την κανονική κατανομή Μπεϋζιανή εκτίμηση για την κανονική κατανομή Γνωστή

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 4 o Φροντιστήριο

Ασκήσεις Φροντιστηρίου 4 o Φροντιστήριο Πρόβλημα 1 ο Ο πίνακας συσχέτισης R x του διανύσματος εισόδου x( στον LMS αλγόριθμο 1 0.5 R x = ορίζεται ως: 0.5 1. Ορίστε το διάστημα των τιμών της παραμέτρου μάθησης

Ασκήσεις Φροντιστηρίου 4 o Φροντιστήριο Πρόβλημα 1 ο Ο πίνακας συσχέτισης R x του διανύσματος εισόδου x( στον LMS αλγόριθμο 1 0.5 R x = ορίζεται ως: 0.5 1. Ορίστε το διάστημα των τιμών της παραμέτρου μάθησης

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 6 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων κανονικές τυχαίες μεταβλητές Εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές

HMY 795: Αναγνώριση Προτύπων Διάλεξη 6 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων κανονικές τυχαίες μεταβλητές Εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές

Τεχνητή Νοημοσύνη. 18η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Υπολογιστική Νοημοσύνη. Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning

Υπολογιστική Νοημοσύνη Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning Κεντρική ιδέα Τα παραδείγματα μάθησης παρουσιάζονται στο μηεκπαιδευμένο δίκτυο και υπολογίζονται οι έξοδοι. Για

Υπολογιστική Νοημοσύνη Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning Κεντρική ιδέα Τα παραδείγματα μάθησης παρουσιάζονται στο μηεκπαιδευμένο δίκτυο και υπολογίζονται οι έξοδοι. Για

HMY 220: Σήματα και Συστήματα Ι

Σύγκλιση Σειρών Fourier Ιδιότητες Σειρών Fourier Παραδείγματα HMY 220: Σήματα και Συστήματα Ι ΔΙΑΛΕΞΗ #10 Τρεις ισοδύναμες μορφές: () = = = = Σειρές Fourier j( 2π ) t Τ.. x () t FS a jω0t xt () = ae =

Σύγκλιση Σειρών Fourier Ιδιότητες Σειρών Fourier Παραδείγματα HMY 220: Σήματα και Συστήματα Ι ΔΙΑΛΕΞΗ #10 Τρεις ισοδύναμες μορφές: () = = = = Σειρές Fourier j( 2π ) t Τ.. x () t FS a jω0t xt () = ae =

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Μάθηση και Γενίκευση. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

HMY 220: Σήματα και Συστήματα Ι

Σύγκλιση Σειρών Fourier Ιδιότητες Σειρών Fourier Παραδείγματα HMY 0: Σήματα και Συστήματα Ι ΔΙΑΛΕΞΗ #10 Σειρές Fourier: Προσέγγιση Οι Σειρές Fourier μπορούν να αναπαραστήσουν μια πολύ μεγάλη κλάση περιοδικών

Σύγκλιση Σειρών Fourier Ιδιότητες Σειρών Fourier Παραδείγματα HMY 0: Σήματα και Συστήματα Ι ΔΙΑΛΕΞΗ #10 Σειρές Fourier: Προσέγγιση Οι Σειρές Fourier μπορούν να αναπαραστήσουν μια πολύ μεγάλη κλάση περιοδικών

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 2-22 Support vector machies (συνέχεια) Support vector machies (συνέχεια) Usupervised learig: Clusterig ad Gaussia mixtures Kerel fuctios: k( xx, ') = ϕ ( x) ϕ( x

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 2-22 Support vector machies (συνέχεια) Support vector machies (συνέχεια) Usupervised learig: Clusterig ad Gaussia mixtures Kerel fuctios: k( xx, ') = ϕ ( x) ϕ( x

HMY 799 1: Αναγνώριση Συστημάτων

HMY 799 : Αναγνώριση Συστημάτων Διάλεξη Γραμμική παλινδρόμηση (Linear regression) Εμπειρική συνάρτηση μεταφοράς Ομαλοποίηση (smoothing) Y ( ) ( ) ω G ω = U ( ω) ω +Δ ω γ ω Δω = ω +Δω W ( ξ ω ) U ( ξ) G(

HMY 799 : Αναγνώριση Συστημάτων Διάλεξη Γραμμική παλινδρόμηση (Linear regression) Εμπειρική συνάρτηση μεταφοράς Ομαλοποίηση (smoothing) Y ( ) ( ) ω G ω = U ( ω) ω +Δ ω γ ω Δω = ω +Δω W ( ξ ω ) U ( ξ) G(

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 9-10

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9-10 Γραμμική παλινδρόμηση (Linear regression) Μπεϋζιανή εκτίμηση για την κανονική κατανομή Γνωστή μέση τιμή μ, άγνωστη διασπορά σ 2. Ακρίβεια λ=1/σ 2 : conjugate

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9-10 Γραμμική παλινδρόμηση (Linear regression) Μπεϋζιανή εκτίμηση για την κανονική κατανομή Γνωστή μέση τιμή μ, άγνωστη διασπορά σ 2. Ακρίβεια λ=1/σ 2 : conjugate

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΧΑΡΤΟΓΡΑΦΗΣΗ ΤΟΥ ΧΩΡΟΥ ΤΩΝ ΤΑΞΙΝΟΜΗΤΩΝ Ταξινομητές Ταξινομητές συναρτ. διάκρισης Ταξινομητές επιφανειών απόφ. Παραμετρικοί ταξινομητές Μη παραμετρικοί

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΧΑΡΤΟΓΡΑΦΗΣΗ ΤΟΥ ΧΩΡΟΥ ΤΩΝ ΤΑΞΙΝΟΜΗΤΩΝ Ταξινομητές Ταξινομητές συναρτ. διάκρισης Ταξινομητές επιφανειών απόφ. Παραμετρικοί ταξινομητές Μη παραμετρικοί

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΗ ΓΡΑΜΜΙΚΟΙ ΤΑΞΙΝΟΜΗΤΕΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Η παραπάνω ανάλυση ήταν χρήσιμη προκειμένου να κατανοήσουμε τη λογική των δικτύων perceptrons πολλών επιπέδων

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΗ ΓΡΑΜΜΙΚΟΙ ΤΑΞΙΝΟΜΗΤΕΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Η παραπάνω ανάλυση ήταν χρήσιμη προκειμένου να κατανοήσουμε τη λογική των δικτύων perceptrons πολλών επιπέδων

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν.

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης Ελαχιστοποίηση συνάρτησης σφάλματος Εκπαίδευση ΤΝΔ: μπορεί να διατυπωθεί ως πρόβλημα ελαχιστοποίησης μιας συνάρτησης σφάλματος E(w)

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης Ελαχιστοποίηση συνάρτησης σφάλματος Εκπαίδευση ΤΝΔ: μπορεί να διατυπωθεί ως πρόβλημα ελαχιστοποίησης μιας συνάρτησης σφάλματος E(w)

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 5 6 Principal component analysis EM for Gaussian mixtures: μ k, Σ k, π k. Ορίζουμε το διάνυσμα z (διάσταση Κ) ώστε K p( x θ) = π ( x μ, Σ ) k = k k k Eκ των υστέρων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 5 6 Principal component analysis EM for Gaussian mixtures: μ k, Σ k, π k. Ορίζουμε το διάνυσμα z (διάσταση Κ) ώστε K p( x θ) = π ( x μ, Σ ) k = k k k Eκ των υστέρων

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Component Analysis, PCA)

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ Ενότητα: Αναγνώριση Διεργασίας - Προσαρμοστικός Έλεγχος (Process Identification) Αλαφοδήμος Κωνσταντίνος

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ Ενότητα: Αναγνώριση Διεργασίας - Προσαρμοστικός Έλεγχος (Process Identification) Αλαφοδήμος Κωνσταντίνος

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Version 2 1 Άλλοι τύποι νευρωνικών δικτύων Αυτοοργανούμενοι χάρτες (Self-organizing maps - SOMs) Αναδρομικά νευρωνικά δίκτυα (Recurrent Neural Networks): γενικής

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Version 2 1 Άλλοι τύποι νευρωνικών δικτύων Αυτοοργανούμενοι χάρτες (Self-organizing maps - SOMs) Αναδρομικά νευρωνικά δίκτυα (Recurrent Neural Networks): γενικής

ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ. Ενότητα #8: Βελτιστοποίηση Συστημάτων Ασαφούς Λογικής. Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε.

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #8: Βελτιστοποίηση Συστημάτων Ασαφούς Λογικής Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #8: Βελτιστοποίηση Συστημάτων Ασαφούς Λογικής Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

LOGO. Εξόρυξη Δεδομένων. Δειγματοληψία. Πίνακες συνάφειας. Καμπύλες ROC και AUC. Σύγκριση Μεθόδων Εξόρυξης

Εξόρυξη Δεδομένων Δειγματοληψία Πίνακες συνάφειας Καμπύλες ROC και AUC Σύγκριση Μεθόδων Εξόρυξης Πασχάλης Θρήσκος PhD Λάρισα 2016-2017 pthriskos@mnec.gr LOGO Συμπερισματολογία - Τι σημαίνει ; Πληθυσμός

Εξόρυξη Δεδομένων Δειγματοληψία Πίνακες συνάφειας Καμπύλες ROC και AUC Σύγκριση Μεθόδων Εξόρυξης Πασχάλης Θρήσκος PhD Λάρισα 2016-2017 pthriskos@mnec.gr LOGO Συμπερισματολογία - Τι σημαίνει ; Πληθυσμός

Μη γραµµικοί ταξινοµητές Νευρωνικά ίκτυα

KEΣ 3 Αναγνώριση Προτύπων και Ανάλυση Εικόνας Μη γραµµικοί ταξινοµητές Νευρωνικά ίκτυα ΤµήµαΕπιστήµης και Τεχνολογίας Τηλεπικοινωνιών Πανεπιστήµιο Πελοποννήσου Εισαγωγή Πολυεπίπεδες Perceptron Οαλγόριθµος

KEΣ 3 Αναγνώριση Προτύπων και Ανάλυση Εικόνας Μη γραµµικοί ταξινοµητές Νευρωνικά ίκτυα ΤµήµαΕπιστήµης και Τεχνολογίας Τηλεπικοινωνιών Πανεπιστήµιο Πελοποννήσου Εισαγωγή Πολυεπίπεδες Perceptron Οαλγόριθµος

Τεχνητή Νοημοσύνη. 17η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 17η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Artificia Inteigence A Modern Approach των S. Russe και

Τεχνητή Νοημοσύνη 17η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Artificia Inteigence A Modern Approach των S. Russe και

Συνδυαστική Βελτιστοποίηση Εισαγωγή στον γραμμικό προγραμματισμό (ΓΠ)

Ανάλυση Ευαισθησίας. Έχοντας λύσει ένας πρόβλημα ΓΠ θα πρέπει να αναρωτηθούμε αν η λύση έχει φυσική σημασία. Είναι επίσης πολύ πιθανό να έχουμε χρησιμοποιήσει δεδομένα για τα οποία δεν είμαστε σίγουροι

Ανάλυση Ευαισθησίας. Έχοντας λύσει ένας πρόβλημα ΓΠ θα πρέπει να αναρωτηθούμε αν η λύση έχει φυσική σημασία. Είναι επίσης πολύ πιθανό να έχουμε χρησιμοποιήσει δεδομένα για τα οποία δεν είμαστε σίγουροι

Νευρωνικά Δίκτυα στο Matlab

Νευρωνικά Δίκτυα στο Matlab Ρ202 Μηχανική Ευφυΐα (Machine Intelligence) Ευστάθιος Αντωνίου Τμήμα Μηχανικών Πληροφορικής Αλεξάνδρειο ΤΕΙ Θεσσαλονίκης E-mail: antoniou@itteithegr Πρόγραμμα Μεταπτυχιακών

Νευρωνικά Δίκτυα στο Matlab Ρ202 Μηχανική Ευφυΐα (Machine Intelligence) Ευστάθιος Αντωνίου Τμήμα Μηχανικών Πληροφορικής Αλεξάνδρειο ΤΕΙ Θεσσαλονίκης E-mail: antoniou@itteithegr Πρόγραμμα Μεταπτυχιακών

Κινητά Δίκτυα Επικοινωνιών. Συμπληρωματικό υλικό. Προσαρμοστική Ισοστάθμιση Καναλιού

Κινητά Δίκτυα Επικοινωνιών Συμπληρωματικό υλικό Προσαρμοστική Ισοστάθμιση Καναλιού Προσαρμοστικοί Ισοσταθμιστές Για να υπολογίσουμε τους συντελεστές του ισοσταθμιστή MMSE, απαιτείται να λύσουμε ένα γραμμικό

Κινητά Δίκτυα Επικοινωνιών Συμπληρωματικό υλικό Προσαρμοστική Ισοστάθμιση Καναλιού Προσαρμοστικοί Ισοσταθμιστές Για να υπολογίσουμε τους συντελεστές του ισοσταθμιστή MMSE, απαιτείται να λύσουμε ένα γραμμικό

ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

Τεχνητή Νοημοσύνη. 19η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 19η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτές βασίζονται σε ύλη των βιβλίων: Artificia Inteigence A Modern Approach των S. Russe και P.

Τεχνητή Νοημοσύνη 19η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτές βασίζονται σε ύλη των βιβλίων: Artificia Inteigence A Modern Approach των S. Russe και P.

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 4 Διαχωριστικές συναρτήσεις Ταξινόμηση Γκαουσιανών μεταβλητών Bayesan decson Mnmum msclassfcaton rate decson: διαλέγουμε την κατηγορίαck για την οποία η εκ των υστέρων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 4 Διαχωριστικές συναρτήσεις Ταξινόμηση Γκαουσιανών μεταβλητών Bayesan decson Mnmum msclassfcaton rate decson: διαλέγουμε την κατηγορίαck για την οποία η εκ των υστέρων

Τεχνικές Μείωσης Διαστάσεων. Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Υπολογιστική Νοημοσύνη. Μάθημα 4: Μάθηση στον απλό τεχνητό νευρώνα (2)

Υπολογιστική Νοημοσύνη Μάθημα 4: Μάθηση στον απλό τεχνητό νευρώνα (2) Ο κανόνας Δέλτα για συνεχείς συναρτήσεις ενεργοποίησης (1/2) Για συνεχείς συναρτήσεις ενεργοποίησης, θα θέλαμε να αλλάξουμε περισσότερο

Υπολογιστική Νοημοσύνη Μάθημα 4: Μάθηση στον απλό τεχνητό νευρώνα (2) Ο κανόνας Δέλτα για συνεχείς συναρτήσεις ενεργοποίησης (1/2) Για συνεχείς συναρτήσεις ενεργοποίησης, θα θέλαμε να αλλάξουμε περισσότερο

Πολλαπλή παλινδρόμηση (Multivariate regression)

ΜΑΘΗΜΑ 3 ο 1 Πολλαπλή παλινδρόμηση (Multivariate regression) Η συμπεριφορά των περισσότερων οικονομικών μεταβλητών είναι συνάρτηση όχι μιας αλλά πολλών μεταβλητών Υ = f ( X 1, X 2,... X n ) δηλαδή η Υ

ΜΑΘΗΜΑ 3 ο 1 Πολλαπλή παλινδρόμηση (Multivariate regression) Η συμπεριφορά των περισσότερων οικονομικών μεταβλητών είναι συνάρτηση όχι μιας αλλά πολλών μεταβλητών Υ = f ( X 1, X 2,... X n ) δηλαδή η Υ

3. O ΑΛΓΟΡΙΘΜΟΣ ΤΟΥ PERCEPTRON

3. O ΑΛΓΟΡΙΘΜΟΣ ΤΟΥ PERCEPRON 3. ΕΙΣΑΓΩΓΗ: Το Perceptron είναι η απλούστερη μορφή Νευρωνικού δικτύου, το οποίο χρησιμοποιείται για την ταξινόμηση ενός ειδικού τύπου προτύπων, που είναι γραμμικά διαχωριζόμενα.

3. O ΑΛΓΟΡΙΘΜΟΣ ΤΟΥ PERCEPRON 3. ΕΙΣΑΓΩΓΗ: Το Perceptron είναι η απλούστερη μορφή Νευρωνικού δικτύου, το οποίο χρησιμοποιείται για την ταξινόμηση ενός ειδικού τύπου προτύπων, που είναι γραμμικά διαχωριζόμενα.

Μάθημα 10 ο. Περιγραφή Σχήματος ΤΜΗΥΠ / ΕΕΣΤ 1

Μάθημα 10 ο Περιγραφή Σχήματος ΤΜΗΥΠ / ΕΕΣΤ 1 Εισαγωγή (1) Η περιγραφή μίας περιοχής μπορεί να γίνει: Με βάση τα εξωτερικά χαρακτηριστικά (ακμές, όρια). Αυτή η περιγραφή προτιμάται όταν μας ενδιαφέρουν

Μάθημα 10 ο Περιγραφή Σχήματος ΤΜΗΥΠ / ΕΕΣΤ 1 Εισαγωγή (1) Η περιγραφή μίας περιοχής μπορεί να γίνει: Με βάση τα εξωτερικά χαρακτηριστικά (ακμές, όρια). Αυτή η περιγραφή προτιμάται όταν μας ενδιαφέρουν

Μέθοδοι μονοδιάστατης ελαχιστοποίησης

Βασικές αρχές μεθόδων ελαχιστοποίησης Μέθοδοι μονοδιάστατης ελαχιστοποίησης Οι μέθοδοι ελαχιστοποίησης είναι επαναληπτικές. Ξεκινώντας από μια αρχική προσέγγιση του ελαχίστου (την συμβολίζουμε ) παράγουν

Βασικές αρχές μεθόδων ελαχιστοποίησης Μέθοδοι μονοδιάστατης ελαχιστοποίησης Οι μέθοδοι ελαχιστοποίησης είναι επαναληπτικές. Ξεκινώντας από μια αρχική προσέγγιση του ελαχίστου (την συμβολίζουμε ) παράγουν

Ασκήσεις μελέτης της 19 ης διάλεξης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

E[ (x- ) ]= trace[(x-x)(x- ) ]

![E[ (x- ) ]= trace[(x-x)(x- ) ] E[ (x- ) ]= trace[(x-x)(x- ) ]](/thumbs/55/36021260.jpg) 1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

Δρ. Βασίλειος Γ. Καμπουρλάζος Δρ. Ανέστης Γ. Χατζημιχαηλίδης

Μάθημα 4 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

Μάθημα 4 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

Αναγνώριση Προτύπων (Pattern Recognition) Μπεϋζιανή Θεωρία Αποφάσεων (Bayesian Decision Theory) Π. Τσακαλίδης

Αναγνώριση Προτύπων (Pattern Recognton Μπεϋζιανή Θεωρία Αποφάσεων (Bayesan Decson Theory Π. Τσακαλίδης ΠΑΝΕΠΙΣΤΗΜΙΟ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΠΙΣΤΗΜΗΣ ΥΠΟΛΟΓΙΣΤΩΝ Μπεϋζιανή Θεωρία Αποφάσεων (Bayes Decson theory Στατιστικά

Αναγνώριση Προτύπων (Pattern Recognton Μπεϋζιανή Θεωρία Αποφάσεων (Bayesan Decson Theory Π. Τσακαλίδης ΠΑΝΕΠΙΣΤΗΜΙΟ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΠΙΣΤΗΜΗΣ ΥΠΟΛΟΓΙΣΤΩΝ Μπεϋζιανή Θεωρία Αποφάσεων (Bayes Decson theory Στατιστικά

Μέθοδοι πολυδιάστατης ελαχιστοποίησης

Μέθοδοι πολυδιάστατης ελαχιστοποίησης με παραγώγους Μέθοδοι πολυδιάστατης ελαχιστοποίησης Δ. Γ. Παπαγεωργίου Τμήμα Μηχανικών Επιστήμης Υλικών Πανεπιστήμιο Ιωαννίνων dpapageo@cc.uoi.gr http://pc64.materials.uoi.gr/dpapageo

Μέθοδοι πολυδιάστατης ελαχιστοποίησης με παραγώγους Μέθοδοι πολυδιάστατης ελαχιστοποίησης Δ. Γ. Παπαγεωργίου Τμήμα Μηχανικών Επιστήμης Υλικών Πανεπιστήμιο Ιωαννίνων dpapageo@cc.uoi.gr http://pc64.materials.uoi.gr/dpapageo

Εφαρμογές μεθοδολογιών μηχανικής εκμάθησης στο χώρο της παραγωγής υδρογονανθράκων. Βασίλης Γαγάνης

Εφαρμογές μεθοδολογιών μηχανικής εκμάθησης στο χώρο της παραγωγής υδρογονανθράκων Μέθοδοι μηχανικής εκμάθησης Εύρεση μαθηματικής έκφρασης μοντέλου (κανόνα) ο κανόνας διέπει το υπό μελέτη πρόβλημα ανάπτυξη

Εφαρμογές μεθοδολογιών μηχανικής εκμάθησης στο χώρο της παραγωγής υδρογονανθράκων Μέθοδοι μηχανικής εκμάθησης Εύρεση μαθηματικής έκφρασης μοντέλου (κανόνα) ο κανόνας διέπει το υπό μελέτη πρόβλημα ανάπτυξη

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 5 o Φροντιστήριο

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων. Δρ. Ε. Χάρου

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων Δρ. Ε. Χάρου Πρόγραμμα υπολογιστικής ευφυίας Ινστιτούτο Πληροφορικής & Τηλεπικοινωνιών ΕΚΕΦΕ ΔΗΜΟΚΡΙΤΟΣ exarou@iit.demokritos.gr Μηχανική

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων Δρ. Ε. Χάρου Πρόγραμμα υπολογιστικής ευφυίας Ινστιτούτο Πληροφορικής & Τηλεπικοινωνιών ΕΚΕΦΕ ΔΗΜΟΚΡΙΤΟΣ exarou@iit.demokritos.gr Μηχανική

ΘΕΩΡΙΑ ΑΠΟΦΑΣΕΩΝ 3 ο ΦΡΟΝΤΙΣΤΗΡΙΟ ΛΥΣΕΙΣ ΤΩΝ ΑΣΚΗΣΕΩΝ

ΘΕΩΡΙΑ ΑΠΟΦΑΣΕΩΝ 3 ο ΦΡΟΝΤΙΣΤΗΡΙΟ ΛΥΣΕΙΣ ΤΩΝ ΑΣΚΗΣΕΩΝ ΑΣΚΗΣΗ Σύμφωνα με στοιχεία από το Πανεπιστήμιο της Οξφόρδης η πιθανότητα ένας φοιτητής να αποφοιτήσει μέσα σε 5 χρόνια από την ημέρα εγγραφής του στο

ΘΕΩΡΙΑ ΑΠΟΦΑΣΕΩΝ 3 ο ΦΡΟΝΤΙΣΤΗΡΙΟ ΛΥΣΕΙΣ ΤΩΝ ΑΣΚΗΣΕΩΝ ΑΣΚΗΣΗ Σύμφωνα με στοιχεία από το Πανεπιστήμιο της Οξφόρδης η πιθανότητα ένας φοιτητής να αποφοιτήσει μέσα σε 5 χρόνια από την ημέρα εγγραφής του στο

Συστήµατα Μη-Γραµµικών Εξισώσεων Μέθοδος Newton-Raphson

Ιαν. 009 Συστήµατα Μη-Γραµµικών Εξισώσεων Μέθοδος Newton-Raphson Έστω y, y,, yn παρατηρήσεις µιας m -διάστατης τυχαίας µεταβλητής µε συνάρτηση πυκνότητας πιθανότητας p( y; θ) η οποία περιγράφεται από ένα

Ιαν. 009 Συστήµατα Μη-Γραµµικών Εξισώσεων Μέθοδος Newton-Raphson Έστω y, y,, yn παρατηρήσεις µιας m -διάστατης τυχαίας µεταβλητής µε συνάρτηση πυκνότητας πιθανότητας p( y; θ) η οποία περιγράφεται από ένα

ΚΑΤΗΓΟΡΙΕΣ ΤΑΞΙΝΟΜΗΣΗΣ

ΚΑΤΗΓΟΡΙΕΣ ΤΑΞΙΝΟΜΗΣΗΣ Κατευθυνόμενη ταξινόμηση (supervsed cassfcaton) Μη-κατευθυνόμενη ταξινόμηση (unsupervsed cassfcaton) Γραμμική: Lnear Dscrmnant Anayss Μη- Γραμμική: Νευρωνικά δίκτυα κλπ. Ιεραρχική

ΚΑΤΗΓΟΡΙΕΣ ΤΑΞΙΝΟΜΗΣΗΣ Κατευθυνόμενη ταξινόμηση (supervsed cassfcaton) Μη-κατευθυνόμενη ταξινόμηση (unsupervsed cassfcaton) Γραμμική: Lnear Dscrmnant Anayss Μη- Γραμμική: Νευρωνικά δίκτυα κλπ. Ιεραρχική

ΕΚΤΙΜΙΣΗ ΜΕΓΙΣΤΗΣ ΠΙΘΑΝΟΦΑΝΕΙΑΣ

3.1 Εισαγωγή ΕΚΤΙΜΙΣΗ ΜΕΓΙΣΤΗΣ ΠΙΘΑΝΟΦΑΝΕΙΑΣ Στο κεφ. 2 είδαμε πώς θα μπορούσαμε να σχεδιάσουμε έναν βέλτιστο ταξινομητή εάν ξέραμε τις προγενέστερες(prior) πιθανότητες ( ) και τις κλάση-υπό όρους πυκνότητες

3.1 Εισαγωγή ΕΚΤΙΜΙΣΗ ΜΕΓΙΣΤΗΣ ΠΙΘΑΝΟΦΑΝΕΙΑΣ Στο κεφ. 2 είδαμε πώς θα μπορούσαμε να σχεδιάσουμε έναν βέλτιστο ταξινομητή εάν ξέραμε τις προγενέστερες(prior) πιθανότητες ( ) και τις κλάση-υπό όρους πυκνότητες

ΕΛΛΗΝΙΚΟ ΑΝΟΙΚΤΟ ΠΑΝΕΠΙΣΤΗΜΙΟ

Θ.Ε. ΠΛΗ31 (2004-5) ΓΡΑΠΤΗ ΕΡΓΑΣΙΑ #3 Στόχος Στόχος αυτής της εργασίας είναι η απόκτηση δεξιοτήτων σε θέματα που αφορούν τα Τεχνητά Νευρωνικά Δίκτυα και ποιο συγκεκριμένα θέματα εκπαίδευσης και υλοποίησης.

Θ.Ε. ΠΛΗ31 (2004-5) ΓΡΑΠΤΗ ΕΡΓΑΣΙΑ #3 Στόχος Στόχος αυτής της εργασίας είναι η απόκτηση δεξιοτήτων σε θέματα που αφορούν τα Τεχνητά Νευρωνικά Δίκτυα και ποιο συγκεκριμένα θέματα εκπαίδευσης και υλοποίησης.

HMY 799 1: Αναγνώριση Συστημάτων

HMY 799 : Αναγνώριση Συστημάτων Διαλέξεις Γραμμική παλινδρόμηση (Linear regression) Συνέχεια Γραμμική παλινδρόμηση (Linear regression) g = θϕ + θϕ + + θ ϕ = φ θ ( φ)... d d ϕ ϕ φ=, θ= [ θ θ... θd ]...

HMY 799 : Αναγνώριση Συστημάτων Διαλέξεις Γραμμική παλινδρόμηση (Linear regression) Συνέχεια Γραμμική παλινδρόμηση (Linear regression) g = θϕ + θϕ + + θ ϕ = φ θ ( φ)... d d ϕ ϕ φ=, θ= [ θ θ... θd ]...

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D.

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: βελτιστοποίηση χωρίς περιορισμούς Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών ΤμήμαΠληροφορικής Διάλεξη 7-8 η /2017 Τι παρουσιάστηκε

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: βελτιστοποίηση χωρίς περιορισμούς Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών ΤμήμαΠληροφορικής Διάλεξη 7-8 η /2017 Τι παρουσιάστηκε

ΓΡΑΜΜΙΚΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ ΚΑΙ ΜΕΘΟΔΟΣ SIMPLEX, διαλ. 3. Ανωτάτη Σχολή Παιδαγωγικής και Τεχνολογικής Εκπαίδευσης 29/4/2017

ΓΡΑΜΜΙΚΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ ΚΑΙ ΜΕΘΟΔΟΣ SIMPLEX, διαλ. 3 Ανωτάτη Σχολή Παιδαγωγικής και Τεχνολογικής Εκπαίδευσης 29/4/2017 ΓΡΑΜΜΙΚΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ Bέλτιστος σχεδιασμός με αντικειμενική συνάρτηση και περιορισμούς

ΓΡΑΜΜΙΚΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ ΚΑΙ ΜΕΘΟΔΟΣ SIMPLEX, διαλ. 3 Ανωτάτη Σχολή Παιδαγωγικής και Τεχνολογικής Εκπαίδευσης 29/4/2017 ΓΡΑΜΜΙΚΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ Bέλτιστος σχεδιασμός με αντικειμενική συνάρτηση και περιορισμούς

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Β Γραφικές παραστάσεις - Πρώτο γράφημα Σχεδιάζοντας το μήκος της σανίδας συναρτήσει των φάσεων της σελήνης μπορείτε να δείτε αν υπάρχει κάποιος συσχετισμός μεταξύ των μεγεθών. Ο συνήθης τρόπος γραφικής

Β Γραφικές παραστάσεις - Πρώτο γράφημα Σχεδιάζοντας το μήκος της σανίδας συναρτήσει των φάσεων της σελήνης μπορείτε να δείτε αν υπάρχει κάποιος συσχετισμός μεταξύ των μεγεθών. Ο συνήθης τρόπος γραφικής

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ

ΘΕΜΑ 1 ο (2,5 μονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Τελικές εξετάσεις Πέμπτη 21 Ιουνίου 2012 16:30-19:30 Υποθέστε ότι θέλουμε

ΘΕΜΑ 1 ο (2,5 μονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Τελικές εξετάσεις Πέμπτη 21 Ιουνίου 2012 16:30-19:30 Υποθέστε ότι θέλουμε

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D.

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: μέθοδοι μονοδιάστατης ελαχιστοποίησης Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών ΤμήμαΠληροφορικής Διάλεξη 6 η /2017 Τι παρουσιάστηκε

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: μέθοδοι μονοδιάστατης ελαχιστοποίησης Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών ΤμήμαΠληροφορικής Διάλεξη 6 η /2017 Τι παρουσιάστηκε

Αναγνώριση Προτύπων. Μη παραμετρικές τεχνικές Αριθμητικά. (Non Parametric Techniques)

Αναγνώριση Προτύπων Μη παραμετρικές τεχνικές Αριθμητικά Παραδείγματα (Non Parametric Techniques) Καθηγητής Χριστόδουλος Χαμζάς Τα περιεχόμενο της παρουσίασης βασίζεται στο βιβλίο: Introduction to Pattern

Αναγνώριση Προτύπων Μη παραμετρικές τεχνικές Αριθμητικά Παραδείγματα (Non Parametric Techniques) Καθηγητής Χριστόδουλος Χαμζάς Τα περιεχόμενο της παρουσίασης βασίζεται στο βιβλίο: Introduction to Pattern

Υπολογιστική Νοημοσύνη. Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Μέθοδοι Μηχανικής Μάθησης & Βελτιστοποίησης μέσω Εννοιών Στατιστικής Φυσικής 1. Αλγόριθμοι Simulated Annealing 2. Gibbs Sampling

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Μέθοδοι Μηχανικής Μάθησης & Βελτιστοποίησης μέσω Εννοιών Στατιστικής Φυσικής 1. Αλγόριθμοι Simulated Annealing 2. Gibbs Sampling

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 26 Ιανουαρίου 2004 ιάρκεια: 2 ώρες (9:00-:00) Στην παρακάτω

ΘΕΜΑ ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 26 Ιανουαρίου 2004 ιάρκεια: 2 ώρες (9:00-:00) Στην παρακάτω

HMY 799 1: Αναγνώριση Συστημάτων

HMY 799 : Αναγνώριση Συστημάτων Διαλέξεις Επιλογή τάξης μοντέλου και επικύρωση Επαναληπτική αναγνώριση Βέλτιστη μέθοδος συμβαλλουσών μεταβλητών (opimal IV mehod) P P P IV IV, op PEM z() = H ( q) φ () Γενική

HMY 799 : Αναγνώριση Συστημάτων Διαλέξεις Επιλογή τάξης μοντέλου και επικύρωση Επαναληπτική αναγνώριση Βέλτιστη μέθοδος συμβαλλουσών μεταβλητών (opimal IV mehod) P P P IV IV, op PEM z() = H ( q) φ () Γενική

Σκοπός μας είναι να εκπαιδεύσουμε το ΝΝ ώστε να πάρει από τα δεδομένα μόνο την «σοφία» που υπάρχει μέσα τους. Αυτή είναι η έννοια της γενίκευσης.

Μάθηση και Γενίκευση Ο Mark Twain, το 1897, έγραφε στο βιβλίο του «Following the Equator»: «Θα πρέπει με προσοχή να εξάγουμε από μια εμπειρία μόνο την σοφία που υπάρχει μέσα της και όχι να παρερμηνεύουμε,

Μάθηση και Γενίκευση Ο Mark Twain, το 1897, έγραφε στο βιβλίο του «Following the Equator»: «Θα πρέπει με προσοχή να εξάγουμε από μια εμπειρία μόνο την σοφία που υπάρχει μέσα της και όχι να παρερμηνεύουμε,

Μέθοδοι μονοδιάστατης ελαχιστοποίησης

Βασικές αρχές μεθόδων ελαχιστοποίησης Μέθοδοι μονοδιάστατης ελαχιστοποίησης Οι μέθοδοι ελαχιστοποίησης είναι επαναληπτικές. Ξεκινώντας από μια αρχική προσέγγιση του ελαχίστου (την συμβολίζουμε ) παράγουν

Βασικές αρχές μεθόδων ελαχιστοποίησης Μέθοδοι μονοδιάστατης ελαχιστοποίησης Οι μέθοδοι ελαχιστοποίησης είναι επαναληπτικές. Ξεκινώντας από μια αρχική προσέγγιση του ελαχίστου (την συμβολίζουμε ) παράγουν

Μπεϋζιανή Στατιστική και MCMC Μέρος 2 ο : MCMC

Μπεϋζιανή Στατιστική και MCMC Μέρος 2 ο : MCMC Περιεχόμενα Μαθήματος Εισαγωγή στο Πρόβλημα. Monte Carlo Εκτιμητές. Προσομοίωση. Αλυσίδες Markov. Αλγόριθμοι MCMC (Metropolis Hastings & Gibbs Sampling).

Μπεϋζιανή Στατιστική και MCMC Μέρος 2 ο : MCMC Περιεχόμενα Μαθήματος Εισαγωγή στο Πρόβλημα. Monte Carlo Εκτιμητές. Προσομοίωση. Αλυσίδες Markov. Αλγόριθμοι MCMC (Metropolis Hastings & Gibbs Sampling).

E [ -x ^2 z] = E[x z]

![E [ -x ^2 z] = E[x z] E [ -x ^2 z] = E[x z]](/thumbs/69/60621176.jpg) 1 1.ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτήν την διάλεξη θα πάμε στο φίλτρο με περισσότερες λεπτομέρειες, και θα παράσχουμε μια νέα παραγωγή για το φίλτρο Kalman, αυτή τη φορά βασισμένο στην ιδέα της γραμμικής

1 1.ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτήν την διάλεξη θα πάμε στο φίλτρο με περισσότερες λεπτομέρειες, και θα παράσχουμε μια νέα παραγωγή για το φίλτρο Kalman, αυτή τη φορά βασισμένο στην ιδέα της γραμμικής

ΣΥΝΕΛΙΚΤΙΚΑ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΑΤΡΩΝ - ΤΜΗΜΑ ΦΥΣΙΚΗΣ - Δ.Π.Μ.Σ. «Ηλεκτρονική και Επεξεργασία της Πληροφορίας» ΔΙΠΛΩΜΑΤΙΚΗ ΕΡΓΑΣΙΑ ΣΥΝΕΛΙΚΤΙΚΑ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ ΣΤΗΝ ΥΠΟΛΟΓΙΣΤΙΚΗ ΌΡΑΣΗ ΟΝΟΜΑΤΕΠΩΝΥΜΟ : ΠΑΠΑΔΟΠΟΥΛΟΣ ΑΘΑΝΑΣΙΟΣ

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΑΤΡΩΝ - ΤΜΗΜΑ ΦΥΣΙΚΗΣ - Δ.Π.Μ.Σ. «Ηλεκτρονική και Επεξεργασία της Πληροφορίας» ΔΙΠΛΩΜΑΤΙΚΗ ΕΡΓΑΣΙΑ ΣΥΝΕΛΙΚΤΙΚΑ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ ΣΤΗΝ ΥΠΟΛΟΓΙΣΤΙΚΗ ΌΡΑΣΗ ΟΝΟΜΑΤΕΠΩΝΥΜΟ : ΠΑΠΑΔΟΠΟΥΛΟΣ ΑΘΑΝΑΣΙΟΣ

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson Σχεδιαζόντας ταξινομητές: Τα δεδομένα Στην πράξη η γνώση σχετικά διαδικασία γέννεσης των δεδομένων είναι πολύ σπάνια γνωστή. Το μόνο που έχουμε στη διάθεσή

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson Σχεδιαζόντας ταξινομητές: Τα δεδομένα Στην πράξη η γνώση σχετικά διαδικασία γέννεσης των δεδομένων είναι πολύ σπάνια γνωστή. Το μόνο που έχουμε στη διάθεσή

Ζωντανό Εργαστήριο Thessaloniki Active and Healthy Ageing Living Lab Παρακολούθηση ατόμων στο σπίτι σε πραγματικό χρόνο

1 Ζωντανό Εργαστήριο Thessaloniki Active and Healthy Ageing Living Lab Παρακολούθηση ατόμων στο σπίτι σε πραγματικό χρόνο Συλλογή δεδομένων Μελέτη κινησιολογικών και συμπεριφορικών συνηθειών Πρόβλεψη ψυχικών

1 Ζωντανό Εργαστήριο Thessaloniki Active and Healthy Ageing Living Lab Παρακολούθηση ατόμων στο σπίτι σε πραγματικό χρόνο Συλλογή δεδομένων Μελέτη κινησιολογικών και συμπεριφορικών συνηθειών Πρόβλεψη ψυχικών

Νευρωνικά ίκτυα και Εξελικτικός. Σηµερινό Μάθηµα. επανάληψη Γενετικών Αλγορίθµων 1 η εργασία Επανάληψη νευρωνικών δικτύων Ασκήσεις εφαρµογές

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα επανάληψη Γενετικών Αλγορίθµων η εργασία Επανάληψη νευρωνικών δικτύων Ασκήσεις εφαρµογές Κωδικοποίηση Αντικειµενική Συνάρτ Αρχικοποίηση Αξιολόγηση

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα επανάληψη Γενετικών Αλγορίθµων η εργασία Επανάληψη νευρωνικών δικτύων Ασκήσεις εφαρµογές Κωδικοποίηση Αντικειµενική Συνάρτ Αρχικοποίηση Αξιολόγηση

ΠΡΟΒΛΗΜΑΤΑ ΔΥΟ ΔΙΑΣΤΑΣΕΩΝ

ΠΡΟΒΛΗΜΑΤΑ ΔΥΟ ΔΙΑΣΤΑΣΕΩΝ Η ανάλυση προβλημάτων δύο διαστάσεων με τη μέθοδο των Πεπερασμένων Στοιχείων περιλαμβάνει τα ίδια βήματα όπως και στα προβλήματα μιας διάστασης. Η ανάλυση γίνεται λίγο πιο πολύπλοκη

ΠΡΟΒΛΗΜΑΤΑ ΔΥΟ ΔΙΑΣΤΑΣΕΩΝ Η ανάλυση προβλημάτων δύο διαστάσεων με τη μέθοδο των Πεπερασμένων Στοιχείων περιλαμβάνει τα ίδια βήματα όπως και στα προβλήματα μιας διάστασης. Η ανάλυση γίνεται λίγο πιο πολύπλοκη

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ Βασίλης Δ. Ανδριτσάνος Δρ. Αγρονόμος - Τοπογράφος Μηχανικός ΑΠΘ Επίκουρος Καθηγητής ΤΕΙ Αθήνας 3ο εξάμηνο http://eclass.teiath.gr Παρουσιάσεις,

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ Βασίλης Δ. Ανδριτσάνος Δρ. Αγρονόμος - Τοπογράφος Μηχανικός ΑΠΘ Επίκουρος Καθηγητής ΤΕΙ Αθήνας 3ο εξάμηνο http://eclass.teiath.gr Παρουσιάσεις,

Συμπίεση Δεδομένων

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Άσκηση 5.1 Για ένα σήμα που έχει τη σ.π.π. του σχήματος να υπολογίσετε: μήκος του δυαδικού κώδικα για Ν επίπεδα κβάντισης για σταθερό μήκος λέξης;

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Άσκηση 5.1 Για ένα σήμα που έχει τη σ.π.π. του σχήματος να υπολογίσετε: μήκος του δυαδικού κώδικα για Ν επίπεδα κβάντισης για σταθερό μήκος λέξης;

4.3. Γραµµικοί ταξινοµητές

Γραµµικοί ταξινοµητές Γραµµικός ταξινοµητής είναι ένα σύστηµα ταξινόµησης που χρησιµοποιεί γραµµικές διακριτικές συναρτήσεις Οι ταξινοµητές αυτοί αναπαρίστανται συχνά µε οµάδες κόµβων εντός των οποίων

Γραµµικοί ταξινοµητές Γραµµικός ταξινοµητής είναι ένα σύστηµα ταξινόµησης που χρησιµοποιεί γραµµικές διακριτικές συναρτήσεις Οι ταξινοµητές αυτοί αναπαρίστανται συχνά µε οµάδες κόµβων εντός των οποίων

Ψηφιακός Έλεγχος. 6 η διάλεξη Σχεδίαση στο χώρο κατάστασης. Ψηφιακός Έλεγχος 1

Ψηφιακός Έλεγχος 6 η διάλεξη Σχεδίαση στο χώρο κατάστασης Ψηφιακός Έλεγχος Μέθοδος μετατόπισης ιδιοτιμών Έστω γραμμικό χρονικά αμετάβλητο σύστημα διακριτού χρόνου: ( + ) = + x k Ax k Bu k Εφαρμόζουμε γραμμικό

Ψηφιακός Έλεγχος 6 η διάλεξη Σχεδίαση στο χώρο κατάστασης Ψηφιακός Έλεγχος Μέθοδος μετατόπισης ιδιοτιμών Έστω γραμμικό χρονικά αμετάβλητο σύστημα διακριτού χρόνου: ( + ) = + x k Ax k Bu k Εφαρμόζουμε γραμμικό

Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων»

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

Project 1: Principle Component Analysis

Project 1: Principle Component Analysis Μια από τις πιο σημαντικές παραγοντοποιήσεις πινάκων είναι η Singular Value Decomposition ή συντετμημένα SVD. Η SVD έχει πολλές χρήσιμες ιδιότητες, επιθυμητές σε

Project 1: Principle Component Analysis Μια από τις πιο σημαντικές παραγοντοποιήσεις πινάκων είναι η Singular Value Decomposition ή συντετμημένα SVD. Η SVD έχει πολλές χρήσιμες ιδιότητες, επιθυμητές σε

Ψηφιακή Επεξεργασία Σημάτων

Ψηφιακή Επεξεργασία Σημάτων Ενότητα 3: Συστήματα Διακριτού Χρόνου Δρ. Μιχάλης Παρασκευάς Επίκουρος Καθηγητής 1 Συστήματα Διακριτού Χρόνου Εισαγωγή στα Συστήματα Διακριτού Χρόνου Ταξινόμηση Συστημάτων ΔΧ

Ψηφιακή Επεξεργασία Σημάτων Ενότητα 3: Συστήματα Διακριτού Χρόνου Δρ. Μιχάλης Παρασκευάς Επίκουρος Καθηγητής 1 Συστήματα Διακριτού Χρόνου Εισαγωγή στα Συστήματα Διακριτού Χρόνου Ταξινόμηση Συστημάτων ΔΧ