Δίκτυα Συναρτήσεων Βάσης Ακτινικού Τύπου Radial Basis Functions (RBF)

|

|

|

- Ζηναις Γεννάδιος

- 7 χρόνια πριν

- Προβολές:

Transcript

1 Δίκτυα Συναρτήσεων Βάσης Ακτινικού Τύπου Radial Basis Functions (RBF) Τα δίκτυα RBF μοιάζουν στη λειτουργία τους με τα ανταγωνιστικά δίκτυα. Έχουν πολλές εφαρμογές και μεγάλο ενδιαφέρον, εξ ίσου με τα MLP. Έχουν συναρτήσεις ενεργοποίησης ακτινικού τύπου. Η συνάρτηση f x είναι ακτινικού τύπου, αν υπάρχει κάποιο διάνυσμα c (κέντρο) και η τιμή της f x εξαρτάται από την απόσταση του x από το κέντρο: f x = f x c Η γενική μορφή αυτών των συναρτήσεων είναι: c d = x c x f x = φ x c T R 1 x c

2 f x = φ x c T R 1 x c Όπου φ είναι η συνάρτηση που χρησιμοποιείται (Gauss, Πολυτετραγωνική, κλπ), c είναι το κέντρο και R το μέτρο. Ο όρος x c T R 1 x c είναι η απόσταση μεταξύ της εισόδου x και του κέντρου c με μέτρο το R. Υπάρχουν διάφορες συναρτήσεις που χρησιμοποιούνται: Η του Gauss: φ z = e z Το δίκτυο RBF Η πολυτετραγωνική: φ z = 1 + z 1 2 Η αντίστροφη πολυτετραγωνική: φ z = 1 + z 1 2 Η του Gauchy: φ z = 1 + z 1

3 Το δίκτυο RBF Πολύ συχνά το μέτρο είναι η Ευκλείδεια απόσταση (δηλαδή R = r 2 I) και η σχέση απλοποιείται στην: f x = φ x c T x c r 2 Και με περεταίρω απλοποίηση (όταν έχουμε μονοδιάστατη είσοδο) θα γίνει: f x = φ x c 2 Η ανωτέρω σχέση, για c = 0 για r = 1 θα δώσει τις μορφές: r 2

4 Το δίκτυο RBF Πολυτετραγωνική Αντίστροφη Πολυτετραγωνική Gauchy Gaussian

5 Το δίκτυο RBF Γενικεύοντας: Συνάρτηση Gauss f x = e x c 2 σ 2

6 Το δίκτυο RBF Γενικεύοντας: Πολυτετραγωνική Συνάρτηση f x = x c 2 + σ 2

7 Το δίκτυο RBF Γενικεύοντας: Συνάρτηση Cauchy f x = x c 2 + σ 2 1 σ

8 Η πιο συνήθης μορφή f x είναι αυτή της κατανομής Gauss: x c 2 f x = e σ 2 Ο συντελεστής σ καθορίζει το πλάτος της καμπύλης και το c το κέντρο της. Το δίκτυο RBF c=0 σ=2 c=-1 σ=0,5 c=1 σ=1

9 Το δίκτυο RBF Τα δίκτυα RBF έχουν ένα στρώμα με νευρώνες που έχουν συνάρτηση ενεργοποίησης ακτινικού τύπου. Έχουν συνήθως μόνο δύο στρώματα, κι αυτό γιατί δεν υπάρχει ικανοποιητικός αλγόριθμος για την εκπαίδευση περισσότερων στρωμάτων. y 1 y 2 y m x 1 x 2 x 3 x n +

10 Ανάκληση στο δίκτυο RBF Είσοδοι: Διάνυσμα εισόδου x = x 1, x 2,. x T n Πλήθος νευρώνων: Στρώμα εισόδου= n Κρυφό στρώμα = K Στρώμα εξόδου= m Κάθε νευρώνας i έχει δικό του κέντρο c i και εύρος συνάρτησης σ i Έξοδοι: y 1, y 2,. x m Για κάθε κρυφό νευρώνα i = 1,, Κ { a i = f x c i, σ i } Για κάθε νευρώνα εξόδου i = 1,, m { } K y i = j=1 w ij a j + w i0 Όπως γίνεται και στο MLP και είναι ακόμα πιο απλή

11 Καθώς τα δίκτυα RBF είναι ανομοιογενή, έχοντας στο κρυφό στρώμα νευρώνες με συνάρτηση ενεργοποίησης ακτινικού τύπου ενώ στο στρώμα εξόδου γραμμικού τύπου, η εκπαίδευσή τους γίνεται διαφορετικά ανά στρώμα. Εκπαιδεύονται πρώτα οι παράμετροι των νευρώνων ακτινικού τύπου, δηλαδή τα κέντρα c i και τα πλάτη σ i (i = 1,, Κ) και κατόπιν εκπαιδεύονται τα συναπτικά βάρη w ij των γραμμικών νευρώνων εξόδου, κατά τα γνωστά. Η εκπαίδευση των νευρώνων του κρυφού στρώματος RBF μπορεί να γίνει με διαφορετικούς τρόπους, ανάλογα με την ιδιομορφία και τις απαιτήσεις σε ακρίβεια και χρόνο. Εκπαίδευση Δικτύων RBF

12 Εκπαίδευση Δικτύων RBF A. Κάθε πρότυπο κι ένα κέντρο Κάθε διάνυσμα εισόδου x i, i = 1,., P, αποτελεί κι ένα κέντρο: c i = x i K = P i = 1,., K P κέντρα συνολικά: Μέθοδος «ακριβή», με πάρα πολλούς κρυφούς νευρώνες (P), αλλά και πολύ γρήγορη εκμάθηση. Ενδείκνυται, η τιμή τους εύρους σ i (για την συνάρτηση Gauss) να είναι: σ 1 = = σ Κ = σ = D 2P D: Απόσταση μεταξύ των πιο απομακρυσμένων κέντρων Έτσι ώστε οι Γκαουσιανές καμπάνες να είναι «νορμάλ» (ούτε πολύ «μυτερές», ούτε πολύ «επίπεδες»).

13 Εκπαίδευση Δικτύων RBF B. Τυχαία επιλογή προτύπων για κέντρα Κάνουμε τυχαία επιλογή από τα πρότυπα εισόδου για να γίνουν κέντρα, ή περιορίζουμε τον αρχικό τους αριθμό σε ένα ποσοστό, π.χ. (K=10% του P). Η Μέθοδος έχει απώλεια πληροφορίας: Σε περιοχές πυκνών προτύπων επιλέγουμε πολλά πρότυπα και η απώλεια περιορίζεται, ενώ σε αραιές περιοχές επιλέγουμε λίγα ή καθόλου γιατί η απώλεια είναι άνευ σημασίας.

14 Εκπαίδευση Δικτύων RBF C. Ομαδοποίηση (clustering) Ομαδοποίηση K-μέσων Εάν διαθέτουμε P πρότυπα: x 1, x 2,, x P που ανήκουν σε K κλάσεις: X 1, X 2,, X K, η μέθοδος Κ-μέσων αναζητά ένα διάνυσμα αντιπρόσωπο c i για κάθε κλάση, ξεκινώντας από τυχαία διανύσματα και προσπαθώντας να καλύψει τις απαιτήσεις: 1. Για κάθε i = 1,., K, η κλάση X i αποτελείται από τα πρότυπα x p τα οποία βρίσκονται πιο κοντά στο διάνυσμα c i σε σχέση με όλα τα άλλα διανύσματα c i, j i: x p c i = min x p c j j 2. Για κάθε i = 1,., K, το διάνυσμα c i είναι ο μέσος όρος των προτύπων που ανήκουν στην κλάση X i : c i = 1 X i p X i x p Με X i, το πλήθος των προτύπων της κλάσης και c i το κέντρο της.

15 Ομαδοποίηση K-μέσων Εκπαίδευση Δικτύων RBF

16 Εκπαίδευση Δικτύων RBF Αλγόριθμος Ομαδοποίησης K-μέσων Είσοδος: P πρότυπα: x 1, x 2,, x P. Πλήθος κέντρων K. Έξοδος: K κέντρα c 1, c 2,, c K Αρχικοποίησε τα c 1, c 2,, c K σε τυχαίες τιμές. Επανέλαβε { Για κάθε πρότυπο p = 1,, P { Βρες το κοντινότερο κέντρο c i στο x P label(p) i } Για κάθε κέντρο k = 1,, K { c k μέσος όρος των x P τα οποία ανήκουν στην κλάση k, δηλαδή label(p) = k } } Μέχρι να μην υπάρξει καμία αλλαγή στα κέντρα c 1, c 2,, c K

17 Εκπαίδευση Δικτύων RBF Αλγόριθμος Ομαδοποίησης K-μέσων Ο αλγόριθμος εναλλάσσεται, μέχρι να υπάρξει σύγκλιση, μεταξύ του υπολογισμού των μελών των κλάσεων και του Μ.Ο. κάθε κλάσης, κατά την διάρκεια των οποίων μπορεί να έχουμε αλλαγές και στα μέλη των κλάσεων και στους Μ.Ο. τους. Οι αλλαγές αυτές σταδιακά μειώνονται, όσο προχωράμε προς την σύγκλιση, και έχουμε παγίωση της κατάστασης.

18 Εκπαίδευση Δικτύων RBF D. Εκπαίδευση με επίβλεψη Οι Poggio & Girosi χρησιμοποιώντας την κατάβαση δυναμικού, πρότειναν μια παραλλαγή της μεθόδου Backpropagation για την βελτίωση της εκμάθησης των RBF που την ονόμασαν Generalized RBF (GRBF). Η μέθοδος αυτή δοκιμάστηκε στο πρόβλημα της μετατροπής κειμένου σε ομιλία (NETtalk), όπου το δίκτυο πρέπει να μάθει την προφορά αγγλικών λέξεων, μελετώντας ένα λεξικό με σωστές προφορές. Η χρήση του GRBF βελτίωσε κατά 17% την επίδοση του δικτύου σε σχέση με τον αλγόριθμο K-μέσων.

19 Εκπαίδευση Δικτύων RBF Εκπαίδευση του εξωτερικού στρώματος Χρήση του κανόνα δέλτα (delta-rule) όπως στο ADALINE. y 1 y 2 y m a 1 a p.... Αφού έχουμε εκπαιδεύσει το κρυφό στρώμα, γνωρίζουμε τα a 1, a 2,, a K (για κάθε πρότυπο εισόδου x = x 1, x 2,. x n T ) τα οποία αποτελούν τις εισόδους του στρώματος εξόδου:

20 Εκπαίδευση του εξωτερικού στρώματος Οι έξοδοι θα είναι: Εκπαίδευση Δικτύων RBF y i = K j=1 w ij a j + w i0 Δηλαδή έχουμε πολλά δίκτυα ADALINE (ένα για κάθε έξοδο). Στην τιμή y p i για το πρότυπο εισόδου: a p = a p p 1,., a T K αντιστοιχεί η τιμή στόχου d i p. Ο κανόνας εκπαίδευσης θα είναι: w ij p+1 = w ij p + β d i p y i p a i p, j = 1,, K, i = 1,, m w i0 p+1 = w i0 p + β d i p y i p a i p, i = 1,, m

21 Δυνατότητες Δικτύων RBF Όπως τα MLP, έτσι και τα RBF μπορούν να αποτελέσουν καθολικό προσεγγιστή (Θεώρημα Park & Sandberg 1991). Οι συναρτήσεις ακτινικού τύπου είναι βάση του χώρου των συνεχών συναρτήσεων και προσεγγίζουν οποιαδήποτε συνεχή συνάρτηση αρκεί να έχουν ικανό πλήθος κρυφών νευρώνων.

22 RBF: μόνο 2 στρώματα. δεν υπάρχει ικανοποιητικός κανόνας εκπαίδευσης για 3, 4, κλπ στρώματα. RBF: αυτο-οργανούμενο κρυφό στρώμα. MLP: μοιάζει περισσότερο με τους νευρώνες. Ομοιότητες/Διαφορές με MLP RBF, MLP: εκπαίδευση με επίβλεψη πραγματικούς Και τα δύο είναι μη γραμμικά δίκτυα με προσωτροφοδότηση (feed-forward). Χρησιμοποιούνται σε παρόμοιες εφαρμογές. Υπάρχει πάντα ένα RBF ικανό να μιμηθεί με ακρίβεια ένα MLP και αντίστροφα.

23 Ομοιότητες/Διαφορές με MLP Ένα κρυφό στρώμα. RBFN Οι κρυφοί νευρώνες (βασικές συναρτήσεις) λειτουργούν πολύ διαφορετικά ο ένας από τον άλλο και έχουν διαφορετικούς σκοπούς σε σχέση με τους νευρώνες εξόδου. Μέτρο στην συνάρτηση ενεργοποίησης για κάθε κρυφή μονάδα είναι η απόσταση μεταξύ εισόδου και βαρών (κέντρα RBF). Συνήθως εκπαιδεύεται ένα στρώμα κάθε φορά, και το πρώτο στρώμα χωρίς επίβλεψη. Χρησιμοποιεί στοχευμένες μη γραμμικότητες (Gaussians) στο κρυφό στρώμα για να χτίσει τοπικές προσεγγίσεις. MLP Περισσότερα κρυφά στρώματα. Οι υπολογιστικοί νευρώνες στα διάφορα στρώματα, έχουν κοινό μοντέλο νευρώνα, αλλά όχι απαραίτητα και την ίδια συνάρτηση ενεργοποίησης. Μέτρο στην συνάρτηση ενεργοποίησης για κάθε κρυφή μονάδα είναι το εσωτερικό γινόμενο μεταξύ εισόδου και βαρών. Συνήθως εκπαιδεύεται με επίβλεψη και με τον ίδιο γενικευμένο αλγόριθμο. Χτίζει γενικευμένες προσεγγίσεις για μη γραμμικές αντιστοιχίσεις εισόδων-εξόδων με κατανεμημένες κρυφές αναπαραστάσεις. Χρειάζεται μικρότερο αριθμό παραμέτρων

24 Ομοιότητες/Διαφορές με MLP Και τα δύο παγκόσμιοι προσεγγιστές RBF προσέγγιση MLP Ισοδυναμία μεταξύ δικτύων RBF και μηχανών ασαφούς λογικής (fuzzy logic). RBF ή MLP? Κριτήριο = ποιότητα προσέγγισης πεπερασμένο πλήθος νευρώνων συγκεκριμένα δεδομένα

25 Ομοιότητες/Διαφορές με MLP MLP RBF

26 Ομοιότητες/Διαφορές με MLP MLP RBF

27 Μοντελοποίηση χρονοσειρών Χρονοσειρά είναι ακολουθία τιμών που παράγονται: Συνεχής χρόνος: y t = F x t Εφαρμογές t R Διακριτός χρόνος: y k = F x k k = 0,1,2,.. Διαφορική Εξίσωση: dy = F y dt Ζητούμενο: Εύρεση του μοντέλου F από τα δεδομένα της χρονοσειράς, ώστε να μπορεί να προβλεφθεί η εξέλιξή της. Οι τιμές από την δειγματοληψία της χρονοσειράς: y 0, y 1, y 2, τροφοδοτούν το νευρωνικό δίκτυο.

28 Εφαρμογές Μοντέλο παραγωγής λευκών αιμοσφαιρίων Mackey- Glass: dy t y t d = by t + a dt 1 + y t d 10 Ζητούμενο: Εκτίμηση παραμέτρων a, b, d Moody & Darken εκτίμηση παραμέτρων χαοτικής χρονοσειράς Mackey-Glass RBF: 27 φορές περισσότερα δεδομένα από το MLP για ίδιο επίπεδο απόδοσης RBF: 16 φορές πιο γρήγορο από το BP

29 Ταξινόμηση φωνημάτων (ταξινόμηση δέκα ήχων φωνηέντων) 338 φωνήματα για εκπαίδευση 333 φωνήματα για έλεγχο Μέθοδος k-μέσων 100 κρυφοί Γκαουσσιανοί νευρώνες Σφάλμα = 18% στα πρότυπα ελέγχου Εφαρμογές Τιμολόγηση Χρηματιστηριακών παραγώγων (option pricing) Εξισορρόπηση τηλεπικοινωνιακού καναλιού (channel equalization)

30 Πραγματοποίηση των δικτύων RBF στο Matlab a = radbas w p b = radbas n = e n2 Η είσοδος n στο RBF, είναι η απόσταση μεταξύ του ανύσματος των βαρών w και του ανύσματος της εισόδου p, επί την πόλωση (bias) b, με την οποία ρυθμίζουμε την ευαισθησία του.

31 Πραγματοποίηση των δικτύων RBF στο Matlab Μορφή Gaussian Η a παίρνει τιμές από 1 μέχρι 0, εάν η διαφορά n οδεύει από το 0 στο max. Ο νευρώνας RBF λειτουργεί ως ανιχνευτής, δίνοντας 1 όταν η είσοδος p είναι ίδια με το άνυσμα βαρών w. a = radbas w p b = radbas n = e n2

32 Πραγματοποίηση των δικτύων RBF στο Matlab To dist παίρνει το άνυσμα εισόδου p και την μήτρα βαρών ΙW 1,1 και δίνει ένα άνυσμα με S 1 στοιχεία, τα οποία είναι οι αποστάσεις μεταξύ του ανύσματος εισόδου και των ανυσμάτων iιw 1,1 που ορίζονται από τις γραμμές της μήτρας των βαρών εισόδου.

33 Πραγματοποίηση των δικτύων RBF στο Matlab Το άνυσμα της πόλωσης b 1 (με το οποίο ρυθμίζεται η ευαισθησία) και το dist πολλαπλασιάζονται, στοιχείο προς στοιχείο, με την πράξη (.*) του MATLAB.

34 Πραγματοποίηση των δικτύων RBF στο Matlab Όταν ένα άνυσμα εισόδου p παρουσιάζεται στην είσοδο, κάθε νευρώνας RBF θα δώσει έξοδο, ανάλογη με το πόσο κοντά είναι η τιμή του ανύσματος εισόδου με την τιμή του ανύσματος βαρών του νευρώνα.

35 Πραγματοποίηση των δικτύων RBF στο Matlab Έτσι οι νευρώνες RBF, με άνυσμα βαρών που διαφέρει από το άνυσμα εισόδου p, θα έχουν εξόδους περίπου ίσες με το μηδέν και η επίδρασή τους στους γραμμικούς νευρώνες εξόδου θα είναι μηδαμινή.

36 Πραγματοποίηση των δικτύων RBF στο Matlab Αντιθέτως, αν το άνυσμα βαρών δεν διαφέρει από το άνυσμα εισόδου p, τότε θα έχουν εξόδους σχεδόν στο 1 και οι έξοδοι αυτές θα περνούν αυτούσιες τις τιμές τους στους γραμμικούς νευρώνες εξόδου.

37 Πραγματοποίηση των δικτύων RBF στο Matlab Δηλαδή αν μόνο ένας νευρώνας RBF έχει έξοδο 1 και όλοι οι άλλοι 0 (ή σχεδόν 0), η έξοδος του γραμμικού στρώματος θα είναι το βάρος εξόδου του ενεργού νευρώνα RBF. Αυτό είναι μια ακραία περίπτωση. Στην πράξη, ενεργοποιούνται περισσότεροι του ενός νευρώνες, σε διαφορετικό βαθμό ο καθένας.

38 Πραγματοποίηση των δικτύων RBF στο Matlab Εάν το άνυσμα βαρών διαφέρει από το άνυσμα εισόδου p, σε απόσταση = spread, η σταθμισμένη είσοδός του θα είναι = spread, η είσοδος n = sqrt( log(.5)) (ή ), και η έξοδος a= 0.5.

39 Πραγματοποίηση των δικτύων RBF στο Matlab Η πραγματοποίηση των δικτύων ΝΝ RBF στο Matlab γίνεται με τις εντολές newrbe και newrb. net = newrbe(p,t,spread) Η εντολή newrbe δέχεται την μήτρα των ανυσμάτων εισόδου P και τα ανύσματα στόχους Τ, καθώς και την παράμετρο SPREAD (για την συνάρτηση RBF) και δημιουργεί το ΝΝ RBF με τα βάρη και τις πολώσεις έτσι ώστε όταν οι είσοδοι είναι Ρ οι έξοδοι να είναι Τ. Δημιουργεί τόσους νευρώνες RBF, όσα ανύσματα έχει η μήτρα εισόδου Ρ. Δηλαδή, κάθε νευρώνας στην γραμμή RBF λειτουργεί σαν ανιχνευτής ενός διαφορετικού ανύσματος εισόδου. Αν έχουμε π.χ. Q ανύσματα εισόδου, θα έχουμε και Q νευρώνες RBF.

40 Πραγματοποίηση των δικτύων RBF στο Matlab Έτσι με την εντολή newrbe δημιουργείται ένα ΝΝ που δίνει μηδενικό σφάλμα για τα ανύσματα εκμάθησης. Μόνη προϋπόθεση: spread αρκετά μεγάλο, ώστε οι νευρώνες RBF να επικαλύπτονται αρκετά και πολλοί νευρώνες RBF να έχουν υψηλές εξόδους, ανά πάσα στιγμή. Αυτό καθιστά τη λειτουργία του δικτύου ομαλότερη και έχει ως αποτέλεσμα την καλύτερη γενίκευση για νέα ανύσματα εισόδου που βρίσκονται μεταξύ των διανυσμάτων εισόδου που χρησιμοποιούνται στο σχεδιασμό. (Ωστόσο, το spread δεν πρέπει να είναι τόσο μεγάλο, γιατί τότε κάθε νευρώνας θα ανταποκρίνεται σχεδόν στην ίδια και μεγάλη περιοχή του χώρου εισόδου).

41 Πραγματοποίηση των δικτύων RBF στο Matlab Το μειονέκτημα της εντολής newrbe είναι ότι δημιουργεί ένα ΝΝ με τόσους κρυφούς νευρώνες, όσα και τα ανύσματα εισόδου. Αυτό δημιουργεί πρόβλημα μεγέθους, όταν χρειάζονται πολλά δεδομένα εισόδου για την σωστή επίλυση του προβλήματος, πράγμα που είναι σύνηθες. Τα ΝΝ RBF που πραγματοποιούνται με την εντολή newrbe λέγονται και Exact Radial Basis Function Networks (Exact RBFN).

42 Πραγματοποίηση των δικτύων RBF στο Matlab Η εντολή newrb δημιουργεί σταδιακά τους νευρώνες RBF, έναν κάθε φορά, ανάλογα με το αν έχουμε φτάσει (ή όχι) στην επιθυμητή τιμή του σφάλματος SSE, ή στον μέγιστο αριθμό νευρώνων. net = newrb(p,t,goal,spread) Η παράμετρος GOAL ορίζει τον στόχο για το σφάλμα SSE. Σε κάθε επανάληψη, το άνυσμα εισόδου που οδηγεί στην μεγαλύτερη μείωση του σφάλματος χρησιμοποιείται για να δημιουργηθεί ένας νευρώνας RBF. Εάν η τιμή σφάλματος έχει επιτευχθεί σταματάμε. Εάν όχι, η διαδικασία επαναλαμβάνεται προσθέτοντας νέο νευρώνα, κ.λ.π., μέχρι να επιτευχθεί η τιμή του σφάλματος ή ο μέγιστος αριθμός νευρώνων.

43 Παράδειγμα: Προσέγγιση συνάρτησης (Radial Basis Approximation) Να προσεγγισθεί μία συνάρτηση η οποία ορίζεται από τα εξής δεδομένα (σημεία): close all, clear all, clc, format compact X = -1:.1:1; T = [ ]; figure; plot(x,t,'+'); title('training Vectors'); xlabel('input Vector P'); ylabel('target Vector T');

44 Παράδειγμα: Προσέγγιση συνάρτησης

45 Παράδειγμα: Προσέγγιση συνάρτησης To NN RBF με το οποίο θα γίνει η προσέγγιση της συνάρτησης θα έχει την εξής συνάρτηση (Gaussian): x = -3:.1:3; a = radbas(x); figure; plot(x,a) title('radial Basis Transfer Function'); xlabel('input p'); ylabel('output a');

46 Παράδειγμα: Προσέγγιση συνάρτησης

47 Παράδειγμα: Προσέγγιση συνάρτησης Τα βάρη (weights) και οι πολώσεις (bias) κάθε νευρώνα στο κρυφό στρώμα του NN RBF, ορίζουν την θέση και το εύρος της συνάρτησης RBF. Κάθε νευρώνας στο στρώμα εξόδου, έχει γραμμική συνάρτηση απόκρισης η οποία δημιουργείται από το σταθμισμένο άθροισμα (weighted sum) των αποκρίσεων των νευρώνων RBF. Με τις σωστές τιμές για τα βάρη και τις πολώσεις, για κάθε στρώμα, και αρκετούς νευρώνες RBF στο κρυφό στρώμα, το ΝΝ RBF μπορεί να προσεγγίσει την συνάρτηση με όση ακρίβεια επιθυμούμε. Δίδονται π.χ., τρεις διαφορετικές συναρτήσεις RBF οι οποίες (σε συνδυασμό) δημιουργούν μια 4 η.

48 Παράδειγμα: Προσέγγιση συνάρτησης Με τις RBF αποκρίσεις των επί μέρους νευρώνων, γίνεται η προσέγγιση (fitting) της συνάρτησης.

49 Παράδειγμα: Προσέγγιση συνάρτησης a2 = radbas(x-1.5); a3 = radbas(x+2); a4 = a + a2*1 + a3*0.5; figure; plot(x,a,'b-',x,a2,'b--',x,a3,'b--',x,a4,'m-') title('weighted Sum of Radial Basis Transfer Functions'); xlabel('input p'); ylabel('output a');

50 Παράδειγμα: Προσέγγιση συνάρτησης

51 P T Παράδειγμα: Προσέγγιση συνάρτησης Με την εντολή newrb δημιουργούμε το ΝΝ RBF το οποίο θα προσεγγίσει την συνάρτηση που ορίζεται από τα σημεία Ρ και Τ. Η εντολή, εκτός από τα Ρ και Τ δέχεται ακόμα μέχρι 4 παραμέτρους: net = newrb(p,t,goal,spread,mn,df) R-by-Q matrix of Q input vectors S-by-Q matrix of Q target class vectors goal Mean squared error goal (default = 0.0) spread Spread of radial basis functions (default = 1.0) MN Maximum number of neurons (default is Q) DF Number of neurons to add between displays (default = 25)

52 Παράδειγμα: Προσέγγιση συνάρτησης eg = 0.02; % sum-squared error goal sc = 1; % spread constant K = 6; % choose max number of neurons Ki = 1; % number of neurons to add between displays net = newrb(x,t,eg,sc,k,ki); view(net)

53 Παράδειγμα: Προσέγγιση συνάρτησης

54 Παράδειγμα: Προσέγγιση συνάρτησης NEWRB, neurons = 0, MSE = NEWRB, neurons = 2, MSE = NEWRB, neurons = 3, MSE = NEWRB, neurons = 4, MSE = NEWRB, neurons = 5, MSE = NEWRB, neurons = 6, MSE =

55 Παράδειγμα: Προσέγγιση συνάρτησης Για να δούμε την επίδοση του ΝΝ πρέπει να τυπώσουμε μαζί τα αρχικά δεδομένα (σημεία), με την απόκριση του ΝΝ στην ίδια περιοχή. figure; plot(x,t,'+'); xlabel('input'); X = -1:.01:1.1; Y = net(x); hold on; plot(x,y); hold off; legend({'target','output'})

56 Παράδειγμα: Προσέγγιση συνάρτησης

57 Παράδειγμα: Προσέγγιση συνάρτησης Για να δούμε την επίδραση του spread στην ικανότητα του ΝΝ, θα δοκιμάσουμε με μια χαμηλή τιμή του. Χαράζουμε ξανά τα σημεία: P = -1:.1:1; T = [ ]; plot(x,t,'+'); title('training Vectors'); xlabel('input Vector P'); ylabel('target Vector T');

58 Παράδειγμα: Προσέγγιση συνάρτησης

59 Παράδειγμα: Προσέγγιση συνάρτησης eg = 0.02; % sum-squared error goal sc =.01; % spread constant net = newrb(p,t,eg,sc); NEWRB, neurons = 0, MSE = Για να δούμε πόσο ομαλά το ΝΝ ακολουθεί την συνάρτηση θα ορίσουμε ένα άλλο σύνολο σημείων στην είσοδο και θα δούμε την απόκρισή του ΝΝ σ αυτά τα νέα σημεία. Από την απόκριση φαίνεται η κακή του επίδοση, λόγω της μικρής τιμής του spead: X = -1:.01:1; Y = net(x); hold on; plot(x,y); hold off;

60 Παράδειγμα: Προσέγγιση συνάρτησης spead = 0.01

61 Παράδειγμα: Προσέγγιση συνάρτησης Εάν επαναλάβουμε την όλη διαδικασία για spead = 0.1

62 Παράδειγμα: Προσέγγιση συνάρτησης Για διαφορετικές τιμές του spead

63 Παράδειγμα: Προσέγγιση συνάρτησης Εάν χρησιμοποιήσουμε την εντολή newrbe το script θα είναι ελαφρώς διαφοροποιημένο στο σημείο εκείνο: sc = 1; % spread constant net = newrbe(x,t,sc); Θα πάρουμε τα εξής αποτελέσματα:

64 Παράδειγμα: Προσέγγιση συνάρτησης Παρατηρούμε πως με την εντολή newrbe η απόκριση του ΝΝ είναι καλύτερη. Βέβαια το δίκτυο τώρα έχει 21 νευρώνες RBF ενώ πρώτα είχε 6.

65 Παράδειγμα: Το πρόβλημα XOR close all, clear all, clc, format compact % number of samples of each cluster K = 100; % offset of clusters q =.6; % define 2 groups of input data A = [rand(1,k)-q rand(1,k)+q; rand(1,k)+q rand(1,k)-q]; B = [rand(1,k)+q rand(1,k)-q; rand(1,k)+q rand(1,k)-q]; % plot data plot(a(1,:),a(2,:),'k+',b(1,:),b(2,:),'b*') grid on hold on Δημιουργούμε 2 κλάσεις με 200 σημεία η κάθε μία (η μία με + και η άλλη με *)

66 Παράδειγμα: Το πρόβλημα XOR

67 Παράδειγμα: Το πρόβλημα XOR Αντιστοιχούμε το -1 και το 1 ως επιθυμητές εξόδους για την κάθε κλάση και ορίζουμε το ΝΝ. % coding (+1/-1) for 2-class XOR problem a = -1; b = 1; % define inputs (combine samples from all four classes) P = [A B]; % define targets T = [repmat(a,1,length(a)) repmat(b,1,length(b))]; % choose a spread constant spread = 1; % create a neural network net = newrbe(p,t,spread); % view network view(net)

68 Παράδειγμα: Το πρόβλημα XOR Warning: Rank deficient, rank = 124, tol = e-14. Όσα και τα δεδομένα εισόδου

69 % simulate a network on training data Y = net(p); % calculate [%] of correct classifications correct = 100 * length(find(t.*y > 0)) / length(t); fprintf('\nspread = %.2f\n',spread) fprintf('num of neurons = %d\n',net.layers{1}.size) fprintf('correct class = %.2f %%\n',correct) % plot targets and network response figure; plot(t') hold on grid on plot(y','r') ylim([-2 2]) set(gca,'ytick',[-2 0 2]) legend('targets','network response') xlabel('sample No.') Παράδειγμα: Το πρόβλημα XOR Το T.*Y>0 θα είναι θετικό [(1).(1) ή (-1).(-1)] μόνον όταν δεν έχω σφάλμα ταξινόμησης, δηλαδή μετράει τις σωστές ταξινομήσεις.

70 Παράδειγμα: Το πρόβλημα XOR Spread = 1.00 Num of neurons = 400 Correct class = %

71 % generate a grid span = -1:.025:2; [P1,P2] = meshgrid(span,span); pp = [P1(:) P2(:)]'; % simualte neural network on a grid aa = sim(net,pp); % plot classification regions based on MAX activation figure(1) ma = mesh(p1,p2,reshape(- aa,length(span),length(span))-5); mb = mesh(p1,p2,reshape( aa,length(span),length(span))-5); set(ma,'facecolor',[ ],'linestyle','none'); set(mb,'facecolor',[ ],'linestyle','none'); view(2) Παράδειγμα: Το πρόβλημα XOR Προσοχή!! Τα script πρέπει να τρέξουν το ένα μετά το άλλο. Κάθε φορά, δεν έχουμε το ίδιο ακριβώς αποτέλεσμα, λόγω τυχαιότητας.

72 Παράδειγμα: Το πρόβλημα XOR

73 Παράδειγμα: Το πρόβλημα XOR plot(net.iw{1}(:,1),net.iw{1}(:,2),'gs')

74 Δίκτυα Γενικευμένης Παλινδρόμησης Generalized Regression NN (GRNN) στο Matlab Τα GRNN μοιάζουν με τα RBF και χρησιμοποιούνται συχνά για την προσέγγιση συναρτήσεων. Η διαφορά τους συνίσταται στην διεργασία nprod, η οποία δίνει ένα άνυσμα n 2 με S 2 στοιχεία.

75 Δίκτυα Γενικευμένης Παλινδρόμησης (GRNN) στο Matlab Το κάθε στοιχείο του ανύσματος n 2 είναι το γινόμενο dot μιας γραμμής της LW 2,1 και του ανύσματος εισόδου a 1, κανονικοποιημένου με το άθροισμα των στοιχείων του a 1. Εάν π.χ. έχουμε: LW 2,1 = nprod LW 2,1, a 1 = και a 1 = 0.7 a = = 1 1x0.7 2x x x x x0.3 1 =

76 Παράδειγμα GRNN στο Matlab %% GRNN Function Approximation % This example uses functions NEWGRNN and SIM. % Here are eight data points of a function we would % like to fit. The functions inputs X should result % in target outputs T. X = [ ]; T = [ ]; plot(x,t,'.','markersize',30) axis([ ]) title('function to approximate.') xlabel('x') ylabel('t')

77 Παράδειγμα GRNN στο Matlab 4 Function to approximate T X

78 Παράδειγμα GRNN στο Matlab % We use NEWGRNN to create a generalized regression network. We use a SPREAD slightly lower than 1, the distance between input values, in order to get a function that fits individual data points fairly closely. A smaller spread would fit data better but be less smooth. spread = 0.7; net = newgrnn(x,t,spread); view(net) A = net(x); hold on outputline = plot(x,a,'.','markersize',30,'color',[1 0 0]); title('create and test y network.') xlabel('x') ylabel('t and A')

79 Παράδειγμα GRNN στο Matlab

80 Παράδειγμα GRNN στο Matlab 4 Create and test y network T and A X

81 Παράδειγμα GRNN στο Matlab % We can use the network to approximate the function at a new input value. x = 3.5; y = net(x); plot(x,y,'.','markersize',30,'color',[1 0 0]); title('new input value.') xlabel('x and x') ylabel('t and y')

82 Παράδειγμα GRNN στο Matlab 4 New input value T and y X and x

83 Παράδειγμα GRNN στο Matlab % Here the network's response is simulated for many values, allowing us to see the function it represents. X2 = 0:.1:9; Y2 = net(x2); plot(x2,y2,'linewidth',4,'color',[1 0 0]) title('function to approximate.') xlabel('x and X2') ylabel('t and Y2')

84 Παράδειγμα GRNN στο Matlab 4 Function to approximate T and Y X and X2

85 Πιθανοτικά Δίκτυα Probabilistic Neural Networks (PNN) στο Matlab Τα PNN χρησιμοποιούνται συνήθως σε προβλήματα ταξινόμησης.

86 PNN στο Matlab Όταν εμφανίζεται μια είσοδος, το 1 ο στρώμα RBF υπολογίζει ένα άνυσμα, τα στοιχεία του οποίου δείχνουν πόσο κοντά είναι η είσοδος στα ανύσματα εκπαίδευσης.

87 PNN στο Matlab Το 2 ο στρώμα αθροίζει αυτές τις συμμετοχές, για κάθε κλάση των δεδομένων εισόδου, για να δώσει στην έξοδό του ένα άνυσμα πιθανοτήτων.

88 PNN στο Matlab Τελικά, μια ανταγωνιστική συνάρτηση στην έξοδο του 2 ου στρώματος, ανιχνεύει την μέγιστη των πιθανοτήτων και δίνει 1 γι αυτή την κλάση και 0 για τις άλλες.

89 PNN στο Matlab Έχουμε Q ζεύγη ανυσμάτων εισόδων/στόχων. Κάθε άνυσμα στόχου έχει Κ στοιχεία (το ένα είναι 1 και τα υπόλοιπα 0). Δηλαδή, κάθε άνυσμα εισόδου αντιστοιχείται σε μία από τις Κ κλάσεις.

90 % PNN Classification % This example uses functions NEWPNN and SIM. % Here are three two-element input vectors X and their % associated classes Tc. We would like to create a % probabilistic neural network that classifies these % vectors properly. X = [1 2; 2 2; 1 1]'; Tc = [1 2 3]; plot(x(1,:),x(2,:),'.','markersize',30) for i=1:3, text(x(1,i)+0.1,x(2,i),sprintf('class %g',tc(i))), end axis([ ]) title('three vectors and their classes.') xlabel('x(1,:)') ylabel('x(2,:)') Παράδειγμα PNN στο Matlab

91 Παράδειγμα PNN στο Matlab

92 % First we convert the target class indices Tc to vectors T. Then we design a probabilistic neural network with NEWPNN. We use a SPREAD value of 1 because that is a typical distance between the input vectors. T = ind2vec(tc); spread = 1; net = newpnn(x,t,spread); view(net) Παράδειγμα PNN στο Matlab

93 Παράδειγμα PNN στο Matlab % Now we test the network on the design input vectors. We do this by simulating the network and converting its vector outputs to indices. Y = net(x); Yc = vec2ind(y); plot(x(1,:),x(2,:),'.','markersize',30) axis([ ]) for i=1:3,text(x(1,i)+0.1,x(2,i),sprintf('class %g',yc(i))),end title('testing the network.') xlabel('x(1,:)') ylabel('x(2,:)')

94 Παράδειγμα PNN στο Matlab 3 Testing the network class 1 class 2 X(2,:) class X(1,:)

95 Παράδειγμα PNN στο Matlab % Let's classify a new vector with our network. x = [2; 1.5]; y = net(x); ac = vec2ind(y); hold on plot(x(1),x(2),'.','markersize',30,'color',[1 0 0]) text(x(1)+0.1,x(2),sprintf('class %g',ac)) hold off title('classifying y new vector.') xlabel('x(1,:) and x(1)') ylabel('x(2,:) and x(2)')

96 Παράδειγμα PNN στο Matlab 3 Classifying y new vector. 2.5 X(2,:) and x(2) class 1 class 2 class 3 class X(1,:) and x(1)

97 % This diagram shows how the probabilistic neural network divides the input space into the three classes. x1 = 0:.05:3; x2 = x1; [X1,X2] = meshgrid(x1,x2); xx = [X1(:) X2(:)]'; yy = net(xx); yy = full(yy); m = mesh(x1,x2,reshape(yy(1,:),length(x1),length(x2))); set(m,'facecolor',[ ],'linestyle','none'); hold on Παράδειγμα PNN στο Matlab m = mesh(x1,x2,reshape(yy(2,:),length(x1),length(x2))); set(m,'facecolor',[ ],'linestyle','none');

98 m = mesh(x1,x2,reshape(yy(3,:),length(x1),length(x2))); set(m,'facecolor',[ ],'linestyle','none'); plot3(x(1,:),x(2,:),[1 1 1]+0.1,'.','markersize',30) plot3(x(1),x(2),1.1,'.','markersize',30,'color',[1 0 0]) hold off view(2) title('the three classes.') xlabel('x(1,:) and x(1)') ylabel('x(2,:) and x(2)') Παράδειγμα PNN στο Matlab

99 Παράδειγμα PNN στο Matlab 3 The three classes X(2,:) and x(2) X(1,:) and x(1)

Πραγματοποίηση Νευρωνικών Δικτύων με το Matlab. Νευρωνικά Δίκτυα

Πραγματοποίηση Νευρωνικών Δικτύων με το Matlab Το MATLAB μας δίνει την δυνατότητα να εργαστούμε στα με 4 τρόπους: Στο 1 ο επίπεδο με τον GUI. Μπορούμε με σχετική ευκολία να χρησιμοποιήσουμε τις εργαλειοθήκες

Πραγματοποίηση Νευρωνικών Δικτύων με το Matlab Το MATLAB μας δίνει την δυνατότητα να εργαστούμε στα με 4 τρόπους: Στο 1 ο επίπεδο με τον GUI. Μπορούμε με σχετική ευκολία να χρησιμοποιήσουμε τις εργαλειοθήκες

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP)

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Το μοντέλο Perceptron

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Νευρωνικά Δίκτυα στο Matlab

Νευρωνικά Δίκτυα στο Matlab Ρ202 Μηχανική Ευφυΐα (Machine Intelligence) Ευστάθιος Αντωνίου Τμήμα Μηχανικών Πληροφορικής Αλεξάνδρειο ΤΕΙ Θεσσαλονίκης E-mail: antoniou@itteithegr Πρόγραμμα Μεταπτυχιακών

Νευρωνικά Δίκτυα στο Matlab Ρ202 Μηχανική Ευφυΐα (Machine Intelligence) Ευστάθιος Αντωνίου Τμήμα Μηχανικών Πληροφορικής Αλεξάνδρειο ΤΕΙ Θεσσαλονίκης E-mail: antoniou@itteithegr Πρόγραμμα Μεταπτυχιακών

Αναγνώριση Προτύπων. Μη παραμετρικές τεχνικές Αριθμητικά. (Non Parametric Techniques)

Αναγνώριση Προτύπων Μη παραμετρικές τεχνικές Αριθμητικά Παραδείγματα (Non Parametric Techniques) Καθηγητής Χριστόδουλος Χαμζάς Τα περιεχόμενο της παρουσίασης βασίζεται στο βιβλίο: Introduction to Pattern

Αναγνώριση Προτύπων Μη παραμετρικές τεχνικές Αριθμητικά Παραδείγματα (Non Parametric Techniques) Καθηγητής Χριστόδουλος Χαμζάς Τα περιεχόμενο της παρουσίασης βασίζεται στο βιβλίο: Introduction to Pattern

ΔΙΚΤΥO RBF. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 15-16

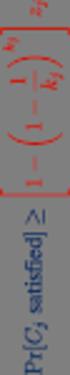

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

Νευρωνικά ίκτυα και Εξελικτικός

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα RBF (Radial Basis Functions) δίκτυα Παρεµβολή συνάρτησης Θεώρηµα Cover ιαχωρισµός προτύπων Υβριδική Εκµάθηση Σύγκριση µε MLP Εφαρµογή: Αναγνώριση

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα RBF (Radial Basis Functions) δίκτυα Παρεµβολή συνάρτησης Θεώρηµα Cover ιαχωρισµός προτύπων Υβριδική Εκµάθηση Σύγκριση µε MLP Εφαρµογή: Αναγνώριση

ΚΥΠΡΙΑΚΗ ΕΤΑΙΡΕΙΑ ΠΛΗΡΟΦΟΡΙΚΗΣ CYPRUS COMPUTER SOCIETY ΠΑΓΚΥΠΡΙΟΣ ΜΑΘΗΤΙΚΟΣ ΔΙΑΓΩΝΙΣΜΟΣ ΠΛΗΡΟΦΟΡΙΚΗΣ 19/5/2007

Οδηγίες: Να απαντηθούν όλες οι ερωτήσεις. Αν κάπου κάνετε κάποιες υποθέσεις να αναφερθούν στη σχετική ερώτηση. Όλα τα αρχεία που αναφέρονται στα προβλήματα βρίσκονται στον ίδιο φάκελο με το εκτελέσιμο

Οδηγίες: Να απαντηθούν όλες οι ερωτήσεις. Αν κάπου κάνετε κάποιες υποθέσεις να αναφερθούν στη σχετική ερώτηση. Όλα τα αρχεία που αναφέρονται στα προβλήματα βρίσκονται στον ίδιο φάκελο με το εκτελέσιμο

Το Πολυεπίπεδο Perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

Διακριτικές Συναρτήσεις

Διακριτικές Συναρτήσεις Δρ. Δηµήτριος Τσέλιος Επίκουρος Καθηγητής ΤΕΙ Θεσσαλίας Τµήµα Διοίκησης Επιχειρήσεων Θερµικός χάρτης των XYZ ξενοδοχείων σε σχέση µε τη γεωγραφική περιοχή τους P. Adamopoulos New

Διακριτικές Συναρτήσεις Δρ. Δηµήτριος Τσέλιος Επίκουρος Καθηγητής ΤΕΙ Θεσσαλίας Τµήµα Διοίκησης Επιχειρήσεων Θερµικός χάρτης των XYZ ξενοδοχείων σε σχέση µε τη γεωγραφική περιοχή τους P. Adamopoulos New

Υπολογιστική Νοημοσύνη. Μάθημα 10: Ομαδοποίηση με Ανταγωνιστική Μάθηση - Δίκτυα Kohonen

Υπολογιστική Νοημοσύνη Μάθημα 10: Ομαδοποίηση με Ανταγωνιστική Μάθηση - Δίκτυα Kohonen Ανταγωνιστικοί Νευρώνες Ένα στρώμα με ανταγωνιστικούς νευρώνες λειτουργεί ως εξής: Όλοι οι νευρώνες δέχονται το σήμα

Υπολογιστική Νοημοσύνη Μάθημα 10: Ομαδοποίηση με Ανταγωνιστική Μάθηση - Δίκτυα Kohonen Ανταγωνιστικοί Νευρώνες Ένα στρώμα με ανταγωνιστικούς νευρώνες λειτουργεί ως εξής: Όλοι οι νευρώνες δέχονται το σήμα

Το δίκτυο SOM. Νευρωνικά Δίκτυα

Το δίκτυο SOM Οι νευρώνες του εγκεφάλου έχουν μια αυστηρή τοπολογική οργάνωση, όπου -ανάλογα με την περιοχή που βρίσκονται- παίζουν έναν ιδιαίτερο ρόλο στις διάφορες λειτουργίες του (π.χ. για την ακοή,

Το δίκτυο SOM Οι νευρώνες του εγκεφάλου έχουν μια αυστηρή τοπολογική οργάνωση, όπου -ανάλογα με την περιοχή που βρίσκονται- παίζουν έναν ιδιαίτερο ρόλο στις διάφορες λειτουργίες του (π.χ. για την ακοή,

SCHOOL OF MATHEMATICAL SCIENCES G11LMA Linear Mathematics Examination Solutions

SCHOOL OF MATHEMATICAL SCIENCES GLMA Linear Mathematics 00- Examination Solutions. (a) i. ( + 5i)( i) = (6 + 5) + (5 )i = + i. Real part is, imaginary part is. (b) ii. + 5i i ( + 5i)( + i) = ( i)( + i)

SCHOOL OF MATHEMATICAL SCIENCES GLMA Linear Mathematics 00- Examination Solutions. (a) i. ( + 5i)( i) = (6 + 5) + (5 )i = + i. Real part is, imaginary part is. (b) ii. + 5i i ( + 5i)( + i) = ( i)( + i)

Ανάκτηση Πληροφορίας

ΑΡΙΣΤΟΤΕΛΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΕΣΣΑΛΟΝΙΚΗΣ ΑΝΟΙΚΤΑ ΑΚΑΔΗΜΑΪΚΑ ΜΑΘΗΜΑΤΑ Ενότητα 8: Λανθάνουσα Σημασιολογική Ανάλυση (Latent Semantic Analysis) Απόστολος Παπαδόπουλος Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό

ΑΡΙΣΤΟΤΕΛΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΕΣΣΑΛΟΝΙΚΗΣ ΑΝΟΙΚΤΑ ΑΚΑΔΗΜΑΪΚΑ ΜΑΘΗΜΑΤΑ Ενότητα 8: Λανθάνουσα Σημασιολογική Ανάλυση (Latent Semantic Analysis) Απόστολος Παπαδόπουλος Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό

derivation of the Laplacian from rectangular to spherical coordinates

derivation of the Laplacian from rectangular to spherical coordinates swapnizzle 03-03- :5:43 We begin by recognizing the familiar conversion from rectangular to spherical coordinates (note that φ is used

derivation of the Laplacian from rectangular to spherical coordinates swapnizzle 03-03- :5:43 We begin by recognizing the familiar conversion from rectangular to spherical coordinates (note that φ is used

Partial Differential Equations in Biology The boundary element method. March 26, 2013

The boundary element method March 26, 203 Introduction and notation The problem: u = f in D R d u = ϕ in Γ D u n = g on Γ N, where D = Γ D Γ N, Γ D Γ N = (possibly, Γ D = [Neumann problem] or Γ N = [Dirichlet

The boundary element method March 26, 203 Introduction and notation The problem: u = f in D R d u = ϕ in Γ D u n = g on Γ N, where D = Γ D Γ N, Γ D Γ N = (possibly, Γ D = [Neumann problem] or Γ N = [Dirichlet

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 2: Δομικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 2: Δομικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Συστήματα Αναμονής (Queuing Systems)

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ - ΕΜΠ ΣΧΟΛΗ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ & ΜΗΧ. ΥΠΟΛΟΓΙΣΤΩΝ Τομέας Επικοινωνιών, Ηλεκτρονικής & Συστημάτων Πληροφορικής Εργαστήριο Διαχείρισης & Βέλτιστου Σχεδιασμού Δικτύων Τηλεματικής

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ - ΕΜΠ ΣΧΟΛΗ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ & ΜΗΧ. ΥΠΟΛΟΓΙΣΤΩΝ Τομέας Επικοινωνιών, Ηλεκτρονικής & Συστημάτων Πληροφορικής Εργαστήριο Διαχείρισης & Βέλτιστου Σχεδιασμού Δικτύων Τηλεματικής

Approximation of distance between locations on earth given by latitude and longitude

Approximation of distance between locations on earth given by latitude and longitude Jan Behrens 2012-12-31 In this paper we shall provide a method to approximate distances between two points on earth

Approximation of distance between locations on earth given by latitude and longitude Jan Behrens 2012-12-31 In this paper we shall provide a method to approximate distances between two points on earth

3.4 SUM AND DIFFERENCE FORMULAS. NOTE: cos(α+β) cos α + cos β cos(α-β) cos α -cos β

3.4 SUM AND DIFFERENCE FORMULAS Page Theorem cos(αβ cos α cos β -sin α cos(α-β cos α cos β sin α NOTE: cos(αβ cos α cos β cos(α-β cos α -cos β Proof of cos(α-β cos α cos β sin α Let s use a unit circle

3.4 SUM AND DIFFERENCE FORMULAS Page Theorem cos(αβ cos α cos β -sin α cos(α-β cos α cos β sin α NOTE: cos(αβ cos α cos β cos(α-β cos α -cos β Proof of cos(α-β cos α cos β sin α Let s use a unit circle

ΚΥΠΡΙΑΚΗ ΕΤΑΙΡΕΙΑ ΠΛΗΡΟΦΟΡΙΚΗΣ CYPRUS COMPUTER SOCIETY ΠΑΓΚΥΠΡΙΟΣ ΜΑΘΗΤΙΚΟΣ ΔΙΑΓΩΝΙΣΜΟΣ ΠΛΗΡΟΦΟΡΙΚΗΣ 24/3/2007

Οδηγίες: Να απαντηθούν όλες οι ερωτήσεις. Όλοι οι αριθμοί που αναφέρονται σε όλα τα ερωτήματα μικρότεροι του 10000 εκτός αν ορίζεται διαφορετικά στη διατύπωση του προβλήματος. Αν κάπου κάνετε κάποιες υποθέσεις

Οδηγίες: Να απαντηθούν όλες οι ερωτήσεις. Όλοι οι αριθμοί που αναφέρονται σε όλα τα ερωτήματα μικρότεροι του 10000 εκτός αν ορίζεται διαφορετικά στη διατύπωση του προβλήματος. Αν κάπου κάνετε κάποιες υποθέσεις

Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη

Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Donald O. Hebb, Organization ofbehavior (1949) Ο Κανόνας του Hebb Είναι ένας από τους πρώτους κανόνες εκμάθησης στα νευρωνικά δίκτυα. Προτάθηκε αρχικά, από τον Hebb,

Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Donald O. Hebb, Organization ofbehavior (1949) Ο Κανόνας του Hebb Είναι ένας από τους πρώτους κανόνες εκμάθησης στα νευρωνικά δίκτυα. Προτάθηκε αρχικά, από τον Hebb,

Α.Τ.ΕΙ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΠΟΛΥΜΕΣΩΝ. ΕΡΓΑΣΤΗΡΙΟ ΤΕΧΝΗΤΩΝ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ

Α.Τ.ΕΙ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΠΟΛΥΜΕΣΩΝ. ΕΡΓΑΣΤΗΡΙΟ ΤΕΧΝΗΤΩΝ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΕΚΜΑΘΗΣΗ ΤΑ ΔΙΚΤΥΑ KOHONEN A. ΕΙΣΑΓΩΓΗ Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα

Α.Τ.ΕΙ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΠΟΛΥΜΕΣΩΝ. ΕΡΓΑΣΤΗΡΙΟ ΤΕΧΝΗΤΩΝ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΕΚΜΑΘΗΣΗ ΤΑ ΔΙΚΤΥΑ KOHONEN A. ΕΙΣΑΓΩΓΗ Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ 1 ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 21 Σεπτεµβρίου 2004 ιάρκεια: 3 ώρες Το παρακάτω σύνολο

ΘΕΜΑ 1 ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 21 Σεπτεµβρίου 2004 ιάρκεια: 3 ώρες Το παρακάτω σύνολο

Δρ. Βασίλειος Γ. Καμπουρλάζος Δρ. Ανέστης Γ. Χατζημιχαηλίδης

Μάθημα 4 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

Μάθημα 4 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ. Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα. Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε.

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες Χρήσης Το

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες Χρήσης Το

EE512: Error Control Coding

EE512: Error Control Coding Solution for Assignment on Finite Fields February 16, 2007 1. (a) Addition and Multiplication tables for GF (5) and GF (7) are shown in Tables 1 and 2. + 0 1 2 3 4 0 0 1 2 3

EE512: Error Control Coding Solution for Assignment on Finite Fields February 16, 2007 1. (a) Addition and Multiplication tables for GF (5) and GF (7) are shown in Tables 1 and 2. + 0 1 2 3 4 0 0 1 2 3

Υπολογιστική Νοημοσύνη. Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΗ ΓΡΑΜΜΙΚΟΙ ΤΑΞΙΝΟΜΗΤΕΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Η παραπάνω ανάλυση ήταν χρήσιμη προκειμένου να κατανοήσουμε τη λογική των δικτύων perceptrons πολλών επιπέδων

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΗ ΓΡΑΜΜΙΚΟΙ ΤΑΞΙΝΟΜΗΤΕΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Η παραπάνω ανάλυση ήταν χρήσιμη προκειμένου να κατανοήσουμε τη λογική των δικτύων perceptrons πολλών επιπέδων

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων. Δρ. Ε. Χάρου

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων Δρ. Ε. Χάρου Πρόγραμμα υπολογιστικής ευφυίας Ινστιτούτο Πληροφορικής & Τηλεπικοινωνιών ΕΚΕΦΕ ΔΗΜΟΚΡΙΤΟΣ exarou@iit.demokritos.gr Μηχανική

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων Δρ. Ε. Χάρου Πρόγραμμα υπολογιστικής ευφυίας Ινστιτούτο Πληροφορικής & Τηλεπικοινωνιών ΕΚΕΦΕ ΔΗΜΟΚΡΙΤΟΣ exarou@iit.demokritos.gr Μηχανική

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΧΑΡΤΟΓΡΑΦΗΣΗ ΤΟΥ ΧΩΡΟΥ ΤΩΝ ΤΑΞΙΝΟΜΗΤΩΝ Ταξινομητές Ταξινομητές συναρτ. διάκρισης Ταξινομητές επιφανειών απόφ. Παραμετρικοί ταξινομητές Μη παραμετρικοί

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΧΑΡΤΟΓΡΑΦΗΣΗ ΤΟΥ ΧΩΡΟΥ ΤΩΝ ΤΑΞΙΝΟΜΗΤΩΝ Ταξινομητές Ταξινομητές συναρτ. διάκρισης Ταξινομητές επιφανειών απόφ. Παραμετρικοί ταξινομητές Μη παραμετρικοί

ΕΙΣΑΓΩΓΗ ΣΤΗ ΣΤΑΤΙΣΤΙΚΗ ΑΝΑΛΥΣΗ

ΕΙΣΑΓΩΓΗ ΣΤΗ ΣΤΑΤΙΣΤΙΚΗ ΑΝΑΛΥΣΗ ΕΛΕΝΑ ΦΛΟΚΑ Επίκουρος Καθηγήτρια Τµήµα Φυσικής, Τοµέας Φυσικής Περιβάλλοντος- Μετεωρολογίας ΓΕΝΙΚΟΙ ΟΡΙΣΜΟΙ Πληθυσµός Σύνολο ατόµων ή αντικειµένων στα οποία αναφέρονται

ΕΙΣΑΓΩΓΗ ΣΤΗ ΣΤΑΤΙΣΤΙΚΗ ΑΝΑΛΥΣΗ ΕΛΕΝΑ ΦΛΟΚΑ Επίκουρος Καθηγήτρια Τµήµα Φυσικής, Τοµέας Φυσικής Περιβάλλοντος- Μετεωρολογίας ΓΕΝΙΚΟΙ ΟΡΙΣΜΟΙ Πληθυσµός Σύνολο ατόµων ή αντικειµένων στα οποία αναφέρονται

HMY 799 1: Αναγνώριση Συστημάτων

HMY 799 : Αναγνώριση Συστημάτων Διάλεξη Γραμμική παλινδρόμηση (Linear regression) Εμπειρική συνάρτηση μεταφοράς Ομαλοποίηση (smoothing) Y ( ) ( ) ω G ω = U ( ω) ω +Δ ω γ ω Δω = ω +Δω W ( ξ ω ) U ( ξ) G(

HMY 799 : Αναγνώριση Συστημάτων Διάλεξη Γραμμική παλινδρόμηση (Linear regression) Εμπειρική συνάρτηση μεταφοράς Ομαλοποίηση (smoothing) Y ( ) ( ) ω G ω = U ( ω) ω +Δ ω γ ω Δω = ω +Δω W ( ξ ω ) U ( ξ) G(

6. Στατιστικές μέθοδοι εκπαίδευσης

6. Στατιστικές μέθοδοι εκπαίδευσης Μία διαφορετική μέθοδος εκπαίδευσης των νευρωνικών δικτύων χρησιμοποιεί ιδέες από την Στατιστική Φυσική για να φέρει τελικά το ίδιο αποτέλεσμα όπως οι άλλες μέθοδοι,

6. Στατιστικές μέθοδοι εκπαίδευσης Μία διαφορετική μέθοδος εκπαίδευσης των νευρωνικών δικτύων χρησιμοποιεί ιδέες από την Στατιστική Φυσική για να φέρει τελικά το ίδιο αποτέλεσμα όπως οι άλλες μέθοδοι,

TMA4115 Matematikk 3

TMA4115 Matematikk 3 Andrew Stacey Norges Teknisk-Naturvitenskapelige Universitet Trondheim Spring 2010 Lecture 12: Mathematics Marvellous Matrices Andrew Stacey Norges Teknisk-Naturvitenskapelige Universitet

TMA4115 Matematikk 3 Andrew Stacey Norges Teknisk-Naturvitenskapelige Universitet Trondheim Spring 2010 Lecture 12: Mathematics Marvellous Matrices Andrew Stacey Norges Teknisk-Naturvitenskapelige Universitet

ΠΕΙΡΑΜΑΤΙΚΕΣ ΠΡΟΣΟΜΟΙΩΣΕΙΣ ΚΕΦΑΛΑΙΟ 4. είναι η πραγματική απόκριση του j δεδομένου (εκπαίδευσης ή ελέγχου) και y ˆ j

Πειραματικές Προσομοιώσεις ΚΕΦΑΛΑΙΟ 4 Όλες οι προσομοιώσεις έγιναν σε περιβάλλον Matlab. Για την υλοποίηση της μεθόδου ε-svm χρησιμοποιήθηκε το λογισμικό SVM-KM που αναπτύχθηκε στο Ecole d Ingenieur(e)s

Πειραματικές Προσομοιώσεις ΚΕΦΑΛΑΙΟ 4 Όλες οι προσομοιώσεις έγιναν σε περιβάλλον Matlab. Για την υλοποίηση της μεθόδου ε-svm χρησιμοποιήθηκε το λογισμικό SVM-KM που αναπτύχθηκε στο Ecole d Ingenieur(e)s

ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

ΜΑΣ 473/673: Μέθοδοι Πεπερασμένων Στοιχείων

ΜΑΣ 473/673: Μέθοδοι Πεπερασμένων Στοιχείων Ένα δυσδιάστατο παράδειγμα με το λογισμικό MATLAB Θεωρούμε το εξής Π.Σ.Τ.: Να βρεθεί η u(x, y) έτσι ώστε όπου f (x, y) = 1. u u f ( x, y), x ( 1,1) ( 1,1) x

ΜΑΣ 473/673: Μέθοδοι Πεπερασμένων Στοιχείων Ένα δυσδιάστατο παράδειγμα με το λογισμικό MATLAB Θεωρούμε το εξής Π.Σ.Τ.: Να βρεθεί η u(x, y) έτσι ώστε όπου f (x, y) = 1. u u f ( x, y), x ( 1,1) ( 1,1) x

Section 9.2 Polar Equations and Graphs

180 Section 9. Polar Equations and Graphs In this section, we will be graphing polar equations on a polar grid. In the first few examples, we will write the polar equation in rectangular form to help identify

180 Section 9. Polar Equations and Graphs In this section, we will be graphing polar equations on a polar grid. In the first few examples, we will write the polar equation in rectangular form to help identify

HMY 795: Αναγνώριση Προτύπων. Διάλεξη 2

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Θεωρία πιθανοτήτων Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (αντίθετα με τις ντετερμινιστικές μεταβλητές)

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Θεωρία πιθανοτήτων Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (αντίθετα με τις ντετερμινιστικές μεταβλητές)

Section 8.3 Trigonometric Equations

99 Section 8. Trigonometric Equations Objective 1: Solve Equations Involving One Trigonometric Function. In this section and the next, we will exple how to solving equations involving trigonometric functions.

99 Section 8. Trigonometric Equations Objective 1: Solve Equations Involving One Trigonometric Function. In this section and the next, we will exple how to solving equations involving trigonometric functions.

ANFIS(Από την Θεωρία στην Πράξη)

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ ΔΗΜΟΚΡΙΤΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΡΑΚΗΣ Πολυτεχνική Σχολή Τμήμα Πολιτικών Μηχανικών Βασ. Σοφίας 12 67100 Ξάνθη HELLENIC REPUBLIC DEMOCRITUS UNIVERSITY OF THRACE SCHOOL OF ENGINEERING Department

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ ΔΗΜΟΚΡΙΤΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΡΑΚΗΣ Πολυτεχνική Σχολή Τμήμα Πολιτικών Μηχανικών Βασ. Σοφίας 12 67100 Ξάνθη HELLENIC REPUBLIC DEMOCRITUS UNIVERSITY OF THRACE SCHOOL OF ENGINEERING Department

Areas and Lengths in Polar Coordinates

Kiryl Tsishchanka Areas and Lengths in Polar Coordinates In this section we develop the formula for the area of a region whose boundary is given by a polar equation. We need to use the formula for the

Kiryl Tsishchanka Areas and Lengths in Polar Coordinates In this section we develop the formula for the area of a region whose boundary is given by a polar equation. We need to use the formula for the

Other Test Constructions: Likelihood Ratio & Bayes Tests

Other Test Constructions: Likelihood Ratio & Bayes Tests Side-Note: So far we have seen a few approaches for creating tests such as Neyman-Pearson Lemma ( most powerful tests of H 0 : θ = θ 0 vs H 1 :

Other Test Constructions: Likelihood Ratio & Bayes Tests Side-Note: So far we have seen a few approaches for creating tests such as Neyman-Pearson Lemma ( most powerful tests of H 0 : θ = θ 0 vs H 1 :

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Version 2 1 Άλλοι τύποι νευρωνικών δικτύων Αυτοοργανούμενοι χάρτες (Self-organizing maps - SOMs) Αναδρομικά νευρωνικά δίκτυα (Recurrent Neural Networks): γενικής

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Version 2 1 Άλλοι τύποι νευρωνικών δικτύων Αυτοοργανούμενοι χάρτες (Self-organizing maps - SOMs) Αναδρομικά νευρωνικά δίκτυα (Recurrent Neural Networks): γενικής

Μάθηση και Γενίκευση. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μέθοδοι πολυδιάστατης ελαχιστοποίησης

Μέθοδοι πολυδιάστατης ελαχιστοποίησης με παραγώγους Μέθοδοι πολυδιάστατης ελαχιστοποίησης Δ. Γ. Παπαγεωργίου Τμήμα Μηχανικών Επιστήμης Υλικών Πανεπιστήμιο Ιωαννίνων dpapageo@cc.uoi.gr http://pc64.materials.uoi.gr/dpapageo

Μέθοδοι πολυδιάστατης ελαχιστοποίησης με παραγώγους Μέθοδοι πολυδιάστατης ελαχιστοποίησης Δ. Γ. Παπαγεωργίου Τμήμα Μηχανικών Επιστήμης Υλικών Πανεπιστήμιο Ιωαννίνων dpapageo@cc.uoi.gr http://pc64.materials.uoi.gr/dpapageo

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15 16 Λογιστική παλινδρόμηση (Logistic regression) Νευρωνικά Δίκτυα (Neural Networks) g ( x) = w x+ w T k k k0 1 ( T T WLS = X X) X T= X T Γραμμικές διαχωριστικές

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15 16 Λογιστική παλινδρόμηση (Logistic regression) Νευρωνικά Δίκτυα (Neural Networks) g ( x) = w x+ w T k k k0 1 ( T T WLS = X X) X T= X T Γραμμικές διαχωριστικές

Σκοπός μας είναι να εκπαιδεύσουμε το ΝΝ ώστε να πάρει από τα δεδομένα μόνο την «σοφία» που υπάρχει μέσα τους. Αυτή είναι η έννοια της γενίκευσης.

Μάθηση και Γενίκευση Ο Mark Twain, το 1897, έγραφε στο βιβλίο του «Following the Equator»: «Θα πρέπει με προσοχή να εξάγουμε από μια εμπειρία μόνο την σοφία που υπάρχει μέσα της και όχι να παρερμηνεύουμε,

Μάθηση και Γενίκευση Ο Mark Twain, το 1897, έγραφε στο βιβλίο του «Following the Equator»: «Θα πρέπει με προσοχή να εξάγουμε από μια εμπειρία μόνο την σοφία που υπάρχει μέσα της και όχι να παρερμηνεύουμε,

Προσομοίωση Νευρωνικού Δικτύου στο MATLAB. Κυριακίδης Ιωάννης 2013

Προσομοίωση Νευρωνικού Δικτύου στο MATLAB Κυριακίδης Ιωάννης 2013 Εισαγωγή Ένα νευρωνικό δίκτυο αποτελεί μια πολύπλοκη δομή, όπου τα βασικά σημεία που περιλαμβάνει είναι τα εξής: Πίνακες με τα βάρη των

Προσομοίωση Νευρωνικού Δικτύου στο MATLAB Κυριακίδης Ιωάννης 2013 Εισαγωγή Ένα νευρωνικό δίκτυο αποτελεί μια πολύπλοκη δομή, όπου τα βασικά σημεία που περιλαμβάνει είναι τα εξής: Πίνακες με τα βάρη των

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 17 18 Νευρωνικά Δίκτυα (Neural Networks) συνέχεια Minimum squared error procedure for classification 1 ( T T wls = X X) X b= X b Xw = b Logistic sigmoidal function

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 17 18 Νευρωνικά Δίκτυα (Neural Networks) συνέχεια Minimum squared error procedure for classification 1 ( T T wls = X X) X b= X b Xw = b Logistic sigmoidal function

Ανάκτηση Πληροφορίας

Το Πιθανοκρατικό Μοντέλο Κλασικά Μοντέλα Ανάκτησης Τρία είναι τα, λεγόμενα, κλασικά μοντέλα ανάκτησης: Λογικό (Boolean) που βασίζεται στη Θεωρία Συνόλων Διανυσματικό (Vector) που βασίζεται στη Γραμμική

Το Πιθανοκρατικό Μοντέλο Κλασικά Μοντέλα Ανάκτησης Τρία είναι τα, λεγόμενα, κλασικά μοντέλα ανάκτησης: Λογικό (Boolean) που βασίζεται στη Θεωρία Συνόλων Διανυσματικό (Vector) που βασίζεται στη Γραμμική

Αριθμητικές Μέθοδοι σε Προγραμματιστικό Περιβάλλον

Τμήμα Μηχανικών Πληροφορικής Αριθμητικές Μέθοδοι σε Προγραμματιστικό Περιβάλλον Δρ. Δημήτρης Βαρσάμης Επίκουρος Καθηγητής Οκτώβριος 2014 Δρ. Δημήτρης Βαρσάμης Οκτώβριος 2014 1 / 42 Αριθμητικές Μέθοδοι

Τμήμα Μηχανικών Πληροφορικής Αριθμητικές Μέθοδοι σε Προγραμματιστικό Περιβάλλον Δρ. Δημήτρης Βαρσάμης Επίκουρος Καθηγητής Οκτώβριος 2014 Δρ. Δημήτρης Βαρσάμης Οκτώβριος 2014 1 / 42 Αριθμητικές Μέθοδοι

ΣΥΝΗΘΕΙΣ ΔΙΑΦΟΡΙΚΕΣ ΕΞΙΣΩΣΕΙΣ ΣΤΗ MATLAB

ΣΥΝΗΘΕΙΣ ΔΙΑΦΟΡΙΚΕΣ ΕΞΙΣΩΣΕΙΣ ΣΤΗ MATLAB 1. Γενικά περί συνήθων διαφορικών εξισώσεων Μια συνήθης διαφορική εξίσωση (Σ.Δ.Ε.) 1 ης τάξης έχει τη μορφή dy dt f ( t, y( t)) όπου η συνάρτηση f(t, y) είναι γνωστή,

ΣΥΝΗΘΕΙΣ ΔΙΑΦΟΡΙΚΕΣ ΕΞΙΣΩΣΕΙΣ ΣΤΗ MATLAB 1. Γενικά περί συνήθων διαφορικών εξισώσεων Μια συνήθης διαφορική εξίσωση (Σ.Δ.Ε.) 1 ης τάξης έχει τη μορφή dy dt f ( t, y( t)) όπου η συνάρτηση f(t, y) είναι γνωστή,

Παραμετρικές εξισώσεις καμπύλων. ΗΥ111 Απειροστικός Λογισμός ΙΙ

ΗΥ-111 Απειροστικός Λογισμός ΙΙ Παραμετρικές εξισώσεις καμπύλων Παραδείγματα ct (): U t ( x ( t), x ( t)) 1 ct (): U t ( x ( t), x ( t), x ( t)) 3 1 3 Θέσης χρόνου ταχύτητας χρόνου Χαρακτηριστικού-χρόνου

ΗΥ-111 Απειροστικός Λογισμός ΙΙ Παραμετρικές εξισώσεις καμπύλων Παραδείγματα ct (): U t ( x ( t), x ( t)) 1 ct (): U t ( x ( t), x ( t), x ( t)) 3 1 3 Θέσης χρόνου ταχύτητας χρόνου Χαρακτηριστικού-χρόνου

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Εισαγωγή στα Τεχνητά Νευρωνικά Δίκτυα. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Εισαγωγή στα Τεχνητά Νευρωνικά Δίκτυα Τεχνητή Νοημοσύνη (Artificial Intelligence) Ανάπτυξη μεθόδων και τεχνολογιών για την επίλυση προβλημάτων στα οποία ο άνθρωπος υπερέχει (?) του υπολογιστή Συλλογισμοί

Εισαγωγή στα Τεχνητά Νευρωνικά Δίκτυα Τεχνητή Νοημοσύνη (Artificial Intelligence) Ανάπτυξη μεθόδων και τεχνολογιών για την επίλυση προβλημάτων στα οποία ο άνθρωπος υπερέχει (?) του υπολογιστή Συλλογισμοί

Ανταγωνιστική Εκμάθηση Δίκτυα Kohonen. Κυριακίδης Ιωάννης 2013

Ανταγωνιστική Εκμάθηση Δίκτυα Kohonen Κυριακίδης Ιωάννης 2013 Εισαγωγή Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα, υπήρχε μια διαδικασία εκπαίδευσης του δικτύου, κατά την οποία είχαμε διανύσματα

Ανταγωνιστική Εκμάθηση Δίκτυα Kohonen Κυριακίδης Ιωάννης 2013 Εισαγωγή Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα, υπήρχε μια διαδικασία εκπαίδευσης του δικτύου, κατά την οποία είχαμε διανύσματα

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM Μάθηση χωρίς επίβλεψη (unsupervised learning) Σύνολο εκπαίδευσης D={(x n )}, n=1,,n. x n =(x n1,, x nd ) T, δεν υπάρχουν τιμές-στόχοι t n. Προβλήματα μάθησης χωρίς

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM Μάθηση χωρίς επίβλεψη (unsupervised learning) Σύνολο εκπαίδευσης D={(x n )}, n=1,,n. x n =(x n1,, x nd ) T, δεν υπάρχουν τιμές-στόχοι t n. Προβλήματα μάθησης χωρίς

Numerical Analysis FMN011

Numerical Analysis FMN011 Carmen Arévalo Lund University carmen@maths.lth.se Lecture 12 Periodic data A function g has period P if g(x + P ) = g(x) Model: Trigonometric polynomial of order M T M (x) =

Numerical Analysis FMN011 Carmen Arévalo Lund University carmen@maths.lth.se Lecture 12 Periodic data A function g has period P if g(x + P ) = g(x) Model: Trigonometric polynomial of order M T M (x) =

Υπολογιστική Νοημοσύνη. Μάθημα 9: Γενίκευση

Υπολογιστική Νοημοσύνη Μάθημα 9: Γενίκευση Υπερπροσαρμογή (Overfitting) Ένα από τα βασικά προβλήματα που μπορεί να εμφανιστεί κατά την εκπαίδευση νευρωνικών δικτύων είναι αυτό της υπερβολικής εκπαίδευσης.

Υπολογιστική Νοημοσύνη Μάθημα 9: Γενίκευση Υπερπροσαρμογή (Overfitting) Ένα από τα βασικά προβλήματα που μπορεί να εμφανιστεί κατά την εκπαίδευση νευρωνικών δικτύων είναι αυτό της υπερβολικής εκπαίδευσης.

5269: Υπολογιστικές Μέθοδοι για Μηχανικούς Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων

5269: Υπολογιστικές Μέθοδοι για Μηχανικούς Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων http://ecourseschemengntuagr/courses/computational_methods_for_engineers/ Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων Γενικά:

5269: Υπολογιστικές Μέθοδοι για Μηχανικούς Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων http://ecourseschemengntuagr/courses/computational_methods_for_engineers/ Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων Γενικά:

5269: Υπολογιστικές Μέθοδοι για Μηχανικούς Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων

5269: Υπολογιστικές Μέθοδοι για Μηχανικούς Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων http://ecourseschemengntuagr/courses/computational_methods_for_engineers/ Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων Γενικά:

5269: Υπολογιστικές Μέθοδοι για Μηχανικούς Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων http://ecourseschemengntuagr/courses/computational_methods_for_engineers/ Συστήματα Γραμμικών Αλγεβρικών Εξισώσεων Γενικά:

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 4

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 4 ΤΟ ΔΙΚΤΥΟ PERCEPTRON I. Αρχιτεκτονική του δικτύου Το δίκτυο Perceptron είναι το πρώτο νευρωνικό δίκτυο το οποίο

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 4 ΤΟ ΔΙΚΤΥΟ PERCEPTRON I. Αρχιτεκτονική του δικτύου Το δίκτυο Perceptron είναι το πρώτο νευρωνικό δίκτυο το οποίο

Areas and Lengths in Polar Coordinates

Kiryl Tsishchanka Areas and Lengths in Polar Coordinates In this section we develop the formula for the area of a region whose boundary is given by a polar equation. We need to use the formula for the

Kiryl Tsishchanka Areas and Lengths in Polar Coordinates In this section we develop the formula for the area of a region whose boundary is given by a polar equation. We need to use the formula for the

Κεφ. 7: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών

Κεφ. 7: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών 7. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης) 7. Μέθοδος Euler 7.3

Κεφ. 7: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών 7. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης) 7. Μέθοδος Euler 7.3

Τεχνητή Νοημοσύνη. 18η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

2 Composition. Invertible Mappings

Arkansas Tech University MATH 4033: Elementary Modern Algebra Dr. Marcel B. Finan Composition. Invertible Mappings In this section we discuss two procedures for creating new mappings from old ones, namely,

Arkansas Tech University MATH 4033: Elementary Modern Algebra Dr. Marcel B. Finan Composition. Invertible Mappings In this section we discuss two procedures for creating new mappings from old ones, namely,

Τεχνητά Νευρωνικά Δίκτυα. Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης

Τεχνητά Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης Ο Βιολογικός Νευρώνας Δενδρίτες Συνάψεις Πυρήνας (Σώμα) Άξονας 2 Ο Βιολογικός Νευρώνας 3 Βασικά Χαρακτηριστικά

Τεχνητά Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης Ο Βιολογικός Νευρώνας Δενδρίτες Συνάψεις Πυρήνας (Σώμα) Άξονας 2 Ο Βιολογικός Νευρώνας 3 Βασικά Χαρακτηριστικά

Προσαρμοστικό Σύστημα Νευρο-ασαφούς Συμπερασμού ANFIS (Adaptive Network based Fuzzy Inference System)

ΔΗΜΟΚΡΙΤΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΡΑΚΗΣ Πολυτεχνική Σχολή Τμήμα Πολιτικών Μηχανικών DEMOCRITUS UNIVERSITY OF THRACE SCHOOL OF ENGINEERING Department of Civil Engineering Προσαρμοστικό Σύστημα Νευρο-ασαφούς Συμπερασμού

ΔΗΜΟΚΡΙΤΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΡΑΚΗΣ Πολυτεχνική Σχολή Τμήμα Πολιτικών Μηχανικών DEMOCRITUS UNIVERSITY OF THRACE SCHOOL OF ENGINEERING Department of Civil Engineering Προσαρμοστικό Σύστημα Νευρο-ασαφούς Συμπερασμού

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Άσκηση εφαρμογής της μεθόδου Newton Raphson

Άσκηση εφαρμογής της μεθόδου Newton Raphson Η ακόλουθη αντίδραση πραγματοποιείται σε έναν αντιδραστήρα αέριας φάσης: H 2 S+O 2 H 2 +SO 2 Όταν το σύστημα φτάσει σε ισορροπία στους 600Κ και 10 atm, τα μοριακά

Άσκηση εφαρμογής της μεθόδου Newton Raphson Η ακόλουθη αντίδραση πραγματοποιείται σε έναν αντιδραστήρα αέριας φάσης: H 2 S+O 2 H 2 +SO 2 Όταν το σύστημα φτάσει σε ισορροπία στους 600Κ και 10 atm, τα μοριακά

27-Ιαν-2009 ΗΜΥ 429. 2. (ι) Βασική στατιστική (ιι) Μετατροπές: αναλογικό-σεψηφιακό και ψηφιακό-σε-αναλογικό

ΗΜΥ 429 2. (ι) Βασική στατιστική (ιι) Μετατροπές: αναλογικό-σεψηφιακό και ψηφιακό-σε-αναλογικό 1 (i) Βασική στατιστική 2 Στατιστική Vs Πιθανότητες Στατιστική: επιτρέπει μέτρηση και αναγνώριση θορύβου και

ΗΜΥ 429 2. (ι) Βασική στατιστική (ιι) Μετατροπές: αναλογικό-σεψηφιακό και ψηφιακό-σε-αναλογικό 1 (i) Βασική στατιστική 2 Στατιστική Vs Πιθανότητες Στατιστική: επιτρέπει μέτρηση και αναγνώριση θορύβου και

ΚΥΠΡΙΑΚΗ ΕΤΑΙΡΕΙΑ ΠΛΗΡΟΦΟΡΙΚΗΣ CYPRUS COMPUTER SOCIETY ΠΑΓΚΥΠΡΙΟΣ ΜΑΘΗΤΙΚΟΣ ΔΙΑΓΩΝΙΣΜΟΣ ΠΛΗΡΟΦΟΡΙΚΗΣ 6/5/2006

Οδηγίες: Να απαντηθούν όλες οι ερωτήσεις. Ολοι οι αριθμοί που αναφέρονται σε όλα τα ερωτήματα είναι μικρότεροι το 1000 εκτός αν ορίζεται διαφορετικά στη διατύπωση του προβλήματος. Διάρκεια: 3,5 ώρες Καλή

Οδηγίες: Να απαντηθούν όλες οι ερωτήσεις. Ολοι οι αριθμοί που αναφέρονται σε όλα τα ερωτήματα είναι μικρότεροι το 1000 εκτός αν ορίζεται διαφορετικά στη διατύπωση του προβλήματος. Διάρκεια: 3,5 ώρες Καλή

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Υπολογιστική Νοημοσύνη. Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning

Υπολογιστική Νοημοσύνη Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning Κεντρική ιδέα Τα παραδείγματα μάθησης παρουσιάζονται στο μηεκπαιδευμένο δίκτυο και υπολογίζονται οι έξοδοι. Για

Υπολογιστική Νοημοσύνη Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning Κεντρική ιδέα Τα παραδείγματα μάθησης παρουσιάζονται στο μηεκπαιδευμένο δίκτυο και υπολογίζονται οι έξοδοι. Για

Second Order Partial Differential Equations

Chapter 7 Second Order Partial Differential Equations 7.1 Introduction A second order linear PDE in two independent variables (x, y Ω can be written as A(x, y u x + B(x, y u xy + C(x, y u u u + D(x, y

Chapter 7 Second Order Partial Differential Equations 7.1 Introduction A second order linear PDE in two independent variables (x, y Ω can be written as A(x, y u x + B(x, y u xy + C(x, y u u u + D(x, y

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΙΑ ΣΥΜΒΑΣΗ: Προκειμένου να καταστήσουμε πιο συμπαγή το συμβολισμό H : ορίζουμε Ετσι έχουμε *=[ ] an *=[ ]. H : * * ΣΗΜΕΙΩΣΗ: Στη συνέχεια εκτός αν ορίζεται

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΙΑ ΣΥΜΒΑΣΗ: Προκειμένου να καταστήσουμε πιο συμπαγή το συμβολισμό H : ορίζουμε Ετσι έχουμε *=[ ] an *=[ ]. H : * * ΣΗΜΕΙΩΣΗ: Στη συνέχεια εκτός αν ορίζεται

c(x 1 + x 2 + x 3 ) εάν 0 x 1, x 2, x 3 k (x 1, x 2, x 3 ) =

ΠΟΛΥΤΕΧΝΕΙΟ ΚΡΗΤΗΣ Τμήμα Ηλεκτρονικών Μηχανικών και Μηχανικών Υπολογιστών Τομέας Τηλεπικοινωνιών ΤΗΛ 11: ΠΙΘΑΝΟΤΗΤΕΣ ΚΑΙ ΤΥΧΑΙΑ ΣΗΜΑΤΑ 4ο Εξάμηνο 009-010 η ΕΡΓΑΣΙΑ ΑΣΚΗΣΗ 1 Εστω X = x 1, x, x T τυχαίο

ΠΟΛΥΤΕΧΝΕΙΟ ΚΡΗΤΗΣ Τμήμα Ηλεκτρονικών Μηχανικών και Μηχανικών Υπολογιστών Τομέας Τηλεπικοινωνιών ΤΗΛ 11: ΠΙΘΑΝΟΤΗΤΕΣ ΚΑΙ ΤΥΧΑΙΑ ΣΗΜΑΤΑ 4ο Εξάμηνο 009-010 η ΕΡΓΑΣΙΑ ΑΣΚΗΣΗ 1 Εστω X = x 1, x, x T τυχαίο

11 ΣΥΝΗΘΕΙΣ ΔΙΑΦΟΡΙΚΕΣ ΕΞΙΣΩΣΕΙΣ

11 ΣΥΝΗΘΕΙΣ ΔΙΑΦΟΡΙΚΕΣ ΕΞΙΣΩΣΕΙΣ 11.1 Γενικά περί συνήθων διαφορικών εξισώσεων Μια συνήθης διαφορική εξίσωση (ΣΔΕ) 1 ης τάξης έχει τη μορφή dy d = f (, y()) όπου f(, y) γνωστή και y() άγνωστη συνάρτηση.

11 ΣΥΝΗΘΕΙΣ ΔΙΑΦΟΡΙΚΕΣ ΕΞΙΣΩΣΕΙΣ 11.1 Γενικά περί συνήθων διαφορικών εξισώσεων Μια συνήθης διαφορική εξίσωση (ΣΔΕ) 1 ης τάξης έχει τη μορφή dy d = f (, y()) όπου f(, y) γνωστή και y() άγνωστη συνάρτηση.

ΧΑΡΟΚΟΠΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΤΗΛΕΜΑΤΙΚΗΣ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ. Καραγιώργου Σοφία

ΧΑΡΟΚΟΠΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΤΗΛΕΜΑΤΙΚΗΣ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Καραγιώργου Σοφία Εισαγωγή Προσομοιώνει βιολογικές διεργασίες (π.χ. λειτουργία του εγκεφάλου, διαδικασία

ΧΑΡΟΚΟΠΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΤΗΛΕΜΑΤΙΚΗΣ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Καραγιώργου Σοφία Εισαγωγή Προσομοιώνει βιολογικές διεργασίες (π.χ. λειτουργία του εγκεφάλου, διαδικασία

Κεφ. 6Β: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών

Κεφ. 6Β: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης). Μέθοδος Euler 3. Μέθοδοι

Κεφ. 6Β: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης). Μέθοδος Euler 3. Μέθοδοι

11/23/2014. Στόχοι. Λογισμικό Υπολογιστή

ονάδα Δικτύων και Επικοινωνιών ΗΥ Τομέας Πληροφορικής, αθηματικών και Στατιστικής ΓΕΩΠΟΙΚΟ ΠΑΕΠΙΣΤΗΙΟ ΑΘΗΩ Εισαγωγή στην Επιστήμη των ΗΥ άθημα-4 url: http://openeclass.aua.gr (AOA0) Λογισμικό Υπολογιστή

ονάδα Δικτύων και Επικοινωνιών ΗΥ Τομέας Πληροφορικής, αθηματικών και Στατιστικής ΓΕΩΠΟΙΚΟ ΠΑΕΠΙΣΤΗΙΟ ΑΘΗΩ Εισαγωγή στην Επιστήμη των ΗΥ άθημα-4 url: http://openeclass.aua.gr (AOA0) Λογισμικό Υπολογιστή

Homework 3 Solutions

Homework 3 Solutions Igor Yanovsky (Math 151A TA) Problem 1: Compute the absolute error and relative error in approximations of p by p. (Use calculator!) a) p π, p 22/7; b) p π, p 3.141. Solution: For

Homework 3 Solutions Igor Yanovsky (Math 151A TA) Problem 1: Compute the absolute error and relative error in approximations of p by p. (Use calculator!) a) p π, p 22/7; b) p π, p 3.141. Solution: For

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ. ΕΝΟΤΗΤΑ: Διανύσματα στους Rn, Cn, διανύσματα στο χώρο (3) ΔΙΔΑΣΚΩΝ: Βλάμος Παναγιώτης ΙΟΝΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ

ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ ΕΝΟΤΗΤΑ: Διανύσματα στους Rn, Cn, διανύσματα στο χώρο (3) ΙΟΝΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΔΙΔΑΣΚΩΝ: Βλάμος Παναγιώτης Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ ΕΝΟΤΗΤΑ: Διανύσματα στους Rn, Cn, διανύσματα στο χώρο (3) ΙΟΝΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΔΙΔΑΣΚΩΝ: Βλάμος Παναγιώτης Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

b. Use the parametrization from (a) to compute the area of S a as S a ds. Be sure to substitute for ds!

MTH U341 urface Integrals, tokes theorem, the divergence theorem To be turned in Wed., Dec. 1. 1. Let be the sphere of radius a, x 2 + y 2 + z 2 a 2. a. Use spherical coordinates (with ρ a) to parametrize.

MTH U341 urface Integrals, tokes theorem, the divergence theorem To be turned in Wed., Dec. 1. 1. Let be the sphere of radius a, x 2 + y 2 + z 2 a 2. a. Use spherical coordinates (with ρ a) to parametrize.

Data Analytics Και Ευφυή Συστήματα Πρόβλεψης Δεδομένων Σε Χρονοσειρά. Εφαρμογή Στον Εναρμονισμένο Δείκτη Τιμών Καταναλωτή.

Data Analytics Και Ευφυή Συστήματα Πρόβλεψης Δεδομένων Σε Χρονοσειρά. Εφαρμογή Στον Εναρμονισμένο Δείκτη Τιμών Καταναλωτή. Τόγιας Παναγιώτης ΤΕΙ Δυτικής Ελλάδας ptogias@outlook.com Μαργαρίτης Σωτήρης ΤΕΙ

Data Analytics Και Ευφυή Συστήματα Πρόβλεψης Δεδομένων Σε Χρονοσειρά. Εφαρμογή Στον Εναρμονισμένο Δείκτη Τιμών Καταναλωτή. Τόγιας Παναγιώτης ΤΕΙ Δυτικής Ελλάδας ptogias@outlook.com Μαργαρίτης Σωτήρης ΤΕΙ

Section 7.6 Double and Half Angle Formulas

09 Section 7. Double and Half Angle Fmulas To derive the double-angles fmulas, we will use the sum of two angles fmulas that we developed in the last section. We will let α θ and β θ: cos(θ) cos(θ + θ)

09 Section 7. Double and Half Angle Fmulas To derive the double-angles fmulas, we will use the sum of two angles fmulas that we developed in the last section. We will let α θ and β θ: cos(θ) cos(θ + θ)

Πανεπιστήμιο Δυτικής Μακεδονίας. Τμήμα Μηχανικών Πληροφορικής & Τηλεπικοινωνιών. Ηλεκτρονική Υγεία. Εργαστήριο 5 ο : MATLAB

Τμήμα Μηχανικών Πληροφορικής & Τηλεπικοινωνιών Ηλεκτρονική Υγεία Εργαστήριο 5 ο : MATLAB Αν. καθηγητής Αγγελίδης Παντελής e-mail: paggelidis@uowm.gr Τμήμα Μηχανικών Πληροφορικής και Τηλεπικοινωνιών Άδειες

Τμήμα Μηχανικών Πληροφορικής & Τηλεπικοινωνιών Ηλεκτρονική Υγεία Εργαστήριο 5 ο : MATLAB Αν. καθηγητής Αγγελίδης Παντελής e-mail: paggelidis@uowm.gr Τμήμα Μηχανικών Πληροφορικής και Τηλεπικοινωνιών Άδειες

Προγραμματισμός και Χρήση Ηλεκτρονικών Υπολογιστών - Βασικά Εργαλεία Λογισμικού

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ ΣΧΟΛΗ ΧΗΜΙΚΩΝ ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΙΚΟ ΚΕΝΤΡΟ Προγραμματισμός και Χρήση Ηλεκτρονικών Υπολογιστών - Βασικά Εργαλεία Λογισμικού Μάθημα 9ο Aντώνης Σπυρόπουλος Σφάλματα στρογγυλοποίησης

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ ΣΧΟΛΗ ΧΗΜΙΚΩΝ ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΙΚΟ ΚΕΝΤΡΟ Προγραμματισμός και Χρήση Ηλεκτρονικών Υπολογιστών - Βασικά Εργαλεία Λογισμικού Μάθημα 9ο Aντώνης Σπυρόπουλος Σφάλματα στρογγυλοποίησης

Queensland University of Technology Transport Data Analysis and Modeling Methodologies

Queensland University of Technology Transport Data Analysis and Modeling Methodologies Lab Session #7 Example 5.2 (with 3SLS Extensions) Seemingly Unrelated Regression Estimation and 3SLS A survey of 206

Queensland University of Technology Transport Data Analysis and Modeling Methodologies Lab Session #7 Example 5.2 (with 3SLS Extensions) Seemingly Unrelated Regression Estimation and 3SLS A survey of 206

Ανδρέας Παπαζώης. Τμ. Διοίκησης Επιχειρήσεων

Ανδρέας Παπαζώης Τμ. Διοίκησης Επιχειρήσεων Περιεχόμενα Εργ. Μαθήματος Εκπαίδευση (μάθηση) Νευρωνικών Δικτύων Απλός αισθητήρας Παράδειγμα εκπαίδευσης Θέματα υλοποίησης Νευρωνικών Δικτύων 2/17 Διαδικασία

Ανδρέας Παπαζώης Τμ. Διοίκησης Επιχειρήσεων Περιεχόμενα Εργ. Μαθήματος Εκπαίδευση (μάθηση) Νευρωνικών Δικτύων Απλός αισθητήρας Παράδειγμα εκπαίδευσης Θέματα υλοποίησης Νευρωνικών Δικτύων 2/17 Διαδικασία

ΚΕΦΑΛΑΙΟ 5. Matlab GUI για FWSVM και Global SVM

ΚΕΦΑΛΑΙΟ 5 Matlab GUI για FWSVM και Global SVM Προκειμένου να γίνουν οι πειραματικές προσομοιώσεις του κεφαλαίου 4, αναπτύξαμε ένα γραφικό περιβάλλον (Graphical User Interface) που εξασφαλίζει την εύκολη

ΚΕΦΑΛΑΙΟ 5 Matlab GUI για FWSVM και Global SVM Προκειμένου να γίνουν οι πειραματικές προσομοιώσεις του κεφαλαίου 4, αναπτύξαμε ένα γραφικό περιβάλλον (Graphical User Interface) που εξασφαλίζει την εύκολη

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 2-22 Support vector machies (συνέχεια) Support vector machies (συνέχεια) Usupervised learig: Clusterig ad Gaussia mixtures Kerel fuctios: k( xx, ') = ϕ ( x) ϕ( x

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 2-22 Support vector machies (συνέχεια) Support vector machies (συνέχεια) Usupervised learig: Clusterig ad Gaussia mixtures Kerel fuctios: k( xx, ') = ϕ ( x) ϕ( x

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΠΕΞΕΡΓΑΣΙΑ ΕΙΚΟΝΑΣ. Ενότητα 4: Δειγματοληψία και Κβάντιση Εικόνας

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΠΕΞΕΡΓΑΣΙΑ ΕΙΚΟΝΑΣ Ενότητα 4: Δειγματοληψία και Κβάντιση Εικόνας Ιωάννης Έλληνας Τμήμα Υπολογιστικών Συστημάτων Άδειες Χρήσης

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΠΕΞΕΡΓΑΣΙΑ ΕΙΚΟΝΑΣ Ενότητα 4: Δειγματοληψία και Κβάντιση Εικόνας Ιωάννης Έλληνας Τμήμα Υπολογιστικών Συστημάτων Άδειες Χρήσης