Μεταπτυχιακή Διπλωματική Εργασία. Βαθιά Αραιή Κωδικοποίηση (Deep Sparse Coding)

|

|

|

- Αλέξιο Παπανικολάου

- 7 χρόνια πριν

- Προβολές:

Transcript

1 Εργαστήριο Ηλεκτρονικής Τομέας Ηλεκτρονικής και Υπολογιστών Τμήμα Φυσικής Πανεπιστήμιο Πατρών Μεταπτυχιακή Διπλωματική Εργασία Βαθιά Αραιή Κωδικοποίηση (Deep Sparse Coding) Τσουρούνης Δημήτριος Α.Μ. : Πάτρα, Οκτώβριος 2017

2 ii

3 Βαθιά Αραιή Κωδικοποίηση (Deep Sparse Coding) Ειδική Επιστημονική Εργασία για την απόκτηση του Μεταπτυχιακού Διπλώματος Ειδίκευσης στην ΗΛΕΚΤΡΟΝΙΚΗ ΚΑΙ ΕΠΕΞΕΡΓΑΣΙΑ ΤΗΣ ΠΛΗΡΟΦΟΡΙΑΣ (ΔΠΜΣ "Ηλεκτρονική και Επεξεργασία της Πληροφορίας" ΗΕΠ) Τσουρούνης Δημήτριος Α.Μ. : Εξεταστική Επιτροπή : Οικονόμου Γεώργιος, Καθηγητής (επιβλέπων) Φωτόπουλος Σπύρος, Καθηγητής Αναστασόπουλος Βασίλειος, Καθηγητής iii

4 iv

5 v

6 vi

7 Η υλοποίηση της παρούσης εργασίας πραγματοποιήθηκε μέσω του λογισμικού MATLAB (mathworks). Για την εκτέλεση των διεργασιών χρησιμοποιήθηκαν οι εργαλειοθήκες K-SVD & OMP box [Aharon 2006], SPAMS (SPArse Modeling Software) [Mairal 2009] και VLFEAT [Vedaldi 2008] καθώς και οι βιβλιοθήκες LIBLINEAR [Fan 2008] και LibSVM [Chang 2011]. Επίσης, χρησιμοποιήθηκαν οι συναρτήσεις προ-επεξεργασίας των εικόνων που αντιστοιχούν σε κάθε βάση δεδομένων. Όλα τα υπόλοιπα αλγοριθμικά προγράμματα (κώδικες matlab) αποτελούν αποτέλεσμα προσωπικής εργασίας και σχεδιάστηκαν κατά την διάρκεια εκπόνησης της παρούσης μεταπτυχιακής εργασίας με τίτλο «Βαθιά Αραιή Κωδικοποίηση (Deep Sparse Coding)». vii

8 viii

9 Περίληψη Η έννοια της αραιότητας (sparsity ή parsimony) έγκειται στην αναπαράσταση ενός φαινομένου με όσο το δυνατόν λιγότερες μεταβλητές. Στον τομέα της Μηχανική Μάθησης, η αραιή αναπαράσταση (Sparse Representation) αποτελεί μία μέθοδο μη-εποπτευόμενης μάθησης (unsupervised learning), όπου επιχειρείται η ελαχιστοποίησης του σφάλματος αναπαράστασης του σήματος με έναν περιορισμό αραιότητας. Έτσι, κάθε σήμα αναπαρίσταται σαν γραμμικός συνδυασμός ενός περιορισμένου αριθμού σημάτων ενός υπερπλήρους λεξικού, που ονομάζονται άτομα. Η επέκταση της αραιής αναπαράστασης σε μία αποδοτική πολλαπλών επιπέδων αρχιτεκτονική επιτυγχάνεται μέσα από τη σύνθεση της αρχιτεκτονικής Bag-of-Visual-words και της αρχιτεκτονικής deep Learning (βαθιά Μάθηση) για την ανάπτυξη μίας αρχιτεκτονικής μη-εποπτευόμενης μάθησης χαρακτηριστικών, που ονομάζεται Deep Sparse Coding (Βαθιά Αραιή Κωδικοποίηση). Η βασική πρωτοτυπία της τοπολογίας Deep Sparse Coding είναι η μονάδα σύνδεσης που τοποθετείται μεταξύ των επιπέδων αραιής αναπαράστασης. Η μονάδα σύνδεσης συγκροτείται από μία διαδικασία τοπικής χωρικής συγκέντρωσης (local spatial pooling) των αραιών αναπαραστάσεων που έχουν υπολογιστεί στο προηγούμενο επίπεδο και από μία διαδικασία ελάττωσης διάστασης (dimensionality reduction) για την παραγωγή των πυκνών αναπαραστάσεων που θα διαδοθούν στο επόμενο επίπεδο. Η τοπική χωρική συγκέντρωση εξασφαλίζει ότι τα σύνθετα χαρακτηριστικά υψηλότερου επιπέδου προκύπτουν σαν αποτέλεσμα εκμάθησης από τη σύνθεση γειτονικών απλούστερων χαρακτηριστικών χαμηλότερου επιπέδου και ως εκ τούτου ότι καλύπτονται μεγαλύτερες περιοχές της εικόνας καθώς η τοπολογία γίνεται βαθύτερη ενώ η μέθοδος ελάττωσης διάστασης εκτελείται λαμβάνοντας υπόψη τις χωρικές σχέσεις μεταξύ των γειτονικών patches της εικόνας έτσι ώστε να διατηρείται η χωρική πληροφορία ομαλότητας των patches κατά τη διαδικασία ελάττωσης διάστασης. Με αυτό τον τρόπο, η τοπολογία Deep Sparse Coding εξάγει ιεραρχικά χαρακτηριστικά από διαφορετικές βαθμίδες της όλης διαδικασίας εκμάθησης που αντιστοιχούν σε διαφορετικές χωρικές περιοχές της εικόνας. Άρα, δομούνται ιεραρχικές αναπαραστάσεις των δεδομένων και υπολογίζονται χαρακτηριστικά υψηλής τάξης (high-level) από τα βαθύτερα (υψηλότερα) επίπεδα (layers) μέσω της σύνθεσης των απλούστερων χαρακτηριστικών από τα χαμηλότερα (αρχικά) επίπεδα της τοπολογίας. Η τοπολογία Deep Sparse Coding εφαρμόζεται σε δύο σημαντικά προβλήματα υπολογιστικής όρασης, που είναι η αναγνώριση φυσικών εικόνων και η αναγνώριση χειρόγραφων υπογραφών (αναγνώριση βιομετρικών χαρακτηριστικών). Το αποτέλεσμα και στις δύο περιπτώσεις είναι ότι η χρήση πολλαπλών επιπέδων αραιής αναπαράστασης μέσω της μεθόδου Deep Sparse Coding οδηγεί στη βελτίωση της απόδοσης αναγνώρισης. ix

10 x

11 Abstract The principle of sparsity (or parsimony) consists of representing some phenomenon with as few variables as possible. In Machine Learning, Sparse Representation is an unsupervised learning method that attempts to minimize the feature reconstruction error, along with a prior regularization that encourages sparse solutions. So, every input signal is representing as a linear combination of a few element of an overcomplete dictionary, which called atoms. The combination of deep Learning and the sparse coding Bag-of-Visual-words pipeline is an unsupervised feature learning framework, namely Deep Sparse Coding, that extends sparse coding to an efficient multi-layer architecture. The main innovation of the Deep Sparse Coding framework is the connection unit between layers that connects the sparse-encoders from different layers by a sparse-to-dense module. The connection unit consists of a local spatial pooling step, which applies the pooling operation to the subsets of sparse codes from the last layer, and a dimensionality reduction step, which converts the sparse codes to dense codes for the next layer. On one hand, the local spatial pooling step ensures the higher-level features are learned from a collection of nearby lower-level features and hence cover larger scopes. On the other hand, the low-dimensional embedding process is designed to take into account the spatial affinities between neighboring image patches such that the spatial smoothness information is preserved during the dimension reduction process. The Deep Sparse Coding method is able to learn sparse representations of the images at different levels of abstraction and of different spatial scopes. The method builds feature hierarchies from bottom-level features, such that the higher-level features (from deeper layers) are compositions of lower-level features (from first layers). The Deep Sparse Coding framework is testing for image classification (natural images recognition) and handwritten signature verification (biometrics recognition). In both cases, the multi-layer framework improves performance. xi

12 xii

13 Η παρούσα εργασία, με τίτλο «Βαθιά Αραιή Κωδικοποίηση (Deep Sparse Coding)», συγκροτείται σε κεφάλαια με στόχο το κάθε κεφάλαιο να είναι αυτόνομο έτσι ώστε ένας αναγνώστης με γνώση του αντικειμένου να μπορεί να μελετήσει το κάθε κεφάλαιο ανεξάρτητα χωρίς να απαιτείται να έχει διαβάσει τα προηγούμενα κεφάλαια και χωρίς να χρειάζεται να ανατρέχει στα προηγούμενα κεφάλαια κατά την διάρκεια της μελέτης ενός κεφαλαίου. Το πρώτο (1 ο ) κεφάλαιο αποτελεί μία εισαγωγή στην μηχανική μάθηση (ή εκμάθηση). Το δεύτερο (2 ο ) κεφάλαιο αναφέρεται στην αραιή αναπαράσταση και περιγράφονται αναλυτικά δύο κυρίαρχες τεχνικές επίλυσης του προβλήματος της αραιής αναπαράστασης. Το τρίτο (3 ο ) κεφάλαιο επεκτείνει την αραιή αναπαράσταση σε πολλαπλά επίπεδα μέσω της αναλυτικής περιγραφής της τοπολογίας Deep Sparse Coding (Βαθιάς Αραιής Κωδικοποίησης). Το τέταρτο (4 ο ) κεφάλαιο περιέχει τα πειραματικά αποτελέσματα από την εφαρμογή της τοπολογίας Deep Sparse Coding σε δύο σημαντικά προβλήματα της υπολογιστικής όρασης. Το πέμπτο (5 ο ) και τελευταίο κεφάλαιο περιλαμβάνει μία σύνοψη και κριτική της μεθόδου πολλαπλών επιπέδων αραιής αναπαράστασης Deep Sparse Coding καθώς και μερικές προτάσεις βελτίωσης της μεθόδου για περεταίρω έρευνα στο μέλλον. xiii

14 xiv

15 ΠΕΡΙΕΧΟΜΕΝΑ Κεφάλαιο 1 : Εισαγωγή στη Μηχανική Μάθηση (ή Μηχανική Εκμάθηση) Ο ορισμός της Μηχανικής Μάθησης Η αρχιτεκτονική Bag-of-Visual-words Η αρχιτεκτονική deep Learning Κεφάλαιο 2 : Αραιή Αναπαράσταση (Sparse Representation) Εισαγωγή στο πρόβλημα της αραιής αναπαράστασης Γενική περιγραφή του προβλήματος αραιής αναπαράστασης Μαθηματική περιγραφή του προβλήματος αραιής αναπαράστασης Αλγόριθμος K-SVD Γενική περιγραφή batch αλγορίθμου εκμάθησης λεξικού Αλγόριθμοι ταιριάσματος (pursuit) για την υλοποίηση της αραιής κωδικοποίησης (Sparse Coding) με 0 -νόρμα i Αραιή κωδικοποίηση (Sparse Coding) με 0 -νόρμα ii Αλγόριθμοι Matching Pursuit και Orthogonal Matching Pursuit Αναλυτική περιγραφή αλγορίθμου εκμάθησης λεξικού i Αναλυτική περιγραφή των σταδίων της αραιής κωδικοποίησης και της ενημέρωσης του λεξικού ii Αναλυτική μαθηματική περιγραφή του σταδίου ενημέρωσης του λεξικού iii Ο αλγόριθμος K-SVD ως γενίκευση της διαδικασίας K-Means Διασαφηνίσεις της διαδικασίας εκμάθησης λεξικού Ενέργειες για βέλτιστη απόδοση του αλγορίθμου εκμάθησης λεξικού Χαρακτηριστικές ιδιότητες της μεθόδου εκμάθησης λεξικού K-SVD Πακέτο αλγορίθμων SPAMS Γενική περιγραφή online αλγορίθμου εκμάθησης λεξικού Αλγόριθμοι για την υλοποίηση της αραιής κωδικοποίησης (Sparse Coding) με 1 -νόρμα i Αραιή κωδικοποίηση (Sparse Coding) με 1 -νόρμα ii Αλγόριθμος μεθόδου ομοτοπίας (homotopy) Αναλυτική περιγραφή αλγορίθμου εκμάθησης λεξικού Υποθέσεις της διαδικασίας εκμάθησης λεξικού xv

16 2.3.5 Ενέργειες για βέλτιστη απόδοση του αλγορίθμου εκμάθησης λεξικού H 1 -νόρμα ως κριτήριο αραιότητας Κεφάλαιο 3 : Βαθιά Αραιή Κωδικοποίηση (Deep Sparse Coding) Η τοπολογία Deep Sparse Coding Η αρχιτεκτονική Bag-of-Visual-words Η αρχιτεκτονική deep learning Η αρχιτεκτονική Deep Sparse Coding σαν συνδυασμός Bag-of-Visual-words και deep learning Περιγραφή της τοπολογίας Deep Sparse Coding i Εισαγωγή στην αρχιτεκτονική πολλαπλών επιπέδων Deep Sparse Coding ii Περιγραφή των σταδίων της τοπολογίας Deep Sparse Coding iii Η μονάδα σύνδεσης μεταξύ επιπέδων αραιής αναπαράστασης της τοπολογίας Deep Sparse Coding Η μέθοδος Dimensionality Reduction by Learning an Invariant Mapping Ελάττωση διάστασης Εισαγωγή στη μέθοδο Dimensionality Reduction by Learning an Invariant Mapping Εισαγωγή στη συνάρτηση contrastive loss Περιγραφή της μεθόδου Dimensionality Reduction by Learning an Invariant Mapping Υλοποίηση της μονάδας σύνδεσης της τοπολογίας Deep Sparse Coding Τοπική Χωρική Συγκέντρωση (Local Spatial Pooling) Dimensionality Reduction by Learning an Invariant Mapping i Σχηματισμός ζευγαριών και προσδιορισμός των ετικετών τους ii Υπολογισμός της συνάρτησης μετασχηματισμού iii Πραγματοποίηση της διαδικασίας ελάττωσης διάστασης iv Σύνοψη της διαδικασίας ελάττωσης διάστασης DRLIM Κεφάλαιο 4 : Πειραματικά Αποτελέσματα Εφαρμογή της τοπολογίας Deep Sparse Coding για την ταξινόμηση φυσικών εικόνων Οι βάσεις δεδομένων Caltech-101 και Caltech Τα στάδια της τοπολογίας Deep Sparse Coding xvi

17 4.1.3 Πειραματικά Αποτελέσματα Εφαρμογή της τοπολογίας Deep Sparse Coding για την ταυτοποίηση χειρόγραφων υπογραφών Η βάση δεδομένων CEDAR Τα στάδια της τοπολογίας Deep Sparse Coding Πειραματικά Αποτελέσματα Κεφάλαιο 5 : Σύνοψη και Προτάσεις για μελλοντική έρευνα Σύνοψη της μεθόδου Deep Sparse Coding Προτάσεις για μελλοντική έρευνα Αναφορές - Βιβλιογραφία xvii

18 xviii

19 Ο γενικός συμβολισμός που ακολουθείται κατά την περιγραφή των μαθηματικών εξισώσεων στην παρούσα εργασία είναι ότι τα κεφαλαία γράμματα αντιστοιχούν σε πίνακες (δηλ. ), τα μικρά γράμματα αντιστοιχούν σε διανύσματα (δηλ. ) και οι συμβολισμοί αντιστοιχούν σε αριθμούς. Οποιεσδήποτε εξαιρέσεις του παραπάνω κανόνα δηλώνονται ρητά κατά την χρήση των αντίστοιχων συμβολισμών (συνήθως οι μεταβλητές δηλώνονται με κεφαλαία ή μικρά γράμματα αλλά είναι αριθμοί και κάποιες διανυσματικές αποστάσεις μπορεί να δηλώνονται με κεφαλαία γράμματα αλλά είναι διανύσματα). Επίσης, με να ορίζεται η ευκλείδεια απόσταση ( ²-νόρμα) ενός διανύσματος και το αποτέλεσμα, φυσικά, είναι ένας αριθμός ( ). xix

20 xx

21 Κεφάλαιο 1 : Εισαγωγή στη Μηχανική Μάθηση (ή Μηχανική Εκμάθηση) 1.1 Ο ορισμός της Μηχανικής Μάθησης : Η επιστήμη των υπολογιστών (Computer Science) ασχολείται με το σχεδιασμό, την ανάπτυξη και τη διερεύνηση των θεωρητικών εννοιών και των πρακτικών μεθοδολογιών που διευκολύνουν και βοηθούν στην προδιαγραφή, ανάπτυξη, υλοποίηση και ανάλυση των υπολογιστικών συστημάτων. Η μηχανική μάθηση (ή μηχανική εκμάθηση) είναι ένας τομέας της επιστήμης των υπολογιστών (Computer Science), που εξελίχθηκε από τη μελέτη της αναγνώρισης προτύπων (Pattern Recognition) και την υπολογιστική θεωρία μάθησης (Computational Learning Theory) στην τεχνητή νοημοσύνη (Artificial Intelligent). Έτσι, η μηχανική μάθηση (Machine Learning) διερευνά την κατασκευή και τη μελέτη αλγορίθμων, που μπορούν να εκπαιδευτούν αλλά και να κάνουν προβλέψεις βασιζόμενοι σε δεδομένα ώστε να επιλύουν προβλήματα πρακτικής φύσεως. Σύμφωνα με τα λόγια του ερευνητή Arthur Samuel, ο οποίος επινόησε τον όρο τη δεκαετία του 1950, «η μηχανική μάθηση είναι το πεδίο μελέτης που δίνει στους υπολογιστές την ικανότητα να μαθαίνουν, χωρίς να έχουν ρητά προγραμματιστεί» ("gives computers the ability to learn without being explicitly programmed"). Η αναγνώριση προτύπων (Pattern Recognition) είναι ο κλάδος της μηχανικής μάθησης (Machine Learning) που επικεντρώνεται στην αναγνώριση των μοτίβων και των κανονικοτήτων που διέπουν τα δεδομένα. H θεωρία του υπολογισμού (Theory of Computation) είναι ο κλάδος που ασχολείται με το πόσο αποτελεσματικά μπορούν να επιλυθούν τα προβλήματα σε ένα υπολογιστικό μοντέλο χρησιμοποιώντας έναν αλγόριθμο και η τομή της με τη μηχανική μάθηση είναι η υπολογιστική θεωρία μάθησης (Computational Learning Theory), δηλ. η ανάλυση της υπολογιστικής πολυπλοκότητας των αλγορίθμων μηχανικής μάθησης. Η εξόρυξης δεδομένων (Data Mining) -δηλ. το στάδιο της ανάλυσης της διαδικασίας ανακάλυψης γνώσης σε βάσεις δεδομένων (KDD)- αναφέρεται στην εξεύρεση πληροφορίας ή προτύπων από μεγάλες βάσεις δεδομένων με χρήση αλγορίθμων ταξινόμησης και των αρχών της στατιστικής, της τεχνητής νοημοσύνης, της μηχανικής μάθησης και των συστημάτων βάσεων δεδομένων και ο στόχος της είναι η πληροφορία που θα εξαχθεί και τα πρότυπα που θα προκύψουν να έχουν δομή κατανοητή προς τον 1

22 άνθρωπο έτσι ώστε να τον βοηθήσουν να πάρει τις κατάλληλες αποφάσεις. Τέλος, η τεχνητή νοημοσύνη (Artificial Intelligence) αποτελεί κύριο σκοπό των παραπάνω προ-αναφερόντων πεδίων αφού ορίζεται ως η νοημοσύνη που εμφανίζεται σε μηχανές ή λογισμικό, δηλ. πρόκειται για το πεδίο μελέτης του τρόπου δημιουργίας υπολογιστών και λογισμικού που είναι ικανά να παρουσιάσουν ευφυή συμπεριφορά. Γενικά, οι όροι μηχανική μάθηση, αναγνώριση προτύπων, εξόρυξη δεδομένων, υπολογιστική στατιστική και μαθηματική βελτιστοποίηση είναι δύσκολο να διαχωριστούν, καθώς όλοι πηγάζουν από τον τομέα της επιστήμη των υπολογιστών, της τεχνητής νοημοσύνης, της μηχανικής και της στατιστικής και το πεδίο εφαρμογής τους επικαλύπτεται όλο και περισσότερο με την ενσωμάτωση των εξελίξεων και των καινούργιων ιδεών. Έτσι, η αναγνώριση προτύπων θεωρείται σχεδόν συνώνυμη έννοια με την μηχανική μάθηση, αν και η μεν πρώτη εστιάζει περισσότερο στην εξήγηση και στην απεικόνιση των προτύπων ενώ η δεύτερη στη μεγιστοποίηση των ποσοστών αναγνώρισης. Η εξόρυξη δεδομένων στοχεύει στην εξαγωγή πληροφορίας από τα δεδομένα, δηλ. μοιάζει πολύ με την μηεποπτευόμενη (unsupervised) μηχανική μάθηση. Επίσης, η υπολογιστική στατιστική και η μαθηματική βελτιστοποίηση μοιράζονται διεργασίες με τη μηχανική μάθηση αφού η υπολογιστική στατιστική εστιάζει στην πρόβλεψη μέσω της χρήσης μηχανών και η μαθηματική βελτιστοποίηση παρέχει τις μεθόδους, τη θεωρία και τις εφαρμογές της στον τομέα της μηχανικής μάθησης. Statistics Pattern Recognition Machine Learning Theory of Data Mining Computation Artificial Intelligence Computer Science Εικόνα 1.1 : Μερικοί αλληλοσυμπληρούμενοι τομείς της επιστήμης των υπολογιστών (Computer Science) 2

23 Η μηχανική μάθηση (ή εκμάθηση) είναι μια τεχνική ανάλυσης δεδομένων που οδηγεί τα υπολογιστικά συστήματα να λειτουργούν με βάση τον φυσικό τρόπο απόκτησης γνώσης των ανθρώπων και των ζώων, δηλ. τη μάθηση από την εμπειρία. Οι αλγόριθμοι μηχανικής μάθησης χρησιμοποιούν υπολογιστικές μεθόδους για να «μαθαίνουν» τις πληροφορίες από τα δεδομένα χωρίς να στηρίζονται σε μια προκαθορισμένη εξίσωση ως μοντέλο. Οι αλγόριθμοι προσαρμόζονται στα δεδομένα ώστε να βελτιώνουν την απόδοσή τους καθώς αυξάνεται ο αριθμός των διαθέσιμων δειγμάτων για εκμάθηση. Η αναγνώριση είναι μία βασική λειτουργία των έμβιων όντων, η οποία οδηγεί στον προσδιορισμό της ταυτότητας ενός αντικειμένου (όταν αυτή δεν είναι άμεσα αντιληπτή). Η ταυτότητα έχει να κάνει με μία συγκεκριμένη ιδιότητα του αντικειμένου, που το ξεχωρίζει από άλλα αντικείμενα και το εντάσσει σε μία συγκεκριμένη κατηγορία. Για την αναγνώριση των αντικειμένων είναι αναγκαία η εύρεση συγκεκριμένων χαρακτηριστικών γνωρισμάτων τους, που τα διακρίνουν από τα υπόλοιπα αντικείμενα. Η εξαγωγή χαρακτηριστικών (feature extraction) αποτελεί μία βασική διεργασία της μηχανικής μάθησης, της αναγνώρισης προτύπων και της επεξεργασία σήματος και έγκειται στον υπολογισμό των κύριων χαρακτηριστικών των δεδομένων, που τα αντικατοπτρίζουν καλύτερα, με στόχο την αναγνώρισή τους. Η εξαγωγή χαρακτηριστικών από τα δεδομένα εκκινεί από το αρχικό σύνολο των μετρούμενων προ-επεξεργασμένων δεδομένων εισόδου και σχηματίζει τα χαρακτηριστικά τους έτσι ώστε να είναι κατατοπιστικά και χωρίς περιττή πληροφορία. Οπότε, είναι σημαντικό να επιλεγούν τα γνωρίσματα εκείνα που περιέχουν την απαραίτητη πληροφορία για την αναγνώριση, ενώ παράλληλα το μέγεθός τους πρέπει να είναι διαχειρίσιμο υπολογιστικά. Η μηχανική μάθηση χρησιμοποιεί δύο ειδών τεχνικές : την εποπτευόμενη μάθηση (supervised learning) και τη μη-εποπτευόμενη μάθηση (unsupervised learning). Ένα σύστημα εποπτευόμενης μάθησης (supervised learning) τροφοδοτείται τόσο από δεδομένα εισόδου όσο και από το επιθυμητό αποτέλεσμα εξόδου, δηλ. γνωρίζοντας την σχέση μεταξύ εισόδου και εξόδου, και ο στόχος είναι να δημιουργηθεί η συνάρτηση αντιστοίχισης από την είσοδο στην έξοδο ώστε να λειτουργεί αποδοτικά σε νέα δεδομένα εισόδου. Έτσι, ένα σύστημα εποπτευόμενης μάθησης αποτελείται από δύο στάδια, την εκπαίδευση για την δημιουργία ενός μοντέλου από τα γνωστά δεδομένα εισόδου (δηλ. από δεδομένα εισόδου που είναι γνωστό το αποτέλεσμα εξόδου τους) και την εφαρμογή του μοντέλου στα άγνωστα δεδομένα εισόδου για την πρόβλεψη του αποτελέσματος. Το όνομα εποπτευόμενη μάθηση προκύπτει λόγω του ότι είναι γνωστή εκ των προτέρων η σωστή πρόβλεψη για τα δεδομένα εκμάθησης και άρα κατά την επαναληπτική διαδικασία εκμάθησης το σύστημα εποπτεύεται και διορθώνεται μέχρι να επιτύχει ένα αποδεκτό επίπεδο απόδοσης με βάση τα δεδομένα εκμάθησης, έτσι ώστε στη συνέχεια να μπορεί να χρησιμοποιηθεί αποτελεσματικά σε νέα άγνωστα δεδομένα. Ένα σύστημα μηεποπτευόμενης μάθησης (unsupervised learning) τροφοδοτείται μόνο από 3

24 δεδομένα εισόδου και όχι από το επιθυμητό αποτέλεσμα εξόδου, δηλ. δεν υπάρχει καμία γνώση της μορφής του αποτελέσματος, και ο στόχος είναι να μοντελοποιηθεί η δομή ή η κατανομή των δεδομένων ώστε να αποκαλυφθούν οι σχέσεις μεταξύ των δεδομένων. Το όνομα μη-εποπτευόμενη μάθηση προκύπτει διότι δεν υπάρχουν πλέον δεδομένα εκμάθησης με σωστές προβλέψεις και άρα το σύστημα δεν επιτηρείται αλλά αφήνεται μόνο του να ανακαλύψει κάποια εγγενή δομή ή σχέση μεταξύ των δεδομένων. Το σύστημα, σε αυτή την περίπτωση, δεν παράγει κάποιο μοντέλο για την εφαρμογή σε νέα δεδομένα αλλά η μάθηση πραγματοποιείται σε όλα τα διαθέσιμα δεδομένα. Τέλος, ένας συνδυασμός των δύο μεθόδων ταξινόμησης, είναι η ημι-εποπτευόμενη μάθηση (semi-supervised learning), η οποία χρησιμοποιεί ένα συνδυασμό επισημασμένων (δηλ. δεδομένων που φέρουν ετικέτα και άρα είναι γνωστό το αποτέλεσμα) και μη επισημασμένων δεδομένων. Εδώ, τα δεδομένα εισόδου αποτελούνται από ένα μικρό σύνολο επισημασμένων (γνωστών) δεδομένων σε συνδυασμό με μία μεγάλη ποσότητα μη επισημασμένων (άγνωστων) δεδομένων και έτσι, στο στάδιο της εκμάθησης ορίζονται αρχικά κάποιες υποθετικές προβλέψεις και στη συνέχεια προσδιορίζονται οι σωστές προβλέψεις, σύμφωνα με κάποιο κριτήριο του εκάστοτε αλγορίθμου. Τα προβλήματα που επιλύονται με την χρήση της εποπτευόμενης μάθησης (supervised learning) χωρίζονται σε δύο κατηγορίες : την παλινδρόμηση (regression) και την ταξινόμηση (classification). Στα προβλήματα παλινδρόμησης (regression) επιχειρείται η πρόβλεψη σε συνεχή αποτελέσματα εξόδου, δηλ. οι μεταβλητές εισόδου αντιστοιχίζονται σε κάποια συνεχή τιμή. Στα προβλήματα ταξινόμησης (classification) επιχειρείται η πρόβλεψη σε διακριτά αποτελέσματα εξόδου, δηλ. οι μεταβλητές εισόδου αντιστοιχίζονται σε διακριτές κατηγορίες. Ένα παράδειγμα προβλήματος παλινδρόμησης (regression) είναι η πρόβλεψη της χρηματικής αξίας ενός σπιτιού δεδομένου του μεγέθους του και άρα, η αξία του σπιτιού σαν συνάρτηση του μεγέθους του σπιτιού λαμβάνει συνεχείς τιμές. Το παράδειγμα αυτό μπορεί να μετατραπεί σε πρόβλημα ταξινόμησης (classification) όταν το σύστημα κάνει την πρόβλεψη για το αν το σπίτι θα πωληθεί σε χρηματική αξία χαμηλότερη ή υψηλότερη από την ζητούμενη αξία. Ένα δεύτερο παράδειγμα παλινδρόμησης (regression) είναι η πρόβλεψη της ηλικίας ενός ατόμου με βάση μία φωτογραφία του ενώ το αντίστοιχο παράδειγμα ταξινόμησης (classification) είναι η κατηγοριοποίηση ενός ατόμου σε μία από τις τρεις κατηγορίες παιδί, μεσήλικας και υπερήλικας με βάση μία φωτογραφία του. Επομένως, φαίνεται καθαρά ότι στα προβλήματα παλινδρόμησης (regression) το αποτέλεσμα αποτελεί μία συνάρτηση συνεχών τιμών ενώ στα προβλήματα ταξινόμησης (classification) το αποτέλεσμα λαμβάνει διακριτές τιμές. Τα προβλήματα που επιλύονται με την χρήση της μη-εποπτευόμενης μάθησης (unsupervised learning) χωρίζονται σε δύο κατηγορίες : την ομαδοποίηση ή συσταδοποίηση (clustering) και την οργάνωση (association ή non-clustering). Στα προβλήματα ομαδοποίησης (clustering) τα δεδομένα συγκεντρώνονται σε κλάσεις 4

25 με βάση κάποιο μέτρο έμφυτης ομοιότητας ή την απόσταση. Έτσι, εκτός από τις κλάσεις που καλούνται να εντοπιστούν, πρέπει να καθοριστούν και τα χαρακτηριστικά εκείνα που κάνουν τα αντικείμενα κάθε κλάσης όμοια μεταξύ τους και διαφορετικά με αυτά των υπολοίπων κλάσεων. Επομένως, διαμορφώνονται φυσικές ομαδοποιήσεις των εισερχόμενων δεδομένων. Στα προβλήματα οργάνωσης (association ή non-clustering) επιχειρείται συνήθως η ανακάλυψη συσχετίσεων μεταξύ των δεδομένων. Στην κατηγορία αυτή περιλαμβάνονται όλα εκείνα τα προβλήματα της μη-εποπτευόμενης μάθησης (unsupervised learning) που δεν οδηγούν σε ομαδοποιήσεις των δεδομένων. Άρα, αποτελούν μία ανομοιογενή κατηγορία προβλημάτων με διαφορετικά χαρακτηριστικά το κάθε ένα και με κοινό γνώρισμα την απουσία επιδίωξης ομαδοποιήσεων. Ένα παράδειγμα προβλήματος ομαδοποίησης (clustering) είναι ο διαχωρισμός ενός συνόλου λουλουδιών με βάση τις πολυτροπικές μετρήσεις του φυλλώματος των φυτών ενώ ένα παράδειγμα προβλήματος οργάνωσης (association ή non-clustering) είναι το φαινόμενο του cocktail party για τον προσδιορισμό των μεμονωμένων φωνών των ατόμων από μία μίξη ήχων που προέρχονται από την ομιλία των άλλων συνδαιτυμόνων και τη μουσική. MACHINE LEARNING SUPERVISED LEARNING UNSUPERVISED LEARNING CLASSIFICATION REGRESSION CLUSTERING NON-CLUSTERING SVM Decision Tree K-Means PCA k-nn Neural Nets Gaussian mix Sparse Coding Εικόνα 1.2 : Τεχνικές Μηχανικής Μάθησης 5

26 1.2 Η αρχιτεκτονική Bag-of-Visual-words : Η πιο κλασσική -ίσως- προσέγγιση για την αναγνώριση αντικειμένων (object recognition) στο πεδίο της Μηχανικής Μάθησης (ή Εκμάθησης) αποτελεί η αρχιτεκτονική που ονομάζεται Bag-of-Visual-words (BoV). Η αρχιτεκτονική Bag-ofVisual-words αποτελείται από μια σειρά σταδίων με σκοπό την εξαγωγή χαρακτηριστικών των δεδομένων για την επιτυχή αναγνώρισή τους. Η BoV περιλαμβάνει μία αλληλουχία διεργασιών, όπου το αποτέλεσμα της προηγούμενης διεργασίας είναι είσοδος στην επόμενη και κάθε διεργασία είναι ανεξάρτητη. Έτσι, στα δεδομένα εισόδου υπολογίζονται τοπικοί περιγραφείς, οι οποίοι χρησιμοποιούνται για την εκμάθηση μίας αναπαράστασης των δεδομένων (συνήθως την εκμάθηση ενός λεξικού και μέσω αυτού την κωδικοποίηση των δεδομένων) και στην συνέχεια υλοποιείται μία χωρική πυραμιδική συγκέντρωση στις κωδικοποιήσεις των δεδομένων για την εξαγωγή του τελικού χαρακτηριστικού διανύσματος, το οποίο θα εισαχθεί σε έναν ταξινομητή. Στην περίπτωση αναγνώρισης εικόνων, στο πρώτο στάδιο της BoV αρχικά εξάγονται κομμάτια (patches) της εικόνας -τα οποία μπορεί να είναι επικαλυπτόμενα (overlapped) ή όχιμε καθορισμένες διαστάσεις και σταθερή απόσταση μεταξύ των κέντρων δύο γειτονικών patches και στη συνέχεια, για κάθε patch της εικόνας υπολογίζεται ένας D-διαστάσεων περιγραφέας (hand-crafted descriptor). Με βάση τους περιγραφείς των εικόνων (οι οποίοι ουσιαστικά είναι διανύσματα χαρακτηριστικών) πραγματοποιείται η εκμάθηση ενός λεξικού αναπαράστασης (learning codebook), το οποίο χρησιμοποιείται για την κωδικοποίηση (coding) των δεδομένων. Έπειτα, δεδομένου των αναπαραστάσεων (δηλ. των κωδικοποιημένων δεδομένων), εφαρμόζεται μία τεχνική χωρικής πυραμιδικής συγκέντρωσης (spatial pyramid pooling) στις αναπαραστάσεις της κάθε εικόνας για να προκύψει ένα χαρακτηριστικό διάνυσμα, που θα αντιστοιχεί στην εικόνα και θα μπορεί να χρησιμοποιηθεί για διάφορα προβλήματα αναγνώρισης. Εικόνα 1.3 : Η πιο απλή προσέγγιση για την αναγνώριση αντικειμένων, όπου η αρχιτεκτονική Bag-of-Visualwords αποτελείται μόνο από το στάδιο υπολογισμού των τοπικών περιγραφέων. (Εικόνα διαθέσιμη από: Introduction tutorial on deep learning for vision at Conference on Computer Vision and Pattern Recognition (CVPR) 2014) 6

27 Το πρώτο στάδιο της αρχιτεκτονικής Bag-of-Visual-words (BoV) είναι ο σχηματισμός των χαμηλής τάξης (low-level) χαρακτηριστικών μέσω του υπολογισμού των τοπικών περιγραφέων (local descriptors). Οι τοπικοί περιγραφείς είναι hand-crafted χαρακτηριστικά, δηλ. υπολογίζονται μέσω μίας συγκεκριμένης μεθοδολογίας και δεν προκύπτουν από μία διαδικασία εκμάθησης από τα δεδομένα. Ένας αποδοτικός περιγραφέας πρέπει να έχει την δυνατότητα να διαχειρίζεται την ένταση, την περιστροφή, την κλιμάκωση και τις γειτονικές διακυμάνσεις του κάθε patch της εικόνας. Έτσι, οι πιο δημοφιλείς μέθοδοι υπολογισμού τοπικών περιγραφέων, με αποδειγμένη ικανότητα διακριτότητας, είναι οι Scale-Invariant Feature Transform (SIFT) [Lowe 2004] και Histograms of oriented Gradients (HoG) [Dalal 2005]. Ο υπολογισμός των τοπικών περιγραφέων έχει σαν αποτέλεσμα συνήθως μία καλύτερη και με περισσότερη πληροφορία αναπαράσταση των μοτίβων που υπάρχουν σε κάθε patch σε σχέση απλά με τις τιμές των raw pixels. Το δεύτερο στάδιο της αρχιτεκτονικής Bag-of-Visual-words (BoV) είναι η παραγωγή των μεσαίας τάξης (mid-level) χαρακτηριστικών μέσω της εκμάθησης αναπαραστάσεων από τα δεδομένα. Το στάδιο αυτό αποτελείται από την εκμάθηση ενός λεξικού (learning codebook) και την κωδικοποίηση (coding) των δεδομένων με τη βοήθεια του λεξικού. Η ονομασία Bag-of-Visual-words (BoV) οφείλεται σε αυτό το στάδιο της αρχιτεκτονικής και προκύπτει από το πρόβλημα ανάκτησης κειμένων (text retrieval), όπου το λεξικό (codebook) αποτελείται από λήμματα λέξεων και κάθε κείμενο ορίζεται σαν μία αναπαράσταση με βάση τη συχνότητα των λέξεων που εμπεριέχει. Έτσι, αντίστοιχα στον χώρο των εικόνων, η πρώτη εφαρμογή της αρχιτεκτονικής ήταν ο σχηματισμός ενός λεξικού με προκαθορισμένα στοιχεία και η ανάθεση του κάθε τοπικού περιγραφέα σε ένα στοιχείο του λεξικού με κριτήριο την μικρότερη διανυσματική τους απόσταση. Στη συνέχεια, η αρχιτεκτονική αναπτύχθηκε με την εκμάθηση των στοιχείων του λεξικού από τα δεδομένα και με την χρήση εναλλακτικών κωδικοποιήσεων που διατηρούν περισσότερη πληροφορία για τα δεδομένα. Γενικά, η διαδικασία κωδικοποίησης των τοπικών περιγραφέων σε μία αρχιτεκτονική Bag-of-Visual-words, υλοποιείται είτε μέσω μεθόδων αυστηρής κβάντισης που δημιουργούν το χωρικό ιστόγραμμα χρήσης των στοιχείων του λεξικού (π.χ. k-means), είτε μέσω της αναπαράστασης του σήματος εισόδου ως γραμμικού συνδυασμού ενός αριθμού στοιχείων του λεξικού (π.χ. Sparse Coding, LLC [Wang 2010]) είτε μέσω μεθόδων aggregate που καταγράφουν τις διαφορές των χαρακτηριστικών με τα στοιχεία του λεξικού, δηλ. που κάνουν χρήση των υπολοίπων των διανυσμάτων (π.χ. VLAD [Jégou 2010], VHAR [Kastaniotis 2017], Fisher Vectors ([Perronnin 2007], [Mironica 2013]), super-vectors [Zhou 2010]). Το τρίτο στάδιο της αρχιτεκτονικής Bag-of-Visual-words (BoV) είναι η χωρική πυραμιδική συγκέντρωση (spatial pyramid pooling) των αναπαραστάσεων της κάθε εικόνας για την παραγωγή ενός χαρακτηριστικού διανύσματος, που θα αντιστοιχεί στην κάθε εικόνα. Στο στάδιο αυτό δεν παράγονται υψηλότερης τάξης 7

28 χαρακτηριστικά αλλά τα μεσαίας τάξης (mid-level) χαρακτηριστικά του προηγούμενου σταδίου ενσωματώνονται μαζί σε ομάδες ώστε να προκύψει μία διανυσματικής αναπαράστασης για κάθε εικόνα, η οποία χαρακτηρίζει την κάθε εικόνα και μπορεί να χρησιμοποιηθεί για διάφορα προβλήματα αναγνώρισης. Η υλοποίηση της χωρικής πυραμιδικής συγκέντρωσης πραγματοποιείται συλλέγοντας αναπαραστάσεις από περιοχές της εικόνας και σε κάθε σύνολο αναπαραστάσεων εκτελείται μία διεργασία συγκέντρωσης (pooling operation) των διανυσμάτων των χαρακτηριστικών έτσι ώστε να ενσωματωθεί η πληροφορία από μία περιοχή σε ένα μόνο διάνυσμα χαρακτηριστικών. Το τελικό διάνυσμα χαρακτηριστικών της κάθε εικόνας δημιουργείται από την ένωση όλων των διανυσμάτων που προκύπτουν από την διεργασία συγκέντρωσης σε κάθε περιοχή της εικόνας. Συνήθως η διεργασία συγκέντρωσης είναι είτε ο υπολογισμός της μέσης τιμής των διανυσμάτων που αντιστοιχούν σε μία περιοχή της εικόνας (average pooling operation) είτε η εύρεση της μέγιστης τιμής των διανυσμάτων που έχουν προκύψει από μία περιοχή της εικόνας (max pooling operation) αλλά μπορεί να χρησιμοποιηθεί και οποιαδήποτε άλλη συνάρτηση. Με τη διαδικασία της χωρικής πυραμιδικής συγκέντρωσης εισάγεται η χωρική πληροφορία στο τελικό διάνυσμα χαρακτηριστικών, η οποία δεν υπάρχει εγγενώς στα διανύσματα κωδικοποίησης, και είναι σημαντική διότι αποκαλύπτει τοπικά χαρακτηριστικά σε μία περιοχή της εικόνας. image image image Filtering Filtering Filtering SIFT at keypoints dense Gradients dense SIFT Coding Coding Coding Vector Quantization Vector Quantization Sparse Coding Pooling Pooling Pooling whole Image (mean) Coarse grid (mean) Spatial Pyramid (max) Εικόνα 1.4 : Τα τρία στάδια (Filtering, Coding, Pooling) της αρχιτεκτονικής Bag-of-Visual-words (BoV) κατά την εξέλιξη της αρχιτεκτονικής με την αντικατάσταση της διανυσματικής κβάντισης (Vector Quantization) από την αραιή αναπαράσταση (Sparse Representation) 8

29 Η παρούσα εργασία χρησιμοποιεί την αρχιτεκτονικής Bag-of-Visual-words με το δεύτερο στάδιο να συνίσταται από την αραιή αναπαράσταση (Sparse Representation). Η έννοια της αραιότητας (sparsity ή parsimony) έγκειται στην αναπαράσταση ενός φαινομένου με όσο το δυνατόν λιγότερες μεταβλητές. Η έννοια αυτή, θεωρείται ότι προέρχεται από το έργο του Άγγλου φιλοσόφου και φραγκισκανού μοναχού του 14ου αιώνα William of Ockham ( ) και συγκεκριμένα από την «αρχή της αραιότητας» ( law of parsimony ), αν και η αρχή αυτή πρώτο-διατυπώθηκε από τους Πυθαγόρειους περίπου δύο χιλιάδες χρόνια νωρίτερα από τον Ockham, τελικά έγινε γνωστή, μερικούς αιώνες μετά το θάνατο του Ockham μελετώντας τα έργα του, ως το ξυράφι του Ockham (Ockham's razor). Ο όρος ξυράφι αναφέρεται στη διάκριση μεταξύ δύο υποθέσεων, είτε με το "ξύρισμα" περιττών υποθέσεων είτε με την περικοπή δύο παρόμοιων συμπερασμάτων. Η αρχή της αραιότητας ή ξυράφι του Ockham δεν αποτυπώνεται σε ένα μόνο απόφθεγμα του Ockham αλλά υπάρχουν πολλές αναφορές στο έργο του, όπως Pluralitas non est ponenda sine necessitate (Plurality must never be posited without necessity) και Frustra fit per plura quod potest fieri per pauciora (It is futile to do with more things that which can be done with fewer). Σε ελεύθερη απόδοση, η αρχή μπορεί να συμπυκνωθεί στην φράση «Όταν δύο θεωρίες παρέχουν εξίσου ακριβείς προβλέψεις, πάντα να επιλέγεται η απλούστερη». Βέβαια, παραλλαγές της αρχής της αραιότητας συναντώνται και σε έργα άλλων στοχαστών. Η χρήση ενός υπερπλήρους συνόλου και η ενεργοποίηση λίγων μόνο στοιχείων του συνόλου για την περιγραφή ενός φαινομένου αποτελεί κυρίαρχη ιδέα σε πολλούς τομείς έρευνας και εφαρμογής. Στον τομέα της Μηχανική Μάθησης (ή Εκμάθησης), η αραιή αναπαράσταση (Sparse Representation) αποτελεί μία μέθοδο μη-εποπτευόμενης μάθησης (unsupervised learning) με αξιοσημείωτα αποτελέσματα τόσο σε απλά προβλήματα, όπως απομάκρυνσης θορύβου, σύνθεση υφής, επεξεργασίας ήχου κ.ά. όσο και σε πιο σύνθετα, όπως προβλήματα ταξινόμησης και ομαδοποίησης. Στην επεξεργασία σήματος, η αραιή αναπαράσταση είναι η εξεύρεση της καλύτερης αναπαράστασης -με βάση το σφάλμα ανακατασκευής- ενός δεδομένου σήματος εισόδου ως γραμμικού συνδυασμού ενός περιορισμένου αριθμού σημάτων ενός λεξικού, που ονομάζονται άτομα. Τελικά, η εκμάθηση ενός λεξικού από τα δεδομένα (Dictionary Learning) και η αραιή κωδικοποίηση (Sparse Coding) μέσω αυτού του λεξικού των σημάτων αποτελεί μία πολύ αποδοτική μέθοδο για την αναγνώριση. Η αραιή αναπαράσταση έχει μία ενδιαφέρουσα σχέση με την διανυσματική κβάντιση (Vector Quantization) ή ομαδοποίηση (clustering) [Delgado 2003]. Κατά τη διανυσματική κβάντιση (μέσω του αλγορίθμου k-means) σχηματίζεται ένα σύνολο αντιπροσωπευτικών διανυσμάτων που αντιστοιχούν στα κέντρα των κλάσεων των δεδομένων (cluster centers) μέσω μίας διαδικασίας μη-εποπτευόμενης (unsupervised) μάθησης και κάθε διάνυσμα των δεδομένων αναθέτεται σε ένα από τα κέντρα των κλάσεων που είναι πιο κοντινό, δηλ. συνήθως σε αυτό που εμφανίζει 9

30 τη μικρότερη διανυσματική απόσταση. Μία διαφορετική εκδοχή της διαδικασίας της διανυσματικής κβάντισης (VQ) ονομάζεται gain-shape Vector Quantization (G/S VQ) και επιτρέπει την ανάθεση κάθε διανύσματος των δεδομένων σε ένα κέντρο αλλά με έναν συντελεστή βαρύτητας που μπορεί να είναι διαφορετικός από τη μονάδα [Gersho 1991]. Ο συνδυασμός των δύο αυτών διεργασιών οδηγεί στην αραιή αναπαράσταση (SR), κατά την οποία κάθε διάνυσμα των δεδομένων μπορεί να αναπαρασταθεί από το γραμμικό συνδυασμό των κέντρων των κλάσεων (codewords), τα οποία πλέον ονομάζονται άτομα του λεξικού. Οι συντελεστές στο σταθμισμένο άθροισμα των ατόμων για τη αναπαράσταση του κάθε σήματος μπορούν να λάβουν οποιαδήποτε τιμή. Έτσι, η gain-shape διανυσματική κβάντιση (G/S VQ) αποτελεί μία ακραία περίπτωση αραιής αναπαράστασης, όπου μόνο ένα άτομο επιτρέπεται να χρησιμοποιηθεί ενώ αν ο συντελεστής του ενός ατόμου -που θα επιλεγεί- επιβληθεί να λαμβάνει μόνο την τιμή της μονάδας τότε προκύπτει η διανυσματική κβάντιση (VQ). Επομένως, η αραιή αναπαράσταση μπορεί να θεωρηθεί σαν μία γενίκευση της διανυσματικής κβάντισης (ή ομαδοποίησης). Η αρχιτεκτονική Bag-of-Visual-words, εξαιτίας της πολύ καλής απόδοσης που επιτυγχάνει, αποτελεί μία από τις κυρίαρχες τεχνικές για την επίλυση προβλημάτων αναγνώρισης αντικειμένων (object recognition) στην υπολογιστική όραση [Law 2014]. Τα βασικά πλεονεκτήματα της μεθόδου Bag-of-Visual-words είναι ότι επωφελείται από την αποδοτικότητα των τοπικών περιγραφέων (handcrafted features) και από την ευέλικτη δομή της αρχιτεκτονικής της. Έτσι, εκμεταλλεύεται την αποτελεσματικότητα και τα χαρακτηριστικά των τοπικών περιγραφέων (ανεξαρτησία (αμεταβλητότητα) κλίμακας, περιστροφής, φωτισμού, κ.ά. και ανθεκτικότητα σε θόρυβο, μετασχηματισμούς, κ.ά.) και μέσω της ευελιξίας της μπορεί να ενσωματώνει διάφορες μεθόδους εκμάθησης για την παραγωγή των μεσαίας τάξης (mid-level) χαρακτηριστικών πολύ εύκολα. Το κύριο μειονέκτημα της μεθόδου Bag-of-Visual-words είναι ότι τα patches κωδικοποιούνται ανεξάρτητα μεταξύ τους, δηλ. αγνοώντας τη χωρική δομή των γειτονιών της εικόνας. Εικόνα 1.5 : Ο σχηματισμός των χαμηλής τάξης (low-level) χαρακτηριστικών μέσω του υπολογισμού των τοπικών περιγραφέων (local descriptors) και η παραγωγή των μεσαίας τάξης (mid-level) χαρακτηριστικών μέσω της εκμάθησης ενός λεξικού (learning codebook) για την κωδικοποίηση (coding) των δεδομένων. (Εικόνα από : R. Fergus ( [Krizhevsky 2012], [Kavukcuoglu 2010], [Zeiler 2010], [Lee 2009], [Jarrett 2009], tutorial at CVPR 2014 ( 10

31 1.3 Η αρχιτεκτονική deep Learning : Η αρχιτεκτονική deep Learning (βαθιά μάθηση) ανήκει στον τομέα της Μηχανικής Μάθησης (ή Εκμάθησης) και είναι ευρέως διαδεδομένη στις μέρες μας καθώς έχει βελτιώσει δραματικά την απόδοση των συστημάτων σε πληθώρα προβλημάτων, όπως η αναγνώριση ομιλίας, η οπτική αναγνώριση αντικειμένων, η ανίχνευση αντικειμένων, κ.ά. Οι deep Learning (βαθιάς μάθησης) τεχνικές, που γενικά ονομάζονται βαθιά τεχνητά νευρωνικά δίκτυα (large deep artificial neural networks), έχουν ως στόχο την εξαγωγή ιεραρχικών χαρακτηριστικών από τα δεδομένα και συνήθως αποτελούνται από διαδοχικές μονάδες εξαγωγής χαρακτηριστικών, όπου το αποτέλεσμα της προηγούμενης διεργασίας είναι είσοδος στην επόμενη [Bengio 2012]. Οι πρώτες υλοποιήσεις σε αυτό το πεδίο έρευνας θεωρούνται τα Convolutional Neural Networks [LeCun 1998] και τα Deep Belief Networks [Hinton 2006]. Η ιεραρχική δομή των νευρικών συστημάτων των έμβιων οργανισμών αποτέλεσε την έμπνευση για την ανάπτυξη των αρχιτεκτονικών βαθιάς (deep) μάθησης για την εκμάθησης χαρακτηριστικών μέσω πολλαπλών επιπέδων (multi-layer) μονάδων εκμάθησης. Έτσι, ο όρος deep (βαθιά) μάθηση προκύπτει από το γεγονός ότι το σύστημα για την αναγνώριση αντικειμένων αποτελείται από πολλαπλά επίπεδα και όλα αυτά τα επίπεδα μπορούν να εκπαιδευτούν. Γενικά, ο όρος deep (βαθιά) μάθηση χρησιμοποιείται για την περιγραφή μεγάλων βαθιών νευρωνικών δικτύων (large deep neural networks). Οι τεχνικές βαθιάς (deep) μάθησης δεν αποτελούν μία καινούργια ιδέα αλλά υπάρχουν από τις δεκαετίες του 1980 και του 1990 ([Rumelhart 1986], [LeCun 1989]), απλά σήμερα οι υπολογιστές είναι τόσο γρήγοροι και τα δεδομένα αρκετά ώστε να μπορούν πραγματικά να εκπαιδευτούν μεγάλα νευρωνικά δίκτυα [Ng at Extract Data Conference 2015 in a talk titled What data scientists should know about deep learning ]. Εικόνα 1.6 : Τα αίτια που οι τεχνικές deep (βαθιάς) μάθησης δεν οδήγησαν σε αποδοτικά αποτελέσματα τις προηγούμενες δεκαετίες [LeCun, Bengio, Hinton 2015]. (Ο όρος backpropagation αναφέρεται στην εκπαίδευση ενός νευρωνικού δικτύου και στην παραπάνω εικόνα χρησιμοποιείται ταυτόσημα με τον όρο deep Learning) (Εικόνα από : Hinton G. at the Royal Society on 2016 in a talk titled Deep Learning ) 11

32 Στη βαθιά (deep) αρχιτεκτονική τοποθετούνται πολλά επίπεδα (layers) από μονάδες εκμάθησης χαρακτηριστικών, το ένα μετά το άλλο, έτσι ώστε κάθε επίπεδο να χρησιμοποιεί την αναπαράσταση που παράχθηκε από το προηγούμενο επίπεδο και να παράγει μία νέα αναπαράσταση που θα τροφοδοτήσει το επόμενο επίπεδο. Με αυτό τον τρόπο, η βαθιά (deep) αρχιτεκτονική μαθαίνει τα χαρακτηριστικά απευθείας από τα δεδομένα (automatically learning features) και ευελπιστεί να ανακαλύψει ιεραρχικές αναπαραστάσεις των δεδομένων, δηλ. καθίσταται δυνατή η παραγωγή χαρακτηριστικών από κάθε επίπεδο χρησιμοποιώντας τα χαρακτηριστικά του προηγούμενου επιπέδου. Επομένως, κάθε επίπεδο της βαθιάς (deep) αρχιτεκτονικής κωδικοποιεί χαρακτηριστικά σε διαφορετική βαθμίδα της όλης διαδικασίας εκμάθησης και έτσι τα χαρακτηριστικά υψηλής τάξης (high-level) από τα βαθύτερα (υψηλότερα) επίπεδα (layers) αποτελούν σύνθεση των χαρακτηριστικών μεσαίας (mid-level) και χαμηλής (low-level) τάξης από τα χαμηλότερα (αρχικά) επίπεδα του δικτύου. Συνεπώς, σε ένα σύστημα βαθιάς (deep) μάθησης τα δεδομένα μεταχειρίζονται σε πολλαπλά επίπεδα, δηλ. αναλύονται από πολλαπλές σκοπιές και όχι μόνο από μία πλευρά όπως σε ένα απλό σύστημα ενός επιπέδου, και επιτυγχάνεται η εξαγωγή υψηλής τάξης (high-level) χαρακτηριστικών. Τελικά, η ιεραρχική προσέγγιση μέσω των πολλαπλών επιπέδων στα συστήματα βαθιάς (deep) μάθησης έχει σαν αποτέλεσμα τα συστήματα να μαθαίνουν πολύπλοκες έννοιες μέσα από την σύνθεση απλούστερων και με αυτό τον τρόπο να επιτυγχάνουν αποδοτικότερες αναπαραστάσεις των δεδομένων ανακαλύπτοντας τα ενδόμυχα χαρακτηριστικά τους. Εικόνα 1.7 : Η εκμάθηση ιεραρχικών αναπαραστάσεων μέσω των πολλαπλών επιπέδων (layers) στα συστήματα βαθιάς (deep) μάθησης για την εξαγωγή υψηλής τάξης (high-level) χαρακτηριστικών. (Εικόνα από : LeCun Y. at the Lawrence Livermore Nat. Laboratory on 2015 in a talk titled "Deep Learning") 12

33 Εικόνα 1.8 : Η τυπική διαδικασία ιεραρχικής μάθησης σε ένα βαθύ νευρωνικό δίκτυο (deep neural network) Για την επίλυση του προβλήματος της ταξινόμησης εικόνων, τα βαθύτερα (υψηλότερα) επίπεδα (layers) του νευρωνικού δικτύου ενισχύουν τις πτυχές των δεδομένων εισόδου που είναι σημαντικές για την διάκριση μεταξύ των εικόνων και καταστέλλουν τις υπόλοιπες άσχετες μεταβολές. Στο πρώτο επίπεδο εκμάθησης χαρακτηριστικών (1 st layer of representation) εισάγεται μία εικόνα (δηλ. οι τιμές των raw pixels της) και σχηματίζονται μέσω μίας διαδικασίας εκμάθησης χαρακτηριστικά χαμηλής τάξης (low-level features). Επομένως, οι αναπαραστάσεις από το πρώτο επίπεδο αντιστοιχούν γενικά στην παρουσία ή απουσία ακμών σε συγκεκριμένους προσανατολισμούς και θέσεις στην εικόνα. Στο δεύτερο επίπεδο εκμάθησης χαρακτηριστικών (2 nd layer of representation) γενικά ανιχνεύονται μοτίβα εντοπίζοντας συνδυασμούς ακμών, ανεξάρτητα από μικρές μεταβολές στις θέσεις των ακμών στην εικόνα. Επομένως, οι αναπαραστάσεις που προκύπτουν από την εκμάθηση στο δεύτερο επίπεδο αντιστοιχούν σε χαρακτηριστικά μεσαίας τάξης (mid-level features). Στο τρίτο επίπεδο εκμάθησης χαρακτηριστικών (3 rd layer of representation) συγκεντρώνονται συνδυασμοί ακμών από το προηγούμενο επίπεδο, οι οποίοι πλέον αντιστοιχούν σε τμήματα οικείων αντικειμένων. Έτσι, δημιουργούνται πιο σύνθετα χαρακτηριστικά από την ένωση απλούστερων. Στα επόμενα επίπεδα εκμάθησης χαρακτηριστικών ανιχνεύονται αντικείμενα στις εικόνες σαν συνδυασμό των τμημάτων των αντικειμένων που έχουν παραχθεί στο προηγούμενο επίπεδο. Επομένως, εξάγονται χαρακτηριστικά υψηλής τάξης (high-level features) από τα δεδομένα. Τελικά, η ιεραρχική προσέγγιση μέσω των πολλαπλών επιπέδων στα συστήματα βαθιάς (deep) μάθησης έχει σαν αποτέλεσμα τα συστήματα να μαθαίνουν πολύπλοκες έννοιες μέσα από την σύνθεση απλούστερων και με αυτό τον τρόπο να επιτυγχάνουν αποδοτικότερες αναπαραστάσεις των δεδομένων, που οδηγούν σε βέλτιστη αναγνώριση των εικόνων. Το βασικό στοιχείο της βαθιάς (deep) μάθησης είναι ότι τα επίπεδα χαρακτηριστικών δεν σχεδιάζονται από το μηχανικό (hand-crafted by human engineers) αλλά μαθαίνονται από τα δεδομένα, δηλ. σχηματίζονται μέσω μίας διαδικασίας εκμάθησης. Έτσι, η διαδικασίας προσδιορισμού των βαρών σε κάθε επίπεδο (layer) του νευρωνικού δικτύου αντιστοιχεί στο φιλτράρισμα που εκτελείται στο επίπεδο αυτό (δηλ. στα χαρακτηριστικά που θα εξαχθούν) και πραγματοποιείται μέσα από την εκμάθηση από τα δεδομένα. Με αυτό τον τρόπο, τα χαρακτηριστικά που εξάγονται από κάθε επίπεδο του δικτύου προκύπτουν απευθείας από τα δεδομένα, δηλ. είναι αποτέλεσμα απευθείας εκμάθησης (automatically learning features). (Εικόνα διαθέσιμη από: Introduction tutorial on deep learning for vision at Conference on Computer Vision and Pattern Recognition (CVPR) 2014, [Krizhevsky 2012], [Kavukcuoglu 2010], [Zeiler 2010], [Lee 2009], [Jarrett 2009]) 13

34 Η ραγδαία χρήση συστημάτων βαθιάς μάθησης στις μέρες μας οφείλεται κατά πολύ στην εξαιρετική απόδοση που επιτυγχάνουν όταν εκπαιδεύονται με εποπτευόμενη μάθηση (supervised learning) [Ng at Extract Data Conference 2015 in a talk titled What data scientists should know about deep learning ]. Έτσι, στις πιο συνηθισμένες υλοποιήσεις της βαθιάς μάθησης (π.χ. Convolutional Neural Networks, Deep Neural Networks) η εκπαίδευση του δικτύου πραγματοποιείται μέσω ενός μεγάλου συνόλου επισημασμένων δεδομένων (supervised learning), όπου εισάγονται εικόνες (raw pixels) και το αποτέλεσμα ταξινόμησης του δικτύου είναι γνωστό έτσι ώστε τα βάρη του δικτύου να προσδιοριστούν απευθείας από τα δεδομένα με στόχο να ενισχύσουν τις πτυχές των δεδομένων που είναι σημαντικές για την διάκριση μεταξύ τους και να καταστείλουν τα υπόλοιπες. Με αυτό τον τρόπο οι τιμές των βαρών επιλέγονται μέσω μίας διαδικασίας εκμάθησης ενώ το εκπαιδευμένο δίκτυο που προκύπτει μπορεί να χρησιμοποιηθεί για την εξαγωγή χαρακτηριστικών ή για την ταξινόμηση εικόνων. Γενικά, η εποπτευόμενη (supervised) εκπαίδευση ενός δικτύου βαθιάς μάθησης για την ταξινόμηση εικόνων πραγματοποιείται είτε μέσω ενός μεγάλου πλήθους επισημασμένων δεδομένων (end-to-end supervised training from scratch) είτε χρησιμοποιώντας ένα προ-εκπαιδευμένο δίκτυο (pretrained) και μέσω ενός μικρού συνόλου επισημασμένων δεδομένων οι παράμετροι του δικτύου προσαρμόζονται στα νέα δεδομένα (transfer learning that involves fine-tuning a pretrained model). Τέλος, όταν ένα δίκτυο επιθυμείται να χρησιμοποιηθεί για την εξαγωγή χαρακτηριστικών από μία εικόνα, τότε η άγνωστη εικόνα εισάγεται στο ήδη εκπαιδευμένο δίκτυο και επιλέγονται τα χαρακτηριστικά που προκύπτουν από οποιοδήποτε επίπεδο του δικτύου. Εικόνα 1.9 : Μία οπτική κατηγοριοποίηση (αξιολόγηση) διάφορων μεθόδων της μηχανικής μάθησης με βάση το αν ακολουθούν τεχνική εποπτευόμενης (supervised) ή μη-εποπτευόμενης (unsupervised) μάθησης και με το αν η αρχιτεκτονική τους είναι βαθιά (deep) ή όχι (shallow). (Εικόνα διαθέσιμη από: Introduction tutorial on deep learning for vision at Conference on Computer Vision and Pattern Recognition (CVPR) 2014) 14

35 Η βαθιά μάθηση (deep Learning), αν και ανήκει γενικά στον τομέα της μηχανικής μάθησης, εμφανίζει δύο σημαντικές διαφορές με τις κλασικές μεθόδους της μηχανικής μάθησης (machine Learning), οι οποίες κατά κάποιο τρόπο έχουν καθορίσει το χώρο του τομέα της μηχανικής μάθησης. Η πρώτη βασική διαφορά με τις κλασικές μεθόδους της μηχανικής μάθησης είναι ότι συχνά η απόδοση της βαθιάς (deep) μάθησης βελτιώνεται καθώς αυξάνεται το μέγεθος των δεδομένων εκμάθησης. Έτσι, η χρήση μεγαλύτερων (βαθύτερων) δικτύων και η εκπαίδευσή τους σε περισσότερα δεδομένα έχει σαν αποτέλεσμα η απόδοσή τους να συνεχίζει να αυξάνεται. Αυτό είναι τελείως αντίθετο με όλες τις άλλες μεθόδους της μηχανικής μάθησης, οι οποίες εμφανίζουν κορεσμό στην απόδοση ύστερα από ένα πεπερασμένο πλήθος δεδομένων εκμάθησης, δηλ. η απόδοσή τους επιτυγχάνει μία μέγιστη τιμή και στη συνέχεια διατηρείται σταθερή όσο και αν αυξάνονται τα παραδείγματα εκμάθησης. Επομένως, οι μέθοδοι βαθιάς μάθησης (deep Learning) φέρουν την ιδιότητα της κλιμάκωσης (scaling) σε σχέση με το μέγεθος του συνόλου εκμάθησης ενώ αντίθετα όλες οι υπόλοιπες μέθοδοι της μηχανικής μάθησης -που συνηθίζεται πλέον να ονομάζονται ρηχή μάθηση (shallow Learning)- συγκλίνουν ύστερα από ένα πεπερασμένο πλήθος δεδομένων εκμάθησης (reach a plateau in performance). Τελικά, η απόδοση ενός δικτύου βαθιάς μάθησης συνεχίζει να βελτιώνεται καθώς τροφοδοτείται με περισσότερα δεδομένα. Εικόνα 1.10 : Η απόδοση των μεθόδων βαθιάς μάθησης (deep Learning) συνεχίζει να βελτιώνεται καθώς τροφοδοτούνται με νέα δεδομένα εκμάθησης, κάτι που δεν συμβαίνει σε καμία άλλη μέθοδο της μηχανικής μάθησης (machine Learning). (Εικόνα από : Ng A. at Extract Data Conference 2015 in a talk titled What data scientists should know about deep learning, διαθέσιμη από : ) 15

36 Στις κλασικές μεθόδους εξαγωγής χαρακτηριστικών της μηχανικής μάθησης (π.χ. SIFT, HOG) τα χαρακτηριστικά είναι hand-crafted, δηλ. υπολογίζονται μέσω μίας συγκεκριμένης μεθοδολογίας και δεν προκύπτουν από μία διαδικασία εκμάθησης από τα δεδομένα. Αντίθετα, σε ένα σύστημα βαθιάς μάθησης (deep Learning) τα χαρακτηριστικά από όλα τα επίπεδα (layers) προκύπτουν απευθείας από τα δεδομένα, δηλ. είναι αποτέλεσμα απευθείας εκμάθησης (automatically learning features). Άρα, στις κλασικές μεθόδους της μηχανικής μάθησης επιλέγονται χειροκίνητα τα χαρακτηριστικά και ένας ταξινομητής καλείται για να αναγνωρίσει τις εικόνες ενώ στη βαθιά μάθηση η εξαγωγή χαρακτηριστικών και η μοντελοποίηση των επιπέδων (layers) πραγματοποιείται αυτόματα μέσω της εκμάθησης από τα δεδομένα. Βέβαια, η πιο συνηθισμένη προσέγγιση για την αναγνώριση αντικειμένων στο πεδίο της μηχανικής μάθησης είναι η αρχιτεκτονική Bag-of-Visual-words. Η αρχιτεκτονική Bag-of-Visual-words διαθέτει στάδιο εκμάθησης χαρακτηριστικών (εκμάθηση λεξικού και κωδικοποίηση μέσω αυτού) αλλά επίσης φέρει και στάδιο υπολογισμού τοπικών περιγραφέων, δηλ. σχηματισμού hand-crafted χαρακτηριστικών. Ακόμα και στην περίπτωση που το στάδιο υπολογισμού των τοπικών περιγραφέων αγνοηθεί, η αρχιτεκτονική Bag-of-Visual-words δεν έχει την δυνατότητα κωδικοποίησης χαρακτηριστικών σε διαφορετικές βαθμίδες της όλης διαδικασίας, δηλ. τα δεδομένα δεν αναλύονται από πολλαπλές σκοπιές, και ούτε μπορεί να επιτύχει ιεραρχική μάθηση χαρακτηριστικών για την εξαγωγή υψηλής τάξης (high-level) χαρακτηριστικών. Η προσπάθεια επέκτασης της αρχιτεκτονική Bag-of-Visual-words για την ενσωμάτωση ιεραρχικών χαρακτηριστικών από διαφορετικές βαθμίδες της όλης διαδικασίας εκμάθησης αποτελεί το θέμα της παρούσης εργασίας και περιγράφεται αναλυτικά στα επόμενα κεφάλαια. 16

37 Κεφάλαιο 2 : Αραιή Αναπαράσταση (Sparse Representation) 2.1 Εισαγωγή στο πρόβλημα της αραιής αναπαράστασης : Γενική περιγραφή του προβλήματος αραιής αναπαράστασης : Η αραιή αναπαράσταση (Sparse Representation) αποτελεί μία διαδικασία μη εποπτευόμενης μάθησης και χρησιμοποιείται ευρέως στη μηχανική μάθηση, τη νευροεπιστήμη, την επεξεργασία σημάτων και την στατιστική καθώς αποτελεί ένα ερευνητικό πεδίο με αξιοσημείωτα αποτελέσματα τόσο σε απλά προβλήματα όπως απομάκρυνσης θορύβου, σύνθεση υφής, επεξεργασίας ήχου κ.α., όσο και σε πιο σύνθετα όπως προβλήματα ταξινόμησης και ομαδοποίησης. Μία μορφή του προβλήματος της αραιής κωδικοποίησης (Sparse Coding) αφορά στην εξεύρεση της καλύτερης αναπαράστασης -με βάση το σφάλμα ανακατασκευής- ενός δεδομένου σήματος εισόδου ως γραμμικού συνδυασμού ενός περιορισμένου αριθμού σημάτων ενός λεξικού, που ονομάζονται άτομα. Εικόνα 2.2 : Αραιή αναπαράσταση σημάτων (Εικόνα από : [Olshausen 1996],[Lee 2007],[Ranzato 2007]) 17

38 Αν και άλλες τεχνικές μη εποπτευόμενης μάθησης, όπως η ανάλυση κύριων συνιστωσών (PCA) απολήγουν στην εκμάθηση ενός πλήρους συνόλου βάσεων για την αναπαράσταση των διανυσμάτων εισόδου, η αραιή κωδικοποίηση μπορεί να οδηγήσει στην εκμάθηση ενός υπερπλήρους (overcompleteness) λεξικού, δηλ. το πλήθος των ατόμων του λεξικού είναι μεγαλύτερο από την διάσταση του σήματος εισόδου. Το πλεονέκτημα της χρήσης ενός υπερπλήρους λεξικού είναι ότι τα άτομα του λεξικού μπορούν να αποκαλύψουν πιο εύκολα τις δομές και τα πρότυπα που είναι εγγενή με τα σήματα εισόδου και έτσι δύναται να καταγράψουν χαρακτηριστικά υψηλότερου επιπέδου στα δεδομένα. Επιπλέον, οι συντελεστές αραιής αναπαράστασης δεν καθορίζονται πλέον μονοσήμαντα από το διάνυσμα εισόδου αλλά και από τα άτομα του υπερπλήρους λεξικού. Έτσι, ενώ σε ένα πλήρες λεξικό τα άτομα συνήθως είναι ορθοκανονικά, σε ένα υπερπλήρες λεξικό τα άτομα έχουν μοναδιαίο μέτρο και καταλαμβάνουν τις ακτινικές διευθύνσεις που ταιριάζουν καλύτερα στο πρόβλημα. Στην αραιή κωδικοποίηση εισάγεται το πρόσθετο κριτήριο της αραιότητας (sparsity) για την επίλυση του εκφυλισμού που εισάγεται από την υπερπληρότητα. Ο όρος αραιότητα αναφέρεται στην ύπαρξη λίγων μη μηδενικών συντελεστών ή λίγων συντελεστών με τιμή όχι κοντά στο μηδέν στην αραιή αναπαράσταση. Δηλαδή το κριτήριο της αραιότητας σημαίνει ότι για δεδομένο διάνυσμα εισόδου επιδιώκουμε αναπαράσταση με λίγους από τους συντελεστές να απέχουν όσο το δυνατόν περισσότερο από το μηδέν. Η επιλογή της αραιότητας ως επιθυμητού χαρακτηριστικού της αναπαράστασης των δεδομένων εισόδου ενθαρρύνεται από την παρατήρηση ότι τα περισσότερα φυσικά ερεθίσματα, όπως οι φυσικές εικόνες, μπορούν να περιγραφούν ως η υπέρθεση ενός μικρού αριθμού στοιχείων όπως επιφάνειες (surfaces) ή ακμές (edges). Η εφαρμογή της αραιής κωδικοποίησης σε φυσικές εικόνες έχει σαν αποτέλεσμα τα άτομα του λεξικού που προκύπτουν από την διαδικασία εκμάθησης να προσομοιάζουν τα δεκτικά πεδία των νευρώνων στον οπτικό φλοιό [Olshausen 1996 & 1997]. Παρόμοια αποτελέσματα έχουν παρατηρηθεί και στη κωδικοποίηση άλλων φυσικών ερεθισμάτων, όπως η ομιλία και το βίντεο ([Lewicki 2000],[Olshausen 2002]). Με βάση τη βιβλιογραφία [Olshausen 1997] θεωρείται ότι το V1 τμήμα του εγκεφάλου -που δέχεται τα οπτικά ερεθίσματα- πραγματοποιεί μία διαδικασία ανίχνευσης ακμών με κριτήριο αραιότητας καθώς και ότι ο ακουστικός κοχλίας στο αυτί εκτελεί αραιή κωδικοποίηση στις συχνότητες για την άμεση ανταπόκριση στα ερεθίσματα [Booth 2013]. Επομένως, η χρήση ενός υπερπλήρους συνόλου και η ενεργοποίηση λίγων μόνο στοιχείων του συνόλου για ένα δεδομένο σήμα εισόδου είναι μια διαδικασία που έχει παρατηρηθεί σε βιολογικούς νευρώνες καθιστώντας έτσι την αραιή κωδικοποίηση ένα βιολογικά εμπνευσμένο μοντέλο [Olshausen 1997 & 2004]. 18

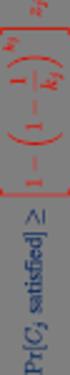

39 2.1.2 Μαθηματική περιγραφή του προβλήματος αραιής αναπαράστασης : Για ένα υπερπλήρες λεξικό D που περιέχει k άτομα-σήματα ως στήλες του, ένα σήμα μπορεί να αναπαρασταθεί σαν γραμμικός συνδυασμός μερικών ατόμων του λεξικού D. Η αναπαράσταση του σήματος μπορεί να είναι είτε ακριβής είτε προσεγγιστική, ικανοποιώντας τη σχέση, όπου η είναι η -νόρμα με. Το διάνυσμα αποτελείται από τους συντελεστές αραιής αναπαράστασης του yᵢ. Επομένως, ένα σύνολο m διανυσμάτων εισόδου είναι ένας πίνακας Υ = { y1,y2,,ym }, το λεξικό είναι D = { d1,d2,,dk } και οι συντελεστές της αραιής αναπαράστασης των m διανυσμάτων είναι A = { α1,α2,,αm }. Έτσι, η συνάρτηση κόστους της αραιής αναπαράστασης για m διανύσματα εισόδου περιγράφεται από τρία ισοδύναμα προβλήματα βελτιστοποίησης : είτε χρησιμοποιώντας την συνάρτηση κανονικοποίησης (regularization) σαν penalty (συνάρτηση ποινής) min + λ Ψ(Α) } και σε μορφή πινάκων: min { D,Α είτε χρησιμοποιώντας την συνάρτηση κανονικοποίησης (regularization) σαν περιορισμό με βάση την τιμή του μ min } και σε μορφή πινάκων: min { D,Α είτε χρησιμοποιώντας ανακατασκευής ε σαν s.t. περιορισμό Ψ(Α) μ την τιμή του σφάλματος min και σε μορφή πινάκων: min { Ψ(Α) } D,Α s.t. ε 19

40 όπου η Ψ(.) είναι μια συνάρτηση κόστους αραιότητας έτσι ώστε οι συντελεστές να μην λαμβάνουν τιμές πολύ μεγαλύτερες από το μηδέν και Frobenius norm που ορίζεται ως. είναι η Στην πράξη παίζει σημαντικό ρόλο ποια από τις τρεις παραπάνω μορφές του προβλήματος θα εκτελεστεί αλλά δεν υπάρχει γενικός κανόνας για την προτίμηση της μίας έναντι της άλλης. Άρα, το πρόβλημα βελτιστοποίησης που επιλέγεται να επιλυθεί για την επίτευξη της αραιής αναπαράστασης εξαρτάται μόνο από την φύση του προβλήματος και τον χρήστη. Όσον αφορά την πρώτη μορφή της συνάρτησης κόστους της αραιής αναπαράστασης, ο πρώτος όρος μπορεί να ερμηνευτεί σαν ο όρος ανακατασκευής για την καλή αναπαράσταση του σήματος εισόδου και ο δεύτερος όρος σαν το κριτήριο αραιότητας το οποίο αναγκάζει την αναπαράσταση να είναι αραιή. Η σταθερά λ είναι μία σταθερά κλιμάκωσης για να προσδιοριστεί η σχετική σχέση των δύο αυτών όρων στην συνάρτηση κόστους. Η ελαχιστοποίηση των παραπάνω συναρτήσεων κόστους μπορεί να επιτευχθεί αν οι συντελεστές α i πάρουν αυθαίρετα μικρές τιμές και τα άτομα d r αυθαίρετα μεγάλες τιμές, κάτι που όμως δεν είναι επιθυμητό. Για την αποφυγή του παραπάνω αποτελέσματος, τα άτομα του λεξικού περιορίζονται ώστε να έχουν ²- νόρμα μικρότερη ή ίση με μία σταθερά, που συνήθως ορίζεται η μονάδα. Έτσι, ονομάζεται C το κυρτό σύνολο των πινάκων που επαληθεύουν αυτόν τον περιορισμό : Επομένως, η συνάρτηση κόστους της αραιής αναπαράστασης με την προσθήκη του περιορισμού C λαμβάνει την μαθηματική μορφή : min k και σε μορφή πινάκων D min { + λ Ψ(Α) } C, Α k x m Άρα, η αραιή αναπαράσταση επιχειρεί την ελαχιστοποίηση του σφάλματος ανακατασκευής του σήματος εισόδου λαμβάνοντας υπόψη τον περιορισμό αραιότητας. Η σχέση μεταξύ των δύο ρυθμίζεται μέσω της τιμής της σταθεράς λ (regularization factor). 20

41 . (data min { + λ Ψ(Α) } D, Α k x m reconstruct error sparsity inducing fitting term) regularization Εικόνα 2.3 : Μαθηματικός φορμαλισμός του προβλήματος της αραιής αναπαράστασης Το πρόβλημα της αραιής αναπαράστασης εμπεριέχει δύο ζητούμενα, την κατασκευή του λεξικού και την κωδικοποίηση των σημάτων εισόδου με την χρήση του λεξικού για τον υπολογισμό των συντελεστών της αραιής αναπαράστασης. Το κοινό πρόβλημα βελτιστοποίησης όμως, δεν είναι κυρτό (jointly convex) ως προς το λεξικό D και τους συντελεστές α i μαζί αλλά είναι κυρτό ως προς κάθε μία μεταβλητή D και όταν η άλλη παραμένει σταθερή. Έτσι, μία προσέγγιση για την επίλυση αυτού του προβλήματος είναι η εναλλαγή μεταξύ των δύο μεταβλητών ελαχιστοποιώντας τη μία και διατηρώντας την άλλη σταθερή. Συνεπώς, το πρόβλημα της αραιής αναπαράστασης διαχωρίζεται σε δύο επιμέρους προβλήματα που επιλύονται διαδοχικά. Το πρώτο βήμα για την επίλυση του προβλήματος της αραιής αναπαράστασης είναι η κατασκευή του λεξικού. Το υπερπλήρες λεξικό που χρησιμοποιείται για την αραιή αναπαράσταση μπορεί να επιλεγεί ώστε να είναι ένα προκαθορισμένο (prespecified) σύνολο διανυσμάτων ή να σχεδιαστεί με τέτοιο τρόπο ώστε να προσαρμόζει το περιεχόμενό του για να ταιριάζει στο δοσμένο σύνολο σημάτων, δηλ. να προκύπτει από μία διαδικασία εκμάθησης. Η χρησιμοποίηση προκαθορισμένου λεξικού είναι ελκυστική λόγω της απλότητάς της διότι σε πολλές περιπτώσεις οδηγεί σε απλούς και γρήγορους αλγορίθμους για την περιγραφή της αραιής αναπαράστασης των σημάτων, όπως για παράδειγμα ο βραχύχρονος μετασχηματισμός Fourier (short-time FT). Βέβαια, η επιτυχία αυτών των λεξικών σε μία εφαρμογή εξαρτάται από το πόσο κατάλληλα είναι για να περιγράψουν τα ζητούμενα σήματα με αραιό τρόπο. Η άλλη κατηγορία λεξικών βασίζεται στην εκμάθηση του λεξικού από τα δεδομένα δείγματα. Στόχος είναι να βρεθεί το λεξικό το οποίο αποδίδει σαφέστερα τις αραιές αναπαραστάσεις των σημάτων εκμάθησης. Αυτού του είδους τα λεξικά επιλέγονται όταν τα σήματα που μελετώνται παρουσιάζουν κάποια κοινά χαρακτηριστικά με αποτέλεσμα το λεξικό που δημιουργείται να προσαρμόζεται σε αυτά. Θεωρείται ότι τέτοια μηπαραμετρικά λεξικά έχουν τη δυνατότητα να ξεπεράσουν τα κοινά χρησιμοποιούμενα προκαθορισμένα λεξικά, και λόγω των αυξημένων υπολογιστικών δυνατοτήτων πλέον, το υπολογιστικό κόστος μπορεί να καταστεί δευτερεύον στοιχείο λόγω της καλύτερης απόδοσης που επιτυγχάνεται όταν χρησιμοποιούνται λεξικά που προσαρμόζονται στα δεδομένα [Aharon 2006]. Η επιλογή του κατάλληλου λεξικού παίζει καθοριστικό ρόλο στην παραγόμενη αραιή 21

42 αναπαράσταση και εξαρτάται τόσο από τα ιδιαίτερα χαρακτηριστικά των σημάτων που επεξεργάζονται όσο και από την σκοπιμότητα της αναπαράστασης. Για αυτό τον λόγο έχουν προταθεί διαφορετικές προσεγγίσεις στο πρόβλημα της κατασκευής μη-παραμετρικών λεξικών, όπως λεξικά με στόχο την καλύτερη δυνατή ανακατασκευή ενός δεδομένου σήματος ([Aharon 2006],[Labusch 2009]) ή λεξικά που παράγουν μία αναπαράσταση που προσφέρει ταυτόχρονα καλή ποιότητα ανακατασκευής και διακριτότητα ως προς τα ενδογενή χαρακτηριστικά των σημάτων έτσι ώστε να είναι κατάλληλα για εφαρμογές ταξινόμησης και ομαδοποίησης σημάτων [Kokiopoulou 2008]. Η επίλυση του προβλήματος της αραιής αναπαράστασης, όπως αναφέρθηκε και παραπάνω, περιλαμβάνει τόσο την εκμάθηση του λεξικού -αν έχει επιλεγεί αυτή η κατηγορία λεξικού- όσο και την παραγόμενη αραιή αναπαράσταση των σημάτων. Η συνάρτηση κόστους αραιότητας Ψ(.) επιβάλλει τον περιορισμό αραιότητας των συντελεστών, δηλ. να μην λαμβάνουν τιμές πολύ μεγαλύτερες από το μηδέν, και λόγω του ότι μπορεί να λάβει διάφορες μορφές επαφίεται στον χρήστη η επιλογή της. Το πιο άμεσο μέτρο αραιότητας είναι η 0-νόρμα ή αλλιώς ψευδό-νόρμα λόγω του ότι απλά μετράει τα μη μηδενικά στοιχεία του διανύσματος αφού 0 = # { i 0 s.t. 0 }. Η χρήση της -νόρμας στην συνάρτηση κόστους, δηλ. ο ακριβής προσδιορισμός των αραιότερων αναπαραστάσεων, αποδεικνύεται ότι είναι ένα μη ντετερμινιστικό πολυωνυμικό χρονικό πρόβλημα (NP-hard problem) και άρα είναι δύσκολο να βελτιστοποιηθεί γενικά. Οπότε, αν επιλεγεί αυτή η μορφή της Ψ(.) αναζητούνται μόνο προσεγγιστικές λύσεις, που μπορούν να επιτευχθούν μέσω αλγορίθμων ταιριάσματος (pursuit algorithms) [Davis 1997]. Η αντικατάσταση της -νόρμας με την -νόρμα, όπου η -νόρμα ισούται με όταν είναι τα k στοιχεία του διανύσματος x, έχει σαν αποτέλεσμα η συνάρτηση κόστους να λαμβάνει μια κυρτή (convex) μορφή. Είναι γνωστό ότι η -μορφή της Ψ(.) οδηγεί σε αραιή αναπαράσταση αν και δεν υπάρχει άμεση σύνδεση μεταξύ της τιμής της σταθεράς κανονικοποίησης λ και του αντίστοιχου πλήθους μη μηδενικών συντελεστών της αραιής αναπαράστασης [Mairal 2009]. Όταν χρησιμοποιείται η νόρμα το πρόβλημα της αραιής κωδικοποίησης ονομάζεται Basis Pursuit (BP) ή Lasso ([Mairal 2009],[Chen 2001],[Tibshirani 1996]). Μία παρόμοια προσέγγιση στο πρόβλημα πραγματοποιείται μέσω του αλγορίθμου FOCUSS (Focal Underdetermined System Solver), ο οποίος αντικαθιστά την -νόρμα με την νόρμα με p 1. Για p < 1 η ομοιότητα με το μέγεθος της πραγματικής αραιότητας, δηλ. του παράγοντα περιορισμού της λύσης, είναι καλύτερη εντούτοις το όλο πρόβλημα καθίσταται μη κυρτό (non convex) με συνέπεια την δημιουργία τοπικών ελαχίστων που δυσκολεύουν την προσέγγιση της λύσης. Στον αλγόριθμο FOCUSS περιλαμβάνονται οι πολλαπλασιαστές Lagrange που χρησιμοποιούνται για την μετατροπή του περιορισμού αραιότητας σε παράγοντα ρύθμισης καθώς και μία επαναληπτική μέθοδος η οποία βασίζεται στην ιδέα των επαναλαμβανόμενων επανασταθμισμένων ελαχίστων τετραγώνων που θεωρούν την -νόρμα ως 22

43 σταθμισμένη ²-νόρμα [Gorodnitsky 1997]. Τόσο ο αλγόριθμος Basis Pursuit όσο και ο FOCUSS αναλύονται με βάση τη εκτίμηση μέγιστης εκ των υστέρων πιθανότητας MAP (Maximum A Posteriori Probability estimation). Η MAP, στην Bayesian στατιστική, είναι η εκτίμηση μίας άγνωστης ποσότητας, η οποία χρησιμοποιείται για την εύρεση της σημειακής εκτίμησης (που είναι ο υπολογισμός ενός στατιστικού στοιχείου του δείγματος ως η καλύτερη εκτίμηση μίας άγνωστης παραμέτρου) μίας μη δοθείσας ποσότητας με βάση τα εμπειρικά δεδομένα. Η MAP χρησιμοποιεί μία επαυξημένη βελτιστοποίηση που ενσωματώνει την προγενέστερη κατανομή στην ποσότητα που πρόκειται να εκτιμηθεί. Έτσι, η MAP εκτιμά τους συντελεστές α i, μεγιστοποιώντας την εκ των υστέρων πιθανότητα P(α i yᵢ,d) P(yᵢ D,α i )P(α i ). Η προγενέστερη (prior) κατανομή των μη μηδενικών συντελεστών του διανύσματος α i θεωρείται ως υπερ-γκαουσιανή (super-gaussian) κατανομή που ενθαρρύνει την αραιότητα. Εν τέλει, η επιτυχία όλων αυτών των αλγορίθμων εξαρτάται από τους περιορισμούς αραιότητας του διανύσματος συντελεστών, οι οποίοι τίθενται από τα επιθυμητά χαρακτηριστικά του λεξικού. Έτσι, όταν το πλήθος των μη μηδενικών συντελεστών είναι αρκετά μικρό σε σχέση με τη διάσταση n του λεξικού D, τότε οι αλγόριθμοι pursuit εκτιμούν μία πολύ καλή προσέγγιση της ιδανικής λύσης [Aharon 2006]. Η αραιή αναπαράσταση αποτελεί μία μη-εποπτευόμενη (unsupervised) μέθοδο μάθησης και επομένως δεν χρειάζεται επισημασμένα δεδομένα (δηλ. που φέρουν ετικέτα και άρα για κάθε διάνυσμα να είναι γνωστή η κατηγορία που ανήκει). Αυτό συμβαίνει διότι κατά την διαδικασία εκμάθησης του λεξικού αραιής αναπαράστασης μπορούν να χρησιμοποιηθούν οποιαδήποτε διανύσματα έχουν προκύψει από τα δεδομένα ως διανύσματα εκμάθησης, χωρίς να απαιτείται η γνώση της κατηγορίας που ανήκουν. Η αραιή κωδικοποίηση (Sparse Coding) δεν εμπεριέχει την έννοια της μάθησης (δηλ. η μάθηση ολοκληρώνεται με τον σχηματισμό του λεξικού) αφού οι συντελεστές αραιής αναπαράστασης υπολογίζονται με μία συγκεκριμένη διαδικασία που καθορίζεται από την μέθοδο κωδικοποίησης -που έχει επιλεγεί- και εκτελείται με βάση το γνωστό πλέον λεξικό. Συνεπώς, αν ένα σήμα κωδικοποιηθεί ξανά με την ίδια μέθοδο, τις ίδιες προδιαγραφές και το ίδιο λεξικό θα προκύπτει πάντα το ίδιο σύνολο συντελεστών. Οπότε, ούτε κατά την διαδικασία της αραιής κωδικοποίησης απαιτείται η γνώση της κατηγορίας που ανήκει το κάθε διάνυσμα που πρόκειται να κωδικοποιηθεί (δηλ. να υπολογιστούν οι συντελεστές αραιής αναπαράστασής τους). Έτσι, αφού δεν απαιτείται η γνώση των κατηγοριών που ανήκουν τα δεδομένα ούτε στο στάδιο εκμάθησης του λεξικού αραιής αναπαράστασης ούτε στο στάδιο αραιής κωδικοποίησης τότε η αραιή αναπαράσταση ορθώς θεωρείται μία μηεποπτευόμενη (unsupervised) μέθοδος. 23

44 Στα επόμενα δύο εδάφια περιγράφονται αναλυτικά δύο χαρακτηριστικές υλοποιήσεις της αραιής αναπαράστασης. Η πρώτη ονομάζεται K-SVD και προτάθηκε από τους M. Aharon, M. Elad, A. Bruckstein το 2006 και η δεύτερη ονομάζεται SPAMS (SPArse Modeling Software) και προτάθηκε από τους J. Mairal, F. Bach, J. Ponce, G. Sapiro το Το κοινό στις δύο τεχνικές είναι ότι το υπερπλήρες λεξικό παράγεται μέσω μιας διαδικασία εκμάθησης από τα δεδομένα δείγματα. Στην πρώτη περίπτωση, όμως, εκτελείται μία διαδικασία batch learning, δηλ. για την εκμάθηση του λεξικού χρησιμοποιούνται όλα τα διαθέσιμα δεδομένα μαζί ενώ στην δεύτερη περίπτωση εφαρμόζεται μία διαδικασία online learning, δηλ. τα δεδομένα γίνονται διαθέσιμα διαδοχικά (και όχι όλα μαζί) και η εκμάθηση του λεξικού πραγματοποιείται σε κάθε βήμα χρησιμοποιώντας τόσο τα νέα διαθέσιμα δεδομένα όσο και την προηγούμενη γνώση. Επίσης, στην πρώτη μέθοδο ο περιορισμός αραιότητας λαμβάνει την μορφή της 0-νόρμας ενώ στην δεύτερη μέθοδο της -νόρμας, οπότε στην πρώτη περίπτωση επιλύεται το πρόβλημα της αραιής κωδικοποίησης που αναφέρεται σαν Matching Pursuit και στην δεύτερη σαν Basis Pursuit ή Lasso. Εικόνα 2.4 : Αραιή αναπαράσταση m σημάτων σε μορφή πινάκων 24

45 2.2 Αλγόριθμος K-SVD : [Aharon 2006] Γενική περιγραφή batch αλγορίθμου εκμάθησης λεξικού : Ο αλγόριθμος K-SVD δημιουργήθηκε για τη σχεδίαση υπερπλήρων προσαρμοζόμενων λεξικών για αραιή αναπαράσταση σημάτων. Διαθέτοντας ένα γνωστό σύνολο από σήματα, αναζητείται το λεξικό εκείνο που αποδίδει την καλύτερη αναπαράσταση για κάθε σήμα του συνόλου, κάτω από αυστηρούς περιορισμούς αραιότητας. Ο K-SVD είναι μία επαναληπτική διαδικασία όπου εναλλάσσονται μία αραιή κωδικοποίηση (sparse coding) των δειγμάτων βασιζόμενη στο τρέχων λεξικό και μία διαδικασία ενημέρωσης (updating dictionary) των ατόμων του λεξικού ώστε να ταιριάζουν καλύτερα στα δεδομένα σήματα εκμάθησης. Η ενημέρωση των ατόμων του λεξικού -δηλ. των στηλών του πίνακα του λεξικούπραγματοποιείται σε συνδυασμό με την ενημέρωση των συντελεστών αραιής αναπαράστασης που σχετίζονται με αυτό το άτομο, έτσι ώστε να επιτυγχάνεται ταχύτερη σύγκλιση. Το πρόβλημα που καλείται ο αλγόριθμος K-SVD να επιλύσει είναι το πρόβλημα της αραιής αναπαράστασης (Sparse Representation), δηλ. ο σχεδιασμός του καλύτερου δυνατού λεξικού D για την αραιή αναπαράσταση των σημάτων Υ=, το οποίο περιγράφεται από τις παρακάτω σχέσεις : min D C,Α kxm { min D C,Α kxm { } s.t., με ορισμένο πλήθος }, για ορισμένη τιμή s.t. ή με Για την περιγραφή του αλγορίθμου θα επικεντρωθούμε στην επίλυση της πρώτης από τις δύο σχέσεις, δηλ. της σχέσης minimize { } s.t., kxm D C,Α η οποία αποτελεί τη συνάρτηση κόστους του προβλήματος, αν και η μεταχείριση είναι παρόμοια και για την άλλη εξίσωση. 25

46 2.2.2 Αλγόριθμοι ταιριάσματος (pursuit) για την υλοποίηση της αραιής κωδικοποίησης (Sparse Coding) με 0-νόρμα : i Αραιή κωδικοποίηση (Sparse Coding) με 0-νόρμα : Στον αλγόριθμο K-SVD υπάρχει το στάδιο της αραιής κωδικοποίησης, δηλ. της διαδικασίας υπολογισμού των συντελεστών αραιής αναπαράστασης, βασιζόμενη σε ένα δεδομένο σήμα και ένα γνωστό λεξικό D. Εάν n<k και D ένας πλήρους βαθμού πίνακας -δηλ. οι πίνακες DᵀD και DDᵀ είναι αντιστρέψιμοι- τότε υπάρχουν άπειρες λύσεις για το πρόβλημα αναπαράστασης και για αυτό το λόγο πρέπει να τεθούν περιορισμοί στη λύση του. Η λύση με το ελάχιστο πλήθος μη μηδενικών συντελεστών είναι η αραιότερη αναπαράσταση και προκύπτει από τη λύση της παρακάτω μαθηματικής έκφρασης : (P ) s.t. (P, ) s.t. ή Η διαδικασία επίλυσης των παραπάνω σχέσεων αποτελεί την αραιή κωδικοποίηση (Sparse Coding [SC]) ή αλλιώς ανάλυση ατόμου (atom decomposition) με κριτήριο αραιότητας την 0-νόρμα και επιτυγχάνεται κατά κύριο λόγο μέσω αλγορίθμων ταιριάσματος (pursuit algorithms), οι οποίοι υπολογίζουν μία προσεγγιστική λύση του προβλήματος. Ο ακριβής προσδιορισμός των αραιότερων αναπαραστάσεων αποδεικνύεται ότι είναι ένα μη ντετερμινιστικό πολυωνυμικό χρονικό πρόβλημα (NP-hard problem) και για αυτό αναζητούνται προσεγγιστικές λύσεις [Davis 1997], οι οποίες επιτυγχάνονται με αλγορίθμους είτε της κατηγορίας greedy είτε επαναληπτικούς αυστηρής κατωφλίωσης, με τους πρώτους να έχουν καλύτερα αποτελέσματα σε συνδυασμό με τον K-SVD [Aharon 2006]. Οι αλγόριθμοι αυτοί επιτελούν μια διαδικασία, όπου αναζητείται η πιο ταιριαστή προβολή των πολυδιάστατων δεδομένων στα άτομα ενός υπερπλήρους λεξικού. Η βασική ιδέα είναι η αναπαράσταση του σήματος y ως σταθμισμένο άθροισμα των ατόμων του λεξικού D, σύμφωνα με τη σχέση, όπου οι μη μηδενικοί συντελεστές του διανύσματος, κάποια από τα άτομα του λεξικού D και το μέγιστο πλήθος των μη μηδενικών συντελεστών του. Με αυτό τον τρόπο, υπολογίζεται η βέλτιστη μη γραμμική προσέγγιση ενός σήματος χτίζοντας μια σειρά αραιών προσεγγίσεων για την σταδιακή ανάκτησή του. Ο παραπάνω συνδυασμός με καθορισμένο πλήθος όρων από τον περιορισμό αραιότητας- προσεγγίζει την λύση του NP-hard προβλήματος. Το αποτέλεσμα της πρόσθεσης των ατόμων που επιλέχθηκαν πολλαπλασιασμένα επί τον ανάλογο συντελεστή είναι ιδανικά το αρχικό σήμα. Σε πολλές περιπτώσεις οι αλγόριθμοι ταιριάσματος παρέχουν εγγυήσεις ορθής ανακατασκευής της αναζητούμενης λύσης, αφού για πολλούς από αυτούς έχουν αποδειχθεί συνθήκες κάτω από τις οποίες ανακατασκευάζουν την 26

47 αραιή λύση με βεβαιότητα [Pati 1993]. Οι αλγόριθμοι ταιριάσματος ακολουθούν μία άπληστη (greedy) προσέγγιση του προβλήματος. Στην κατηγορία greedy κατατάσσονται εκείνοι οι αλγόριθμοι που για την επίλυση του προβλήματος χρησιμοποιούν μία επινοητική μέθοδο, η οποία ακολουθεί την τοπικά βέλτιστη επιλογή σε κάθε βήμα με την ελπίδα να οδηγηθεί έτσι στην γενική λύση του προβλήματος. Η μέθοδος αυτή είναι γρηγορότερη από τις κλασσικές μεθόδους και επιφέρει προσεγγιστική λύση σε προβλήματα που οι κλασσικοί τρόποι επίλυσης αδυνατούν να υπολογίσουν την ακριβή λύση (όπως σε ένα NP-hard problem). Βέβαια, σε πολλά προβλήματα δεν οδηγεί στην καλύτερη λύση που θα μπορούσε να υπολογιστεί. Εν κατακλείδι, οι αλγόριθμοι ταιριάσματος (pursuit) εκτελούν μία επαναληπτική διαδικασία για την εκτίμηση της προσεγγιστικής λύσης, εντοπίζοντας τα άτομα του λεξικού με τη μεγαλύτερη συσχέτιση με το εκτιμώμενο σήμα και αποκαλύπτοντας έτσι μία ή περισσότερες θέσεις μη μηδενικών στοιχείων του αραιού διανύσματος συντελεστών. Ο τερματισμός των αλγορίθμων ταιριάσματος πραγματοποιείται είτε μετά από έναν καθορισμένο αριθμό επαναλήψεων είτε όταν το σφάλμα της εκτιμώμενης αναπαράστασης του σήματος σε σχέση με την δεδομένη απεικόνισή του είναι μικρότερο από μία καθορισμένη τιμή, αναλόγως με το αν επιλύουν την σχέση (P ) ή την (P, ) αντίστοιχα ii Αλγόριθμοι Matching Pursuit και Orthogonal Matching Pursuit : Οι πιο απλοί αλγόριθμοι ταιριάσματος είναι o Matching Pursuit (MP) και η βελτιωμένη εκδοχή του, ο Orthogonal Matching Pursuit (OMP). Συνήθως ένας από τους δύο επιλέγεται στην εκτέλεση του K-SVD και κατά κανόνα είναι ο OMP διότι επιφέρει καλύτερα αποτελέσματα (όπως θα αναφερθεί και παρακάτω). Αυτοί έχουν απλή γεωμετρική ερμηνεία, επιλέγουν τα άτομα του λεξικού διαδοχικά και εφαρμόζοντας το εσωτερικό γινόμενο του σήματος με τα άτομα του λεξικού μαζί ενδεχομένως με τη μέθοδο των ελαχίστων τετραγώνων οδηγούνται τελικά στην προσεγγιστική λύση του προβλήματος. Πιο συγκεκριμένα, ο Matching Pursuit (ή Basic Matching Pursuit ή MP) είναι ένας coordinate descent αλγόριθμος, που για δεδομένο λεξικό D, εκτελεί την παρακάτω επαναληπτική διαδικασία για την αραιή ανάκτηση κάθε σήματος y. Αρχικά, υπολογίζει το εσωτερικό γινόμενο του διανύσματος υπολοίπου rᵗ με κάθε άτομο του D (r d = <r,d> = rᵀd) και μέσω του αποτελέσματος με την μεγαλύτερη απόλυτη τιμή εντοπίζει το άτομο που θα χρησιμοποιηθεί για την αναπαράσταση του σήματος. Ως υπόλοιπο ορίζεται το διάνυσμα rᵗ = y Dαᵗ, όπου y το δεδομένο σήμα, D το λεξικό και αᵗ η τρέχουσα προσεγγιστική αραιή λύση, ενώ, εφόσον ως αρχική λύση αᵗ ⁰ θεωρείται η μηδενική, -κατά συνέπεια- ως αρχικό διάνυσμα υπολοίπου rᵗ ⁰ θεωρείται το δεδομένο σήμα y. Η τιμή του αντίστοιχου μη μηδενικού συντελεστή είναι ίση, κάθε φορά, με την προβολή του υπολοίπου στην αντίστοιχη στήλη του D. Η διεργασία αυτή επαναλαμβάνεται μέχρι να διεκπεραιωθεί η συνθήκη τερματισμού, που είναι είτε ένας καθορισμένος αριθμός 27

48 επαναλήψεων τουλάχιστον ίσος με το πλήθος των μη μηδενικών συντελεστών είτε όταν το σφάλμα της μέτρησης, δηλ. το υπόλοιπο, γίνει μικρότερο από ένα καθορισμένο όριο. Με βάση την παραπάνω διαδικασία του MP, το εκτιμώμενο κάθε φορά αποτέλεσμα δεν είναι απαραίτητα ορθογώνιο με τα προηγούμενα άτομα που επιλέγονται και αυτό σημαίνει ότι ένα νωρίτερα επιλεγμένο άτομο μπορεί να επιλεγεί και πάλι. Το γεγονός αυτό και οι αντίστοιχες επιπλοκές του στη σύγκλιση -όπως η ταλάντωση μεταξύ ενός μικρού πλήθους ατόμων- οδήγησαν στην ανάπτυξη της βελτιωμένης εκδοχής του MP, τον αλγόριθμο OMP. Ο αλγόριθμος OMP -ή forward selection στην στατιστική- ακολουθεί την ίδια διαδικασία με τον MP αλλά με μία επιπλέον ορθογωνοποίηση, αφού ενθαρρύνει το υπόλοιπο να είναι πάντα ορθογώνιο με όλα τα προηγούμενα επιλεγμένα άτομα, κάτι το οποίο είναι ισοδύναμο με τον επανυπολογισμό όλων των τιμών των μη μηδενικών συντελεστών όταν επιλέγεται ένα νέο άτομο. Συνεπώς, κάθε επαναληπτική διαδικασία του OMP είναι υπολογιστικά πιο σύνθετη από αυτή του MP αλλά με αυτό τον τρόπο εγγυάται η σύγκλιση ύστερα από έναν ορισμένο αριθμό επαναλήψεων. Έτσι, ο OMP ανανεώνει όλους τους συντελεστές που έχουν υπολογιστεί μέχρι εκείνη την στιγμή επανα-προβάλλοντας στο υπάρχον επιλεγμένο σύνολο ατόμων, πριν από την αφαίρεση για τον υπολογισμό του υπολοίπου. Το στάδιο της επανα-προβολής για τον υπολογισμό των νέων τιμών των συντελεστών πραγματοποιείται με την χρήση ενός ψευδό-αντίστροφου πίνακα, σύμφωνα με την σχέση με Λ να ορίζεται το σύνολο των μέχρι στιγμής επιλεγμένων ατόμων, και επειδή ο πίνακας αυτός δεν είναι σταθερός εφαρμόζεται η ανάλυση Cholesky. Οπότε, σε κάθε βήμα ο αλγόριθμος OMP επιλέγει το άτομο του λεξικού που σχετίζεται περισσότερο με τα μέχρι στιγμής υπολογισμένα διανύσματα υπολοίπου (residual correlation), μέσω της διαδικασίας που περιγράφηκε στον MP, με το διαδοχικό υπολογισμό του εσωτερικού γινομένου των r και των d. Η ενημέρωση των υπολοίπων (residuals update) υλοποιείται υπολογίζοντας την ορθογώνια προβολή του εκτιμώμενου σήματος στο σύνολο των μέχρι στιγμής επιλεγμένων ατόμων. Με αυτό τον τρόπο, τα μη μηδενικά στοιχεία του διανύσματος α -που αποτελούν τους συντελεστές βαρύτητας των ατόμων στο σταθμισμένο άθροισμα αναπαράστασης- ενημερώνονται σε κάθε βήμα με τη βοήθεια της μεθόδου των ελαχίστων τετραγώνων, η οποία χρησιμοποιεί για την λύση της τα διανύσματα υπολοίπου και τα επιλεγμένα μέχρι αυτό το στάδιο άτομα του λεξικού. Σύμφωνα με αυτή τη μέθοδο, η βέλτιστη λύση προσεγγίζεται όταν το άθροισμα των τετραγώνων των υπολοίπων είναι ελάχιστο. Η μέθοδος των ελαχίστων τετραγώνων εφαρμόζεται σε προβλήματα, όπου ο αριθμός των εξισώσεων είναι μεγαλύτερος από τον αριθμό των αγνώστων (overdetermined systems). Συνοψίζοντας, η επαναληπτική διαδικασία, για τον υπολογισμό των όρων που συνθέτουν την προσεγγιστική λύση, επιλέγει τα άτομα εκείνα που ταιριάζουν καλύτερα στις εσωτερικές δομές του αρχικού σήματος. Έτσι, ο δείκτης του ατόμου που παρατηρείται η μέγιστη ορθογώνια προβολή του υπολοίπου αποτελεί θέση μη 28

49 μηδενικού στοιχείου του εκτιμώμενου αραιού διανύσματος συντελεστών α και η τιμή του στοιχείου αυτού υπολογίζεται μέσω της μεθόδου των ελαχίστων τετραγώνων. Με βάση την όλη παραπάνω διεργασία, τα διανύσματα υπολοίπου είναι, πλέον, ορθογώνια πάνω στα επιλεγμένα άτομα με συνέπεια κανένα άτομο να μην επιλέγεται δεύτερη φορά και το σύνολο των επιλεγμένων ατόμων να αυξάνεται σε κάθε βήμα. Η διεργασία αυτή επαναλαμβάνεται μέχρι να διεκπεραιωθεί η συνθήκη τερματισμού. Η συνθήκη αυτή είναι όμοια με προηγουμένως, δηλ. είτε ένας συγκεκριμένος αριθμός επαναλήψεων είτε το υπόλοιπο να γίνει μικρότερο από ένα καθορισμένο όριο. Βέβαια, είναι προτιμότερη η πρώτη διότι η αποδεδειγμένη ιδιότητα του OMP, που τον κατατάσσει στους σημαντικότερους και πιο αποτελεσματικούς αλγορίθμους pursuit, είναι ότι εξασφαλίζει την σύγκλιση στην ιδανική λύση το πολύ σε k επαναλήψεις της αλγοριθμικής διαδικασίας του, όπου k η διάσταση του λεξικού, δηλ. το πλήθος των ατόμων του D [Pati 1993]. Τελικά, οι δύο αυτοί αλγόριθμοι, MP και OMP, χαρακτηρίζονται από χαμηλή υπολογιστική πολυπλοκότητα και απλή γεωμετρική ερμηνεία. Η διαφορά τους έγκειται στην επιπλέον υπολογιστική προσθήκη του OMP, η οποία οδηγεί τελικά σε βελτιωμένη σύγκλιση. Είναι σημαντικό ότι η προσθήκη αυτή μπορεί να εφαρμοστεί αναδρομικά στον MP και έτσι να δημιουργήσει τον OMP. Ολοκληρώνοντας, σημειώνεται ότι οι δύο αυτοί αλγόριθμοι υποθέτουν ότι τα άτομα του λεξικού είναι κανονικοποιημένα με νόρμα, δηλ. το μέτρο κάθε στήλης του είναι ίσο με 1. Σε διαφορετική περίπτωση για να υπολογιστεί η προβολή του υπολοίπου σε κάθε άτομο θα πρέπει να διαιρεθεί και με το τετράγωνο του μέτρου της αντίστοιχης στήλης του λεξικού D Αναλυτική περιγραφή αλγορίθμου εκμάθησης λεξικού : i Αναλυτική περιγραφή των σταδίων της αραιής κωδικοποίησης και της ενημέρωσης του λεξικού : Η πρώτη διεργασία που πρέπει να εκτελέσει ο αλγόριθμος K-SVD είναι η αρχικοποίηση του πίνακα του λεξικού D ⁰ με ταυτόχρονη κανονικοποίηση με ²-νόρμα των στηλών του. Ο πίνακας D ⁰ μπορεί να σχεδιαστεί με δύο τρόπους. Είτε καθορίζοντας ο χρήστης μόνο το μέγεθος του λεξικού, δηλ. τον αριθμό των ατόμων του D, και ο αλγόριθμος επιλέγει ως άτομα τυχαία σήματα εκμάθησης είτε επιλέγοντας ο χρήστης συγκεκριμένα σήματα, το οποία θα αποτελέσουν τα άτομα του λεξικού. Στη συνέχεια εκτελείται η επαναληπτική διαδικασία, που περιέχει το στάδιο της αραιής κωδικοποίησης και το στάδιο της ενημέρωσης του λεξικού, μέχρι να επέλθει η σύγκλιση, που πρακτικά αντιστοιχεί στην ενεργοποίηση ενός κανόνα τερματισμού ορισμένο από τον χρήστη. Ο κανόνας αυτός συνήθως είναι ένα ορισμένο πλήθος επαναλήψεων της παραπάνω διαδικασίας. 29