Σκοπός μας είναι να εκπαιδεύσουμε το ΝΝ ώστε να πάρει από τα δεδομένα μόνο την «σοφία» που υπάρχει μέσα τους. Αυτή είναι η έννοια της γενίκευσης.

|

|

|

- Αθάμας Δυοβουνιώτης

- 7 χρόνια πριν

- Προβολές:

Transcript

1 Μάθηση και Γενίκευση Ο Mark Twain, το 1897, έγραφε στο βιβλίο του «Following the Equator»: «Θα πρέπει με προσοχή να εξάγουμε από μια εμπειρία μόνο την σοφία που υπάρχει μέσα της και όχι να παρερμηνεύουμε, όπως η γάτα που κάθισε πάνω στο καπάκι της αναμμένης σόμπας και δεν θα ξανακαθίσει ποτέ στο μέλλον, όχι μόνον στο ζεστό, αλλά ούτε και στο κρύο». Σκοπός μας είναι να εκπαιδεύσουμε το ΝΝ ώστε να πάρει από τα δεδομένα μόνο την «σοφία» που υπάρχει μέσα τους. Αυτή είναι η έννοια της γενίκευσης.

2 Μάθηση και Γενίκευση Η βασική στρατηγική γι αυτό, είναι να βρούμε το απλούστερο μοντέλο που εξηγεί («κατανοεί») τα δεδομένα. Είναι μια παραλλαγή της αρχής που λέγεται: «Το ξυράφι του Ockham s» (από τον Άγγλο William of Ockham, 14 ος αιώνας) και η βασική του ιδέα είναι πως όσο πιο περίπλοκο ΝΝ έχουμε, τόσο αυξάνεται η δυνατότητα για σφάλματα. Αυτό, στα ΝΝ, μεταφράζεται ως εξής: Το απλούστερο ΝΝ είναι αυτό που έχει τις λιγότερες ελεύθερες παραμέτρους (δηλαδή βάρη και πολώσεις (bias), ή ισοδύναμα τους λιγότερους νευρώνες.

3 Γενικές Κατευθύνσεις Για τον σωστό σχεδιασμό ενός ΝΝ πρέπει: 1. Να κατανοήσουμε και να εξειδικεύσουμε το πρόβλημα. 2. Συλλογή και ανάλυση των δεδομένων, καθορισμός εισόδων-εξόδων, κατάργηση των ακραίων τιμών, εφαρμογή μεθόδων προ-επεξεργασίας (αλλαγή κλίμακας (rescale), τυποποίηση, ομαλοποίηση), σωστή κωδικοποίηση εξόδων, Έρευνα και εφαρμογή της γνώσης στην επιλογή των χαρακτηριστικών (features) και στην εξαγωγή τους, στην επιλογή τύπου του ΝΝ, της πολυπλοκότητάς του, κ.λ.π.

4 Γενικές Κατευθύνσεις 4. Αρχίζουμε με απλά ΝΝ (απλή αρχιτεκτονική, λίγα στρώματα, λίγοι νευρώνες). 5. Εκπαιδεύουμε το ΝΝ και ελέγχουμε την καλή του επίδοση στα δεδομένα εκπαίδευσης. Εάν αυτό δεν συμβαίνει, τότε αυξάνουμε την πολυπλοκότητα του ΝΝ. 6. Ελέγχουμε την επίδοση της γενίκευσης του ΝΝ με νέα δεδομένα για τον έλεγχό του. Εάν η επίδοση δεν ικανοποιεί, ελέγχουμε τα δεδομένα και την κατανομή τους στα υποσύνολα train/test, ελέγχουμε και μεταβάλλουμε την αρχιτεκτονική του ΝΝ,...

5 Μάθηση και Γενίκευση Μάθηση είναι η διαδικασία αυτοπροσαρμογής ενός συστήματος, για την επίλυση ενός προβλήματος, με κάποιο κριτήριο καταλληλότητας. Ένα ΝΝ λέμε ότι μαθαίνει (εκπαιδεύεται) όταν αλλάζει τις εσωτερικές του παραμέτρους (συνήθως τα βάρη των συνάψεών του) με στόχο να ελαχιστοποιήσει ένα κριτήριο (συνήθως το κριτήριο του σφάλματος, π.χ. το Μέσο Τετραγωνικό Σφάλμα MSE). Αυτό ισχύει γενικότερα για όλα τα «Ευφυή Συστήματα» που μπορούν και μαθαίνουν (η μάθηση είναι βασικό στοιχείο της ευφυΐας). «Μηχανή Μάθησης»: Αυτόματο σύστημα που μαθαίνει (ή εκπαιδεύεται χρησιμοποιώντας κάποια πρότυπα εισόδου. Τα ΝΝ είναι τυπικές «μηχανές μάθησης».

6 Μάθηση και Γενίκευση Η χρησιμότητα της μάθησης είναι περιορισμένη, αν προσφέρει απλώς την δυνατότητα καλής προσέγγισης μόνον των στόχων, για τα πρότυπα που χρησιμοποιήθηκαν στην εκπαίδευση, και δεν προσφέρει την ικανότητα επιτυχίας στην εκτίμηση των στόχων για πρότυπα εισόδου για τα οποία δεν έχει εκπαιδευτεί. Η ικανότητα αυτή (δηλαδή της επιτυχούς πρόβλεψης των στόχων για πρότυπα για τα οποία η μηχανή μάθησης δεν έχει εκπαιδευτεί), λέγεται γενίκευση.

7 Μάθηση και Γενίκευση Για να εκτιμήσουμε την ικανότητα γενίκευσης ενός ΝΝ πρέπει πρώτα να ορίσουμε τον τρόπο με τον οποίο μπορεί να γίνει αυτό. Εάν έχουμε έναν ορισμένο αριθμό δεδομένων, είναι σημαντικό, κατά την φάση της εκπαίδευσης να κρατήσουμε εκτός ένα μέρος αυτών των δεδομένων (ένα υποσύνολο δηλαδή του συνολικού συνόλου των δεδομένων, το Test Set). Αφού το ΝΝ εκπαιδευτεί, θα υπολογίσουμε το σφάλμα που εμφανίζει σ αυτά τα δεδομένα (τα εκτός) και αυτό θα μας δώσει μια ένδειξη για το πώς θα συμπεριφέρεται το ΝΝ στο μέλλον. Είναι η μέτρηση της ικανότητας προς γενίκευση του ΝΝ.

8 Μάθηση και Γενίκευση Το Test Set δεν πρέπει να έχει χρησιμοποιηθεί ποτέ για την εκπαίδευση του ΝΝ, ούτε για την επιλογή ενός ΝΝ, μεταξύ περισσοτέρων υποψηφίων ΝΝ. Δηλαδή πρέπει είναι παντελώς άγνωστο στο ΝΝ. Πρέπει να χρησιμοποιείται μόνο, αφού όλη η εκπαίδευση και η επιλογή έχουν ολοκληρωθεί. Το Test Set πρέπει να είναι αντιπροσωπευτικό όλων των καταστάσεων στις οποίες το ΝΝ θα χρησιμοποιηθεί. Αυτό, μερικές φορές, είναι δύσκολο να εξασφαλισθεί, ειδικά αν η είσοδος (data) είναι πολυδιάστατη ή έχει πολύπλοκη μορφή. Το Test Set χρησιμοποιείται μετά την εκπαίδευση για να μετρήσει την ικανότητα γενίκευσης του ΝΝ.

9 Μάθηση και Γενίκευση Υπάρχουν 5 διαφορετικοί τρόποι για την δημιουργία απλών ΝΝ: Growing (Καλλιέργεια): Αρχίζουμε χωρίς νευρώνες στο ΝΝ και προσθέτουμε νευρώνες μέχρι η επίδοσή του να είναι ικανοποιητική. Pruning (Κλάδεμα): Αρχίζουμε έχοντας ένα μεγάλο ΝΝ, το οποίο υπερπροσαρμόζει (overfit) και αφαιρούμε νευρώνες (ή βάρη), ένα κάθε φορά, μέχρι που το overfit να πέφτει σημαντικά.

10 Μάθηση και Γενίκευση Global searches (Συνολική αναζήτηση): Όπως στους γενετικούς αλγόριθμους, αναζητούμε όλες τις δυνατές αρχιτεκτονικές ΝΝ για τον εντοπισμό του απλούστερου που εξηγεί τα δεδομένα. Regularization (Κανονικοποίηση): Early stopping (Πρόωρη παύση): Οι δύο αυτοί τρόποι, κρατούν το ΝΝ μικρό, περιορίζοντας τα βάρη του και όχι τον αριθμό των βαρών του (συνάψεων).

11 Μάθηση με Επίβλεψη: Για κάθε πρότυπο εισόδου x p Μάθηση και Γενίκευση d p και ορίζεται μια συνάρτηση κόστους: J x 1, d 1,.., x p, d p ; w δίνεται ένα διάνυσμα στόχος Στόχος της εκπαίδευσης είναι να επιλεγεί η τιμή του w ώστε να ελαχιστοποιηθεί η τιμή του J. Μάθηση χωρίς Επίβλεψη: Εδώ, καθώς δεν υπάρχουν τα διανύσματα στόχοι, δίνεται κάποιο κριτήριο καταλληλότητας το οποίο βελτιστοποιείται από την μάθηση. Στο ΝΝ SOM για παράδειγμα, το κριτήριο είναι η ομοιότητα του νευρώνα νικητή (και της γειτονιάς του) με το διάνυσμα εισόδου. Παρόμοια κριτήρια υπάρχουν σε κάθε μοντέλο με μάθηση χωρίς επίβλεψη.

12 Μάθηση και Γενίκευση Συνάρτηση κόστους ή Συνάρτηση Σφάλματος Εκπαίδευσης J train = P p=1 M i=1 d i p yi p 2 Όπου: P = το πλήθος των προτύπων στα οποία εκπαιδεύτηκε το δίκτυο (Training set) p p d i, yi πρότυπο p = στόχοι και έξοδοι του δικτύου για το Μ = το πλήθος των εξόδων του δικτύου

13 Μάθηση και Γενίκευση Συνάρτηση Κόστους ή Συνάρτηση Σφάλματος Ελέγχου J test = T M d i t y i t 2 t=1 i=1 Τ = το πλήθος των προτύπων στα οποία δεν εκπαιδεύτηκε το δίκτυο αλλά τα χρησιμοποιούμε για έλεγχο γενίκευσης (Test set) Μ = το πλήθος των εξόδων του δικτύου d t i, y t i = στόχοι και έξοδοι του δικτύου για το πρότυπο t

14 d Μάθηση και Γενίκευση Πρότυπα εκμάθησης αυτό μάθαμε αληθές μοντέλο x Μάθηση με Επίβλεψη: Να μάθουμε ακριβώς τις τιμές των στόχων d i γιά κάθε διάνυσμα εισόδου x i.

15 Μάθηση και Γενίκευση Σκοπός του ΝΝ δεν είναι να αντιστοιχεί τα πρότυπα (να τα μαθαίνει ή να τα αναγνωρίζει) αλλά να χτίσει το στατιστικό μοντέλο που τα «γεννάει»*. Να μάθει δηλαδή την κρυμμένη «αλήθεια». Μην ξεχνάμε ότι μπορεί να υπάρχει και ο θόρυβος παρατήρησης. Στόχος η γενίκευση. Γενίκευση: Η ικανότητα να εκτιμάμε τη σωστή έξοδο d i για πρότυπα εισόδου x i που δεν έχουμε δει κατά την εκπαίδευση. * Υποτίθεται πως τα δεδομένα που χρησιμοποιούνται για την εκπαίδευση και για τον έλεγχο, προέρχονται από τον ίδιο πληθυσμό δεδομένων.

16 Μάθηση και Γενίκευση Η ικανότητα αυτή της γενίκευσης είναι που διακρίνει τα ευφυή συστήματα (από μία απλή απομνημόνευση, π.χ. μια RAM). Ποιός ο λόγος να χρησιμοποιήσουμε ένα ΝΝ εάν πρόκειται μόνο να απομνημονεύσουμε τα ζεύγη των προτύπων-στόχων: x 1, d 1,.., x p, d p ; Ισχύει κι εδώ το γνωστό: «Δεν είναι καλό να μαθαίνουμε παπαγαλία».

17 Επιλογή μοντέλου Μάθηση και Γενίκευση Έστω ότι χρησιμοποιούμε MLP και Back-Propagation. (Το ίδιο ισχύει και για τα δίκτυα RBF ή για οποιοδήποτε άλλο δίκτυο που εκπαιδεύεται με επίβλεψη). Χρήση πολλών νευρώνων το δίκτυο μπορεί να περιγράψει ιδιαίτερα πολύπλοκες καμπύλες (ή επιφάνειες) Χρήση λίγων νευρώνων το δίκτυο μπορεί να περιγράψει απλές καμπύλες (ή επιφάνειες) Ποια επιλογή να κάνω? Η διαδικασία εκπαίδευσης μπορεί να ειδωθεί και ως ένα πρόβλημα προσαρμογής καμπύλης (curve fitting).

18 Μάθηση και Γενίκευση d αυτό μάθαμε αληθές μοντέλο Σφάλμα υπερ-προσαρμογής (Overfitting). Περισσότεροι νευρώνες απ όσους πρέπει. Κακή γενίκευση, αν και μπορεί να έχουμε τέλεια προσέγγιση των προτύπων εισόδου (κουκίδες). x

19 Μάθηση και Γενίκευση d αυτό μάθαμε αληθές μοντέλο Σφάλμα υπο-προσαρμογής (Underfitting). Λιγότεροι νευρώνες απ όσους πρέπει. Μέτρια ή κακή γενίκευση και φτωχή προσέγγιση των προτύπων εισόδου (κουκίδες). x

20 Μάθηση και Γενίκευση Γενίκευση στην ταξινόμηση (καλή γενίκευση)

21 Μάθηση και Γενίκευση Γενίκευση στην ταξινόμηση (Overfitting)

22 Παράδειγμα Neural Network DESIGN Generalization Target Function Approximation Click the [Train] button to train the logsig-linear netw ork on the data points at left. Use the slide bar to choose the number of neurons in the hidden layer Input Number of Hidden Neurons S1: Difficulty Index: Chapter 11 nnd11gn

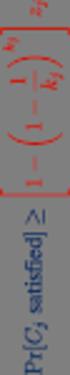

23 Επιλογή μεγέθους δικτύου Μάθηση και Γενίκευση Καταλληλότερο μέγεθος δικτύου: Όταν η καμπύλη J test αρχίζει να αυξάνεται J test J train Πλήθος Νευρώνων N

24 Βελτιώνοντας την Γενίκευση Πως μπορούμε να αντιμετωπίσουμε το underfitting? 1. Να έχουμε αρκετούς κρυφούς νευρώνες για να αντιπροσωπεύονται οι απαραίτητες αντιστοιχίσεις. 2. Να εκπαιδεύσουμε το ΝΝ αρκετά ώστε το SSE να ελαχιστοποιηθεί αρκετά. Πως μπορούμε να αντιμετωπίσουμε το overfitting? 1. Να σχεδιάσουμε σωστά τα δεδομένα εκπαίδευσης πολλά δεδομένα εκπαίδευσης. 2. Διασταυρωμένη Επικύρωση (Cross-validation) έλεγχος της ικανότητας γενίκευσης στα δεδομένα ελέγχου. 3. Πρόωρη Παύση πριν το NN εκπαιδευτεί στα δεδομένα αρκετά καλά.

25 Βελτιώνοντας την Γενίκευση 4. Περιορισμός του αριθμού των ρυθμιζόμενων παραμέτρων a) Μείωση του αριθμού των κρυφών νευρώνων, ή b) Αύξηση των συνάψεων για να μοιραστούν τα βάρη. 5. Προσθέτουμε όρο ελέγχου στην συνάρτηση σφάλματος, για πιο ομαλή αντιστοίχιση. 6. Πρόσθεση θορύβου στα δεδομένα εκπαίδευσης για να γίνει πιο «ανεκτικό» το ΝΝ.

26 Cross-validation (Διασταυρωμένη Επικύρωση) Χρησιμοποιείται για την εκτίμηση του σφάλματος γενίκευσης με βάση επαναπροσδιορισμένα δεδομένα. Τα διαθέσιμα δεδομένα κατανέμονται τυχαία σε: Δεδομένα Εκπαίδευσης (Training set ) Δεδομένα Ελέγχου (Test set ) Το Training set κατανέμεται περεταίρω σε: Estimation subset, για την εκπαίδευση του NN. Validation subset, για την επικύρωση του NN. Το Training set χρησιμοποιείται για την δημιουργία και την επικύρωση διαφόρων δοκιμαστικών μοντέλων (NN), για την επιλογή του «καλύτερου». Η επίδοση της γενίκευσης του επιλεγμένου ΝΝ δοκιμάζεται με το Test set που είναι διαφορετικό από το Validation subset.

27 Παραλλαγές της Cross-validation Πολλαπλή cross-validation Εάν έχουμε λίγα δεδομένα: Διαιρούμε τα N διαθέσιμα δεδομένα σε K υποσύνολα Το μοντέλο εκπαιδεύεται σε όλα τα υποσύνολα (εκτός ενός) Το Σφάλμα Επικύρωσης μετριέται με το υποσύνολο αυτό Η διαδικασία επαναλαμβάνεται K φορές Η επίδοση του μοντέλου από τον Μ.Ο. των Κ επαναλήψεων

28 Παραλλαγές της Cross-validation Leave-one-out cross-validation Ακραία εκδοχή της cross-validation N-1 δεδομένα χρησιμοποιούνται για την εκπαίδευση Το μοντέλο επικυρώνεται με το δεδομένο που έμεινε εκτός Η διαδικασία επαναλαμβάνεται Ν φορές Το αποτέλεσμα είναι ο Μ.Ο. των Ν επαναλήψεων

29 Πρόωρη Παύση Η βασική ιδέα πίσω από την μέθοδο αυτή είναι πως: καθώς η εκπαίδευση προχωράει χρησιμοποιεί όλο και περισσότερο τα βάρη του ΝΝ, ώσπου όλα τα βάρη να έχουν πλήρως χρησιμοποιηθεί, όταν το σφάλμα εκπαίδευσης αγγίζει το ελάχιστό του. Αυξάνοντας τον αριθμό των εποχών εκπαίδευσης, αυξάνουμε την περιπλοκότητα του ΝΝ.

30 Πρόωρη Παύση Εάν η εκπαίδευση σταματήσει πριν φτάσουμε στο ελάχιστο, τότε το ΝΝ θα χρησιμοποιεί λιγότερες παραμέτρους και θα έχει μικρότερη πιθανότητα να υπερπροσαρμόζει (Overfit). Ο αριθμός των παραμέτρων αλλάζει καθώς αυξάνει ο αριθμός των εποχών. Για να κάνουμε σωστή χρήση της μεθόδου της πρόωρης παύσης, πρέπει να ξέρουμε πότε θα σταματήσουμε την εκμάθηση. Αυτό μας το λέει η cross-validation και χρησιμοποιεί προς τούτο το Validation Set.

31 Μάθηση και Γενίκευση Πρόωρη Παύση Τα διαθέσιμα δεδομένα, τα χωρίζουμε σε Training Set και Test Set. Το Training Set χωρίζεται σε δύο υποσύνολα, το Estimation subset και το Validation subset. To Estimation χρησιμοποιείται για τον υπολογισμό του σφάλματος εκπαίδευσης και την επικαιροποίηση των βαρών σε κάθε βήμα εκπαίδευσης. Το validation είναι ένας δείκτης για το τι θα συμβεί στην συνάρτηση του ΝΝ «στο ενδιάμεσο των σημείων εκπαίδευσης», και το σφάλμα του φαίνεται κατά την διάρκεια της εκπαίδευσης.

32 Πρόωρη Παύση Μάθηση και Γενίκευση Όταν το σφάλμα στο validation set αυξάνεται, για μερικές συνεχόμενα εποχές, η εκπαίδευση σταματάει και τα βάρη που έδωσαν το ελάχιστο αυτό σφάλμα στο validation set χρησιμοποιούνται ως τα τελικά βάρη του εκπαιδευμένου ΝΝ. Δηλαδή το Validation τρέχει κατά την διάρκεια της εκπαίδευσης μαζί με το Estimation (και τα δύο μαζί συναποτελούν το Training Set), αλλά δεν συμμετέχει στην επικαιροποίηση των βαρών του ΝΝ. Είναι δηλαδή όπως το Test set, τρέχει κατά την εκπαίδευση και μας δείχνει πότε πρέπει να σταματήσουμε.

33 Πρόωρη Παύση Μάθηση και Γενίκευση Τα ΝΝ συχνά γίνονται με παραπάνω ελεύθερες παραμέτρους (δηλαδή το σύνολο των συναπτικών βαρών και των πολώσεων) από όσο χρειάζεται, πράγμα που μπορεί να δημιουργήσει over-fitting. Για την εκπαίδευση του ΝΝ με επαναληπτική οπισθοδιάδοση του gradient (backpropagation,...), το σφάλμα εκπαίδευσης λογικά μειώνεται όσο αυξάνονται οι εποχές εκπαίδευσης. Το σφάλμα ωστόσο, στα Test set και Validation set τα οποία δεν γνωρίζει το ΝΝ, θα αρχίσει να μειώνεται, καθώς η υπομοντελοποίηση μειώνεται, αλλά θα αρχίσει να ξαναμεγαλώνει όταν προκύψει υπέρ-μοντελοποίηση.

34 Μάθηση και Γενίκευση Ενώ το σφάλμα εκπαίδευσης (training set) συνεχίζει να πέφτει, το σφάλμα στο validation set φτάνει στο ελάχιστό του και εν συνεχεία αυξάνεται. Εδώ είναι το σημείο της πρόωρης παύσης.

35 Μάθηση και Γενίκευση Η απόκριση του ΝΝ όταν έχουμε πρόωρη παύση (είναι ικανοποιητική) ενώ εάν η εκπαίδευση συνεχισθεί θα έχουμε overfiting.

36 Μάθηση και Γενίκευση Διαδικασία Πρόωρης Παύσης Πως γίνεται η εκπαίδευση με την πρόωρη παύση? 1. Χωρίζουμε τα training data σε υποσύνολα estimation set και validation set 2. Χρησιμοποιούμε μεγάλο αριθμό κρυφών νευρώνων 3. Χρησιμοποιούμε πολύ μικρές τυχαίες αρχικές τιμές 4. Χρησιμοποιούμε συντελεστή για αργή εκπαίδευση 5. Υπολογίζουμε περιοδικά το σφάλμα επικύρωσης κατά την εκπαίδευση 6. Σταματάμε την εκπαίδευση όταν το σφάλμα επικύρωσης (validation) αρχίζει να αυξάνεται

37 Μάθηση και Γενίκευση Εφ όσον το σφάλμα επικύρωσης δεν αποτελεί καλή εκτίμηση του σφάλματος γενίκευσης, ένα 3 ο test set πρέπει να εφαρμοστεί για την εκτίμηση της επίδοσης γενίκευσης Τα διαθέσιμα δεδομένα χωρίζονται, όπως στην περίπτωση της cross-validation σε: Training set Estimation subset Validation subset Test set

38 Μάθηση και Γενίκευση Πρακτικές διαπιστώσεις για την πρόωρη παύση Πιθανό Πρόβλημα: Το σφάλμα επικύρωσης μπορεί να αυξομειώνεται πολλές φορές κατά την διάρκεια της εκπαίδευσης η πιο σίγουρη προσέγγιση γενικώς, είναι να εκπαιδεύουμε μέχρι την σύγκλιση, να αποθηκεύουμε τα βάρη σε κάθε εποχή, και μετά να πάμε πίσω στα βάρη, όταν προκύψει η εποχή με το μικρότερο σφάλμα επικύρωσης. Η πρόωρη παύση μοιάζει με την ρύθμιση ελάττωσης βαρών η οποία φαίνεται να λειτουργεί καλύτερα εάν η εκπαίδευση αρχίζει με πολύ μικρές τυχαίες τιμές για τα αρχικά βάρη.

39 Μάθηση και Γενίκευση Γενικά πρακτικά προβλήματα Πως διαχωρίζονται καλύτερα τα διαθέσιμα δεδομένα σε υποσύνολα training και validation? Τι ποσοστό των δεδομένων πρέπει να είναι στο validation set? Τα δεδομένα πρέπει να χωρίζονται τυχαία, ή με κάποιον συστηματικό αλγόριθμο? Τα ερωτήματα αυτά εξαρτώνται από την υφή του κάθε προβλήματος. Η προεπιλογή των παραμέτρων για το Matlab είναι: (train, validation, test): 70%, 15%, 15%.

40 Μάθηση και Γενίκευση Περιορισμοί και μοίρασμα βαρών Ο πιο εύλογος τρόπος για να αποφύγουμε το overfitting στα ΝΝ είναι να περιορίσουμε τον αριθμό των ελεύθερων παραμέτρων (Βάρη και Bias) Η απλούστερη λύση είναι ο περιορισμός των κρυφών νευρώνων, πράγμα που θα μειώσει αυτόματα και τον αριθμό των βαρών. Ο βέλτιστος αριθμός για ένα δεδομένο πρόβλημα- μπορεί να ορισθεί από την cross-validation.

41 Μάθηση και Γενίκευση Κανονικοποίηση (Regularization) Η τεχνική αυτή ενθαρρύνει ομαλότερες αντιστοιχίσεις στο ΝΝ προσθέτοντας ένα όρο-ποινή στην συνάρτηση κόστους SSE: E reg = E SSE + λω Η παράμετρος κανονικοποίησης λ ελέγχει την ισορροπία μεταξύ της μείωσης του σφάλματος E SSE και της αύξησης της εξομάλυνσης. Αυτό μεταβάλλει την κλίση καθόδου (gradient descent) της ενημέρωσης βαρών: n n E m SSE w ij Ω w ij Δw kl = η ηλ w kl m w kl m Η αντιστοίχηση που προκύπτει στο ΝΝ είναι μια συμφωνία μεταξύ προσαρμογής δεδομένων (fitting) και ελαχιστοποίησης του κανονικοποιητή Ω (Regularizer).

42 Μάθηση και Γενίκευση Κανονικοποίηση (Regularization) με ελάττωση των βαρών Μια από τις πιο απλές μορφές Regularizer ονομάζεται κατάβασης βαρών (weight decay) και συνίσταται στο άθροισμα των τετραγώνων των βαρών του ΝΝ: Ω = 1 2 k,l,m w kl m 2 Στο συμβατικό curve fitting ο regularizer είναι γνωστός ως ridge regression. Παρατηρώντας τον επιπρόσθετο όρο στην ενημέρωση των βαρών: ηλ Ω w ij n w kl m = ηλw kl αντιλαμβανόμαστε προς τι η ονομασία weight decay: Σε κάθε εποχή τα βάρη μειώνονται ανάλογα με το μέγεθός τους. Εμπειρικά αυτό οδηγεί σε αξιοσημείωτη βελτίωση της γενίκευσης. Η μείωση των βαρών κρατά μικρές τις τιμές τους και έτσι οι αντιστοιχήσεις είναι ομαλές. m

43 Μάθηση και Γενίκευση Εκπαίδευση με θόρυβο / Jittering Προσθέτοντας θόρυβο (jitter) στις εισόδους, κατά την εκπαίδευση, βρέθηκε εμπειρικά πως αυτό βελτιώνει την γενίκευση του ΝΝ. Ο θόρυβος «θολώνει» τα σημεία-δεδομένα εισόδου και κάνει πιο δύσκολη, για το ΝΝ, την επακριβή αντιστοίχισή τους, μειώνοντας έτσι το over-fitting. Η θορυβοποίηση (Jittering) ολοκληρώνεται με την παραγωγή νέων εισόδων, χρησιμοποιώντας τις αρχικές και προσθέτοντας λίγο θόρυβο. Εάν προσθέσουμε θόρυβο στους στόχους, αυτό δεν θα αλλάξει τα βέλτιστα βάρη, αλλά απλά θα επιβραδύνει την εκπαίδευση. Η θορυβοποίηση συνδέεται επίσης στενά και με τις μεθόδους συστηματοποίησης (regularization), όπως η weight decay και η ridge regression.

44 Μάθηση και Γενίκευση Επισκόπηση Generalization Πρόληψη underfitting 1. Να έχουμε αρκετούς κρυφούς νευρώνες 2. Να εκπαιδεύσουμε αρκετά το ΝΝ Πρόληψη overfitting 1. Σωστή επιλογή των δεδομένων εκπαίδευσης 2. Cross-validation (Διασταυρωμένη Επικύρωση) 3. Πρόωρη παύση 4. Περιορισμός του αριθμού των ρυθμιζόμενων παραμέτρων 5. Regularization (Συστηματοποίηση) 6. Jittering (Θορυβοποίηση )

45 Γενικές Κατευθύνσεις Συλλογή/ Προεπεξεργασία Δεδομένων Επιλογή ΝΝ Τύπος/ Αρχιτεκτονική Επιλογή Αλγορίθμου Εκπαίδευσης Ανάλυση Επίδοσης ΝΝ Αρχικοποίηση Βαρών & Εκπαίδευση ΝΝ Χρήση ΝΝ Μπλοκ Διάγραμμα Μελέτης ΝΝ

46 Γενικές Κατευθύνσεις Πριν την εκπαίδευση Συλλογή των Δεδομένων Προεπεξεργασία Δεδομένων Επιλογή ΝΝ (Τύπος και Αρχιτεκτονική) Εκπαίδευση Ανάλυση ΝΝ μετά την Εκπαίδευση

47 Συλλογή των Δεδομένων Καθώς τα ΝΝ είναι μια τεχνολογία που βρίσκεται στο «έλεος» των δεδομένων, όσο καλύτερη επιλογή δεδομένων έχουμε, τόσο καλύτερο μπορεί να γίνει το ΝΝ. Τα δεδομένα πρέπει να καλύπτουν όλη την περιοχή στην οποία είναι δυνατό να κινείται η είσοδος του ΝΝ. Υπάρχουν μέθοδοι εκπαίδευσης που εξασφαλίζουν ότι το ΝΝ θα ανταποκρίνεται με ακρίβεια σε όλο το εύρος των δεδομένων (interpolation) που του χορηγούνται (καλή γενίκευση).

48 Συλλογή των Δεδομένων Εάν όμως τα δεδομένα εισόδου είναι εκτός της περιοχής του training set, τότε η επίδοση του ΝΝ δεν μπορεί να εξασφαλισθεί. Τα ΝΝ, όπως και άλλες μη γραμμικές black box, δεν προεκτείνουν καλά (extrapolation). Interpolation: όταν ανταποκρίνεται στο ενδιάμεσο διάστημα μιας περιοχής δεδομένων Extrapolation: όταν ανταποκρίνεται στο διάστημα εκτός μιας περιοχής δεδομένων

49 Συλλογή των Δεδομένων Δεν είναι πάντα δεδομένο πως η περιοχή εισόδου αντιπροσωπεύεται επαρκώς από τα δεδομένα εκπαίδευσης (training set). Για απλά προβλήματα με ανύσματα εισόδου μικρών διαστάσεων (π.χ. 2), όπου το κάθε στοιχείο του ανύσματος μπορεί να επιλεγεί ανεξάρτητα, μπορούμε να αναπαραστήσουμε την περιοχή εισόδου σε πλέγμα. Αυτό όμως δεν είναι σύνηθες, καθώς οι διαστάσεις είναι περισσότερες των 2 και μπορεί να είναι και εξαρτημένες.

50 Συλλογή των Δεδομένων

51 Συλλογή των Δεδομένων Η σκιασμένη επιφάνεια αντιπροσωπεύει την περιοχή στην οποία μπορούν να κινηθούν οι είσοδοι. Δεν είναι πάντα δεδομένο πως η περιοχή εισόδου αντιπροσωπεύεται επαρκώς από τα δεδομένα εκπαίδευσης (training set). Ακόμα κι αν η κάθε μεταβλητή μπορεί να κινηθεί μεταξύ [-1 1], δεν χρειαζόμαστε πλέγμα στο οποίο και οι δύο μεταβλητές κινούνται σε όλο τους το φάσμα. Το ΝΝ χρειάζεται να βρει (fit) την συνάρτηση μόνον στην σκιασμένη επιφάνεια, καθώς εκεί μόνο θα χρησιμοποιηθεί. Εκτός αυτής είναι ανώφελο. Αυτό ισχύει κυρίως για πολυδιάστατες εισόδους.

52 Μπορεί να μην είναι πάντα δυνατός ο ακριβής προσδιορισμός του ενεργού τμήματος της περιοχής εισόδου, συνήθως όμως έχουμε την δυνατότητα συλλογής δεδομένων (του συστήματος που θέλουμε να μοντελοποιήσουμε), σε όλες τις περιοχές και τις καταστάσεις λειτουργίας του. Πως όμως μπορούμε να ξέρουμε αν τα δεδομένα εκπαίδευσης αντιπροσωπεύουν επαρκώς την περιοχή εισόδου? Αυτό δεν είναι δυνατόν να απαντηθεί πριν την εκπαίδευση και πολλές φορές, όταν δεν έχουμε έλεγχο στην επιλογή των δεδομένων, είμαστε υποχρεωμένοι να χρησιμοποιήσουμε αυτά που έχουμε. Συλλογή των Δεδομένων

53 Συλλογή των Δεδομένων Αυτό μπορεί να γίνει στην φάση: Post-Training Analysis. Αναλύοντας το εκπαιδευμένο ΝΝ μπορούμε συχνά να πούμε αν τα δεδομένα εκπαίδευσης ήταν επαρκή. Υπάρχουν τεχνικές που δείχνουν πότε ένα ΝΝ χρησιμοποιήθηκε εκτός της περιοχής δεδομένων με τα οποία εκπαιδεύτηκε. Αυτό βέβαια δεν βελτιώνει την επίδοση του ΝΝ, αλλά μας προφυλάσσει από το να το χρησιμοποιήσουμε σε περιπτώσεις που δεν είναι αξιόπιστο.

54 Τα δεδομένα που έχουν επιλεγεί, χωρίζονται σε τρία σύνολα: Training set, 70% Validation set, 15% Testing set, 15% Συλλογή των Δεδομένων Είναι σημαντικό και τα τρία σύνολα να καλύπτουν όλο το εύρος των εισόδων. Αυτό μπορεί να γίνει με την κατανομή των δεδομένων στα τρία σύνολα με τυχαίο τρόπο, αν και θα πρέπει να γίνεται κι ένας έλεγχος για τυχόν μεγάλες διαφορές μεταξύ τους.

55 Συλλογή των Δεδομένων Μια άλλη εύλογη ερώτηση είναι: Τα δεδομένα που έχουν επιλεγεί, είναι αρκετά? Αυτό είναι δύσκολο να απαντηθεί, ιδίως πριν την εκπαίδευση του ΝΝ. Τα απαιτούμενα δεδομένα εξαρτώνται από την πολυπλοκότητα της συνάρτησης που θέλουμε να προσεγγίσουμε (ή από την πολυπλοκότητα των ορίων των περιοχών που θέλουμε να χωρίσουμε). Όσο πιο μεγάλη πολυπλοκότητα υπάρχει, τόσο περισσότερα δεδομένα χρειάζονται, ενώ αντίθετα όσο πιο ομαλή, τόσο λιγότερα (εκτός κι αν τα δεδομένα έχουν θόρυβο).

56 Συλλογή των Δεδομένων Η επιλογή του πλήθους δεδομένων συναρτάται στενά με τον αριθμό των νευρώνων του ΝΝ. Γενικά βέβαια δεν γνωρίζουμε την πολυπλοκότητα της συνάρτησης ή των περιοχών, πριν την εκπαίδευση του ΝΝ, γι αυτό και η συνολική εκπαίδευσή του γίνεται με τρόπο επαναληπτικό (όπως φαίνεται στο μπλοκ διάγραμμα). Με την ολοκλήρωση της εκπαίδευσης μπορούμε να αναλύσουμε την επίδοση του ΝΝ και να αποφασίσουμε αν τα δεδομένα ήταν επαρκή.

57 Σκοπός της προεπεξεργασίας των δεδομένων είναι να διευκολύνει την εκπαίδευση του ΝΝ ώστε να εξάγει την χρήσιμη πληροφορία. Μπορεί κατά περίπτωση- να περιλαμβάνει: rescaling detrending εξαγωγή χαρακτηριστικών γνωρισμάτων Principal Component Analysis (PCA) κανονικοποίηση μη γραμμικό μετασχηματισμό επανάκτηση δεδομένων ψηφιακή κωδικοποίηση εισόδων/εξόδων κλπ. Προεπεξεργασία των Δεδομένων

58 Κανονικοποίηση (normalization) Στα MLP, όπου χρησιμοποιείται συχνά η σιγμοειδής συνάρτηση στα κρυφά στρώματα, έχουμε κορεσμό όταν η είσοδός της είναι μεγαλύτερη του 3 (e 3 0,05), πράγμα που δεν επιθυμούμε στην αρχή της εκπαίδευσης. Εάν πάλι οι είσοδοι είναι πολύ μεγάλες, τότε τα βάρη πρέπει να είναι μικρά για να μην οδηγηθούμε στον κορεσμό. Και στις δύο περιπτώσεις, είναι κοινή πρακτική πριν εφαρμόσουμε τις εισόδους στο ΝΝ- να τις κανονικοποιούμε, πράγμα που εξασφαλίζει χαμηλές τιμές διεγέρσεων για το στρώμα εισόδου. Προεπεξεργασία των Δεδομένων

59 Κανονικοποίηση Υπάρχουν δύο μέθοδοι κανονικοποίησης: 1. Οδηγεί τις τιμές σε μια standard περιοχή, π.χ. -1 μέχρι 1. p n = 2 p p min./ p max p min 1 Όπου: p n : κανονικοποημένη είσοδος p min : το άνυσμα, που περιέχει τις μικρότερες τιμές για κάθε στοιχείο, από τα ανύσματα εισόδου p max : το άνυσμα, που περιέχει τις μεγαλύτερες τιμές για κάθε στοιχείο, από τα ανύσματα εισόδου./: συμβολίζει την διαίρεση στοιχείο προς στοιχείο δύο ανυσμάτων Προεπεξεργασία των Δεδομένων

60 Προεπεξεργασία των Δεδομένων Κανονικοποίηση 2. Μία άλλη μέθοδος είναι να οδηγήσουμε τις τιμές ώστε να έχουν μέση τιμή και διακύμανση 0 και 1 αντίστοιχα: p n = p p mean./p std Όπου: p mean : η μέση τιμή των ανυσμάτων εισόδου p std : το άνυσμα, που περιέχει τις τυπικές αποκλίσεις κάθε στοιχείου των ανυσμάτων εισόδου Γενικά η κανονικοποίηση εφαρμόζεται και στα ανύσματα εισόδου και στα ανύσματα στόχους της εξόδου.

61 Προεπεξεργασία των Δεδομένων Μη Γραμμικός Μετασχηματισμός (Nonlinear Transformation) Ο μη γραμμικός μετασχηματισμός σε αντίθεση με την κανονικοποίηση που είναι γραμμικός- δεν εφαρμόζεται σε όλα τα δεδομένα, αλλά κατά περίπτωση. Π.χ., στα οικονομικά δεδομένα, πολλές μεταβλητές έχουν μια λογαριθμική εξάρτηση, πράγμα που μας οδηγεί να βρούμε τον λογάριθμο των δεδομένων πριν τα εφαρμόσουμε στο ΝΝ. Ο μη γραμμικός μετασχηματισμός κατά κάποιο τρόπο- δίνει την δυνατότητα να συμπεριλάβουμε την πρότερη γνώση στην εκπαίδευση του ΝΝ και εάν είναι σωστά επιλεγμένος, κάνει την εκπαίδευση του ΝΝ πιο αποτελεσματική, απαλλάσσοντάς το από την εργασία που χρειάζεται για την εύρεση του μετασχηματισμού μεταξύ εισόδων-εξόδων.

62 Προεπεξεργασία των Δεδομένων Εξαγωγή χαρακτηριστικών (Feature Extraction) Όταν η διάσταση των δεδομένων εισόδου είναι πολύ μεγάλη και στοιχεία του ανύσματος εισόδου είναι περιττά, τότε είναι δόκιμο να ελαττώσουμε την διάσταση του ανύσματος εισόδου, υπολογίζοντας από αυτό ένα άνυσμα με χαρακτηριστικά του στοιχεία και μικρότερη διάσταση, το οποίο και θα αποτελέσει τα δεδομένα εισόδου στο ΝΝ. Π.χ. στην μελέτη ηλεκτροκαρδιογραφημάτων (EKG) μπορεί να έχουμε σήματα στην διάρκεια μερικών λεπτών, πράγμα που δημιουργεί πάρα πολλά δεδομένα για το ΝΝ. Αντ αυτού μπορούμε να εξάγουμε μερικά χαρακτηριστικά από το σήμα (EKG), όπως π.χ. την μέση τιμή του, την μέση χρονική απόσταση μεταξύ κάποιων κυματομορφών του, την διακύμανσή του, κ.λ.π.

63 Προεπεξεργασία των Δεδομένων Ανάλυση Κυρίων Συνιστωσών (Principal Component Analysis) Υπάρχουν μερικές μέθοδοι γενικού σκοπού για την εξαγωγή των χαρακτηριστικών, με την πιο γνωστή να είναι η Ανάλυση Κυρίων Συνιστωσών (principal component analysis (PCA). Η μέθοδος μετασχηματίζει τα αρχικά ανύσματα, έτσι ώστε τα στοιχεία των μετασχηματισμένων ανυσμάτων να μην έχουν σχέση μεταξύ τους, και κατατάσσει τα στοιχεία κατά σειρά, σύμφωνα με την μεγαλύτερη διακύμανση που έχει το καθένα. Συνήθως κρατάμε τα πρώτα στοιχεία, με την μεγαλύτερη διακύμανση, επιτυγχάνοντας έτσι σημαντική μείωση στην διάσταση του ανύσματος εισόδου, ιδίως αν τα αρχικά στοιχεία έχουν ισχυρή συσχέτιση.

64 Προεπεξεργασία των Δεδομένων Ανάλυση Κυρίων Συνιστωσών (Principal Component Analysis) Το μειονέκτημα της μεθόδου είναι ότι «βλέπει» μόνο τις γραμμικές σχέσεις που υπάρχουν μεταξύ των στοιχείων του ανύσματος εισόδου. Όταν μειώνουμε την διάσταση του ανύσματος με γραμμικό μετασχηματισμό, μπορεί να χάσουμε κάποιες μη γραμμικές πληροφορίες. Καθώς τα ΝΝ προορίζονται κυρίως να χρησιμοποιηθούν για την ικανότητά τους στην μη γραμμική αντιστοίχιση, όταν μειώνουμε την διάσταση της εισόδου, χρειάζεται προσοχή στην εφαρμογή. Υπάρχει μια μη γραμμική εκδοχή της PCA, η kernel PCA.

65 Προεπεξεργασία των Δεδομένων Κωδικοποίηση των στόχων (Coding Targets) Μία άλλη σημαντική προεπεξεργασία που απαιτείται, είναι όταν οι είσοδοι (ή οι στόχοι) παίρνουν μόνο διακριτές τιμές. Εάν π.χ. έχουμε να αναγνωρίσουμε δεδομένα εισόδου σε 4 κλάσεις και κάθε στόχος (επιθυμητή έξοδος) πρέπει να αντιπροσωπεύει μία εκ των 4 κλάσεων, τότε χρειάζεται μία κωδικοποίηση των στόχων:

66 Προεπεξεργασία των Δεδομένων Κωδικοποίηση των στόχων (Coding Targets) Μπορούμε να έχουμε για στόχο έναν αριθμό για κάθε κλάση (1,2,3,4). Μπορούμε να έχουμε στόχο με 2 ψηφία: (0,0), (0,1), (1,0), (1,1)). Μπορούμε να έχουμε 4 εξόδους και να ενεργοποιείται η κάθε μία ανάλογα με την κλάση: (1,0,0,0), (0,1,0,0), (0,0,1,0), (0,0,0,1) (η καλύτερη ταξινόμηση). Με τον ίδιο τρόπο κωδικοποιούνται και οι είσοδοι.

67 Προεπεξεργασία των Δεδομένων Κωδικοποίηση των στόχων (Coding Targets) Στην κωδικοποίηση των στόχων, χρειάζεται να δούμε και την συνάρτηση ενεργοποίησης του στρώματος εξόδου του ΝΝ. Για αναγνώριση δεδομένων συνήθως χρησιμοποιούμε τις σιγμοειδείς συναρτήσεις: log-sigmoid ή tangentsigmoid. Στην περίπτωση της tangent-sigmoid (που δίνει έξοδο [- 1 έως 1]) είναι λογικό να κάνουμε κωδικοποίηση στόχων με -1 ή 1, που είναι οι ασύμπτωτές της.

68 Προεπεξεργασία των Δεδομένων Κωδικοποίηση των στόχων (Coding Targets) Όμως αυτό μπορεί δημιουργεί δυσκολίες στον αλγόριθμο εκπαίδευσης του ΝΝ που προσπαθεί να πάει στον κορεσμό της σιγμοειδούς συνάρτησης για να βρει την τιμή στόχου. Εδώ είναι καλύτερα να αντιστοιχίσουμε τις τιμές στόχους εκεί που είναι το μέγιστο της 2 ας παραγώγου της σιγμοειδούς συνάρτησης. Για την tangent-sigmoid, αυτό προκύπτει όταν η είσοδος είναι -1 και 1, πράγμα που αντιστοιχεί στις τιμές εξόδου και

69 Προεπεξεργασία των Δεδομένων Detrending Αφαίρεση της γραμμικής τάσης στις χρονοσειρές Μετά την πραγματοποίηση και την εφαρμογή του ΝΝ η αρχική γραμμική τάση μπορεί να προστεθεί ξανά Προσοχή: Είναι πολύ εύκολο να δημιουργήσουμε trend εκεί που δεν υπάρχουν!

70 Detrending Προεπεξεργασία των Δεδομένων

71 Απολεσθέντα Δεδομένα (Missing Data) Μερικές φορές, ειδικότερα στις οικονομικές εφαρμογές, έχουμε απώλεια δεδομένων. Εάν π.χ. έχουμε, στο άνυσμα εισόδου, 20 στοιχεία που συλλέγονται κάθε μήνα, αλλά μερικά από αυτά (1-2) δεν έχουν συλλεχθεί σωστά για κάποιους μήνες, η απλούστερη λύση είναι να απορρίψουμε όλα τα δεδομένα από αυτούς τους μήνες. Αν όμως έχουμε ανάγκη από δεδομένα, τότε πρέπει να τα χρησιμοποιήσουμε όλα όσα έχουμε. Υπάρχουν διάφορες στρατηγικές προς τούτο. Η πιο συνήθης είναι να τα αντικαταστήσουμε με τον Μ.Ο. αυτών που υπάρχουν για το στοιχείο αυτό του ανύσματος. Προεπεξεργασία των Δεδομένων

72 Ο βασικός τύπος του ΝΝ καθορίζεται από τον τύπο του προβλήματος που έχουμε να επιλύσουμε. Αφού γίνει η αρχική επιλογή, μετά εξειδικεύουμε παραπέρα, με τον αριθμό των νευρώνων και των στρωμάτων του, τον αριθμό των εξόδων και την επίδοση που θέλουμε να έχει στην εκπαίδευση. Επιλογή Βασικής Αρχιτεκτονικής Τα πιο διαδεδομένα προβλήματα προς επίλυση είναι: Fitting (Προσαρμογή) Pattern recognition (Αναγνώριση Μορφών) Clustering (Ομαδοποίηση) Prediction (Πρόβλεψη) Επιλογή Αρχιτεκτονικής ΝΝ

73 Επιλογή Αρχιτεκτονικής ΝΝ Fitting (Προσαρμογή) Αναφέρεται και ως προσέγγιση συνάρτησης (Function Approximation) ή παλινδρόμηση (Regression). Θέλουμε το ΝΝ να κάνει την αντιστοίχιση μεταξύ των δεδομένων εισόδου και των στόχων που τα αντιστοιχούν. Π.χ.: Ένας μεσίτης θέλει να εκτιμήσει τις τιμές ακινήτων, από δεδομένα εισόδου του τύπου: φορολογικός συντελεστής, σχέση μαθητών/δασκάλων στην περιοχή, εγκληματικότητα. Ένας μηχανολόγος μηχανικός θέλει να εκτιμήσει τους ρύπους της μηχανής με βάση την κατανάλωση καυσίμου και την ταχύτητα. Ένας γιατρός θέλει να προβλέψει το πάχος σε έναν άρρωστο με βάση τις μετρήσεις στο σώμα του.

74 Επιλογή Αρχιτεκτονικής ΝΝ Fitting (Προσαρμογή) Για τις περιπτώσεις αυτές, η έξοδος έχει συνεχείς τιμές. Το ΝΝ που ενδείκνυται περισσότερο είναι το MLP, με νευρώνες tansig στα κρυφά στρώματα και linear στο στρώμα εξόδου. Η συνάρτηση tansig προτιμάται, σε σχέση με την logsig, για τους ίδιους λόγους που κάνουμε κανονικοποίηση των δεδομένων εισόδου. Δίνει εξόδους που γίνονται είσοδοι για το επόμενο στρώμα και είναι κεντραρισμένες γύρω από το 0, ενώ η logsig δίνει όλο θετικές εξόδους.

75 Επιλογή Αρχιτεκτονικής ΝΝ Fitting (Προσαρμογή) Για τις περισσότερες περιπτώσεις fitting, ένα κρυφό στρώμα επαρκεί. Αν το αποτέλεσμα δεν μας ικανοποιεί, μπορούμε να χρησιμοποιήσουμε και δύο κρυφά στρώματα. Σπάνια χρησιμοποιούνται πάνω από 2 κρυφά στρώματα. Οι νευρώνες με γραμμική συνάρτηση ενεργοποίησης χρησιμοποιούνται στην έξοδο καθώς ο στόχος είναι μια συνεχής μεταβλητή. Το ΝΝ με 2 στρώματα, sigmoid συνάρτηση στο κρυφό στρώμα και γραμμική στο στρώμα εξόδου, λέγεται και universal approximator (MLP).

76 Επιλογή Αρχιτεκτονικής ΝΝ Fitting (Προσαρμογή) Τα RBF NN μπορούν επίσης να χρησιμοποιηθούν σε προβλήματα fitting. Η συνάρτηση Gaussian χρησιμοποιείται συνήθως στο κρυφό στρώμα και η linear στο στρώμα εξόδου.

77 Επιλογή Αρχιτεκτονικής ΝΝ Pattern recognition (Αναγνώριση Μορφών) Αναφέρεται και ως ταξινόμηση μορφών (pattern classification). Θέλουμε το ΝΝ να κατηγοριοποιεί τις εισόδους σε κατηγορίες στόχους της εξόδου. Ένας πωλητής κρασιών θέλει να αναγνωρίζει το αμπέλι από το οποίο προέρχεται ένα μπουκάλι κρασί, με βάση την χημική ανάλυσή του. Ένας γιατρός θέλει να ταξινομεί έναν όγκο ως καλοήθη ή κακοήθη, με βάση την ομοιομορφία του μεγέθους των κυττάρων, το πάχος και την δομή τους.

78 Επιλογή Αρχιτεκτονικής ΝΝ Pattern recognition (Αναγνώριση Μορφών) Το MLP μπορεί να χρησιμοποιηθεί και σ αυτήν την περίπτωση, με την διαφορά πως, η συνάρτηση ενεργοποίησης στο στρώμα εξόδου που χρησιμοποιείται γενικώς είναι η σιγμοειδής και όχι η γραμμική. Το RBF επίσης μπορεί να χρησιμοποιηθεί σε προβλήματα αναγνώρισης μορφών.

79 Επιλογή Αρχιτεκτονικής ΝΝ Clustering (Ομαδοποίηση) Εδώ θέλουμε το ΝΝ να ομαδοποιεί τα δεδομένα με βάση την ομοιότητά τους. Π.χ.: Μια επιχείρηση θέλει να χωρίσει σε τμήματα το εμπόριό της σύμφωνα με τα χαρακτηριστικά των πελατών. Ένας πληροφορικός θέλει να χωρίσει τα δεδομένα των συνταξιούχων σε κατηγορίες σχετικές με τα εισοδήματα. Ένα βιολόγος θέλει να κάνει βιοπληροφορική ανάλυση, ομαδοποιώντας τα γονίδια με βάση τις σχέσεις στην μορφή τους.

80 Επιλογή Αρχιτεκτονικής ΝΝ Clustering (Ομαδοποίηση) Μπορούν να χρησιμοποιηθούν ανταγωνιστικά ΝΝ. Το Self-Organizing Feature Map (SOFM) είναι το πιο δημοφιλές. Το μεγάλο του πλεονέκτημα είναι πως δίνει την δυνατότητα της οπτικής αναπαράστασης των πολυδιάστατων ανυσμάτων εισόδου.

81 Prediction (Πρόβλεψη) Η πρόβλεψη χρησιμοποιείται στις περιπτώσεις της ανάλυσης χρονοσειρών, του φιλτραρίσματος, ή της δυναμικής μοντελοποίησης. Εδώ θέλουμε να προβλέψουμε την μελλοντική τιμή μιας χρονικής σειράς. Ένας τραπεζίτης θέλει να προβλέψει με ασφάλεια την τιμή μιας μετοχής. Ένας μηχανικός θέλει να προβλέψει την τιμή της συγκέντρωσης κάποιου χημικού στοιχείου στην έξοδο μιας χημικής επεξεργασίας. Ένας μηχανικός θέλει να προβλέψει τις διακοπές του ηλεκτρικού ρεύματος. Επιλογή Αρχιτεκτονικής ΝΝ

82 Prediction (Πρόβλεψη) Η πρόβλεψη απαιτεί την χρήση δυναμικών ΝΝ. Το είδος του δυναμικού ΝΝ για κάθε περίπτωση συνδέεται με την συγκεκριμένη εφαρμογή. Το απλούστερο ΝΝ, για μη γραμμική πρόβλεψη, είναι το επικεντρωμένο (Focused) TDNN. Το TDNN ανήκει στα δυναμικά ΝΝ με την δυναμικότητα να προσδιορίζεται μόνο στο στρώμα εισόδου ενός στατικού MLP. Εκπαιδεύεται με τους στατικούς backpropagation αλγόριθμους, αφού, η σειρά της χρονοκαθυστέρησης στην είσοδο, μπορεί να αντικατασταθεί με ένα άνυσμα με στοιχεία τις καθυστερημένες τιμές εισόδου. Επιλογή Αρχιτεκτονικής ΝΝ

83 Prediction (Πρόβλεψη) Επιλογή Αρχιτεκτονικής ΝΝ Focused TDNN

84 Επιλογή Αρχιτεκτονικής ΝΝ Prediction (Πρόβλεψη) Για προβλήματα ελέγχου δυναμικών συστημάτων, είναι δημοφιλές το δίκτυο NARX (Nonlinear AutoRegressive model with exogenous input). NARX Neural Network

85 Επιλογή Αρχιτεκτονικής ΝΝ Prediction (Πρόβλεψη) Το σήμα εισόδου μπορεί να είναι η τάση που εφαρμόζεται στο μοτέρ και η έξοδος η γωνιακή θέση του ρομποτικού βραχίονα. Όπως και στο TDNN, το NARX μπορεί να εκπαιδευτεί με στατικό backpropagation αλγόριθμο. Μπορούμε να χρησιμοποιήσουμε στόχους, αντί να επανατροφοδοτήσουμε με τις εξόδους του ΝΝ (πράγμα που απαιτεί δυναμικό backpropagation για την εκπαίδευση), γιατί η έξοδος του ΝΝ πρέπει να βρίσκει τους στόχους όταν η εκπαίδευση είναι πλήρης. Υπάρχουν κι άλλα δυναμικά ΝΝ πιο πολύπλοκα.

86 Επιλογή Αρχιτεκτονικής ΝΝ Επιλογή στρωμάτων (layers) στα ΝΝ Αφού αρχικά έχει επιλεγεί ο τύπος του ΝΝ, στην συνέχεια επιλέγουμε τα ειδικότερα στοιχεία του (π.χ. αριθμός στρωμάτων, αριθμός νευρώνων, κ.λ.π.). Σε μερικές περιπτώσεις ο αριθμός των στρωμάτων προκύπτει αυτόματα με την επιλογή του τύπου του ΝΝ. Στο SOFM (self-organizing feature map) π.χ. που χρησιμοποιείται για ομαδοποίηση θα έχουμε ένα στρώμα.

87 Επιλογή Αρχιτεκτονικής ΝΝ Επιλογή στρωμάτων (layers) στα ΝΝ Στα MLP που χρησιμοποιούνται για fitting ή pattern recognition, ο αριθμός των κρυφών στρωμάτων δεν ορίζεται από τον τύπο του ΝΝ αλλά μπορεί να είναι οποιοσδήποτε. Συνήθως αρχίζουμε με 1 στρώμα και μπορούμε να συνεχίσουμε στα 2 ή 3, βλέποντας, ανάλογα με την επίδοση. Συνήθως δεν πάμε πέρα από τα 2 κρυφά στρώματα, γιατί η εκπαίδευση του ΝΝ γίνεται πιο δύσκολη και βέβαια υπάρχει και το θέμα του χρόνου εκπαίδευσης, που πρέπει να βρίσκεται μέσα σε λογικά πλαίσια.

88 Επιλογή Αρχιτεκτονικής ΝΝ Επιλογή αριθμού νευρώνων σε κάθε στρώμα Στο στρώμα εξόδου, ο αριθμός των νευρώνων ισούται φυσικά με το μέγεθος του ανύσματος στόχου και της ενδεχόμενης κωδικοποίησης που έχουμε κάνει. Ο αριθμός των νευρώνων στα κρυφά στρώματα καθορίζεται από την πολυπλοκότητα της συνάρτησης που έχουμε να προσεγγίσουμε (fitting). Καθώς όμως δεν γνωρίζουμε την πολυπλοκότητα του προβλήματος (πριν την εκπαίδευση), συνήθως αρχίζουμε με περισσότερους νευρώνες -από όσοι είναι απαραίτητοι- και κάνουμε πρόωρη παύση στην εκπαίδευση, ή ρύθμιση Bayesian, για να προλάβουμε το overfitting.

89 Επιλογή Αρχιτεκτονικής ΝΝ Επιλογή αριθμού νευρώνων σε κάθε στρώμα Εάν μετά την εκπαίδευση ο ενεργός αριθμός των παραμέτρων είναι αρκετά μικρότερος του συνολικού αριθμού των παραμέτρων, τότε μπορούμε να ελαττώσουμε τον αριθμό των νευρώνων και να ξαναεκπαιδεύσουμε το ΝΝ. Μπορούμε επίσης να χρησιμοποιήσουμε μεθόδους pruning (κλάδεμα) για να καταργήσουμε νευρώνες ή βάρη.

90 Εκπαιδεύοντας το ΝΝ Αρχικοποίηση των βαρών Για τα MLP συνήθως βάζουμε τα βάρη σε μικρές τυχαίες τιμές, με ομοιόμορφη κατανομή, μεταξύ -0.5 και 0.5, αν οι είσοδοι έχουν κανονικοποιηθεί μεταξύ -1 και 1. Αν βάλουμε πολύ μικρές (ή πολύ μεγάλες) αρχικές τιμές, ενδέχεται να πέσουμε σε τοπικό ελάχιστο (ή σε «πλάτωμα»), κατά την εκπαίδευση, που οφείλονται στον κορεσμό των σιγμοειδών συναρτήσεων. Υπάρχουν κι άλλες -πιο προχωρημένες- μέθοδοι αρχικοποίησης των βαρών και των πολώσεων για ΝΝ.

91 Εκπαιδεύοντας το ΝΝ Επιλογή Αλγορίθμου εκπαίδευσης Στα MLP χρησιμοποιούμε αλγορίθμους gradient (που βασίζονται στον ρυθμό μεταβολής του σφάλματος) ή Jacobian. Για τα MLP που έχουν μερικές εκατοντάδες βάρη και πολώσεις και χρησιμοποιούνται για fitting, πιο γρήγορος είναι ο αλγόριθμος εκπαίδευσης Levenberg- Marquardt. Για μεγαλύτερα ΝΝ, πιο αποτελεσματικός είναι ο αλγόριθμος Scaled Conjugate Gradient. Τα ίδια περίπου ισχύουν και για τα ΝΝ που χρησιμοποιούνται για pattern recognition. Υπάρχουν κι άλλοι πολλοί αλγόριθμοι που είναι περισσότερο ειδικού σκοπού.

92 Εκπαιδεύοντας το ΝΝ Κριτήρια Παύσης Εκπαίδευσης Το σφάλμα εκπαίδευσης στα ΝΝ είναι σχεδόν αδύνατο να μηδενιστεί. Αυτό μπορεί να γίνει στο Perceptron αλλά στα MLP δεν μπορεί να συμβεί. Έτσι χρειάζονται άλλα κριτήρια. Το πιο απλό είναι να ορίσουμε ένα κατώφλι για το σφάλμα. Καθώς όμως δεν είναι εύκολα προβλέψιμο για το πότε θα φθάσουμε και αν φτάσουμε- εκεί, είναι πιο λογικό να ορίσουμε έναν αριθμό εποχών εκπαίδευσης ως τέρμα. Ο αριθμός αυτός συνήθως ορίζεται να είναι σχετικά μεγάλος.

93 Εκπαιδεύοντας το ΝΝ Κριτήρια Παύσης Εκπαίδευσης Εάν στο τέλος των εποχών το ΝΝ δεν καταφέρει να φτάσει στο επιθυμητό σφάλμα, μπορούμε να το ξαναεκπαιδεύσουμε ακόμα μία φορά, έχοντας ως αρχικές τιμές των βαρών, αυτές που πέτυχε η 1 η εκπαίδευση. Ένα άλλο κριτήριο παύσης είναι να θέσουμε ένα όριο για την μεταβολή του gradient, που όταν επιτυγχάνεται να σταματάει η εκπαίδευση. Έτσι πλησιάζουμε αρκετά στο minimum, καθώς, όταν το όριο μηδενίζεται δεν έχουμε πια μεταβολές στα βάρη. Το πρόβλημα εδώ είναι τα σημεία όπου έχουμε τοπικά ελάχιστα ή «πλατώματα», όπου το gradient μηδενίζεται.

94 Εκπαιδεύοντας το ΝΝ Κριτήρια Παύσης Εκπαίδευσης Γι αυτό πρέπει να θέσουμε πολύ χαμηλή τιμή (π.χ. για το MSE) ώστε η εκπαίδευση να μην σταματάει πρόωρα. Μπορούμε επίσης να σταματήσουμε την εκπαίδευση όταν πέφτει η επίδοση/εποχή. Όμως κι αυτό το κριτήριο μπορεί να σταματήσει την εκπαίδευση πριν την ώρα της. Κατά την εκπαίδευση του MLP μπορεί να έχουμε «πλάτωμα» για κάποιον αριθμό εποχών και μετά απότομη πτώση. Είναι χρήσιμο να μελετάται η καμπύλη log-log μετά το πέρας της εκπαίδευσης.

95 Εκπαιδεύοντας το ΝΝ

96 Εκπαιδεύοντας το ΝΝ Κριτήρια Παύσης Εκπαίδευσης Η εκπαίδευση του ΝΝ είναι μια επαναληπτική διαδικασία (όπως φαίνεται και στο μπλοκ διάγραμμα). Ακόμα όμως κι αν η εκπαίδευση έχει συγκλίνει στο minimum, μπορεί -με την εκ των υστέρων ανάλυση- να οδηγηθούμε σε αλλαγές στο ΝΝ και επανεκπαίδευση. Επιπροσθέτως, πρέπει η εκπαίδευση -σε κάθε ΝΝ- να γίνεται μερικές φορές -με διαφορετικό αριθμό εποχώνγια να εξασφαλίζεται πως φτάσαμε στο συνολικό ελάχιστο.

97 Εκπαιδεύοντας το ΝΝ Κριτήρια Παύσης Εκπαίδευσης Τα προηγούμενα κριτήρια παύσης αφορούν κυρίως την εκπαίδευση με gradient αλγορίθμους. Για τα ανταγωνιστικά ΝΝ (SOFM) δεν υπάρχει σαφής δείκτης επίδοσης για την σύγκλιση και η εκπαίδευση σταματάει όταν φτάσουμε στον προκαθορισμένο αριθμό εποχών. Ο ρυθμός εκμάθησης και η γειτονιά ελαττώνεται με τον χρόνο. Τυπικά η γειτονιά μειώνεται σε έναν νευρώνα στο τέλος της εκπαίδευσης. Έτσι ο μέγιστος αριθμός εποχών ορίζει το τέλος της εκπαίδευσης όσο την ορίζει και η ελάττωση της γειτονιάς ή η ελάττωση του ρυθμού εκμάθησης.

98 Εκπαιδεύοντας το ΝΝ Κριτήρια Παύσης Εκπαίδευσης Ο αριθμός των εποχών εκπαίδευσης είναι μια σημαντική παράμετρος. Συνήθως ορίζεται περίπου δεκαπλάσιος από των αριθμό των νευρώνων του ΝΝ. Το ΝΝ πρέπει να αναλυθεί με το τέλος της εκπαίδευσης για να δούμε αν έχει καλή επίδοση.

Μάθηση και Γενίκευση. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP)

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Το μοντέλο Perceptron

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Το Πολυεπίπεδο Perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

Υπολογιστική Νοημοσύνη. Μάθημα 9: Γενίκευση

Υπολογιστική Νοημοσύνη Μάθημα 9: Γενίκευση Υπερπροσαρμογή (Overfitting) Ένα από τα βασικά προβλήματα που μπορεί να εμφανιστεί κατά την εκπαίδευση νευρωνικών δικτύων είναι αυτό της υπερβολικής εκπαίδευσης.

Υπολογιστική Νοημοσύνη Μάθημα 9: Γενίκευση Υπερπροσαρμογή (Overfitting) Ένα από τα βασικά προβλήματα που μπορεί να εμφανιστεί κατά την εκπαίδευση νευρωνικών δικτύων είναι αυτό της υπερβολικής εκπαίδευσης.

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 15-16

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 26 Ιανουαρίου 2004 ιάρκεια: 2 ώρες (9:00-:00) Στην παρακάτω

ΘΕΜΑ ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 26 Ιανουαρίου 2004 ιάρκεια: 2 ώρες (9:00-:00) Στην παρακάτω

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Τεχνητά Νευρωνικά Δίκτυα. Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης

Τεχνητά Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης Ο Βιολογικός Νευρώνας Δενδρίτες Συνάψεις Πυρήνας (Σώμα) Άξονας 2 Ο Βιολογικός Νευρώνας 3 Βασικά Χαρακτηριστικά

Τεχνητά Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης Ο Βιολογικός Νευρώνας Δενδρίτες Συνάψεις Πυρήνας (Σώμα) Άξονας 2 Ο Βιολογικός Νευρώνας 3 Βασικά Χαρακτηριστικά

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων. Δρ. Ε. Χάρου

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων Δρ. Ε. Χάρου Πρόγραμμα υπολογιστικής ευφυίας Ινστιτούτο Πληροφορικής & Τηλεπικοινωνιών ΕΚΕΦΕ ΔΗΜΟΚΡΙΤΟΣ exarou@iit.demokritos.gr Μηχανική

Μέθοδοι Μηχανικής Μάθησης στην επεξεργασία Τηλεπισκοπικών Δεδομένων Δρ. Ε. Χάρου Πρόγραμμα υπολογιστικής ευφυίας Ινστιτούτο Πληροφορικής & Τηλεπικοινωνιών ΕΚΕΦΕ ΔΗΜΟΚΡΙΤΟΣ exarou@iit.demokritos.gr Μηχανική

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 3 Επιλογή μοντέλου Επιλογή μοντέλου Θεωρία αποφάσεων Επιλογή μοντέλου δεδομένα επικύρωσης Η επιλογή του είδους του μοντέλου που θα χρησιμοποιηθεί σε ένα πρόβλημα (π.χ.

HMY 795: Αναγνώριση Προτύπων Διάλεξη 3 Επιλογή μοντέλου Επιλογή μοντέλου Θεωρία αποφάσεων Επιλογή μοντέλου δεδομένα επικύρωσης Η επιλογή του είδους του μοντέλου που θα χρησιμοποιηθεί σε ένα πρόβλημα (π.χ.

ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ. Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα. Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε.

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες Χρήσης Το

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες Χρήσης Το

ΔΙΚΤΥO RBF. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

Υπερπροσαρμογή (Overfitting) (1)

Αλγόριθμος C4.5 Αποφυγή υπερπροσαρμογής (overfitting) Reduced error pruning Rule post-pruning Χειρισμός χαρακτηριστικών συνεχών τιμών Επιλογή κατάλληλης μετρικής για την επιλογή των χαρακτηριστικών διάσπασης

Αλγόριθμος C4.5 Αποφυγή υπερπροσαρμογής (overfitting) Reduced error pruning Rule post-pruning Χειρισμός χαρακτηριστικών συνεχών τιμών Επιλογή κατάλληλης μετρικής για την επιλογή των χαρακτηριστικών διάσπασης

Τεχνικές Μείωσης Διαστάσεων. Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D.

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: βελτιστοποίηση χωρίς περιορισμούς Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών ΤμήμαΠληροφορικής Διάλεξη 7-8 η /2017 Τι παρουσιάστηκε

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: βελτιστοποίηση χωρίς περιορισμούς Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών ΤμήμαΠληροφορικής Διάλεξη 7-8 η /2017 Τι παρουσιάστηκε

Τεχνητή Νοημοσύνη. 18η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

LOGO. Εξόρυξη Δεδομένων. Δειγματοληψία. Πίνακες συνάφειας. Καμπύλες ROC και AUC. Σύγκριση Μεθόδων Εξόρυξης

Εξόρυξη Δεδομένων Δειγματοληψία Πίνακες συνάφειας Καμπύλες ROC και AUC Σύγκριση Μεθόδων Εξόρυξης Πασχάλης Θρήσκος PhD Λάρισα 2016-2017 pthriskos@mnec.gr LOGO Συμπερισματολογία - Τι σημαίνει ; Πληθυσμός

Εξόρυξη Δεδομένων Δειγματοληψία Πίνακες συνάφειας Καμπύλες ROC και AUC Σύγκριση Μεθόδων Εξόρυξης Πασχάλης Θρήσκος PhD Λάρισα 2016-2017 pthriskos@mnec.gr LOGO Συμπερισματολογία - Τι σημαίνει ; Πληθυσμός

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ

ΘΕΜΑ 1 ο (2,5 μονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Τελικές εξετάσεις Πέμπτη 21 Ιουνίου 2012 16:30-19:30 Υποθέστε ότι θέλουμε

ΘΕΜΑ 1 ο (2,5 μονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Τελικές εξετάσεις Πέμπτη 21 Ιουνίου 2012 16:30-19:30 Υποθέστε ότι θέλουμε

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 2: Δομικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 2: Δομικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 17 18 Νευρωνικά Δίκτυα (Neural Networks) συνέχεια Minimum squared error procedure for classification 1 ( T T wls = X X) X b= X b Xw = b Logistic sigmoidal function

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 17 18 Νευρωνικά Δίκτυα (Neural Networks) συνέχεια Minimum squared error procedure for classification 1 ( T T wls = X X) X b= X b Xw = b Logistic sigmoidal function

ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM Μάθηση χωρίς επίβλεψη (unsupervised learning) Σύνολο εκπαίδευσης D={(x n )}, n=1,,n. x n =(x n1,, x nd ) T, δεν υπάρχουν τιμές-στόχοι t n. Προβλήματα μάθησης χωρίς

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM Μάθηση χωρίς επίβλεψη (unsupervised learning) Σύνολο εκπαίδευσης D={(x n )}, n=1,,n. x n =(x n1,, x nd ) T, δεν υπάρχουν τιμές-στόχοι t n. Προβλήματα μάθησης χωρίς

Νευρωνικά ίκτυα και Εξελικτικός. Σηµερινό Μάθηµα. επανάληψη Γενετικών Αλγορίθµων 1 η εργασία Επανάληψη νευρωνικών δικτύων Ασκήσεις εφαρµογές

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα επανάληψη Γενετικών Αλγορίθµων η εργασία Επανάληψη νευρωνικών δικτύων Ασκήσεις εφαρµογές Κωδικοποίηση Αντικειµενική Συνάρτ Αρχικοποίηση Αξιολόγηση

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα επανάληψη Γενετικών Αλγορίθµων η εργασία Επανάληψη νευρωνικών δικτύων Ασκήσεις εφαρµογές Κωδικοποίηση Αντικειµενική Συνάρτ Αρχικοποίηση Αξιολόγηση

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

Μεταπτυχιακό Πρόγραμμα «Γεωχωρικές Τεχνολογίες» Ψηφιακή Επεξεργασία Εικόνας. Εισηγητής Αναστάσιος Κεσίδης

Μεταπτυχιακό Πρόγραμμα «Γεωχωρικές Τεχνολογίες» Ψηφιακή Επεξεργασία Εικόνας Εισηγητής Αναστάσιος Κεσίδης Τμηματοποίηση εικόνας Τμηματοποίηση εικόνας Γενικά Διαμερισμός μιας εικόνας σε διακριτές περιοχές

Μεταπτυχιακό Πρόγραμμα «Γεωχωρικές Τεχνολογίες» Ψηφιακή Επεξεργασία Εικόνας Εισηγητής Αναστάσιος Κεσίδης Τμηματοποίηση εικόνας Τμηματοποίηση εικόνας Γενικά Διαμερισμός μιας εικόνας σε διακριτές περιοχές

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος Χιωτίδης Γεώργιος Τμήμα Λογιστικής και Χρηματοοικονομικής Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος Χιωτίδης Γεώργιος Τμήμα Λογιστικής και Χρηματοοικονομικής Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

6. Στατιστικές μέθοδοι εκπαίδευσης

6. Στατιστικές μέθοδοι εκπαίδευσης Μία διαφορετική μέθοδος εκπαίδευσης των νευρωνικών δικτύων χρησιμοποιεί ιδέες από την Στατιστική Φυσική για να φέρει τελικά το ίδιο αποτέλεσμα όπως οι άλλες μέθοδοι,

6. Στατιστικές μέθοδοι εκπαίδευσης Μία διαφορετική μέθοδος εκπαίδευσης των νευρωνικών δικτύων χρησιμοποιεί ιδέες από την Στατιστική Φυσική για να φέρει τελικά το ίδιο αποτέλεσμα όπως οι άλλες μέθοδοι,

Μηχανική Μάθηση: γιατί;

Μηχανική Μάθηση Μηχανική Μάθηση: γιατί; Απαραίτητη για να μπορεί ο πράκτορας να ανταπεξέρχεται σε άγνωστα περιβάλλοντα Δεν είναι δυνατόν ο σχεδιαστής να προβλέψει όλα τα ενδεχόμενα περιβάλλοντα. Χρήσιμη

Μηχανική Μάθηση Μηχανική Μάθηση: γιατί; Απαραίτητη για να μπορεί ο πράκτορας να ανταπεξέρχεται σε άγνωστα περιβάλλοντα Δεν είναι δυνατόν ο σχεδιαστής να προβλέψει όλα τα ενδεχόμενα περιβάλλοντα. Χρήσιμη

Διδάσκουσα: Χάλκου Χαρά,

Διδάσκουσα: Χάλκου Χαρά, Διπλωματούχος Ηλεκτρολόγος Μηχανικός & Τεχνολογίας Η/Υ, MSc e-mail: chalkou@upatras.gr Επιβλεπόμενοι Μη Επιβλεπόμενοι Ομάδα Κατηγορία Κανονικοποίηση Δεδομένων Συμπλήρωση Ελλιπών

Διδάσκουσα: Χάλκου Χαρά, Διπλωματούχος Ηλεκτρολόγος Μηχανικός & Τεχνολογίας Η/Υ, MSc e-mail: chalkou@upatras.gr Επιβλεπόμενοι Μη Επιβλεπόμενοι Ομάδα Κατηγορία Κανονικοποίηση Δεδομένων Συμπλήρωση Ελλιπών

Πληροφοριακά Συστήματα Διοίκησης

Πληροφοριακά Συστήματα Διοίκησης Τρεις αλγόριθμοι μηχανικής μάθησης ΠΜΣ Λογιστική Χρηματοοικονομική και Διοικητική Επιστήμη ΤΕΙ Ηπείρου @ 2018 Μηχανική μάθηση αναγνώριση προτύπων Η αναγνώριση προτύπων

Πληροφοριακά Συστήματα Διοίκησης Τρεις αλγόριθμοι μηχανικής μάθησης ΠΜΣ Λογιστική Χρηματοοικονομική και Διοικητική Επιστήμη ΤΕΙ Ηπείρου @ 2018 Μηχανική μάθηση αναγνώριση προτύπων Η αναγνώριση προτύπων

ΧΑΡΟΚΟΠΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΤΗΛΕΜΑΤΙΚΗΣ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ. Καραγιώργου Σοφία

ΧΑΡΟΚΟΠΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΤΗΛΕΜΑΤΙΚΗΣ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Καραγιώργου Σοφία Εισαγωγή Προσομοιώνει βιολογικές διεργασίες (π.χ. λειτουργία του εγκεφάλου, διαδικασία

ΧΑΡΟΚΟΠΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΤΗΛΕΜΑΤΙΚΗΣ ΤΕΧΝΗΤΗ ΝΟΗΜΟΣΥΝΗ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Καραγιώργου Σοφία Εισαγωγή Προσομοιώνει βιολογικές διεργασίες (π.χ. λειτουργία του εγκεφάλου, διαδικασία

Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων»

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Νευρωνικά Δίκτυα στο Matlab

Νευρωνικά Δίκτυα στο Matlab Ρ202 Μηχανική Ευφυΐα (Machine Intelligence) Ευστάθιος Αντωνίου Τμήμα Μηχανικών Πληροφορικής Αλεξάνδρειο ΤΕΙ Θεσσαλονίκης E-mail: antoniou@itteithegr Πρόγραμμα Μεταπτυχιακών

Νευρωνικά Δίκτυα στο Matlab Ρ202 Μηχανική Ευφυΐα (Machine Intelligence) Ευστάθιος Αντωνίου Τμήμα Μηχανικών Πληροφορικής Αλεξάνδρειο ΤΕΙ Θεσσαλονίκης E-mail: antoniou@itteithegr Πρόγραμμα Μεταπτυχιακών

Αντικείμενο του κεφαλαίου είναι: Ανάλυση συσχέτισης μεταξύ δύο μεταβλητών. Εξίσωση παλινδρόμησης. Πρόβλεψη εξέλιξης

Γραμμική Παλινδρόμηση και Συσχέτιση Αντικείμενο του κεφαλαίου είναι: Ανάλυση συσχέτισης μεταξύ δύο μεταβλητών Εξίσωση παλινδρόμησης Πρόβλεψη εξέλιξης Διμεταβλητές συσχετίσεις Πολλές φορές χρειάζεται να

Γραμμική Παλινδρόμηση και Συσχέτιση Αντικείμενο του κεφαλαίου είναι: Ανάλυση συσχέτισης μεταξύ δύο μεταβλητών Εξίσωση παλινδρόμησης Πρόβλεψη εξέλιξης Διμεταβλητές συσχετίσεις Πολλές φορές χρειάζεται να

Εισαγωγή στα Τεχνητά Νευρωνικά Δίκτυα. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Εισαγωγή στα Τεχνητά Νευρωνικά Δίκτυα Τεχνητή Νοημοσύνη (Artificial Intelligence) Ανάπτυξη μεθόδων και τεχνολογιών για την επίλυση προβλημάτων στα οποία ο άνθρωπος υπερέχει (?) του υπολογιστή Συλλογισμοί

Εισαγωγή στα Τεχνητά Νευρωνικά Δίκτυα Τεχνητή Νοημοσύνη (Artificial Intelligence) Ανάπτυξη μεθόδων και τεχνολογιών για την επίλυση προβλημάτων στα οποία ο άνθρωπος υπερέχει (?) του υπολογιστή Συλλογισμοί

Μεταπτυχιακό Πρόγραμμα «Γεωχωρικές Τεχνολογίες» Ψηφιακή Επεξεργασία Εικόνας. Εισηγητής Αναστάσιος Κεσίδης

Μεταπτυχιακό Πρόγραμμα «Γεωχωρικές Τεχνολογίες» Ψηφιακή Επεξεργασία Εικόνας Εισηγητής Αναστάσιος Κεσίδης Χωρικά φίλτρα Χωρικά φίλτρα Γενικά Σε αντίθεση με τις σημειακές πράξεις και μετασχηματισμούς, στα

Μεταπτυχιακό Πρόγραμμα «Γεωχωρικές Τεχνολογίες» Ψηφιακή Επεξεργασία Εικόνας Εισηγητής Αναστάσιος Κεσίδης Χωρικά φίλτρα Χωρικά φίλτρα Γενικά Σε αντίθεση με τις σημειακές πράξεις και μετασχηματισμούς, στα

Τεχνητή Νοημοσύνη. 17η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 17η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Artificia Inteigence A Modern Approach των S. Russe και

Τεχνητή Νοημοσύνη 17η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Artificia Inteigence A Modern Approach των S. Russe και

Απλή Γραμμική Παλινδρόμηση και Συσχέτιση 19/5/2017

Απλή Γραμμική Παλινδρόμηση και Συσχέτιση 2 Εισαγωγή Η ανάλυση παλινδρόμησης περιλαμβάνει το σύνολο των μεθόδων της στατιστικής που αναφέρονται σε ποσοτικές σχέσεις μεταξύ μεταβλητών Πρότυπα παλινδρόμησης

Απλή Γραμμική Παλινδρόμηση και Συσχέτιση 2 Εισαγωγή Η ανάλυση παλινδρόμησης περιλαμβάνει το σύνολο των μεθόδων της στατιστικής που αναφέρονται σε ποσοτικές σχέσεις μεταξύ μεταβλητών Πρότυπα παλινδρόμησης

Μη γραµµικοί ταξινοµητές Νευρωνικά ίκτυα

KEΣ 3 Αναγνώριση Προτύπων και Ανάλυση Εικόνας Μη γραµµικοί ταξινοµητές Νευρωνικά ίκτυα ΤµήµαΕπιστήµης και Τεχνολογίας Τηλεπικοινωνιών Πανεπιστήµιο Πελοποννήσου Εισαγωγή Πολυεπίπεδες Perceptron Οαλγόριθµος

KEΣ 3 Αναγνώριση Προτύπων και Ανάλυση Εικόνας Μη γραµµικοί ταξινοµητές Νευρωνικά ίκτυα ΤµήµαΕπιστήµης και Τεχνολογίας Τηλεπικοινωνιών Πανεπιστήµιο Πελοποννήσου Εισαγωγή Πολυεπίπεδες Perceptron Οαλγόριθµος

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Ασκήσεις μελέτης της 19 ης διάλεξης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ Ενότητα: Αναγνώριση Διεργασίας - Προσαρμοστικός Έλεγχος (Process Identification) Αλαφοδήμος Κωνσταντίνος

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ Ενότητα: Αναγνώριση Διεργασίας - Προσαρμοστικός Έλεγχος (Process Identification) Αλαφοδήμος Κωνσταντίνος

Είδη Διορθωτών: Υπάρχουν πολλών ειδών διορθωτές. Μία βασική ταξινόμησή τους είναι οι «Ειδικοί Διορθωτές» και οι «Κλασσικοί Διορθωτές».

ΔΙΟΡΘΩΣΗ ΣΑΕ Είδη Διορθωτών: Οι Διορθωτές έχουν την δική τους (Σ.Μ). Ενσωματώνονται στον βρόχο του ΣΑΕ και δρουν πάνω στην αρχική Σ.Μ κατά τρόπο ώστε να της προσδώσουν την επιθυμητή συμπεριφορά, την οποία

ΔΙΟΡΘΩΣΗ ΣΑΕ Είδη Διορθωτών: Οι Διορθωτές έχουν την δική τους (Σ.Μ). Ενσωματώνονται στον βρόχο του ΣΑΕ και δρουν πάνω στην αρχική Σ.Μ κατά τρόπο ώστε να της προσδώσουν την επιθυμητή συμπεριφορά, την οποία

5. ΤΟ ΓΕΝΙΚΟ ΓΡΑΜΜΙΚΟ ΜΟΝΤΕΛΟ (GENERAL LINEAR MODEL) 5.1 Εναλλακτικά μοντέλα του απλού γραμμικού μοντέλου: Το εκθετικό μοντέλο

5. ΤΟ ΓΕΝΙΚΟ ΓΡΑΜΜΙΚΟ ΜΟΝΤΕΛΟ (GENERAL LINEAR MODEL) 5.1 Εναλλακτικά μοντέλα του απλού γραμμικού μοντέλου: Το εκθετικό μοντέλο Ένα εναλλακτικό μοντέλο της απλής γραμμικής παλινδρόμησης (που χρησιμοποιήθηκε

5. ΤΟ ΓΕΝΙΚΟ ΓΡΑΜΜΙΚΟ ΜΟΝΤΕΛΟ (GENERAL LINEAR MODEL) 5.1 Εναλλακτικά μοντέλα του απλού γραμμικού μοντέλου: Το εκθετικό μοντέλο Ένα εναλλακτικό μοντέλο της απλής γραμμικής παλινδρόμησης (που χρησιμοποιήθηκε

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Component Analysis, PCA)

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΠΑΡΟΥΣΙΑΣΗ ΣΤΑΤΙΣΤΙΚΩΝ ΔΕΔΟΜΕΝΩΝ

ο Κεφάλαιο: Στατιστική ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ ΚΑΙ ΟΡΙΣΜΟΙ ΣΤΗ ΣΤΑΤΙΣΤΙΚΗ ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ Πληθυσμός: Λέγεται ένα σύνολο στοιχείων που θέλουμε να εξετάσουμε με ένα ή περισσότερα χαρακτηριστικά. Μεταβλητές X: Ονομάζονται

ο Κεφάλαιο: Στατιστική ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ ΚΑΙ ΟΡΙΣΜΟΙ ΣΤΗ ΣΤΑΤΙΣΤΙΚΗ ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ Πληθυσμός: Λέγεται ένα σύνολο στοιχείων που θέλουμε να εξετάσουμε με ένα ή περισσότερα χαρακτηριστικά. Μεταβλητές X: Ονομάζονται

Οι Εξελικτικοί Αλγόριθμοι (ΕΑ) είναι καθολικοί στοχαστικοί αλγόριθμοι βελτιστοποίησης, εμπνευσμένοι από τις βασικές αρχές της φυσικής εξέλιξης.

Οι Εξελικτικοί Αλγόριθμοι (ΕΑ) είναι καθολικοί στοχαστικοί αλγόριθμοι βελτιστοποίησης, εμπνευσμένοι από τις βασικές αρχές της φυσικής εξέλιξης. Ένα από τα γνωστότερα παραδείγματα των ΕΑ είναι ο Γενετικός

Οι Εξελικτικοί Αλγόριθμοι (ΕΑ) είναι καθολικοί στοχαστικοί αλγόριθμοι βελτιστοποίησης, εμπνευσμένοι από τις βασικές αρχές της φυσικής εξέλιξης. Ένα από τα γνωστότερα παραδείγματα των ΕΑ είναι ο Γενετικός

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 5 o Φροντιστήριο

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Σ ΤΑΤ Ι Σ Τ Ι Κ Η. Statisticum collegium iv

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium iv Στατιστική Συμπερασματολογία Ι Σημειακές Εκτιμήσεις Διαστήματα Εμπιστοσύνης Στατιστική Συμπερασματολογία (Statistical Inference) Το πεδίο της Στατιστικής Συμπερασματολογία,

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium iv Στατιστική Συμπερασματολογία Ι Σημειακές Εκτιμήσεις Διαστήματα Εμπιστοσύνης Στατιστική Συμπερασματολογία (Statistical Inference) Το πεδίο της Στατιστικής Συμπερασματολογία,

ΣΥΝΘΕΤΑ ΜΟΝΤΕΛΑ. Αριθμητικός Μέσος Εξομάλυνση Μοντελοποίηση. Συνδυασμός κάποιου μοντέλου και εξομάλυνσης. Διαχείριση Πληροφοριών 10.

ΣΥΝΘΕΤΑ ΜΟΝΤΕΛΑ Αριθμητικός Μέσος Εξομάλυνση Μοντελοποίηση Συνδυασμός κάποιου μοντέλου και εξομάλυνσης 10.1 ΑΡΙΘΜΗΤΙΚΟΣ ΜΕΣΟΣ Βασική έννοια στη Στατιστική Σημαντική για την κατανόηση προβλέψεων που βασίζονται

ΣΥΝΘΕΤΑ ΜΟΝΤΕΛΑ Αριθμητικός Μέσος Εξομάλυνση Μοντελοποίηση Συνδυασμός κάποιου μοντέλου και εξομάλυνσης 10.1 ΑΡΙΘΜΗΤΙΚΟΣ ΜΕΣΟΣ Βασική έννοια στη Στατιστική Σημαντική για την κατανόηση προβλέψεων που βασίζονται

Υπολογιστική Νοημοσύνη. Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ Βασίλης Δ. Ανδριτσάνος Δρ. Αγρονόμος - Τοπογράφος Μηχανικός ΑΠΘ Επίκουρος Καθηγητής ΤΕΙ Αθήνας 3ο εξάμηνο http://eclass.teiath.gr Παρουσιάσεις,

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ Βασίλης Δ. Ανδριτσάνος Δρ. Αγρονόμος - Τοπογράφος Μηχανικός ΑΠΘ Επίκουρος Καθηγητής ΤΕΙ Αθήνας 3ο εξάμηνο http://eclass.teiath.gr Παρουσιάσεις,

HMY 799 1: Αναγνώριση Συστημάτων

HMY 799 : Αναγνώριση Συστημάτων Διάλεξη Γραμμική παλινδρόμηση (Linear regression) Εμπειρική συνάρτηση μεταφοράς Ομαλοποίηση (smoothing) Y ( ) ( ) ω G ω = U ( ω) ω +Δ ω γ ω Δω = ω +Δω W ( ξ ω ) U ( ξ) G(

HMY 799 : Αναγνώριση Συστημάτων Διάλεξη Γραμμική παλινδρόμηση (Linear regression) Εμπειρική συνάρτηση μεταφοράς Ομαλοποίηση (smoothing) Y ( ) ( ) ω G ω = U ( ω) ω +Δ ω γ ω Δω = ω +Δω W ( ξ ω ) U ( ξ) G(

Μέρος Β /Στατιστική. Μέρος Β. Στατιστική. Γεωπονικό Πανεπιστήμιο Αθηνών Εργαστήριο Μαθηματικών&Στατιστικής/Γ. Παπαδόπουλος (www.aua.

Μέρος Β /Στατιστική Μέρος Β Στατιστική Γεωπονικό Πανεπιστήμιο Αθηνών Εργαστήριο Μαθηματικών&Στατιστικής/Γ. Παπαδόπουλος (www.aua.gr/gpapadopoulos) Από τις Πιθανότητες στη Στατιστική Στα προηγούμενα, στο

Μέρος Β /Στατιστική Μέρος Β Στατιστική Γεωπονικό Πανεπιστήμιο Αθηνών Εργαστήριο Μαθηματικών&Στατιστικής/Γ. Παπαδόπουλος (www.aua.gr/gpapadopoulos) Από τις Πιθανότητες στη Στατιστική Στα προηγούμενα, στο

ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΙΓΑΙΟΥ ΣΧΟΛΗ ΕΠΙΣΤΗΜΩΝ ΤΗΣ ΔΙΟΙΚΗΣΗΣ ΤΜΗΜΑ ΜΗΧΑΝΙΚΩΝ ΟΙΚΟΝΟΜΙΑΣ ΚΑΙ ΔΙΟΙΚΗΣΗΣ ΣΤΑΤΙΣΤΙΚΗ

ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΙΓΑΙΟΥ ΣΧΟΛΗ ΕΠΙΣΤΗΜΩΝ ΤΗΣ ΔΙΟΙΚΗΣΗΣ ΤΜΗΜΑ ΜΗΧΑΝΙΚΩΝ ΟΙΚΟΝΟΜΙΑΣ ΚΑΙ ΔΙΟΙΚΗΣΗΣ ΣΤΑΤΙΣΤΙΚΗ Ακαδ. Έτος 06-07 Διδάσκων: Βασίλης ΚΟΥΤΡΑΣ Λέκτορας v.koutras@fme.aegea.gr Τηλ: 7035468 Εκτίμηση Διαστήματος

ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΙΓΑΙΟΥ ΣΧΟΛΗ ΕΠΙΣΤΗΜΩΝ ΤΗΣ ΔΙΟΙΚΗΣΗΣ ΤΜΗΜΑ ΜΗΧΑΝΙΚΩΝ ΟΙΚΟΝΟΜΙΑΣ ΚΑΙ ΔΙΟΙΚΗΣΗΣ ΣΤΑΤΙΣΤΙΚΗ Ακαδ. Έτος 06-07 Διδάσκων: Βασίλης ΚΟΥΤΡΑΣ Λέκτορας v.koutras@fme.aegea.gr Τηλ: 7035468 Εκτίμηση Διαστήματος

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν.

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης Ελαχιστοποίηση συνάρτησης σφάλματος Εκπαίδευση ΤΝΔ: μπορεί να διατυπωθεί ως πρόβλημα ελαχιστοποίησης μιας συνάρτησης σφάλματος E(w)

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης Ελαχιστοποίηση συνάρτησης σφάλματος Εκπαίδευση ΤΝΔ: μπορεί να διατυπωθεί ως πρόβλημα ελαχιστοποίησης μιας συνάρτησης σφάλματος E(w)

Β Γραφικές παραστάσεις - Πρώτο γράφημα Σχεδιάζοντας το μήκος της σανίδας συναρτήσει των φάσεων της σελήνης μπορείτε να δείτε αν υπάρχει κάποιος συσχετισμός μεταξύ των μεγεθών. Ο συνήθης τρόπος γραφικής

Β Γραφικές παραστάσεις - Πρώτο γράφημα Σχεδιάζοντας το μήκος της σανίδας συναρτήσει των φάσεων της σελήνης μπορείτε να δείτε αν υπάρχει κάποιος συσχετισμός μεταξύ των μεγεθών. Ο συνήθης τρόπος γραφικής

Υπολογιστική Νοημοσύνη. Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning

Υπολογιστική Νοημοσύνη Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning Κεντρική ιδέα Τα παραδείγματα μάθησης παρουσιάζονται στο μηεκπαιδευμένο δίκτυο και υπολογίζονται οι έξοδοι. Για

Υπολογιστική Νοημοσύνη Μάθημα 6: Μάθηση με Οπισθοδιάδοση Σφάλματος Backpropagation Learning Κεντρική ιδέα Τα παραδείγματα μάθησης παρουσιάζονται στο μηεκπαιδευμένο δίκτυο και υπολογίζονται οι έξοδοι. Για

Ζητήματα ηήμ με τα δεδομένα

Ζητήματα ηήμ με τα δεδομένα Ποιότητα Απαλοιφή θορύβου Εντοπισμός ανωμαλιών λώ Ελλιπείς τιμές Μετασχηματισμός Κβάντωση Μείωση μεγέθους Γραμμών: ειγματοληψία Στηλών: Ιδιοδιανύσματα, Επιλογή χαρακτηριστικών

Ζητήματα ηήμ με τα δεδομένα Ποιότητα Απαλοιφή θορύβου Εντοπισμός ανωμαλιών λώ Ελλιπείς τιμές Μετασχηματισμός Κβάντωση Μείωση μεγέθους Γραμμών: ειγματοληψία Στηλών: Ιδιοδιανύσματα, Επιλογή χαρακτηριστικών

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ ΣΧΟΛΗ ΕΦΑΡΜΟΣΜΕΝΩΝ ΜΑΘΗΜΑΤΙΚΩΝ ΚΑΙ ΦΥΣΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΠΛΗΡΟΦΟΡΙΑΣ ΠΑΡΟΥΣΙΑΣΗ ΤΕΛΙΚΗΣ ΕΡΓΑΣΙΑΣ ΛΙΝΑ ΜΑΣΣΟΥ

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ ΣΧΟΛΗ ΕΦΑΡΜΟΣΜΕΝΩΝ ΜΑΘΗΜΑΤΙΚΩΝ ΚΑΙ ΦΥΣΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΑΛΓΟΡΙΘΜΟΙ ΕΞΟΡΥΞΗΣ ΠΛΗΡΟΦΟΡΙΑΣ ΠΑΡΟΥΣΙΑΣΗ ΤΕΛΙΚΗΣ ΕΡΓΑΣΙΑΣ ΛΙΝΑ ΜΑΣΣΟΥ Δ.Π.Μ.Σ: «Εφαρμοσμένες Μαθηματικές Επιστήμες» 2008

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ ΣΧΟΛΗ ΕΦΑΡΜΟΣΜΕΝΩΝ ΜΑΘΗΜΑΤΙΚΩΝ ΚΑΙ ΦΥΣΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΑΛΓΟΡΙΘΜΟΙ ΕΞΟΡΥΞΗΣ ΠΛΗΡΟΦΟΡΙΑΣ ΠΑΡΟΥΣΙΑΣΗ ΤΕΛΙΚΗΣ ΕΡΓΑΣΙΑΣ ΛΙΝΑ ΜΑΣΣΟΥ Δ.Π.Μ.Σ: «Εφαρμοσμένες Μαθηματικές Επιστήμες» 2008

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 4 o Φροντιστήριο

Ασκήσεις Φροντιστηρίου 4 o Φροντιστήριο Πρόβλημα 1 ο Ο πίνακας συσχέτισης R x του διανύσματος εισόδου x( στον LMS αλγόριθμο 1 0.5 R x = ορίζεται ως: 0.5 1. Ορίστε το διάστημα των τιμών της παραμέτρου μάθησης

Ασκήσεις Φροντιστηρίου 4 o Φροντιστήριο Πρόβλημα 1 ο Ο πίνακας συσχέτισης R x του διανύσματος εισόδου x( στον LMS αλγόριθμο 1 0.5 R x = ορίζεται ως: 0.5 1. Ορίστε το διάστημα των τιμών της παραμέτρου μάθησης

Κινητά Δίκτυα Επικοινωνιών. Συμπληρωματικό υλικό. Προσαρμοστική Ισοστάθμιση Καναλιού

Κινητά Δίκτυα Επικοινωνιών Συμπληρωματικό υλικό Προσαρμοστική Ισοστάθμιση Καναλιού Προσαρμοστικοί Ισοσταθμιστές Για να υπολογίσουμε τους συντελεστές του ισοσταθμιστή MMSE, απαιτείται να λύσουμε ένα γραμμικό

Κινητά Δίκτυα Επικοινωνιών Συμπληρωματικό υλικό Προσαρμοστική Ισοστάθμιση Καναλιού Προσαρμοστικοί Ισοσταθμιστές Για να υπολογίσουμε τους συντελεστές του ισοσταθμιστή MMSE, απαιτείται να λύσουμε ένα γραμμικό

Αλγόριθμος Ομαδοποίησης

Αλγόριθμος Ομαδοποίησης Εμπειρίες από τη μελέτη αναλλοίωτων χαρακτηριστικών και ταξινομητών για συστήματα OCR Μορφονιός Κωνσταντίνος Αθήνα, Ιανουάριος 2002 Γενικά Ένα σύστημα OCR χρησιμοποιείται για την

Αλγόριθμος Ομαδοποίησης Εμπειρίες από τη μελέτη αναλλοίωτων χαρακτηριστικών και ταξινομητών για συστήματα OCR Μορφονιός Κωνσταντίνος Αθήνα, Ιανουάριος 2002 Γενικά Ένα σύστημα OCR χρησιμοποιείται για την

27-Ιαν-2009 ΗΜΥ 429. 2. (ι) Βασική στατιστική (ιι) Μετατροπές: αναλογικό-σεψηφιακό και ψηφιακό-σε-αναλογικό

ΗΜΥ 429 2. (ι) Βασική στατιστική (ιι) Μετατροπές: αναλογικό-σεψηφιακό και ψηφιακό-σε-αναλογικό 1 (i) Βασική στατιστική 2 Στατιστική Vs Πιθανότητες Στατιστική: επιτρέπει μέτρηση και αναγνώριση θορύβου και

ΗΜΥ 429 2. (ι) Βασική στατιστική (ιι) Μετατροπές: αναλογικό-σεψηφιακό και ψηφιακό-σε-αναλογικό 1 (i) Βασική στατιστική 2 Στατιστική Vs Πιθανότητες Στατιστική: επιτρέπει μέτρηση και αναγνώριση θορύβου και

Μέθοδοι μονοδιάστατης ελαχιστοποίησης

Βασικές αρχές μεθόδων ελαχιστοποίησης Μέθοδοι μονοδιάστατης ελαχιστοποίησης Οι μέθοδοι ελαχιστοποίησης είναι επαναληπτικές. Ξεκινώντας από μια αρχική προσέγγιση του ελαχίστου (την συμβολίζουμε ) παράγουν

Βασικές αρχές μεθόδων ελαχιστοποίησης Μέθοδοι μονοδιάστατης ελαχιστοποίησης Οι μέθοδοι ελαχιστοποίησης είναι επαναληπτικές. Ξεκινώντας από μια αρχική προσέγγιση του ελαχίστου (την συμβολίζουμε ) παράγουν

Συμπίεση Δεδομένων

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Άσκηση 5.1 Για ένα σήμα που έχει τη σ.π.π. του σχήματος να υπολογίσετε: μήκος του δυαδικού κώδικα για Ν επίπεδα κβάντισης για σταθερό μήκος λέξης;

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Άσκηση 5.1 Για ένα σήμα που έχει τη σ.π.π. του σχήματος να υπολογίσετε: μήκος του δυαδικού κώδικα για Ν επίπεδα κβάντισης για σταθερό μήκος λέξης;

Υπολογιστική Νοημοσύνη. Μάθημα 10: Ομαδοποίηση με Ανταγωνιστική Μάθηση - Δίκτυα Kohonen

Υπολογιστική Νοημοσύνη Μάθημα 10: Ομαδοποίηση με Ανταγωνιστική Μάθηση - Δίκτυα Kohonen Ανταγωνιστικοί Νευρώνες Ένα στρώμα με ανταγωνιστικούς νευρώνες λειτουργεί ως εξής: Όλοι οι νευρώνες δέχονται το σήμα

Υπολογιστική Νοημοσύνη Μάθημα 10: Ομαδοποίηση με Ανταγωνιστική Μάθηση - Δίκτυα Kohonen Ανταγωνιστικοί Νευρώνες Ένα στρώμα με ανταγωνιστικούς νευρώνες λειτουργεί ως εξής: Όλοι οι νευρώνες δέχονται το σήμα

Διακριτικές Συναρτήσεις

Διακριτικές Συναρτήσεις Δρ. Δηµήτριος Τσέλιος Επίκουρος Καθηγητής ΤΕΙ Θεσσαλίας Τµήµα Διοίκησης Επιχειρήσεων Θερµικός χάρτης των XYZ ξενοδοχείων σε σχέση µε τη γεωγραφική περιοχή τους P. Adamopoulos New

Διακριτικές Συναρτήσεις Δρ. Δηµήτριος Τσέλιος Επίκουρος Καθηγητής ΤΕΙ Θεσσαλίας Τµήµα Διοίκησης Επιχειρήσεων Θερµικός χάρτης των XYZ ξενοδοχείων σε σχέση µε τη γεωγραφική περιοχή τους P. Adamopoulos New

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 7 Ιανουαρίου 2005 ιάρκεια εξέτασης: 5:00-8:00 Έστω ότι

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 7 Ιανουαρίου 2005 ιάρκεια εξέτασης: 5:00-8:00 Έστω ότι

DIP_04 Σημειακή επεξεργασία. ΤΕΙ Κρήτης

DIP_04 Σημειακή επεξεργασία ΤΕΙ Κρήτης ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ ΕΙΚΟΝΑΣ Σκοπός μιας τέτοιας τεχνικής μπορεί να είναι: η βελτιστοποίηση της οπτικής εμφάνισης μιας εικόνας όπως την αντιλαμβάνεται ο άνθρωπος, η τροποποίηση

DIP_04 Σημειακή επεξεργασία ΤΕΙ Κρήτης ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ ΕΙΚΟΝΑΣ Σκοπός μιας τέτοιας τεχνικής μπορεί να είναι: η βελτιστοποίηση της οπτικής εμφάνισης μιας εικόνας όπως την αντιλαμβάνεται ο άνθρωπος, η τροποποίηση

Δειγματοληψία στην Ερευνα. Ετος

ΓΕΩΠΟΝΙΚΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ Τμήμα Αγροτικής Οικονομίας & Ανάπτυξης Μέθοδοι Γεωργοοικονομικής και Κοινωνιολογικής Ερευνας Δειγματοληψία στην Έρευνα (Μέθοδοι Δειγματοληψίας - Τρόποι Επιλογής Τυχαίου Δείγματος)

ΓΕΩΠΟΝΙΚΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΘΗΝΩΝ Τμήμα Αγροτικής Οικονομίας & Ανάπτυξης Μέθοδοι Γεωργοοικονομικής και Κοινωνιολογικής Ερευνας Δειγματοληψία στην Έρευνα (Μέθοδοι Δειγματοληψίας - Τρόποι Επιλογής Τυχαίου Δείγματος)

Μέθοδοι μονοδιάστατης ελαχιστοποίησης