Αναγνώριση Προσώπου Με Χρήση Πυρήνων. Παπαχαρίση Μαρίας

|

|

|

- Ἀσκληπιός Ζερβός

- 8 χρόνια πριν

- Προβολές:

Transcript

1 Αριστοτέλειο Πανεπστήμιο Θεσσαλονίκης Σχολή Θετικών Επιστημών Τμήμα Πληροφορικής Αναγνώριση Προσώπου Με Χρήση Πυρήνων Μεταπτυχιακή Διπλωματική εργασία της Παπαχαρίση Μαρίας επιβλέπων Καθηγητής Ι. Πήτας 2008

2

3 Ευχαριστώ ιδιαίτερα τον κ. Ι. Πήτα για τη συνεργασία, τον λέκτορα Α. Τέφα και τον μεταδιδακτορικό συνεργάτη Στ. Ζαφειρίου για την σημαντική συμβολή τους στην ολοκλήρωση αυτής της εργασίας καθώς και όλα τα μέλη του εργαστηρίου.

4 Απόσπασμα Η εργασία αυτή, που εκπονήθηκε στα πλαίσια του μεταπτυχιακού κύκλου σπουδών του τμήματος Πληροφορικής του Α.Π.Θ., έχει ως αντικείμενο την μελέτη και ανάπτυξη τεχνικών για αναγνώριση προσώπου. Πιο συγκεκριμένα, ασχολείται με την εφαρμογή πυρήνων (δηλ. οικογενειών συναρτήσεων), όπως οι πυρήνες Gabor, σε εικόνες προσώπων και την εξαγωγή χαρακτηριστικών από αυτές με τη χρήση της μεθόδου ανάλυσης σε πρωτεύουσες συνιστώσες (PCA). Τα δεδομένα είναι εικόνες προσώπων από μια βάση δεδομένων. Η όλη διαδικασία αποτελεί έναν μηχανισμό μάθησης χωρίς επίβλεψη.

5 ΠΕΡΙΕΧΟΜΕΝΑ ΕΝΟΤΗΤΑ 1: Θεωρητικό Υπόβαθρο 1. State Of The Art [6] [5] 2. Σύστημα Αναγνώρισης Προσώπου 3. Μείωση της διάστασης των δεδομένων αλγόριθμοι 4. Κατηγοριοποίηση 4.1. Linear classifiers Fisher's linear discriminant Logistic regression Bayes classifier Perceptron 4.2. Quadratic classifiers 4.3. K-πλησιέστερος γείτονας (k-nearest neighbour) 4.4. Boosting 4.5. Decision trees 4.6. Νευρωνικά δίκτυα 4.7. Bayesian δίκτυα 4.8. Κρυμμένα Μοντέλα Markov 4.9. Support vector machines (SVMs) Soft Margins Μη γραμμική κατηγοριοποίηση.

6 5. Supervised Learning 5.1. Support Vector Machines [ 4] Διασπορά ν-svms Υπολογισμός του κατωφλίου Γεωμετρική ερμηνεία 5.2. Kernel Fisher Discriminant 6. Unsupervised Learning [4] 6.1. kpca [4] 7. Μη γραμμικοί αλγόριθμοι στους χώρους των χαρακτηριστικών με χρήση πυρήνων [4] 8. Model Selection [4] 9. Gabor Πυρήνες [5] 10. Gabor feature representation [5]

7 ΕΝΟΤΗΤΑ 2: Εφαρμογή 1. Περιγραφή των δεδομένων 2. Μετασχηματισμοί 3. Kernel PCA 4. Αποστάσεις 5. PFA PFR [9] 6. Πειράματα Σύγκριση Αποτελεσμάτων Συμπεράσματα 7. Μελλοντική εργασία Αναφορές

8 ΕΝΟΤΗΤΑ 1: Θεωρητικό Υπόβαθρο 1. State Of The Art [6] [5] Τα τελευταία χρόνια, έχει προταθεί ένας μεγάλος αριθμός ισχυρών μηχανών μάθησης βασισμένων σε πυρήνες, όπως οι SVMs, KFD, kpca. Αυτές προσεγγίσεις παρουσιάζουν ιδιαίτερο πρακτικό ενδιαφέρον όχι μόνο για κατηγοριοποίηση δεδομένων (classification) αλλά κυρίως στις εφαρμογές που απαιτούν μάθηση χωρίς επίβλεψη. Τα ευσταθή σχήματα αναγνώρισης προσώπου απαιτούν η αναπαράσταση των δεδομένων με απώτερο σκοπό τη συμπίεσή τους να γίνεται όχι μόνο χρησιμοποιώντας όσο το δυνατόν λιγότερες διαστάσεις, αλλά και ενισχυμένες ικανότητες διαχωρισμού για μετέπειτα προσπάθειες ανάκτησης τους. Οι μέθοδοι αναπαράστασης συνήθως ξεκινούν με μια διαδικασία μείωσης της διάστασης (dimensionality reduction), καθώς οι μεγάλες διαστάσεις των πρωτογενών δεδομένων δυσκολεύουν τη εκτίμηση στατιστικών μέτρων. Μερικές από τις πιο δημοφιλείς μεθόδους αναπαράστασης δεδομένων είναι η PCA, η αναπαράσταση κυματομορφής με χρήση των φίλτρων Gabor. Οι μέθοδοι διαχωρισμού (discrimination) έχουν ως στόχο να πετύχουν τον πλήρη διαχωρισμό μεταξύ δύο διαφορετικών προτύπων, προκειμένου να ενταχθούν σε διαφορετικές κατηγορίες. Μερικές από της πιο κλασσικές μεθόδους διαχωρισμού είναι ο κατηγοριοποιητής του Bayes, η MAP, η FLD και τελευταία η μέθοδος του k-pca. Η αναπαράσταση με χρήση των Gabor κυματομορφών μας δίνει τη δυνατότητα να διατηρούμε ακραίες οπτικές ιδιότητες, όπως χωρική τοπικότητα, επιλογή προσανατολισμού, αλλά και τη χωρική συχνότητα. O Lades και οι συνεργάτες του χρησιμοποίησαν της Gabor κυματομορφές σε συνδυασμό με την DLA (dynamic link architecture) για αναγνώριση προσώπου. O Wiskott και οι συνεργάτες του επέκτειναν την DLA,

9 αναπτύσσοντας μια μέθοδο ταιρίασματος γράφων βασισμένη στις Gabor κυματομορφές. Βασιζόμενος στην 2D αναπαράσταση με τις Gabor κυματομορφές και ταίριασμα γράφων με χρήση ετικετών (labeled elastic graph matching), ο Lyons και οι συνεργάτες του, πρότειναν έναν αλγόριθμο κατηγοριοποίησης σε δύο κλάσεις σύμφωνα με το γένος, τη φυλή, και την έκφραση του προσώπου. Πιο πρόσφατα, ο Donato και οι συνεργάτες του συνέκριναν μια μέθοδο που βασιζόταν ακριβώς στα Gabor φίλτρα με άλλες τεχνικές και κατέληξαν στο συμπέρασμα ότι η πρώτη έχει σαφώς καλύτερη απόδοση. Η k-pca υπερνικά πολλούς από τους περιορισμούς της γραμμικής PCA, απεικονίζοντας μη γραμμικά τα αρχικά δεδομένα σε ένα χώρο χαρακτηριστικών (feature space) με περισσότερες διαστάσεις από ότι ο αρχικός χώρος. Το γεγονός ότι διατηρεί τη γραμμικότητα στο χώρο των χαρακτηριστικών, ενώ στον αρχικό χώρο είχαμε να αντιμετωπίσουμε τη μη γραμμικότητα, δίνει τη δυνατότητα στον kpca να παράγει χαρακτηριστικά σε μικρότερες διαστάσεις. Ο kpca βασίζεται στο θεώρημα του Cover για τη διαχωρισιμότητα των προτύπων, σύμφωνα με το οποίο τα πρότυπα που δεν μπορούν να διαχωριστούν γραμμικά σε έναν χώρο, μπορούν να διαχωριστούν γραμμικά αν τα προβάλλουμε σε έναν χώρο χαρακτηριστικών με περισσότερες διαστάσεις. Υπολογιστικά, ο kpca εκμεταλλεύεται την συνθήκη της εξίσωσης του Mercer και είναι εφικτός να υλοποιηθεί με ικανοποιητική απόδοση επειδή τα εσωτερικά γινόμενα που εμφανίζονται στον χώρο των χαρακτηριστικών με τις πολλές διαστάσεις αντικαθίστανται από τα εσωτερικά γινόμενα του αρχικό χώρου με τις λιγότερες διαστάσεις. Η υπολογιστική πολυπλοκότητα σχετίζεται με το πλήθος των δεδομένων εκπαίδευσης και όχι με τη διάσταση του χώρου των χαρακτηριστικών. Ο Scholkopf και οι συνεργάτες του απέδειξαν ότι ο kpca ξεπερνά τον PCA χρησιμοποιώντας ικανό πλήθος μη γραμμικών αναπαραστάσεων των δεδομένων εισόδου. Ο Yang και οι συνεργάτες του συνέκριναν την απόδοση του kpca και της μεθόδου των Eigenfaces για αναγνώριση προσώπων και τα αποτελέσματά τους δείχνουν ότι ο kpca με ένα πολυώνυμο τρίτης τάξης για συνάρτηση πυρήνα έδωσε χαμηλότερο ποσοστό λάθους. Ο Moghaddam

10 υλοποίησε τον kpca με γκαουσιανούς πυρήνες και απέδειξε πως έχουν καλύτερη απόδοση από τον PCA για αναγνώριση προσώπου. 2. Σύστημα Αναγνώρισης Προσώπου Ένα σύστημα αναγνώρισης προσώπου είναι μια εφαρμογή η οποία έχει ως σκοπό την αυτόματη ταυτοποίηση ενός προσώπου από μια ψηφιακή εικόνα του. Αυτό επιτυγχάνεται συγκρίνοντας κάποια χαρακτηριστικά του προσώπου που θέλουμε να ελέγξουμε με τα χαρακτηριστικά των εικόνων που διαθέτουμε σε μια βάση. Τα συστήματα αναγνώρισης προσώπου χρησιμοποιούνται σε συστήματα ασφαλείας και μπορούν να συγκριθούν με άλλα βιομετρικά συστήματα, όπως τα συστήματα που εξετάζουν δακτυλικά αποτυπώματα ή συστήματα αναγνώρισης της ίριδας του ματιού. Οι πιο δημοφιλής αλγόριθμοι αναγνώρισης περιλαμβάνουν τα eigenfaces, fisherfaces και το ταίριασμα με δυναμικές συνδέσεις που βασίζεται σε νευρώνες. Μια νέα τάση, που υποστηρίζει ότι μπορεί να είναι πιο ακριβής σε σχέση με τις προηγούμενες, είναι η τρισδιάστατη αναγνώριση προσώπου. Μια άλλη πολλά υποσχόμενη τεχνική χρησιμοποιεί τις ορατές λεπτομέρειες του δέρματος. Έλεγχοι που έχουν γίνει στη βάση FERET, απέδειξαν πως αυτή η προσέγγιση είναι πιο αξιόπιστη από ότι οι προηγούμενες.

11 3. Μείωση της διάστασης των δεδομένων - αλγόριθμοι Όταν προσπαθούμε να διαχωρίσουμε σε κατηγορίες πολυδιάστατα δεδομένα, όπως στην περίπτωση της αναγνώρισης προσώπου, πολλές από τις διαστάσεις τους μπορεί να είναι κοινές, δηλαδή να μη διαφοροποιούνται επειδή ακριβώς δεν είναι και τόσο σημαντικές για την κατηγοριοποίηση. Επιπλέον, πρέπει να επισημάνουμε πως τα δεδομένα που είναι πολυδιάστατα είναι και δύσχρηστα. Άλλο ένα πρόβλημα των πολυδιάστατων δεδομένων είναι η δυσκολία να επιλέξουμε ποια από τα χαρακτηριστικά είναι τα πιο σημαντικά (feature selection problem). Για να αντιμετωπιστεί το πρόβλημα των πολλών διαστάσεων των δεδομένων έχουν προταθεί διάφοροι αλγόριθμοι, οι πιο σημαντικοί από τους οποίους αναφέρονται στη συνέχεια Τυχαίες προβολές (random projections). Στην τεχνική αυτή, τα αρχικά d-διαστατα δεδομένα προβάλλονται σε έναν k- διάστατο υποχώρο του αρχικού χώρου (k<<d), με την εφαρμογή ενός τυχαίου kxd πίνακα R, του οποίου οι στήλες είναι μοναδιαίου μήκους. Χρησιμοποιώντας την ορολογία για τους πίνακες, αν το X d N είναι το αρχικό σύνολο των Ν d-διάστατων παρατηρήσεων, τότε (1) είναι η προβολή των δεδομένων στον k-διάστατο υποχώρο. Η κεντρική ιδέα των τυχαίων προβολών βασίζεται στη θέση των Johnson-Lindenstrauss: αν τα σημεία ενός διανυσματικού χώρου προβληθούν σε ένα τυχαία επιλεγμένο υποχώρο μικρότερης αλλά εξίσου βολικής διάστασης, τότε οι αποστάσεις μεταξύ των σημείων διατηρούνται κατά προσέγγιση.

12 Η τεχνική των τυχαίων προβολών υπολογιστικά είναι πολύ απλή: αρκεί να σχηματίσουμε τον τυχαίο πίνακα R και να προβάλλουμε τα d N δεδομένα του πίνακα Χ στις k διαστάσεις. Η πολυπλοκότητα του προβλήματος είναι της τάξης του O(dkN), και αν ο πίνακα Χ είναι αραιός με περίπου c μη μηδενικές τιμές ανά στήλη, η πολυπλοκότητα μειώνεται στην τάξη του O(ckN). Στην πραγματικότητα η σχέση (1) δεν είναι προβολή επειδή ο πίνακας R δεν είναι γενικά ορθογώνιος. Μια γραμμική απεικόνιση, όπως αυτή της σχέσης (1), μπορεί να προκαλέσει σημαντικές παραμορφώσεις στο σύνολο των δεδομένων αν ο πίνακας R δεν είναι ορθογώνιος. Η μετατροπή τους σε ορθογώνιο απαιτεί αρκετό υπολογιστικό κόστος. Παρόλα αυτά μπορούμε να εκμεταλλευτούμε το αποτέλεσμα στο οποίο κατέληξαν οι Hecht-Nielsen: Σε ένα χώρο πολλών διαστάσεων υπάρχει μεγαλύτερο ποσοστό σχεδόν ορθογώνιων διευθύνσεων. Έτσι τα διανύσματα που έχουν τυχαίες διευθύνσεις είναι πολύ πιθανό να προσεγγίζουν τα ορθογώνια. Συνεπώς, ο πίνακας R Τ R μπορεί να προσεγγίζει τον μοναδιαίο πίνακα. Όταν θέλουμε να συγκρίνουμε την απόδοση της τεχνικής των τυχαίων προβολών με τις άλλες μεθόδους μείωσης διαστάσεων, θα πρέπει να παρατηρήσουμε τον τρόπο με τον οποίο παραμορφώνεται η ομοιότητα δύο διανυσμάτων μετά την μείωση της διάστασης. Η μέτρηση της ομοιότητας μπορεί να γίνει είτε με τη χρήση της Ευκλείδειας απόστασης ή υπολογίζοντας το εσωτερικό γινόμενο των δύο διανυσμάτων. Στην περίπτωση που τα δεδομένα μας είναι εικόνες, η Ευκλείδεια απόσταση χρησιμοποιείται κατά κόρον. Η Ευκλείδεια απόσταση μεταξύ των διανυσμάτων x 1 και x 2 εκφράζεται ως x 1 x 2 στον αρχικό πολυδιάστατο χώρο. Μετά την τυχαία προβολή τους, η απόσταση των διανυσμάτων στον υποχώρο προσεγγίζεται από την κλιμακούμενη Ευκλείδεια απόσταση, η οποία δίνεται από τη σχέση: (2)

13 όπου d είναι η αρχική διάσταση και k η διάσταση του υποχώρου του συνόλου των δεδομένων. Ο όρος κλιμάκωσης (d/k) ½ εκφράζει την μείωση της διάστασης των δεδομένων, σύμφωνα με τους Johnson-Lindenstrauss, Η επιλογή του τυχαίου πίνακα R είναι ένα από τα σημεία στα οποία αξίζει να σταθούμε και να σχολιάσουμε, καθώς είναι μείζονος σημασία και ενδιαφέροντος. Τα στοιχεία r ij του R ακολουθούν συνήθως γκαουσιανή κατανομή, αλλά αυτό δεν συμβαίνει πάντα. Ο Achlioptas απέδειξε ότι η γκαουσιανή κατανομή μπορεί να αντικατασταθεί από μια πιο απλή κατανομή, όπως: (3) Στην πραγματικότητα, όλες οι κατανομές με μηδενική μέση τιμή και μοναδιαία τυπική απόκλιση μπορούν να χρησιμοποιηθούν για την προβολή και παράλληλα να ικανοποιούν την αρχή που διατύπωσαν οι Johnson- Lindenstrauss PCA Στην ανάλυση πρωτευουσών συνιστωσών (principal component analysis), υπολογίζουμε τις ιδιοτιμές του πίνακα συμμεταβλητότητας των δεδομένων με τη σχέση E{XX T } = EΛE T, όπου οι στήλες του πίνακα Ε είναι τα ιδιοδιανύσματα του πίνακα E{XX T } και Λ είναι ένας διαγώνιος πίνακας με τα στοιχεία της διαγωνίου να είναι οι ιδιοτιμές που αντιστοιχούν στα ιδιοδυανύσματα. Αν απαιτείται μείωση της διάστασης του συνόλου των αρχικών δεδομένων, τα δεδομένα μπορούν να προβληθούν σε έναν υποχώρο που ορίζεται από τα πιο σημαντικά ιδιοδιανύσματα:

14 (4) όπου ο πίνακας E k (d k ) περιέχει τα k ιδιοδιανύσματα που αντιστοιχούν στις k μεγαλύτερες ιδιοτιμές. Ο αλγόριθμος του PCA είναι ένα καλός τρόπος να προβάλουμε τα δεδομένα υπό την έννοια ότι το τετραγωνικό σφάλμα που εισάγεται με την προβολή ελαχιστοποιείται σε σχέση με τις άλλες προβολές στον k-διάστατο χώρο. Ένα από τα σημαντικότερα μειονεκτήματα αυτής της μεθόδου είναι το γεγονός ότι η ιδιοανάλυση του πίνακα συμμεταβλητότητας (του οποίου το μέγεθος είναι d x d για τα d-διάστατα δεδομένα) έχει αυξημένο υπολογιστικό κόστος. Η υπολογιστική πολυπλοκότητα της PCA είναι της τάξης O(d 2 N) + O(d 3 ). Βέβαια υπάρχουν και λιγότερο υπολογιστικά δαπανηρές μέθοδοι για τον υπολογισμό μόνο ορισμένων ιδιοδυανυσμάτων και ιδιοτιμών ενός μεγάλου πίνακα SVD Μια άλλη μέθοδος που μάλιστα έχει στενή σχέση με την PCA είναι η SVD (singular value decomposition) X = USV T, όπου οι πίνακες U και V είναι ορθογώνιοι και περιέχουν τα αριστερά και δεξιά μοναδιαία διανύσματα του Χ, αντίστοιχα, και η διαγώνιος του S περιέχει τις μοναδιαίες τιμές του Χ. Με την εφαρμογή του αλγόριθμου SVD, μπορούμε να μειώσουμε τις διαστάσεις των δεδομένων προβάλλοντας τα δεδομένα στον χώρο που καθορίζεται από τα αριστερά μοναδιαία διανύσματα που αντιστοιχούν στις k μεγαλύτερες μοναδιαίες τιμές: (5) όπου U k είναι ένας πίνακας d k και περιέχει τα k μοναδιαία διανύσματα. Όπως η PCA, η μέθοδος SVD είναι επίσης υπολογιστικά δαπανηρή. Υπάρχουν βέβαια αριθμητικές ρουτίνες όπως η μέθοδος Lanczos, που διευκολύνουν τους υπολογισμούς και κάνουν την SVD πιο αποδοτική από την PCA, ακόμα και αν αυτή εφαρμόζεται σε αραιούς πίνακες. Η υπολογιστική πολυπλοκότητα του SVD είναι της τάξης του O(dcN), όταν έχουμε ένα αραιό πίνακα X (d N) με c μη μηδενικές τιμές ανά γραμμή

15 3.4. Latent semantic indexing (LSI) Η LSI είναι μια μέθοδος μείωσης της διάστασης και χρησιμοποιείται συνήθως σε δεδομένα που το περιεχόμενο τους είναι κείμενο 4. Κατηγοριοποίηση Οι μέθοδοι διαχωρισμού (discrimination) έχουν ως στόχο να πετύχουν τον πλήρη διαχωρισμό μεταξύ δύο διαφορετικών προτύπων, προκειμένου να ενταχθούν σε διαφορετικές κατηγορίες. Μερικές από της πιο κλασσικές μεθόδους διαχωρισμού είναι ο κατηγοριοποιητής του Bayes, η MAP, η FLD και τελευταία η μέθοδος του k-pca. Ορισμένοι από τους πιο γνωστούς αλγορίθμους κατηγοριοποίησης είναι οι ακόλουθοι: ( Linear classifiers Στην περιοχή του machine Learning, στόχος της κατηγοριοποίησης είναι η ομαδοποίηση των αντικειμένων, τα οποία εμφανίζουν παρόμοια χαρακτηριστικά. Ένας γραμμικός κατηγοριοποιητής μπορεί να επιτύχει αυτό τον σκοπό βασιζόμενος στον γραμμικό συνδυασμό των χαρακτηριστικών. Αν το διάνυσμα χαρακτηριστικών που εισάγεται στον κατηγοριοποιητή είναι ένα πραγματικό διάνυσμα, τότε η έξοδος του κατηγοριοποιητή είναι: όπου το είναι ένα πραγματικό διάνυσμα βαρών και f είναι μια συνάρτηση που μετατρέπει το εσωτερικό γινόμενο των δύο διανυσμάτων στο επιθυμητό αποτέλεσμα. Το διάνυσμα βάρους εκπαιδεύεται από ένα σύνολο δειγμάτων εκπαίδευσης που το καθένα έχει μια ετικέτα. Συχνά η f είναι μια απλή συνάρτηση που θέτει στην πρώτη κλάση όλες τις τιμές που βρίσκονται πάνω από ένα κατώφλι, ενώ όλες οι υπόλοιπες τιμές ομαδοποιούνται σε μια δεύτερη κλάση. Μια πιο σύνθετη συνάρτηση f μπορεί να δίνει την πιθανότητα ενός αντικειμένου να ανήκει σε μια κλάση.

16 Το πρόβλημα κατηγοριοποίησης σε δύο κλάσεις, μπορούμε να το δούμε και σαν μια διαδικασία διαχωρισμού του πολυδιάστατου χώρου των δεδομένων από ένα υπερεπίπεδο βάσει του γραμμικού κατηγοριοποιητή: όλα τα σημεία που βρίσκονται στην μια πλευρά του υπερεπιπέδου ανήκουν στην κλάση «ναι», και αυτά που βρίσκονται στην αντίθετη πλευρά ανήκουν στην κλάση «όχι». Οι γραμμικοί κατηγοριοποιητές συνήθως χρησιμοποιούνται στις περιπτώσεις όπου η ταχύτητα της κατηγοριοποίησης είναι σημαντική, καθώς είναι ο ταχύτερος από όλους τους άλλους κατηγοριοποίητες, ιδιαίτερα όταν το διάνυσμα είναι αραιό ή όταν η διάστασή του είναι πολύ μεγάλη Fisher's linear discriminant Οι όροι Fisher's linear discriminant και LDA συνήθως χρησιμοποιούνται με την ίδια έννοια, αν και το αρχικό άρθρο του Fisher «The Use of Multiple Measures in Taxonomic Problems» (1936) περιγράφει στην πραγματικότητα έναν ελαφρώς διαφορετικό διαχωριστή, ο οποίος δεν περιλαμβάνει μερικές από τις υποθέσεις του LDA, όπως τις ομοιόμορφα κατανεμημένες κλάσεις ή τις ίσες συμμεταβλητότητες των κλάσεων. Υποθέτουμε ότι δύο κλάσεις παρατηρήσεων έχουν μέση τιμή και τυπική απόκλιση Σy = 0,Σy = 1. Ο γραμμικός συνδυασμός των χαρακτηριστικών θα έχει μέση τιμή και τυπική απόκλιση για i=0,1. O Fisher όρισε το διαχωρισμό των δύο κατανομών ως το κλάσμα των τυπικών αποκλίσεων μεταξύ των κλάσεων προς την τυπική απόκλιση μέσα στην κάθε κλάση: και θυμίζει αρκετά το κλάσμα σήματος προς θόρυβο (signal-to-noise ratio). Ο μέγιστος διαχωρισμός επιτυγχάνεται όταν:

17 Στην αναγνώριση προσώπου, κάθε πρόσωπο αναπαρίσταται από ένα μεγάλο αριθμό εικονοστοιχείων. Η μέθοδος LDA αρχικά χρησιμοποιείται για να μειωθούν οι διαστάσεις των χαρακτηριστικών ώστε να διευκολυνθεί η διαδικασία της κατηγοριοποίησης. Καθεμία από τις νέες διαστάσεις είναι ένας γραμμικός συνδυασμός των τιμών των εικονοστοιχείων, που σχηματίζουν ένα template. Οι γραμμικοί συνδυασμοί που προκύπτουν από την μέθοδο του Fisher (Fisher linear discriminant) ονομάζονται Fisher faces, ενώ εκείνοι που προέρχονται από την εφαρμογή της μεθόδου PCA ονομάζονται eigenfaces Logistic regression Στην στατιστική, η λογιστική οπισθοδρόμηση (logistic regression) είναι ένα μοντέλο οπισθοδρόμησης για διωνυμικά κατανεμημένες και εξαρτώμενες μεταβλητές. Πρόκειται για ένα γενικευμένο γραμμικό μοντέλο που χρησιμοποιεί τη συνάρτηση: Η λογιστική οπισθοδρόμηση χρησιμοποιείται στις επιστήμες υγείας και κοινωνιολογίας Bayes classifier Ένας Bayes κατηγοριοποιητής είναι ένα απλός πιθανοθεωρητικός κατηγοριοποιητής που βασίζεται στο θεώρημα του Βayes με ισχυρές υποθέσεις ανεξαρτησίας. Οι κατηγοριοποιητές Bayes μπορεί εύκολα να εκπαιδευτεί με επίβλεψη, ανάλογα με την φύση του πιθανοθεωρητικού μοντέλου. Σε πολλές πρακτικές εφαρμογές, η εκτίμηση των παραμέτρων του Bayes μοντέλου γίνεται με τη μέθοδο της μέγιστης πιθανοφάνειας. Έτσι έχουμε τη δυνατότητα να

18 δουλεύουμε με το μοντέλο του Bayes χωρίς να βασιζόμαστε την πιθανότητα του Bayes ή να χρησιμοποιήσουμε κάποια από τις μεθόδους του Bayes. Παρά την απλοϊκή σχεδίασή του και τις υπεραπλουστευμένες υποθέσεις, αυτού του είδους οι κατηγοριοποιητές πολλές φορές δουλεύουν καλύτερα σε πολλές σύνθετες περιπτώσεις Ένα από τα πλεονεκτήματα του κατηγοριοποιητή Bayes είναι ότι απαιτεί μικρό πλήθος δεδομένων εκπαίδευσης για να εκτιμήσει τις παραμέτρους (μέσες τιμές και τυπικές αποκλίσεις των μεταβλητών) για την κατηγοριοποίηση. Έχοντας λάβει ως δεδομένο ότι οι μεταβλητές είναι ανεξάρτητες, αρκεί να υπολογιστούν μόνο οι τυπικές αποκλίσεις των μεταβλητών και όχι ολόκληρος ο πίνακας συμμεταβλητότητας. Το πιθανοθεωρητικό μοντέλο για έναν κατηγοριοποιητή είναι ένα μοντέλο υπο συνθήκη ως προς μια εξαρτημένη μεταβλητή C, με μικρό πλήθος κλάσεων. Το πρόβλημα είναι το εξής: όταν ο αριθμός των χαρακτηριστικών n είναι αρκετά μεγάλος ή όταν ένα χαρακτηριστικό μπορεί να πάρει ένα ευρύ πλήθος τιμών, τότε είναι ανέφικτη η χρήση ενός μοντέλου που βασίζεται σε πιθανότητες. Σύμφωνα με το θεώρημα του Bayes: ή Στην πράξη αυτό που κυρίως μας ενδιαφέρει είναι ο αριθμητής του παραπάνω κλάσματος, αφού ο παρονομαστής δεν εξαρτάται από τον C και από τις τιμές των F i χαρακτηριστικών είναι γνωστές, και επομένως ο

19 παρονομαστής μπορεί να θεωρηθεί σταθερός. Ο αριθμητής ισοδυναμεί με το μοντέλο των αρθρωτών πιθανοτήτων (joint probability model): το οποίο, χρησιμοποιώντας επαναληπτικά τον ορισμό των υπο συνθήκη πιθανοτήτων, μπορεί να οριστεί και ως: και ούτω καθεξής. Ας υποθέσουμε τώρα ότι κάθε χαρακτηριστικό F i είναι κατά συνθήκη ανεξάρτητο από οποιοδήποτε άλλο χαρακτηριστικό F j για j i. Τούτη η υπόθεση σημαίνει ότι: με αποτέλεσμα το αρθρωτό μοντέλο (joint model) να παίρνει της εξής μορφή: Αυτό σημαίνει ότι, λαμβάνοντας ως δεδομένο την παραπάνω υποθέσγ για την ανεξαρτησία των χαρακτηριστικών, η υπο συνθήκη κατανομή για τη μεταβλητή C της κλάσης παίρνει της μορφή:

20 όπου το Z είναι ο παράγοντας κλιμάκωσης και εξαρτάται μόνο από τα F i,, F n, π.χ. μια σταθερά αν οι τιμές των μεταβλητών των χαρακτηριστικών είναι γνωστες. Τα μοντέλα που μπορούν να εκφραστούν με την παραπάνω μορφή είναι πιο εύχρηστα, καθώς συντελούν στην p(c) και στις ανεξάρτητες κατανομές των πιθανοτήτων p(f i C). Αν έχουμε k κλάσεις και αν το μοντέλο για την p(f i ) μπορεί να περιγραφεί με τη βοήθεια r παραμέτρων, τότε το αντίστοιχο μοντέλο Bayes έχει (k 1) + n r k παραμέτρους. Στην πράξη, συχνά επιλέγουμε το k = 2 (δυαδικλη κατηγοριοποίηση) και το r = 1 (μεταβλητητές Bernoulli ως χαρακτηριστικά), με αποτέλεσμα ο συνολικός αριθμός των παραμέτρων του μοντέλου Bayes να είναι 2n + 1, όπου το n έιναι το πλήθος δων δυαδικών χαρακτηριστικών που χρησιμοποιούνται για πρόβλεψη Perceptron Ο perceptron είναι ένα είδος δυαδικού κατηγοριοποιητή που προβάλλει τις x εισόδους (διανύσματα) σε μια τιμή εξόδου f(x) (βαθμωτό μέγεθος), σύμφωνα με τη σχέση: To w είναι ένα διάνυσμα βαρών και το σύμβολο απεικονίζει το εσωτερικό γινόμενο ( το οποίο υπολογίζει ένα ζυγισμένο άθροισμα) Το b εκφράζει την μεροληψία (bias), και είναι συνήθως μια σταθερά που δεν εξαρτάται από τα δεδομένα εισόδου. Το πρόσημο της f(x) (θετικό ή αρνητικό) χρησιμοποιείται για την κατηγοριοποίηση του διανύσματος x σε έναν δυαδικό κατηγοριοποιητή. Ο συντελεστής της μεροληψίας (b) μπορεί να θεωρηθεί ως η τιμή που αντισταθμίζει τη συνάρτηση ενεργοποίησης, ή ως η τιμή που καθορίζει το βασικό επίπεδο ενός νευρώνα. Αν η τιμή του b είναι ένας αρνητικός αριθμός,

21 τότε ο συνδυασμός των εισόδων και των βαρών θα πρέπει να δώσει ως έξοδο μια θετική τιμή μεγαλύτερη από το b., έτσι ώστε να ωθήσει τον νευρώνα που χρησιμοποιείται για κατηγοριοποίηση πάνω από το μηδέν. Τα κατάλληλα βάρη εφαρμόζονται στις εισόδους. Οι ζυγισμένες πλέον είσοδοι περνούν από τη συνάρτηση f, η οποία παράγει την έξοδο y Quadratic classifiers Ένας κατηγοριοποιητής δεύτερης τάξης χρησιμοποιείται στην περιοχή του machine learning για να διαχωρίσει μετρήσεις σε δύο ή περισσότερες κλάσεις με τη βοήθεια ενός επιπέδου που ορίζεται από μια δευτεροβάθμια εξίσωση. Πρόκειται για μια γενικευμένη μορφή των γραμμικών κατηγοριοποιητών. Quadratic discriminant analysis H QDA σχετίζεται άμεσα με την LDA, στην οποία βασιζόμαστε στην υπόθεση ότι υπάρχουν μόνο δύο κλάσεις (y Є {0,1}) και οι μετρήσεις είναι ομοιόμορφα κατανεμημένες. Αντίθετα με την LDA, στην QDA, δεν υπάρχει καμία υπόθεση σχετικά με την τυπική απόκλιση των κλάσεων. Όταν οι τυπικές αποκλίσεις των κλάσεων θεωρούνται παρόμοιες, ο καλύτερος δυνατός έλεγχος είναι ο έλεγχος του ποσοστού πιθανότητας για το αν μια δεδομένη μέτρηση προέρχεται από μια δεδομένη κλάση. Ας θεωρήσουμε ότι οι μέσες τιμές των κλάσεων είναι γνωστές (μ y =0, μ y =1) και οι τυπικές αποκλίσεις είναι Σ y =0, Σ y =1. Τότε το ποσοστό πιθανότητας θα δίνεται από τη σχέση:

22 Likelihood ratio = για το κατώφλι t. Αν απλοποιήσουμε και επεξεργαστούμε την παραπάνω σχέση, αποδεικνύεται ότι το επίπεδο που διαχωρίζει τις κλάσεις είναι δεύτερης τάξης. Αν και ο QDA είναι η πιο κοινή και διαδεδομένη μέθοδος, έχουν προταθεί και διάφορες άλλες μέθοδοι. Μια από αυτές είναι η εξής: δημιουργούμε ένα μεγαλύτερο διάνυσμα από τα αρχικό προσθέτοντας τα γινόμενα που προκύπτουν από τα ζευγάρια των μετρήσεων. Για παράδειγμα το διάνυσμα θα πάρει τη μορφή. Αφού βρούμε τον quadratic classifier για τις αρχικές μετρήσεις, θα επαναλάβουμε τη διαδικασία για να βρούμε τον γραμμικό κατηγοριοποιητή για το διάνυσμα που προέκυψε μετά τις προσθήκες νέων τιμών. Φια τους γραμμικούς κατηγοριοποιητές που βασίζονται μόνο στα εσωτερικά γινόμενα, οι τιμές που προσθέτουμε δεν χρειάζεται στην πραγματικότητα να υπολογιστούν, αφού το εσωτερικό γινόμενο σε ένα χώρο μεγάλων διατάσεων συνδέεται με αυτό στον αρχικό χώρο. Η μέθοδος αυτή είναι ένα παράδειγμα εφαρμογής πυρήνων, που εφαρμόζεται στην LDA, OPVW KAI στα SVMs K-πλησιέστερος γείτονας (k-nearest neighbour) Τα δείγματα εκπαίδευσης είναι διανύσματα σε ένα πολυδιάστατο χώρο χαρακτηριστικών. Ο χώρος διασπάται σε περιοχές σύμφωνα με την θέση και τις ετικέτες των δειγμάτων. Ένα σημείο του χώρου καταχωρείται στην c

23 κλάση, αν η ετικέτα του παρουσιάζει μεγαλύτερη συχνότητα σε αυτή την κλάση σε σχέση με τα k πλησιέστερα δείγματα εκπαίδευσης. Η ευκλείδεια απόσταση είναι αυτή που χρησιμοποιείται συχνότερα. Η φάση εκπαίδευσης του αλγορίθμου περιλαμβάνει μόνο την αποθήκευση των διανυσμάτων των χαρακτηριστικών και των ετικετών των κλάσεων των δειγμάτων εκπαίδευσης. Στην πραγματική φάση κατηγοριοποίησης, το δείγμα που χρησιμοποιείται για έλεγχο (του οποίου η κλάση δεν είναι γνωστή) αναπαρίσταται ως διάνυσμα στο χώρο των χαρακτηριστικών. Έπειτα υπολογίζονται οι αποστάσεις του νέου αυτού διανύσματος με όλα τα αποθηκευμένα διανύσματα και επιλέγονται τα k πλησιέστερα δείγματα. Το νέο σημείο θεωρείται πλέον ότι ανήκει στην πιο συχνή κλάση από το σύνολο των κλάσεων. Το δείγμα ελέγχου (πράσσινος κύκλος) θα εκχωρηθεί είτε στην πρώτη κλάση των μπλέ τετραγώνων είτε στην δεύτερη κλάση των κόκκινων τριγώνων. Αν το k=3 θα εκχωρηθεί στη δεύτερη κλάση, επειδή υπάρχουν 2 τρίγωνα και μόνο 1 τετράγωνο μέσα στον εσωτερικό κύκλο. Αν το k=5 θα εκχωρηθεί στην πρώτη κλάση ( 3 τετράγωνα έναντι 2 τριγώνων μέσα στον εξωτερικό κύκλο Boosting

24 Με τον όρο boosting αναφερόμαστε σε μια ομάδα μετα-αλγορίθμων την μηχανικής μάθησης με την οποία μπορούμε να δημιουργήσουμε συστήματα επιβλεπόμενης μάθησης. Η τεχνική αυτή βασίζεται στο ερώτημα που τέθηκε από τον Kearns: μπορεί άραγε ένα σύνολο ασθενών μαθητευόμενων να δημιουργήσει ένα ισχυρότερο; Ένας ασθενής μαθητευόμενος (weak learner) ονομάζεται ένας κατηγοριοποιητής, ο οποίος συσχετίζεται με χαλαρές σχέσεις με την πραγματική κατηγοριοποίηση. Αντιθέτως, ένας ισχυρός μαθητευόμενος (strong learner) είναι ο κατηγοριοποιητής που σχετίζεται άμεσα με την πραγματική κατηγοριοποίηση. Ενώ η τεχνική του boosting δεν έχει αλγοριθμικούς περιορισμούς, οι περισσότεροι αλγόριθμοι boosting ακολουθούν ένα πρότυπο. Θεωρητικά το boosting συναντάται στις επαναλήψεις, προσθέτοντας προοδευτικά ασθενείς μαθητευόμενους στον τελικό ισχυρό μαθητευόμενο. Σε κάθε επανάληψη, ένας ασθενής μαθητευόμενος μαθαίνει τα δεδομένα εκπαίδευσης σε σχέση με μια κατανομή. Έπειτα ο ασθενής μαθητευόμενος προστίθεται στον ισχυρό. Αυτό επιτυγχάνεται με στάθμιση του ασθενούς μαθητευόμενου με κάποιο τρόπο, που συνήθως έχει να κάνει με την ακρίβειά του. Αφού έχει γίνει η προσθήκη, τα δεδομένα σταθμίζονται ξανά: παραδείγματα που έχουν κατηγοριοποιηθεί εσφαλμένα κερδίζουν σε βάρος ενώ αυτά που έχουν κατηγοριοποιηθεί σωστά μειώνουν τα βάρη τους (ορισμένοι αλγόριθμοι boosting στην πραγματικότητα μειώνουν το βάρος παραδειγμάτων που επανειλημμένως κατηγοριοποιούνται εσφαλμένα ( π.χ. οι αλγόριθμοι boosting by majority και BrownBoost). Έτσι, οι μελλοντικοί ασθενής μαθητευόμενοι επικεντρώνονται περισσότερο στα παραδείγματα που οι προηγούμενοι ασθενείς μαθητευόμενοι είχαν κατηγοριοποιηθεί εσφαλμένα. Υπάρχουν πολλοί αλγόριθμοι boosting. Οι αρχικοί αλγόριθμοι που προτάθηκαν από τον Rob Schapire και τον Yoav Freund δεν ήταν προσαρμοστικοί και δεν εκμεταλλευόταν πλήρως τις ιδιότητες των ασθενέστερων μαθητευόμενων. Η βασική διαφορά που συναντάται στους διάφορους αλγόριθμους boosting είναι η μέθοδος με την οποία ζυγίζονται τα δεδομένα εκπαίδευσης και οι υποθέσεις. Ο AdaBoost είναι ένα ο πιο δημοφιλής και ίσως ο πιο σημαντικός

25 ιστορικά αλγόριθμος, μια που υπήρξε ο πρώτος αλγόριθμος που μπορούσε να προσαρμόσει τους ασθενείς μαθητευόμενους στη διαδικασία μάθησης. Άλλοι αλγόριθμοι που ανήκουν σε αυτή την οικογένεια αλγορίθμων είναι οι LPBoost, TotalBoost, BrownBoost, MadaBoost, LogitBoost και πολλοί άλλοι Decision trees Ένα δένδρο απόφασης είναι ένα μοντέλο πρόβλεψης. Πρόκειται δηλαδή για ένα μοντέλο που έχοντας ως δεδομένο μια απεικόνιση των παρατηρήσεων για ένα αντικείμενο να παράγει συμπεράσματα για την τιμή του αποτελέσματος. Συνώνυμες έννοιες του δένδρου απόφασης είναι το δένδρο κατηγοριοποίησης (διακριτές έξοδοι) και δένδρο οπισθοδόμησης (συνεχείς έξοδοι). Σε αυτές τις δομές δένδρων, τα φύλλα αναπαριστούν τις κατηγοριοποιήσεις και τα κλαδιά τις συνδέσεις των χαρακτηριστικών που οδήγησαν στις συγκεκριμένες κατηγοριοποιήσεις Νευρωνικά δίκτυα Βασική έννοια στα νευρωνικά δίκτυα είναι η έννοια του νευρώνα, καθώς αποτελεί το θεμέλιο λίθο αυτών των συστημάτων. Ένας νευρώνας αποτελείται από τρία στοιχεία: ένα σύνολο κλάδων σύνδεσης (συνάψεων) ένα κόμβο άθροισης (γραμμικής άθροισης) μια συνάρτηση ενεργοποίησης (μη γραμμικότητα) Ένα μεγάλο μέρος της βιβλιογραφίας αναφέρεται στις συναρτήσεις ενεργοποίησης που μπορούν να χρησιμοποιηθούν και παρουσιάζουν σημαντικό ενδιαφέρον. Μια από τις πιο ενδιαφέρουσες πτυχές των νευρωνικών δικτύων είναι η ικανότητά τους να εκπαιδεύονται, που στην πράξη σημαίνει: Δεδομένου ενός προβλήματος και μιας κλάσης F συναρτήσεων, το να εκπαιδευτεί το δίκτυο σημαίνει να χρησιμοποιηθεί ένα σύνολο παρατηρήσεων, με σκοπό να βρεθεί η

26 η οποία θα αντιπροσωπεύει την βέλτιστη λύση του προβλήματος. Η επίλυση του προβλήματος απαιτεί να ορίσουμε μια συνάρτηση κόστους έτσι ώστε η βέλτιστη λύση να ικανοποιεί την ανίσωση Η συνάρτηση κόστους C είναι αποτελεί σημαντικό θέμα στην εκπαίδευση, καθώς μετρά ακριβής θα είναι η βέλτιστη λύση στην οποία θα καταλήξουμε. Οι αλγόριθμοι εκμάθησης αναζητούν στο χώρο των λύσεων τη βέλτιστη λύση, εκείνη δηλαδή που θα έχει το μικρότερο δυνατό κόστος Bayesian δίκτυα

27 Ένα Bayesian δίκτυο (ή αλλιώς δίκτυο πιστότητας belief network) είναι ένα πιθανοθεωρητικό γραφικό μοντέλο που αναπαριστά ένα σύνολο μεταβλητών και τις πιθανοθεωριτικές τους εξαρτήσεις. Για παράδειγμα, ένα τέτοιο δίκτυο μπορεί να χρησιμοποιηθεί για να υπολογίσει την πιθανότητα ένας ασθενής να πάσχει από μια ασθένεια, δίνοντας ως δεδομένο την ύπαρξη ή την απουσία ορισμένων συμπτωμάτων, αν βέβαια είναι γνωστές η πιθανοθεωρητικές εξαρτήσεις μεταξύ των ασθενειών και των συμπτωμάτων. Στη γενική περίπτωση, τα Bayesian δίκτυα είναι κατευθυνόμενοι μη κυκλική γράφοι των οποίων οι κόμβοι αναπαριστούν τις μεταβλητές και οι ακμές χρησιμοποιούνται για την κωδικοποίηση των υπό συνθήκη εξαρτήσεων μεταξύ των μεταβλητών Κρυμμένα Μοντέλα Markov Ένα κρυμμένο μοντέλο Markov (ΗΜΜ) ονομάζεται κάθε στατιστικό μοντέλο στο οποίο το σύστημα που μοντελοποιείται είναι μια διαδικασία Markov με άγνωστες παραμέτρους, και σκοπός μας είναι καθορίσουμε τις τιμές των κρυμμένων παραμέτρων από τις παρατηρήσεις μας. Οι παράμετροι του μοντέλου που προκύπτουν μπορούν να χρησιμοποιηθούν στη συνέχεια για περαιτέρω ανάλυση, π.χ. σε εφαρμογές αναγνώρισης προτύπων. Το ΗΜΜ μπορεί να θεωρηθεί ως το απλούστερο δυναμικό δίκτυο Bayes. Σε ένα συνηθισμένο μοντέλο Markov, η κατάσταση είναι άμεσα ορατή στον παρατηρητή, και έτσι οι μόνες παράμετροι του προβλήματος είναι οι πιθανότητες μεταβάσεων από κατάσταση σε κατάσταση. Σε ένα κρυμμένο μοντέλο Markov, η κατάσταση στην οποία βρισκόμαστε δεν είναι άμεσα ορατή, αλλά είναι ορατές οι μεταβλητές που επηρεάζονται από την κατάσταση. Κάθε κατάσταση έχει μια κατανομή πιθανοτήτων για κάθε πιθανή έξοδο. Η ακολουθία των συμβόλων που παράγεται από το HMM είναι αυτή που μας πληροφορεί και για την ακολουθία των καταστάσεων. Τα κρυμμένα μοντέλα Markov είναι ιδιαιτέρως γνωστά για την εφαρμογή τους στην αναγνώριση ομιλίας, κειμένων, αλλά και στην αναγνώριση χειρονομιών και στην βιοπληροφορική.

28 4.9. Support vector machines (SVMs) Πολλά υπερεπίπεδα μπορούν να διαιρέσουν τα δεδομένα σε κλασεις. Μόνο ένα από αυτά θα επιτύχει το βέλτιστο διαχωρισμό. Τα SVMs προβάλλουν τα διανύσματα εισόδου σε ένα χώρο με μεγαλύτερες διαστάσεις, όπου και ορίζεται ένα μέγιστο υπερεπίπεδο που χρησιμοποιείται για το διαχωρισμό των κλάσεων. Στη συνέχεια ορίζονται δύο παράλληλα υπερεπίπεδα εκατέρωθεν του αρχικού. Το αρχικό υπερεπίπεδο θα πρέπει να μεγιστοποιεί την απόσταση μεταξύ των δύο παράλληλων υπερεπιπέδων. Θεωρούμε ότι όσο μεγαλύτερο είναι το εύρος ή η απόσταση μεταξύ των δύο παράλληλων υπερεπιπέδων τόσο χαμηλότερο θα είναι το συνολικό σφάλμα του κατηγοριοποιητή. Συχνά αυτό που μας ενδιαφέρει είναι να κατηγοριοποιήσουμε τα δεδομένα μας με μια διαδικασία μηχανικής μάθησης. Κάθε δεδομένο μπορεί να αναπαρασταθεί με ένα p-διάστατο διάνυσμα (μια λίστα p αριθμών). Καθένα από αυτά τα δεδομένα ανήκει μόνο σε μια από τις δύο κλάσεις. Αυτό που μας ενδιαφέρει να μάθουμε είναι αν μπορούμε να τα διαχωρίσουμε με ένα υπερεπίπεδο p-1 διαστάσεων. Αυτή εξάλλου είναι και η τυπική μορφή των γραμμικών κατηγοριοποιητών. Πολλοί είναι οι γραμμικοί κατηγοριοποιητές

29 που ικανοποιούν αυτή την ιδιότητα. Ωστόσο, θα ήταν χρήσιμο να μάθουμε αν μπορούμε να το επιτύχουμε με το μέγιστο διαχωρισμό (μέγιστο εύρος) μεταξύ των δύο κλάσεων. Με άλλα λόγια, επιλέγουμε το υπερεπίπεδο έτσι ώστε να μεγιστοποιείται η απόσταση του από το κοντινότερο σημείο δεδομένο. Αν υπάρχει ένα τέτοιο υπερεπίπεδο, τότε αυτό ονομάζεται υπερεπίπεδο μέγιστου εύρους (maximum margin hyperplane) και ο γραμμικός κατηγοριοποιητής ονομάζεται κατηγοριοποιητής μέγιστου εύρους (maximum margin classifier). Τα υπερεπίπεδα μέγιστου εύρους ενός SVM εκπαιδεύονται με τα δείγματα των δύο κλάσεων. Τα δείγματα που βρίσκονται κατά μήκος του υπερεπιπέδου ονομάζονται διανύσματα υποστήριξης (support vectors). Ας θεωρήσουμε ότι τα δεδομένα μας έχουν τη μορφή:

30 όπου το c i παίρνει την τιμή 1 ή -1, μια σταθερά που υποδηλώνει την κλάση στην οποία ανήκει το σημείο x i. Κάθε x i είναι ένα p-διάστατο διάνυσμα, συνήθως κανονικοποιημένο στις τιμές [0,1] ή [0,-1]. Η κλιμάκωση είναι απαραίτητα ώστε να προστατευτούμε από τις μεταβλητές με τις μεγαλύτερες διακυμάνσεις που υπό άλλες συνθήκες θα επικρατούσαν στην κατηγοριοποίηση. Θεωρούμε τα σημεία αυτά ως τα δεδομένα εισόδου, που θα μας δώσουν τη σωστή κατηγοριοποίηση στην οποία θέλουμε να καταλήξουμε με τη εφαρμογή του SVM, το οποίο παίρνει τη μορφή: Το διάνυσμα w είναι κάθετο στο υπερεπίπεδο διαχωρισμού. Η προσθήκη της παραμέτρου b μας δίνει τη δυνατότητα να αυξάνουμε το εύρος. Αν την αγνοήσουμε, τότε το υπερεπίπεδο διέρχεται από την αρχή των αξόνων, περιορίζοντας την επίλυση. Δεδομένου ότι αναζητούμε το μέγιστο εύρος, στην ουσία ψάχνουμε τα διανύσματα υποστήριξης (support vectors) και τα παράλληλα υπερεπίπεδα που θα βρίσκονται πλησιέστερα σε αυτά τα διανύσματα σε κάθε κλάση. Αποδεικνύεται ότι τα παράλληλα υπερεπίπεδα παριγράφονται από τις εξισώσεις: Αν τα δεδομένα εκπαίδευσης είναι γραμμικώς διαχωρίσιμα, μπορούμε να επιλέξουμε αυτά τα υπερεπίπεδα έτσι ώστε να μην υπάρχει κανένα σημείο μεταξύ τους και στη συνέχεια να προσπαθήσουμε να μεγιστοποιήοσυμε την απόστασή τους. Με εφραμογή της γεωμετρίας, μπορούμε να πούμε ότι η απόσταση μεταξύ των υπερεπιπέδων είναι 2/ w. Συνεπώς το μόονο που έχουμε να κάνουμε είναι να ελαχιστοποιήσουμε το w. Για να αποκλείσουμε κάποια δεδομένα, θα πρέπει να διαβεβαιωθούμε ότι για κάθε i θα ισχύει: ή

31 Το οποίο μπορεί να συμπτυχθεί στην παρακάτω ανίσωση: (1) Το πρόβλημα τώρα έγκειται στην ελαχιστοποίηση του w υπό τον περιορισμό (1). Αυτό είναι πλέον πρόβλημα βελτιστοποίησης (quadratic programming optimization problem QP). Συγκεκριμένα, η ελαχιστοποίηση του, υπό τον περιορισμό.ο παράγοντας 1/2 χρησιμοποιείται για διευκόλυνση στους μαθηματικούς υπολογισμούς. Γράφοντας τον κανόνα κατηγοριοποίησης στην δυική του μορφή παρατηρούμε ότι η κατηγοριοποίηση δεν είναι τιποτα περισσότερο από μια συνάρτηση των διανυσμάτων υποστήριξης (support vectors).η δυική μορφή του SVM είναι: με, όπου οι α όροι αποτελούν μια δυική αναπαράσταση του διανύσματος βάρους σε σχέση με το σύνολο εκπαίδευσης: Soft Margins To 1995, οι Cortes και Vapnik πρότειναν μια τροποποιημένη εκδοχή του μέγιστου εύρους που μπορεί να χρησιμοποιηθεί και για παραδείγματα στα

32 οποία έχουν δοθεί εσφαλμένες ετικέτες. Αν δεν υπάρχει υπερεπίπεδο το οποίο να μπορεί να διαιρέσει το χώρο σε παραδείγματα «ναι» και «όχι», τότε μπορεί να χρησιμοποιηθεί η μέθοδος Soft Margin. Σύμφωνα με αυτή, επιλέγεται ένα υπερεπίπεδο το οποίο διαιρεί όσο πιο ξεκάθαρα γίνεται, ενώ παράλληλα, μεγιστοποιεί την απόσταση με τα κοντινότερα παραδείγματα που έχουν διαχωριστεί με όσο το δυνατόν μεγαλύτερη σαφήνεια. Η μέθοδος αυτή έκανε δημοφιλή τα SVMs. Η μέθοδος Soft Margin εισήγαγε τις «χαλαρές» μεταβλητές ξ i, οι οποίες μετρούν το βαθμό εσφαλμένης κατηγοριοποίησης του x i. (2) Η συνάρτηση αυξάνεται από μια διαδικασία η οποία τιμωρεί τα μη-μηδενικά ξ i, και η βελτιστοποίηση ταλαντεύεται μεταξύ ενός μεγάλου εύρους και ενός μικρού σφάλματος ποινής. Αν η συνάρτηση ποινής (penalty function) είναι γραμμική, η εξίσωση παίρνει τη μορφή: ούτως ώστε: Ο περιορισμός αυτός σε συνδυασμό με το στόχο μας που είναι η ελαχιστοποίηση του w μπορεί να επιλυθεί με τη χρήση λαπλασιανών πολλαπλασιαστών (Laplacian multipliers). Το βασικότερο πλεονέκτημα μιας γραμμικής συνάρτησης ποινής είναι το γεγονός ότι οι «χαλαρές» μεταβλητές εξαλείφονται από το δυικό πρόβλημα, και η σταθερά C εμφανίζεται μόνο σαν ένας πρόσθετος περιορισμός στους πολλαπλασιαστές του Lagrance. Μη γραμμικές συναρτήσεις ποινής έχουν επίσης χρησιμοποιηθεί, ιδιαίτερα για να μειώσουν την επίδραση των ακραίων τιμών στον κατηγοριοποιητή, αλλά αν δεν μας ενδιαφέρει κάτι τέτοιο, η εύρεση της ολικής λύσης γίνεται πολύ πιο δύσκολη.

33 4.11. Μη γραμμική κατηγοριοποίηση. Ο αρχικός αλγόριθμος για εύρεση του βέλτιστου υπερεπιπέδου, που προτάθηκε από τον Vapnik το 1963, ήταν ένας γραμμικός κατηγοριοποιητής. Ωστόσο, το 1992, οι Boser, Guyon και Vapnik πρότειναν έναν τρόπο για τη δημιουργία μη γραμμικών κατηγοριοποιητών εφαρμόζοντας το κόλπο των πυρήνων (που αρχικά είχαν αναφερθεί από τον Aizerman) στα υπερεπίπεδα μέγιστου εύρους. Ο αλγόριθμος που προέκυψε είναι τυπικά παρόμοιος, εκτός από το γεγονός ότι κάθε εσωτερικό γινόμενο αντικαταστάθηκε από μια μη γραμμική συνάρτηση πυρήνα. Αυτή η τροποποίηση δίνει τη δυνατότητα στον αλγόριθμο να ορίζει πιο ευέλικτα το υπερεπίπεδο μέγιστου εύρους στον μετασχηματισμένο χώρο των χαρακτηριστικών. Ο μετασχηματισμός μπορεί να μην είναι γραμμικός και ο μετασχηματισμένος χώρος θα είναι μεγάλων διαστάσεων. Έτσι, θεωρώντας τον κατηγοριοποιητή ως ένα υπερεπίπεδο στον πολυδιάστατο χώρο των χαρακτηριστικών, ο ίδιος κατηγοριοποιητής μπορεί να μην είναι γραμμικός στον αρχικό χώρο. Αν ο πυρήνας που θα χρησιμοποιηθεί είναι γκαουσιανές συναρτήσεις ακτινικής βάσης (Gaussian radial basis functions), τότε ο αντίστοιχος χώρος των χαρακτηριστικών θα είναι ένας χώρος Hilbert (Hilbert space) απείρης διαστάσεων. Οι κατηγοριοποιητές μέγιστου εύρους είναι κανονικοποιημένοι, και έτσι το γεγονός ότι οι διαστάσεις τείνουν στο άπειρο δεν επηρεάζει καταστροφικά τα αποτελέσματα. Μερικοί από τους πιο γνωστούς πυρήνες είναι: Πολυωνυμικός (ομογενής): Πολυωνυμικός (μη ομογενής): Συνάρτηση Ακτινικής Βάσης (Radial Basis Function RBF):, για γ > 0

34 Γκαουσιανή Συνάρτηση ακτινικής βάσης (Gaussian Radial basis function) : Σιγμοειδής (sigmoid):, για ορισμένα (όχι για όλα) τα κ > 0 και c < 0

35 5. Supervised Learning Στη συνέχεια παρουσιάζονται οι αλγόριθμοι των SVMs και ο KFD και θα μελετήσουμε τους αλγόριθμους Boosting και τη σχέση τους με τους πυρήνες στον χώρο των χαρακτηριστικών αλλά και με τα SVMs Support Vector Machines [ 4] Ας θυμηθούμε πρώτα ότι η VC διάσταση ενός γραμμικού συστήματος, π.χ. των υπερεπιπέδων που χρησιμοποιούνται για διαχωρισμό ενός χώρου (όπως υπολογίζονται από ένα perceptron) μπορεί να περιοριστεί με ένα άνω φράγμα σε σχέση με το εύρος. Για τους κατηγοριοποιητές που εκφράζονται με υπερεπίπεδα οι συνθήκες που τους επιτρέπουν να χρησιμοποιηθούν στη διαδικασία της κατηγοριοποίησης χωρίς σφάλμα εκπαίδευσης είναι: Καθώς οι γραμμικές συναρτήσεις που καθορίζουν τις κλάσεις δεν είναι πάντα αρκετά ικανοποιητικές στην πράξη, θα θεωρήσουμε γραμμικούς κατηγοριοποιητές στο χώρο των χαρακτηριστικών με τη χρήση εσωτερικών γινομένων. Για το σκοπό αυτό, αντικαθιστούμε τα Φ(x i ) κάθε δείγματος x i, π.χ. Στο χώρο των χαρακτηριστικών, οι συνθήκες για μια τέλεια κατηγοριοποίηση παίρνουν τη μορφή:

36 Ο σκοπός της εκμάθησης είναι να βρεθούν τα w Є F, και έτσι να ελαχιστοποιηθεί το αναμενόμενο σφάλμα. Ωστόσο, επειδή δεν μπορούμε να απομονώσουμε και να ασχοληθούμε μόνο με το αναμενόμενο σφάλμα, προσπαθούμε αντ αυτού να ελαχιστοποιήσουμε το όριο, που στην ουσία αντιπροσωπεύει το εμπειρικό σφάλμα και τον όρο της πολυπλοκότητας. Ένας τρόπος είναι να μηδενίσουμε το εμπειρικό σφάλμα περιορίζοντας τα w και b, ενώ παράλληλα να ελαχιστοποιήσουμε τον όρο πολυπλοκότητας, που συνήθως είναι μια αύξουσα συνάρτηση, που εξαρτάται από τη διάσταση h. Για έναν γραμμικό κατηγοριοποιητή η διάσταση h ικανοποιεί την ανίσωση: (α) όπου το R είναι η ακτίνα την μικρότερης σφαίρας που περιβάλλει τα δεδομένα εκπαίδευσης και είναι σταθερή για ένα δεδομένο σύνολοι δεδομένων. Έτσι, ελαχιστοποιώντας τον όρο w 2 ελαχιστοποιούμε και την πολυπλοκότητα. Η διαδικασία αυτή μπορεί να μετασχηματιστεί σε πρόβλημα βέλτιστου τετραέδρου (quadratic optimization problem). (β) υπό την συνθήκη (α). Ωστόσο, αν ο μόνος τρόπος για να έχουμε πρόσβαση στο χώρο των χαρακτηριστικών είναι μέσω των εσωτερικών γινομένων που υπολογίζονται με τους πυρήνες, μπορούμε να μην ασχοληθούμε με την άμεση επίλυση της (β), καθώς το w είναι μέρος του χώρου των χαρακτηριστικών. Μπορούμε όμως να απαλλαγούμε από την χρήση του w, εφαρμόζοντας το πρόβλημα δυικής βελτιστοποίησης (dual optimization problem). Με την εισαγωγή των πολλαπλασιαστών Lagrance στη συνθήκη (α) καταλήγουμε στην παρακάτω μορφή:

37 (γ) Σκοπός μας πλέον είναι να ελαχιστοποιήσουμε την παραπάνω σχέση συναρτήσει των α i. Στο βέλτιστο σημείο, ισχύουν οι εξισώσεις: και που μετασχηματίζονται σε: και (δ) Από την εξίσωση που βρίσκεται στα δεξιά, βρίσκουμε ότι το w περιλαμβάνεται στον υποχώρο που ορίζεται από τα Φ(x i ). Αντικαθιστώντας τις σχέσεις (δ) στιν (γ) και το γινόμενο (Φ(x i ) Φ(x j )) με μια συνάρτηση πυρήνα k(x i, x j ), κατάλήγουμε στο dual optimization problem: υπό τις συνθήκες: Επιλύοντας το πρόβλημα, όπως έχει οριστεί παραπάνω, μπορούμε να υπολογίσουμε τους συντελεστές α i, i=1,, Ν, καθένας από τους οποίους χρειάζεται για να εκφράσουμε τα w και έτσι να βρούμε τη λύση της (β). Με αυτόν τον τρόπο οδηγούμαστε σε μια μη γραμμική συνάρτηση απόφασης

38 Ας σημειωθεί ότι μέχρι στιγμής έχουμε ασχοληθεί μόνο με την περίπτωση που το εμπειρικό σφάλμα είναι μηδενικό. Όμως για τα ενθόρυβα δεδομένα δεν ισχύει πάντα αυτή η υπόθεση. Επομένως πρέπει να βρεθεί μια ικανοποιητική ισορροπία μεταξύ του εμπειρικού σφάλματος και της πολυπλοκότητας. Χρησιμοποιώντας μια τεχνική που προτάθηκε από τους Bennett και Mangasarian και μετέπειτα χρησιμοποιήθηκε στα SVMs, μπορούμε να εισάγουμε αυθαίρετες μεταβλητές για να χαλαρώσουμε τους περιορισμούς των ορίων. επιτρέποντας και κάποια λάθη στην κατηγοριοποίηση. Η λύση για το SVM μπορεί να βρεθεί είτε διατηρώντας την τιμή του ορίου χαμηλή στην VC διάσταση είτε ελαχιστοποιώντας ένα άνω όριο σφάλμα, π.χ. το πλήθος των λαθών εκπαίδευσης. στο εμπειρικό 1) by keeping the upper bound on the VC dimension small and 2) by minimizing an upper bound on the empirical risk,4 i.e., the number of training errors. Ελαχιστοποιούμε δηλαδή την τιμή:

39 όπου η σταθερά της κανονικοποίησης καθορίζει την ισορροπία μεταξύ του εμπειρικού σφάλματος και της πολυπλοκότητας. Με τον τρόπο αυτό οδηγούμαστε στο δυικό πρόβλημα: (ε) Από την στιγμή που εισάγουμε της αυθόρμητες μεταβλητές, καταλήγουμε σε περιορισμούς που οριοθετούν το μέγεθος των πολλαπλασιαστών Lagrange: Διασπορά Οι περισσότερε μέθοδοι βελτιστοποίησης βασίζονται στις συνθήκες βελτιστοποίησης δεύτερης τάξης, τις συνθήκες Karush Kuhn Tucker (ΚΚΤ), που θεωρούνται αναγκαίες και σε μερικές περιπτώσεις ικανές ώστε ένα σύνολο μεταβλητών να είναι το βέλτιστο σε ένα πρόβλημα βελτιστοποίησης. Αυτές οι συνθήκες είναι ιδιαίτερα εύχρηστες και βολικές και μπορούν να μας εξυπηρετήσουν στο πρόβλημα του δυικού SVM.

40 Οι ανωτέρω συνθήκες αποκαλύπτουν τη σημαντικότερη ιδιότητα των SVMs: η λύση είναι διάσπαρτη στους συντελεστές α, π.χ. πολλά από τα πρότυπα είναι εκτός του περιθωρίου και οι βέλτιστοι συντελεστές α i είναι μηδενικοί. Πιο συγκεκριμένα, οι συνθήκες ΚΚΤ δείχνουν ότι μόνο τα α i που είναι συνδεδεμένα με ένα πρότυπο του συνόλου εκπαίδευσης, το οποίο είτε βρίσκεται εντός του περιθωρίου (π.χ. 0< α i < C και y i f(x i )=1 ) είτε εκτός του περιθωρίου (π.χ. α i = C και y i f(x i )<1), είναι μη μηδενικά. Χωρίς την ιδιότητα της διασποράς, η μάθηση με SVM δεν θα μπορούσε εύκολα να χρησιμοποιηθεί σε πρακτικές εφαρμογές με μεγάλα σύνολα δεδομένων ν-svms Πολλές είναι οι τροποποιήσεις που έχουν προταθεί σε σχέση με τον βασικό αλγόριθμο των SVMs. Μια ιδιαιτέρως πρακτική παραλλαγή είναι τα ν-svms, που αρχικά χρησιμοποιήθηκαν σε εφαρμογές που απαιτούσαν οπισθοδρόμηση. Στην περίπτωση της αναγνώρισης προτύπων, αντικαθιστούν τη σταθερά κανονικοποίησης C που δεν είναι και τόσο εύχρηστη με μία σταθερά v Є (0,1] που, με επιλογή κατάλληλων παραμέτρων, δίνει παρόμοια αποτελέσματα. Έτσι, αντί να χρειαστεί να επιλύσουμε την (ε):

41 Το πλεονέκτημα είναι ότι η νέα παράμετρος ν είναι πιο ξεκάθαρη από την δήλωση «όσο μικρότερη τόσο πιο ομαλή» : υπό ορισμένες ήπιες υποθέσεις είναι ασυμπτωτικά ένα άνω όριο για το πλήθος των σφαλμάτων του περιθωρίου και ένα κάτω όριο του πλήθους των SVs Υπολογισμός του κατωφλίου Το κατώφλι b μπορεί να υπολογιστεί αν εκμεταλλευτούμε το γεγονός ότι για όλα τα SVs τα x i με 0 < α i < C, οι αυθαίρετες μεταβλητές ξ i έχουν μηδενική τιμή. Το γεγονός αυτό προκύπτει από τις συνθήκες των Karush Kuhn Tucker (KKT). Έτσι για κάθε διάνυσμα υποστήριξης (SV) x i με i Є I: {i : 0 < α i < C), ισχύει: Παίρνοντας το μέσο όρο των προτύπων προκύπτει μια αριθμητικά ευσταθής λύση:

42 Γεωμετρική ερμηνεία Στη συνέχεια θα προσπαθήσουμε να δώσουμε τη γεωμετρική ερμηνεία της λύσης του SVM, ώστε να έχουμε και μια εποπτική εικόνα για το θέμα. Ας κανονικοποιήσουμε τα διανύσματα βαρών στη μονάδα (π.χ. w 2 = 1) και ας καθορίσουμε ως τιμή για το κατώφλι b=0. Τότε, το σύνολο των w που διαχωρίσουν τα δείγματα εκπαίδευσης περιγράφονται πλήρως από τη σχέση: Το σύνολο ονομάζεται version space. Αποδεικνύεται ότι η λύση του SVM συμπίπτει με το κέντρο του version space, όπως αυτό ορίζεται από τον Tchebycheff, που είναι το κέντρο της μεγαλύτερης σφαίρας που περιέχεται στο v. Ωστόσο, το θεωρητικά βέλτιστο σημείο του version space που παράγει ένα βέλτιστο όριο απόφασης κατά Bayes, είναι το σημείο Bayes, που ως γνωστόν προσεγγίζεται από το κέντρο της μάζας. Ο version space απεικονίζεται γραφικά ως μια περιοχή πάνω στη σφαίρα όπως φαίνεται στα σχήματα ΣΧΗΜΑ ΣΧΗΜΑ Παράδειγμα του version space, που το SVM δουλεύει ικανοποιητικά. Το κέντρο της μάζας προσεγγίζει τη λύση του SVM.

43 Παράδειγμα του version space, που το SVM δεν δουλεύει ικανοποιητικά.ο version space καταλαμβάνει μια επιμηκυμένη περιοχή και το κέντρο της μάζας απέχει σημαντικά από τη λύση που δίνει το SVM Αν ο version space έχει τη μορφή του ΣΧΗΜΑΤΟΣ 1, η λύση που δίνει το SVM είναι κοντά στο βέλτιστο σημείο, Όμως, αν κατέχει μια επιμηκυμένη περιοχή, όπως αυτή που παρουσιάζεται στο ΣΧΗΜΑ 2, η λύση του SVM απέχει από το βέλτιστο σημείο Kernel Fisher Discriminant Ο βασικός σκοπός του KFD είναι η επίλυση του προβλήματος του γραμμικού διαχωρισμού του Fisher, σε ένα χώρο χαρακτηριστικών (F) που προέκυψε με χρήση πυρήνων, και μέσω αυτού να παράγουμε ένα μη γραμμικό διαχωριστή στον αρχικό χώρο. Στη γραμμική περίπτωση ο διαχωριστής του Fisher στοχεύει στην εύρεση γραμμικών προβολών τέτοιων που οι κλάσεις να διαχωρίζονται πλήρως. Η διαχωρισιμότητα μετράται με τη χρήση δύο ποσοτικών μεγεθών:

44 Από την απόσταση των μέσων όρων των προβολών (θα πρέπει να είναι μεγάλη) Από το πόσο μεγάλη είναι η τυπική απόκλιση των δεδομένων σε αυτή την κατεύθυνση (θα πρέπει να είναι μικρή) Ο σκοπός αυτός μπορεί να επιτευχθεί μεγιστοποιώντας τους συντελεστές Rayleigh (ζ) των τυπικών αποκλίσεων μεταξύ των κλάσεων αλλά και μέσα στις ίδιες τις κλάσεις συναρτήσει του w, όπου και Εδώ τα m k και I k χρησιμοποιούνται για να δηλώσουμε τη μέση τιμλη των δειγμάτων και το σύνολο των περιεχομένων για την κλάση k, αντίστοιχα. Ας σημειωθεί ότι αν υποθέσουμε ότι η κατανομές της κλάσεις είναι γκαουσιανές, ο διαχωριστής του Fisher είναι το βέλτιστο σημείο Bayes. Η δήλωση αυτή μπορεί να γενικευτεί και για την περίπτωση των πολλαπλών κλάσεων. Για να μορφοποιήσουμε το πρόβλημα στο χώρο των χαρακτηριστικών με χρήση πυρήνων (F), μπορούμε να χρησιμοποιήσουμε την επέκταση που προτάθηκε στην (δ) στα SVMs για w Є F, π.χ. εκφράζοντας το w με τη βοήθεια των προτύπων εκπαίδευσης που έχουν ήδη προβληθεί με τους πυρήνες. (η)

45 Αντικαθιστώντας τα Φ(x) για όλα τα x στην (ζ) και συνδυάζοντάς τη με την (η), το πρόβλημα της βελτιστοποίησης για τον KFD στο χώρο των χαρακτηριστικών παίρνει τη μορφή: όπου: (ι) Η προβολή ενός σημείου που χρησιμοποιείται για έλεγχο στον διαχωριστή υπολογίζεται με τη σχέση: Τελικά, για να χρησιμοποιηθούν αυτές οι προβολές στην διαδικασία της κατηγοριοποίησης, χρειάζεται να βρεθεί ένα βολικό κατώφλι το οποίο είτε θα επιλεγεί ως η μέση τιμή του μέσου όρου των προβολών των δύο κλάσεων είτε εκπαιδεύοντας π.χ. ένα γραμμικό SVM στις προβολές. Όπως επισημάνθηκε και προηγουμένως, η διάσταση του χώρου των χαρακτηριστικών είναι ίση η μεγαλύτερη από το πλήθος των δειγμάτων εκπαίδευσης, και για το λόγο αυτό η κανονικοποίηση είναι αναγκαία. Για να μεγιστοποιηθεί η (ι) θα μπορούσαμε είτε να λύσουμε ένα γενικευμένο πρόβλημα ιδιοτιμών, επιλέγοντας το ιδιοδιάνυσμα α με τη μεγαλύτερη ιδιοτιμή λ,

46 είτε ισοδύναμα να υπολογίσουμε: Όμως, καθώς οι πίνακες Μ και Ν αλλάζουν μεγέθη ανάλογα με το πλήθος των δειγμάτων εκπαίδευσης και οι λύσεις δεν είναι αραιές, ο παραπάνω υπολογισμός είναι εφικτός για μέσες τιμές του n. Μια πιθανή λύση στο πρόβλημά μας είναι να μετασχηματίσουμε τον KFD σε ένα πρόβλημα προγραμματισμού κυρτών τετραέδρων (convex quadratic programming Problem). Υπενθυμίζοντας ότι ο διαχωριστής του Fisher προσπαθεί να ελαχιστοποιήσει την τυπική απόκλιση των δεδομένων κατά την προβολή και παράλληλα να μεγιστοποιήσει την απόσταση των μέσων όρων των εξόδων για κάθε κλάση, οι σχέσεις που ακολουθούν εκφράζουν ακριβώς αυτό: αν (κ) και με για k=1,2. και Το P είναι μια συνάρτηση κανονικοποίησης και έχει την τιμή 1 για τα y i που ανήκουν στην κλάση k και μηδέν σε κάθε άλλη περίπτωση. Αυτό το πρόγραμμα είναι ισοδύναμο με το (ι) με την ίδια συνάρτηση κανονικοποίσης που προστέθηκε στον πίνακα Ν. Η απόδειξη αυτής της ισοδυναμίας βασίζεται στο γεγονός ότι Τα στοιχεία του πίνακα Μ έχουν καταταχθεί Οι λύσεις w στην (ι) παραμένουν αμετάβλητες αν εφαρμόσουμε οποιαδήποτε κλιμάκωση.

47 Έτσι μπορούμε να καθορίσουμε την απόσταση των μέσων όρων σε μια τυχαία, θετική τιμή, π.χ. 2, και απλώς να ελαχιστοποιήσουμε την τυπική απόκλιση. Ο πρώτος περιορισμός, που μπορεί να γραφεί και ως με έλκει την έξοδο για κάθε δείγμα στην κλάση με την αντίστοιχη ετικέτα. [89]. Ο όρος ξ 2 ελαχιστοποιεί την τυπική απόκλιση του σφάλματος που προέκυψε, ενώ ο περιορισμός διαβεβαιώνουν ότι ο μέσος όρος των αποτελεσμάτων για κάθε κλάση είναι η ετικέτα, π.χ. για τις ετικέτες ±1 ο μέσος όρος της απόστασης των προβολών είναι 2. Για C=0, οδηγούμαστε στον αρχικό αλγόριθμο του Fisher στον χώρο των χαρακτηριστικών.

48 6. Unsupervised Learning [4] Στην μάθηση χωρίς επίβλεψη δίνονται μόνο τα δεδομένα x1, x2, xn Є R Ν και δεν έχουμε ετικέτες. Από τα πιο κλασσικά θέματα στα οποία χρησιμοποιούμε τεχνικές μάθησης χωρίς επίβλεψη είναι η κατηγοριοποίηση, η εκτίμηση πυκνότητας και η περιγραφή δεδομένων. Η τεχνική με τους πυρήνες μπορεί να εφαρμοστεί και στις μεθόδους μάθησης χωρίς επίβλεψη υπό τη συνθήκη ότι το αλγόριθμος βάσης μπορεί να γραφεί με τη χρήση αριθμητικών γινομένων (scalar products) kpca [4] Η βασική ιδέα του PCA είναι η εξής: Για Ν-διάστατα δεδομένα, υπολογίζουμε ένα σύνολο ορθογώνιων κατευθύνσεων, π.χ. οι πρώτες k προβολές (k=1,, N) να δίνουν τη δυνατότητα να ανακαταστευάσουμε τα δεδομένα με το μικρότερο τετραγωνικό σφάλμα. (α)

49 (β) ΣΧΗΜΑ: Με τη χρήση μίας συνάρτησης πυρήνα, ο k-pca υλοποιεί ένα γραμμικό PCA σε έναν πολυδιάστατο χώρο χαρακτηριστικών, και σχετίζεται μη γραμμικά με τον αρχικό χώρο των δεδομένων. (α) O γραμμικός PCA στον αρχικό χώρο δεν είναι ικανός να δώσει μια καλή περιγραφή για την κατεύθυνση των δεδομένων σε αυτό το απλό παράδειγμα. (β) Με τη χρήση της κατάλληλης μη γραμμικής απεικόνισης Φ και εφαρμόζοντας τον γραμμικό PCA στα πρότυπα που έχουν προκύψει μετά την απεικόνιση (kernel PCA), η μη γραμμική κατεύθυνση στον αρχικό χώρο, η οποία είναι το αποτέλεσμα της εφαρμογής του αλγόριθμου, είναι σε θέση να μας πληροφορήσει για την κατεύθυνση που μας ενδιαφέρει. Στην πράξη, επιθυμούμε να περιγράψουμε τα δεδομένα με όσο το δυνατόν λιγότερες διαστάσεις εξάγοντας ορισμένα χαρακτηριστικά ή στοιχεία, ενώ παράλληλα προσπαθούμε να διατηρήσουμε τη δομή των δεδομένων. Δεδομένου ότι ο PCA είναι ένας γραμμικός αλγόριθμος δεν μπορεί να εξάγει μη γραμμικές δομές από τα δεδομένα. Το γεγονός αυτό αντιμετωπίζεται με τον kpca. Για τον kpca πρώτα απεικονίζουμε τα δεδομένα σε ένα χώρο χαρακτηριστικών (F) και υπολογίζουμε τον πίνακα συμμεταβλητότητας. (1)

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Τεχνικές Μείωσης Διαστάσεων. Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 5 6 Principal component analysis EM for Gaussian mixtures: μ k, Σ k, π k. Ορίζουμε το διάνυσμα z (διάσταση Κ) ώστε K p( x θ) = π ( x μ, Σ ) k = k k k Eκ των υστέρων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 5 6 Principal component analysis EM for Gaussian mixtures: μ k, Σ k, π k. Ορίζουμε το διάνυσμα z (διάσταση Κ) ώστε K p( x θ) = π ( x μ, Σ ) k = k k k Eκ των υστέρων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Πανεπιστήμιο Κύπρου Πολυτεχνική Σχολή

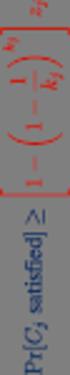

Πανεπιστήμιο Κύπρου Πολυτεχνική Σχολή Τμήμα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδημαϊκό έτος 2010-11 Χειμερινό Εξάμηνο Practice final exam 1. Έστω ότι για

Πανεπιστήμιο Κύπρου Πολυτεχνική Σχολή Τμήμα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδημαϊκό έτος 2010-11 Χειμερινό Εξάμηνο Practice final exam 1. Έστω ότι για

Τεχνητή Νοημοσύνη. 18η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΧΑΡΤΟΓΡΑΦΗΣΗ ΤΟΥ ΧΩΡΟΥ ΤΩΝ ΤΑΞΙΝΟΜΗΤΩΝ Ταξινομητές Ταξινομητές συναρτ. διάκρισης Ταξινομητές επιφανειών απόφ. Παραμετρικοί ταξινομητές Μη παραμετρικοί

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΧΑΡΤΟΓΡΑΦΗΣΗ ΤΟΥ ΧΩΡΟΥ ΤΩΝ ΤΑΞΙΝΟΜΗΤΩΝ Ταξινομητές Ταξινομητές συναρτ. διάκρισης Ταξινομητές επιφανειών απόφ. Παραμετρικοί ταξινομητές Μη παραμετρικοί

Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων»

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Δρ. Βασίλειος Γ. Καμπουρλάζος Δρ. Ανέστης Γ. Χατζημιχαηλίδης

Μάθημα 4 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

Μάθημα 4 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 3 Επιλογή μοντέλου Επιλογή μοντέλου Θεωρία αποφάσεων Επιλογή μοντέλου δεδομένα επικύρωσης Η επιλογή του είδους του μοντέλου που θα χρησιμοποιηθεί σε ένα πρόβλημα (π.χ.

HMY 795: Αναγνώριση Προτύπων Διάλεξη 3 Επιλογή μοντέλου Επιλογή μοντέλου Θεωρία αποφάσεων Επιλογή μοντέλου δεδομένα επικύρωσης Η επιλογή του είδους του μοντέλου που θα χρησιμοποιηθεί σε ένα πρόβλημα (π.χ.

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis)

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis) Η μέθοδος PCA (Ανάλυση Κύριων Συνιστωσών), αποτελεί μία γραμμική μέθοδο συμπίεσης Δεδομένων η οποία συνίσταται από τον επαναπροσδιορισμό των συντεταγμένων ενός

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis) Η μέθοδος PCA (Ανάλυση Κύριων Συνιστωσών), αποτελεί μία γραμμική μέθοδο συμπίεσης Δεδομένων η οποία συνίσταται από τον επαναπροσδιορισμό των συντεταγμένων ενός

ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ ΚΑΙ ΜΑΘΗΜΑΤΙΚΗ ΔΙΑΤΥΠΩΣΗ, Διαλ. 2. Ανωτάτη Σχολή Παιδαγωγικής και Τεχνολογικής Εκπαίδευσης 8/4/2017

ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ ΚΑΙ ΜΑΘΗΜΑΤΙΚΗ ΔΙΑΤΥΠΩΣΗ, Διαλ. 2 Ανωτάτη Σχολή Παιδαγωγικής και Τεχνολογικής Εκπαίδευσης 8/4/2017 Αντικειμενικοί στόχοι Η μελέτη των βασικών στοιχείων που συνθέτουν ένα πρόβλημα βελτιστοποίησης

ΒΑΣΙΚΕΣ ΕΝΝΟΙΕΣ ΚΑΙ ΜΑΘΗΜΑΤΙΚΗ ΔΙΑΤΥΠΩΣΗ, Διαλ. 2 Ανωτάτη Σχολή Παιδαγωγικής και Τεχνολογικής Εκπαίδευσης 8/4/2017 Αντικειμενικοί στόχοι Η μελέτη των βασικών στοιχείων που συνθέτουν ένα πρόβλημα βελτιστοποίησης

ΔΙΚΤΥO RBF. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

Το μοντέλο Perceptron

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 15-16

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 2: Δομικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 2: Δομικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Διακριτικές Συναρτήσεις

Διακριτικές Συναρτήσεις Δρ. Δηµήτριος Τσέλιος Επίκουρος Καθηγητής ΤΕΙ Θεσσαλίας Τµήµα Διοίκησης Επιχειρήσεων Θερµικός χάρτης των XYZ ξενοδοχείων σε σχέση µε τη γεωγραφική περιοχή τους P. Adamopoulos New

Διακριτικές Συναρτήσεις Δρ. Δηµήτριος Τσέλιος Επίκουρος Καθηγητής ΤΕΙ Θεσσαλίας Τµήµα Διοίκησης Επιχειρήσεων Θερµικός χάρτης των XYZ ξενοδοχείων σε σχέση µε τη γεωγραφική περιοχή τους P. Adamopoulos New

Ακαδημαϊκό Έτος , Χειμερινό Εξάμηνο Διδάσκων Καθ.: Νίκος Τσαπατσούλης

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΛΟΠΟΝΝΗΣΟΥ, ΤΜΗΜΑ ΤΕΧΝΟΛΟΓΙΑΣ ΤΗΛΕΠΙΚΟΙΝΩΝΙΩΝ ΚΕΣ 3: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΚΑΙ ΑΝΑΛΥΣΗ ΕΙΚΟΝΑΣ Ακαδημαϊκό Έτος 7 8, Χειμερινό Εξάμηνο Καθ.: Νίκος Τσαπατσούλης ΕΡΩΤΗΣΕΙΣ ΕΠΑΝΑΛΗΨΗΣ Το παρόν

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΛΟΠΟΝΝΗΣΟΥ, ΤΜΗΜΑ ΤΕΧΝΟΛΟΓΙΑΣ ΤΗΛΕΠΙΚΟΙΝΩΝΙΩΝ ΚΕΣ 3: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΚΑΙ ΑΝΑΛΥΣΗ ΕΙΚΟΝΑΣ Ακαδημαϊκό Έτος 7 8, Χειμερινό Εξάμηνο Καθ.: Νίκος Τσαπατσούλης ΕΡΩΤΗΣΕΙΣ ΕΠΑΝΑΛΗΨΗΣ Το παρόν

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

Ασκήσεις μελέτης της 19 ης διάλεξης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος Χιωτίδης Γεώργιος Τμήμα Λογιστικής και Χρηματοοικονομικής Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος Χιωτίδης Γεώργιος Τμήμα Λογιστικής και Χρηματοοικονομικής Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

Σημειώσεις διαλέξεων: Βελτιστοποίηση πολυδιάστατων συνεχών συναρτήσεων 1 / 20

Σημειώσεις διαλέξεων: Βελτιστοποίηση πολυδιάστατων συνεχών συναρτήσεων Ισαάκ Η Λαγαρής 1 Τμήμα Μηχανικών Η/Υ & Πληροφορικής Πανεπιστήμιον Ιωαννίνων 1 Με υλικό από το υπό προετοιμασία βιβλίο των: Βόγκλη,

Σημειώσεις διαλέξεων: Βελτιστοποίηση πολυδιάστατων συνεχών συναρτήσεων Ισαάκ Η Λαγαρής 1 Τμήμα Μηχανικών Η/Υ & Πληροφορικής Πανεπιστήμιον Ιωαννίνων 1 Με υλικό από το υπό προετοιμασία βιβλίο των: Βόγκλη,

Β Γραφικές παραστάσεις - Πρώτο γράφημα Σχεδιάζοντας το μήκος της σανίδας συναρτήσει των φάσεων της σελήνης μπορείτε να δείτε αν υπάρχει κάποιος συσχετισμός μεταξύ των μεγεθών. Ο συνήθης τρόπος γραφικής

Β Γραφικές παραστάσεις - Πρώτο γράφημα Σχεδιάζοντας το μήκος της σανίδας συναρτήσει των φάσεων της σελήνης μπορείτε να δείτε αν υπάρχει κάποιος συσχετισμός μεταξύ των μεγεθών. Ο συνήθης τρόπος γραφικής

ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

Project 1: Principle Component Analysis

Project 1: Principle Component Analysis Μια από τις πιο σημαντικές παραγοντοποιήσεις πινάκων είναι η Singular Value Decomposition ή συντετμημένα SVD. Η SVD έχει πολλές χρήσιμες ιδιότητες, επιθυμητές σε

Project 1: Principle Component Analysis Μια από τις πιο σημαντικές παραγοντοποιήσεις πινάκων είναι η Singular Value Decomposition ή συντετμημένα SVD. Η SVD έχει πολλές χρήσιμες ιδιότητες, επιθυμητές σε

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Διαχωριστικές συναρτήσεις Ταξινόμηση κανονικών

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Διαχωριστικές συναρτήσεις Ταξινόμηση κανονικών

E[ (x- ) ]= trace[(x-x)(x- ) ]

![E[ (x- ) ]= trace[(x-x)(x- ) ] E[ (x- ) ]= trace[(x-x)(x- ) ]](/thumbs/55/36021260.jpg) 1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9 20 Kernel methods Support vector machines Εκπαίδευση νευρωνικών δικτύων backpropagation:. Υπολογισμός μεταβλητών δικτύου «τρέχον» w () () (2) (2) aj = wji xi ak

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 9 20 Kernel methods Support vector machines Εκπαίδευση νευρωνικών δικτύων backpropagation:. Υπολογισμός μεταβλητών δικτύου «τρέχον» w () () (2) (2) aj = wji xi ak

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ Βασίλης Δ. Ανδριτσάνος Δρ. Αγρονόμος - Τοπογράφος Μηχανικός ΑΠΘ Επίκουρος Καθηγητής ΤΕΙ Αθήνας 3ο εξάμηνο http://eclass.teiath.gr Παρουσιάσεις,

ΤΟΠΟΓΡΑΦΙΚΑ ΔΙΚΤΥΑ ΚΑΙ ΥΠΟΛΟΓΙΣΜΟΙ ΑΝΑΣΚΟΠΗΣΗ ΘΕΩΡΙΑΣ ΣΥΝΟΡΘΩΣΕΩΝ Βασίλης Δ. Ανδριτσάνος Δρ. Αγρονόμος - Τοπογράφος Μηχανικός ΑΠΘ Επίκουρος Καθηγητής ΤΕΙ Αθήνας 3ο εξάμηνο http://eclass.teiath.gr Παρουσιάσεις,

Κεφάλαιο 8. Οπτικοποίηση Απαλοιφή

Κεφάλαιο 8. Οπτικοποίηση Απαλοιφή Oι οπτικές επιδράσεις, που μπορεί να προκαλέσει μια εικόνα στους χρήστες, αποτελούν ένα από τα σπουδαιότερα αποτελέσματα των λειτουργιών γραφικών με Η/Υ. Τον όρο της οπτικοποίησης

Κεφάλαιο 8. Οπτικοποίηση Απαλοιφή Oι οπτικές επιδράσεις, που μπορεί να προκαλέσει μια εικόνα στους χρήστες, αποτελούν ένα από τα σπουδαιότερα αποτελέσματα των λειτουργιών γραφικών με Η/Υ. Τον όρο της οπτικοποίησης

ETY-202 ΤΑ ΜΑΘΗΜΑΤΙΚΑ ΕΡΓΑΛΕΙΑ ΤΗΣ ΚΒΑΝΤΟΜΗΧΑΝΙΚΗΣ ETY-202 ΎΛΗ & ΦΩΣ 02. ΜΑΘΗΜΑΤΙΚΑ ΕΡΓΑΛΕΙΑ. Στέλιος Τζωρτζάκης 1/11/2013

stzortz@iesl.forth.gr 1396; office Δ013 ΙΤΕ 2 ΎΛΗ & ΦΩΣ 02. ΜΑΘΗΜΑΤΙΚΑ ΕΡΓΑΛΕΙΑ ΤΑ ΜΑΘΗΜΑΤΙΚΑ ΕΡΓΑΛΕΙΑ ΤΗΣ ΚΒΑΝΤΟΜΗΧΑΝΙΚΗΣ Στέλιος Τζωρτζάκης 1 3 4 Ο διανυσματικός χώρος των φυσικών καταστάσεων Η έννοια

stzortz@iesl.forth.gr 1396; office Δ013 ΙΤΕ 2 ΎΛΗ & ΦΩΣ 02. ΜΑΘΗΜΑΤΙΚΑ ΕΡΓΑΛΕΙΑ ΤΑ ΜΑΘΗΜΑΤΙΚΑ ΕΡΓΑΛΕΙΑ ΤΗΣ ΚΒΑΝΤΟΜΗΧΑΝΙΚΗΣ Στέλιος Τζωρτζάκης 1 3 4 Ο διανυσματικός χώρος των φυσικών καταστάσεων Η έννοια

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 5 o Φροντιστήριο

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D.

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: βελτιστοποίηση με περιορισμούς Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών Τμήμα Πληροφορικής Διάλεξη 9-10 η /2017 Τι παρουσιάστηκε

Βασίλειος Μαχαιράς Πολιτικός Μηχανικός Ph.D. Μη γραμμικός προγραμματισμός: βελτιστοποίηση με περιορισμούς Πανεπιστήμιο Θεσσαλίας Σχολή Θετικών Επιστημών Τμήμα Πληροφορικής Διάλεξη 9-10 η /2017 Τι παρουσιάστηκε

Παραδείγματα Ιδιοτιμές Ιδιοδιανύσματα

Παραδείγματα Ιδιοτιμές Ιδιοδιανύσματα Παράδειγμα Να βρείτε τις ιδιοτιμές και τα αντίστοιχα ιδιοδιανύσματα του πίνακα A 4. Επίσης να προσδιοριστούν οι ιδιοχώροι και οι γεωμετρικές πολλαπλότητες των ιδιοτιμών.

Παραδείγματα Ιδιοτιμές Ιδιοδιανύσματα Παράδειγμα Να βρείτε τις ιδιοτιμές και τα αντίστοιχα ιδιοδιανύσματα του πίνακα A 4. Επίσης να προσδιοριστούν οι ιδιοχώροι και οι γεωμετρικές πολλαπλότητες των ιδιοτιμών.

12. ΑΝΙΣΩΣΕΙΣ Α ΒΑΘΜΟΥ. είναι δύο παραστάσεις μιας μεταβλητής x πού παίρνει τιμές στο

ΓΕΝΙΚΑ ΠΕΡΙ ΑΝΙΣΩΣΕΩΝ Έστω f σύνολο Α, g Α ΒΑΘΜΟΥ είναι δύο παραστάσεις μιας μεταβλητής πού παίρνει τιμές στο Ανίσωση με έναν άγνωστο λέγεται κάθε σχέση της μορφής f f g g ή, η οποία αληθεύει για ορισμένες

ΓΕΝΙΚΑ ΠΕΡΙ ΑΝΙΣΩΣΕΩΝ Έστω f σύνολο Α, g Α ΒΑΘΜΟΥ είναι δύο παραστάσεις μιας μεταβλητής πού παίρνει τιμές στο Ανίσωση με έναν άγνωστο λέγεται κάθε σχέση της μορφής f f g g ή, η οποία αληθεύει για ορισμένες

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Τμήμα Μηχανικών Πληροφορικής ΤΕ Δυϊκότητα. Γκόγκος Χρήστος ΤΕΙ Ηπείρου Επιχειρησιακή Έρευνα. τελευταία ενημέρωση: 1/12/2016

Τμήμα Μηχανικών Πληροφορικής ΤΕ 2016-2017 Δυϊκότητα Γκόγκος Χρήστος ΤΕΙ Ηπείρου Επιχειρησιακή Έρευνα τελευταία ενημέρωση: 1/12/2016 1 Το δυϊκό πρόβλημα Για κάθε πρόβλημα Γραμμικού Προγραμματισμού υπάρχει

Τμήμα Μηχανικών Πληροφορικής ΤΕ 2016-2017 Δυϊκότητα Γκόγκος Χρήστος ΤΕΙ Ηπείρου Επιχειρησιακή Έρευνα τελευταία ενημέρωση: 1/12/2016 1 Το δυϊκό πρόβλημα Για κάθε πρόβλημα Γραμμικού Προγραμματισμού υπάρχει

Εισαγωγή στις Τηλεπικοινωνίες. Δομή της παρουσίασης

1 Oct 16 ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΙΡΑΙΩΣ ΣΧΟΛΗ ΤΕΧΝΟΛΟΓΙΩΝ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΕΠΙΚΟΙΝΩΝΙΩΝ ΤΜΗΜΑ ΨΗΦΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ ΕΡΓΑΣΤΗΡΙΟ ΤΗΛΕΠΙΚΟΙΝΩΝΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ Εισαγωγή στις Τηλεπικοινωνίες Διάλεξη 4 η Γεωμετρική Αναπαράσταση

1 Oct 16 ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΙΡΑΙΩΣ ΣΧΟΛΗ ΤΕΧΝΟΛΟΓΙΩΝ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΕΠΙΚΟΙΝΩΝΙΩΝ ΤΜΗΜΑ ΨΗΦΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ ΕΡΓΑΣΤΗΡΙΟ ΤΗΛΕΠΙΚΟΙΝΩΝΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ Εισαγωγή στις Τηλεπικοινωνίες Διάλεξη 4 η Γεωμετρική Αναπαράσταση

Τι είναι βαθμωτό μέγεθος? Ένα μέγεθος που περιγράφεται μόνο με έναν αριθμό (π.χ. πίεση)

TETY Εφαρμοσμένα Μαθηματικά Ενότητα ΙΙ: Γραμμική Άλγεβρα Ύλη: Διανυσματικοί χώροι και διανύσματα, μετασχηματισμοί διανυσμάτων, τελεστές και πίνακες, ιδιοδιανύσματα και ιδιοτιμές πινάκων, επίλυση γραμμικών

TETY Εφαρμοσμένα Μαθηματικά Ενότητα ΙΙ: Γραμμική Άλγεβρα Ύλη: Διανυσματικοί χώροι και διανύσματα, μετασχηματισμοί διανυσμάτων, τελεστές και πίνακες, ιδιοδιανύσματα και ιδιοτιμές πινάκων, επίλυση γραμμικών

Σ ΤΑΤ Ι Σ Τ Ι Κ Η. Statisticum collegium iv

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium iv Στατιστική Συμπερασματολογία Ι Σημειακές Εκτιμήσεις Διαστήματα Εμπιστοσύνης Στατιστική Συμπερασματολογία (Statistical Inference) Το πεδίο της Στατιστικής Συμπερασματολογία,

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium iv Στατιστική Συμπερασματολογία Ι Σημειακές Εκτιμήσεις Διαστήματα Εμπιστοσύνης Στατιστική Συμπερασματολογία (Statistical Inference) Το πεδίο της Στατιστικής Συμπερασματολογία,

Συστήματα συντεταγμένων

Κεφάλαιο. Για να δημιουργήσουμε τρισδιάστατα αντικείμενα, που μπορούν να παρασταθούν στην οθόνη του υπολογιστή ως ένα σύνολο από γραμμές, επίπεδες πολυγωνικές επιφάνειες ή ακόμη και από ένα συνδυασμό από

Κεφάλαιο. Για να δημιουργήσουμε τρισδιάστατα αντικείμενα, που μπορούν να παρασταθούν στην οθόνη του υπολογιστή ως ένα σύνολο από γραμμές, επίπεδες πολυγωνικές επιφάνειες ή ακόμη και από ένα συνδυασμό από

ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - 02/07/08) ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ

Ονοματεπώνυμο:......... Α.Μ....... Ετος... ΑΙΘΟΥΣΑ:....... I. (περί τις 55μ. = ++5++. Σωστό ή Λάθος: ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - //8 ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ (αʹ Αν AB = BA όπου A, B τετραγωνικά και

Ονοματεπώνυμο:......... Α.Μ....... Ετος... ΑΙΘΟΥΣΑ:....... I. (περί τις 55μ. = ++5++. Σωστό ή Λάθος: ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - //8 ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ (αʹ Αν AB = BA όπου A, B τετραγωνικά και

Σ ΤΑΤ Ι Σ Τ Ι Κ Η ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ Κατανομή Δειγματοληψίας του Δειγματικού Μέσου Ο Δειγματικός Μέσος X είναι μια Τυχαία Μεταβλητή. Καθώς η επιλογή και χρήση διαφορετικών δειγμάτων από έναν

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ Κατανομή Δειγματοληψίας του Δειγματικού Μέσου Ο Δειγματικός Μέσος X είναι μια Τυχαία Μεταβλητή. Καθώς η επιλογή και χρήση διαφορετικών δειγμάτων από έναν

4. ΚΕΦΑΛΑΙΟ ΕΦΑΡΜΟΓΕΣ ΤΟΥ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΥ FOURIER

4. ΚΕΦΑΛΑΙΟ ΕΦΑΡΜΟΓΕΣ ΤΟΥ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΥ FOURIER Σκοπός του κεφαλαίου είναι να παρουσιάσει μερικές εφαρμογές του Μετασχηματισμού Fourier (ΜF). Ειδικότερα στο κεφάλαιο αυτό θα περιγραφούν έμμεσοι τρόποι

4. ΚΕΦΑΛΑΙΟ ΕΦΑΡΜΟΓΕΣ ΤΟΥ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΥ FOURIER Σκοπός του κεφαλαίου είναι να παρουσιάσει μερικές εφαρμογές του Μετασχηματισμού Fourier (ΜF). Ειδικότερα στο κεφάλαιο αυτό θα περιγραφούν έμμεσοι τρόποι

Πανεπιστήμιο Αθηνών Τμήμα Φυσικής Κβαντομηχανική ΙΙ

Πανεπιστήμιο Αθηνών Τμήμα Φυσικής Κβαντομηχανική ΙΙ Χρονικά Ανεξάρτητη Θεωρία Διαταραχών. Τα περισσότερα φυσικά συστήματα που έχομε προσεγγίσει μέχρι τώρα περιγράφονται από μία κύρια Χαμιλτονιανή η οποία

Πανεπιστήμιο Αθηνών Τμήμα Φυσικής Κβαντομηχανική ΙΙ Χρονικά Ανεξάρτητη Θεωρία Διαταραχών. Τα περισσότερα φυσικά συστήματα που έχομε προσεγγίσει μέχρι τώρα περιγράφονται από μία κύρια Χαμιλτονιανή η οποία

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

HMY 795: Αναγνώριση Προτύπων. Διάλεξη 2

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Θεωρία πιθανοτήτων Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (αντίθετα με τις ντετερμινιστικές μεταβλητές)

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Θεωρία πιθανοτήτων Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (αντίθετα με τις ντετερμινιστικές μεταβλητές)

Κεφ. 7: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών

Κεφ. 7: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών 7. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης) 7. Μέθοδος Euler 7.3

Κεφ. 7: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών 7. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης) 7. Μέθοδος Euler 7.3

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Component Analysis, PCA)

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

Μέθοδος μέγιστης πιθανοφάνειας

Μέθοδος μέγιστης πιθανοφάνειας Αν x =,,, παρατηρήσεις των Χ =,,,, τότε έχουμε διαθέσιμο ένα δείγμα Χ={Χ, =,,,} της κατανομής F μεγέθους με από κοινού σ.κ. της Χ f x f x Ορισμός : Θεωρούμε ένα τυχαίο δείγμα

Μέθοδος μέγιστης πιθανοφάνειας Αν x =,,, παρατηρήσεις των Χ =,,,, τότε έχουμε διαθέσιμο ένα δείγμα Χ={Χ, =,,,} της κατανομής F μεγέθους με από κοινού σ.κ. της Χ f x f x Ορισμός : Θεωρούμε ένα τυχαίο δείγμα

Τμήμα Μηχανικών Πληροφορικής ΤΕ Η μέθοδος Simplex. Γκόγκος Χρήστος ΤΕΙ Ηπείρου Επιχειρησιακή Έρευνα. τελευταία ενημέρωση: 19/01/2017

Τμήμα Μηχανικών Πληροφορικής ΤΕ 2016-2017 Η μέθοδος Simplex Γκόγκος Χρήστος ΤΕΙ Ηπείρου Επιχειρησιακή Έρευνα τελευταία ενημέρωση: 19/01/2017 1 Πλεονεκτήματα Η μέθοδος Simplex Η μέθοδος Simplex είναι μια

Τμήμα Μηχανικών Πληροφορικής ΤΕ 2016-2017 Η μέθοδος Simplex Γκόγκος Χρήστος ΤΕΙ Ηπείρου Επιχειρησιακή Έρευνα τελευταία ενημέρωση: 19/01/2017 1 Πλεονεκτήματα Η μέθοδος Simplex Η μέθοδος Simplex είναι μια

Κεφ. 6Β: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών

Κεφ. 6Β: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης). Μέθοδος Euler 3. Μέθοδοι

Κεφ. 6Β: Συνήθεις διαφορικές εξισώσεις (ΣΔΕ) - προβλήματα αρχικών τιμών. Εισαγωγή (ορισμός προβλήματος, αριθμητική ολοκλήρωση ΣΔΕ, αντικατάσταση ΣΔΕ τάξης n με n εξισώσεις ης τάξης). Μέθοδος Euler 3. Μέθοδοι

ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΙΓΑΙΟΥ ΠΟΛΥΤΕΧΝΙΚΗ ΣΧΟΛΗ ΤΜΗΜΑ ΜΗΧΑΝΙΚΩΝ ΟΙΚΟΝΟΜΙΑΣ ΚΑΙ ΔΙΟΙΚΗΣΗΣ ΣΤΑΤΙΣΤΙΚΗ

ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΙΓΑΙΟΥ ΠΟΛΥΤΕΧΝΙΚΗ ΣΧΟΛΗ ΤΜΗΜΑ ΜΗΧΑΝΙΚΩΝ ΟΙΚΟΝΟΜΙΑΣ ΚΑΙ ΔΙΟΙΚΗΣΗΣ ΣΤΑΤΙΣΤΙΚΗ Ακαδ. Έτος 07-08 Διδάσκων: Βασίλης ΚΟΥΤΡΑΣ Επικ. Καθηγητής v.koutras@fme.aegea.gr Τηλ: 7035468 Θα μελετήσουμε

ΠΑΝΕΠΙΣΤΗΜΙΟ ΑΙΓΑΙΟΥ ΠΟΛΥΤΕΧΝΙΚΗ ΣΧΟΛΗ ΤΜΗΜΑ ΜΗΧΑΝΙΚΩΝ ΟΙΚΟΝΟΜΙΑΣ ΚΑΙ ΔΙΟΙΚΗΣΗΣ ΣΤΑΤΙΣΤΙΚΗ Ακαδ. Έτος 07-08 Διδάσκων: Βασίλης ΚΟΥΤΡΑΣ Επικ. Καθηγητής v.koutras@fme.aegea.gr Τηλ: 7035468 Θα μελετήσουμε

Συσχέτιση μεταξύ δύο συνόλων δεδομένων

Διαγράμματα διασποράς (scattergrams) Συσχέτιση μεταξύ δύο συνόλων δεδομένων Η οπτική απεικόνιση δύο συνόλων δεδομένων μπορεί να αποκαλύψει με παραστατικό τρόπο πιθανές τάσεις και μεταξύ τους συσχετίσεις,

Διαγράμματα διασποράς (scattergrams) Συσχέτιση μεταξύ δύο συνόλων δεδομένων Η οπτική απεικόνιση δύο συνόλων δεδομένων μπορεί να αποκαλύψει με παραστατικό τρόπο πιθανές τάσεις και μεταξύ τους συσχετίσεις,