Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη

|

|

|

- Ἀθήνη Αντωνόπουλος

- 6 χρόνια πριν

- Προβολές:

Transcript

1 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Donald O. Hebb, Organization ofbehavior (1949) Ο Κανόνας του Hebb Είναι ένας από τους πρώτους κανόνες εκμάθησης στα νευρωνικά δίκτυα. Προτάθηκε αρχικά, από τον Hebb, ως ένας πιθανός μηχανισμός για την συναπτική μεταβολή στον εγκέφαλο και υιοθετήθηκε κατόπιν στα νευρωνικά δίκτυα. Εδράζεται στην μελέτη του Hebb για την θεωρία του Pavlov.

2 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Ο Κανόνας του Hebb Όταν ο άξονας ενός νευρώνα Α είναι αρκετά κοντά ώστε να διεγείρει το νευρώνα Β, και συστηματικά και επίμονα συμμετέχει στην ενεργοποίησή του, τότε κάποια μεταβολική αλλαγή συμβαίνει, είτε στο ένα απ' τα δύο, είτε και στα δύο κύτταρα, έτσι ώστε η αποτελεσματικότητα με την οποία ο Α διεγείρει τον Β, αυξάνεται.

3 Γραμμικός Συσχετιστής (Linear Associator) Ο κανόνας του Hebb μπορεί να χρησιμοποιηθεί με διάφορες αρχιτεκτονικές ΝΝ. Η πιο απλή είναι αυτή του James Anderson ή του Teuvo Kohonen. Είσοδοι Γραμμικό Στρώμα a = Wp R p Rx1 W SxR n Sx1 S a Sx1 a i = ή Q j=1 w ij p j a = purelin Wp Γραμμικός Συσχετιστής

4 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Αυτό οδηγεί στην μαθηματική έκφραση του κανόνα του Hebb: w ij new = w ij old + af i a iq g j p jq Όπου: p jq : είναι το j th στοιχείο του q th ανύσματος εισόδου p q a iq : είναι το i th στοιχείο της εξόδου όταν το q th άνυσμα εισόδου εμφανίζεται στην είσοδο. a: είναι η σταθερά εκμάθησης, ένα θετικός αριθμός. Και απλοποιώντας περεταίρω: w ij new = w ij old + a. a iq. p jq

5 Η σχέση αυτή λέει πως το βάρος αλλάζει ανάλογα με την δραστηριότητα και στις δύο πλευρές της σύναψης. Αυξάνει και όταν τα p j και a i είναι και τα δύο θετικά και όταν είναι και τα δύο αρνητικά. Αντίθετα μειώνεται όταν έχουν αντίθετα πρόσημα. Ο κανόνας αυτός είναι ένας κανόνας χωρίς επίβλεψη και δεν χρειάζεται καμιά επιθυμητή έξοδο. Εάν θέλουμε να τον χρησιμοποιήσουμε με επίβλεψη, θα αντικαταστήσουμε την τιμή της πραγματικής εξόδου με την τιμή στόχου και η σχέση θα γίνει: w ij new = w ij old + a. t iq. p jq Όπου t iq : το i th στοιχείο του ανύσματος στόχου t q Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη

6 Η απλοποιημένη σχέση (με a = 1) σε μορφή πινάκων θα είναι: W new = W old + t q p q T Εάν υποθέσουμε πως τα βάρη W old αρχικά είναι μηδέν και εφαρμόζονται τα Q ζεύγη εισόδου/εξόδου θα έχουμε: W = t 1 p 1 T + t 2 p 2 T + + t Q p Q T = με Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Q q=1 T = t 1 t 2 t Q, P = p 1 p 2 p Q t q p q T = TP T

7 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Η επίδοση στην εκμάθηση του γραμμικού συσχετιστή με τον κανόνα του Hebb, όταν τα ανύσματα p q είναι ορθοκανονικά (δηλ. ορθογώνια και μοναδιαίου μήκους), θα διαγράφεται ως εξής: Για είσοδο p k η έξοδος a θα είναι: a = Wp k = Q q=1 t q p q T p k = Q q=1 t q p q T p k Για p q ορθοκανονικό, θα έχουμε: p q T p k = 1 q = k p q T p k = 0 q k και a = Wp k = t k Δηλαδή για πρωτότυπα ορθοκανονικά ανύσματα εισόδου, η έξοδος ισούται με τον στόχο και η εκμάθηση λειτουργεί τέλεια.

8 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Ορθοκανονικά διανύσματα: Λέγονται τα ορθογώνια (κάθετα) διανύσματα, με μέτρο 1. Το μεταξύ τους γινόμενο είναι 0. Για τα διανύσματα αυτά ισχύει e i. e j = δ ij (δ ij είναι το σύμβολο του Kronecker, το οποίο είναι δ ij = 1 για i = j και δ ij = 0 για i j ). Εάν τα ανύσματα p q δεν είναι ορθοκανονικά (αλλά μοναδιαίου μήκους), θα έχουμε: a = Wp k = t k + q k t q p q T p k σφάλμα Δηλαδή τότε δεν θα έχουμε την σωστή έξοδο, και το σφάλμα θα εξαρτάται από τον βαθμό συσχέτισης μεταξύ πρωτοτύπου και ανύσματος εισόδου.

9 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Μήκος (μέτρο) ανύσματος Εάν έχουμε ένα άνυσμα A = Το μέτρο του θα είναι: Α = A x 2 + A y 2 + A z 2 = = 14 = 3,742 Κανονικοποίηση ανύσματος A N = Α Α = 3 1 3,742 3, ,742 = 0,802 0,267 0,534

10 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Παράδειγμα Έστω 2 ορθοκανονικά πρωτότυπα ζεύγη εισόδου/εξόδου: p 1 = 0,5 0,5 0,5 0,5, t 1 = 1 1 p 2 = 0,5 0,5 0,5 0,5, t 2 = 1 1 Μήτρα βαρών: W = TP T = = ,5 0,5 0,5 0,5 0,5 0,5 0,5 0,5

11 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Παράδειγμα Δοκιμή: a 1 = Wp 1 = a 2 = Wp 2 = ,5 0,5 0,5 0,5 0,5 0,5 0,5 0,5 = 1 1 = 1 1 Δηλαδή το σύστημα μας δίνει ως εξόδους τους στόχους: a 1 = t 1 και a 2 = t 2.

12 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Παράδειγμα Εάν έχουμε δύο πρωτότυπα που δεν είναι ορθοκανονικά: p 1 = Τα κανονικοποιούμε:, t 1 = 1 p 2 = 1 1 1, t 2 = 1 p 1 = p 2 = 3 = 1, ,732 = 0,5774 p 1 p 1 = 0,5774 0,5774 0,5774, t 1 = 1 p 2 p 2 = 0,5774 0,5774 0,5774, t 2 = 1

13 Χεμπιανά Μοντέλα Μάθησης με Επίβλεψη Παράδειγμα Μήτρα βαρών: W = TP T = 1 1 = 0 1, ,5774 0,5774 0,5774 0,5774 0,5774 0,5774 a 1 = Wp 1 = 0 1, a 2 = Wp 2 = 0 1, ,5774 0,5774 0,5774 0,5774 0,5774 0,5774 = 0,6668 = 0,6668 Δηλαδή το σύστημα μας δίνει τιμές εξόδου κοντά στους στόχους (-1 1), ωστόσο όμως με ένα σημαντικό σφάλμα.

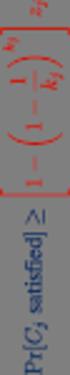

14 Ψευδοαντίστροφος κανόνας Μάθησης Όταν τα πρωτότυπα ανύσματα εισόδου δεν είναι ορθογώνια, ο κανόνας του Hebb δίνει κάποια σφάλματα, τα οποία μπορούμε να τα μειώσουμε με διάφορες μεθόδους (π.χ. με τον ψευδοαντίστροφο κανόνα). Σκοπός του γραμμικού συσχετιστή είναι να δίνει μια έξοδο t q όταν δέχεται μια είσοδο p q : Wp q = t q q = 1,2,.. Q Εάν δεν είναι δυνατόν να επιλεγεί η μήτρα βαρών έτσι ώστε να μπορεί να επιτευχθεί ακριβώς η σχέση, τότε μπορεί να αποπειραθεί μια προσέγγισή της: F W = Q q=1 t q Wp q 2 Για ορθοκανονικά ανύσματα εισόδου p q η F W μηδενίζεται.

15 Ψευδοαντίστροφος κανόνας Μάθησης Όταν τα ανύσματα εισόδου δεν είναι ορθοκανονικά, η F W, όχι μόνον δεν μηδενίζεται, αλλά και η τιμή που παίρνει δεν είναι κατ ανάγκη η ελάχιστη δυνατή. Η μήτρα βαρών που ελαχιστοποιεί την F W υπολογίζεται με την βοήθεια της ψευδοαντίστροφης μήτρας. Έχουμε: WP = T με: T = t 1 t 2 t Q, P = p 1 p 2 p Q F W = T WP 2 = E 2 = i j e ij 2 Η F W μπορεί να μηδενισθεί εάν υπάρχει η αντίστροφη της P. T WP = 0 WP = T W = ΤP 1

16 Ψευδοαντίστροφος κανόνας Μάθησης Η P 1 σπάνια υπάρχει. Κανονικά, τα ανύσματα p q (δηλαδή οι στήλες της P) είναι ανεξάρτητα, αλλά η R (δηλαδή η διάσταση του p q ) είναι μεγαλύτερη του Q (δηλαδή του αριθμού των ανυσμάτων p q ). Δηλαδή η P δεν θα είναι μια τετραγωνική μήτρα και δεν θα υπάρχει ακριβής αντίστροφός της. P = Q R Στην περίπτωση αυτή, η μήτρα που θα ελαχιστοποιεί την F W θα βρίσκεται από τον κανόνα της ψευδοαντιστρόφου:

17 Ψευδοαντίστροφος κανόνας Μάθησης Αντί WP = T θα έχουμε: WPP + = TP + W = ΤP + Η μήτρα P + λέγεται ψευδοαντίστροφος της P (των Moore- Penrose) και είναι η μοναδική μήτρα που ικανοποιεί την σχέση: PP + P = P P + PP + = P + P + P = P + P Τ PP + = PP + Τ Όταν ο αριθμός R των γραμμών της P είναι μεγαλύτερος του αριθμού Q των στηλών της και οι στήλες είναι ανεξάρτητες, τότε η ψευδοαντίστροφος υπολογίζεται: P + = P T P 1 P T

18 Ψευδοαντίστροφος κανόνας Μάθησης Παράδειγμα Ξαναπαίρνουμε τα δύο μη ορθοκανονικά πρωτότυπα και δεν χρειάζεται να κανονικοποιήσουμε τα ανύσματα εισόδου: p 1 = 1 1 1, t 1 = 1 p 2 = 1 1 1, t 2 = 1 Τ = 1 1 P = W = ΤP + =

19 Παράδειγμα P + = P T P 1 P T Ψευδοαντίστροφος κανόνας Μάθησης = = = ,25 0,5 0,25 0,25 0,5 0, = 0,375 0,125 0,125 0,

20 Ψευδοαντίστροφος κανόνας Μάθησης Παράδειγμα W = ΤP + = 1 1 0,25 0,5 0,25 0,25 0,5 0,25 = a 1 = Wp 1 = a 2 = Wp 2 = = 1 = 1 Δηλαδή το δίκτυο, με την χρήση της ψευδοαντιστρόφου, δίνει εξόδους ίσες με τις τιμές στόχους, όπως ακριβώς και με τον κανόνα του Hebb.

21 Εφαρμογή Για την κατανόηση του κανόνα του Hebb, στην εκμάθηση ενός δικτύου, θα χρησιμοποιήσουμε ένα υπεραπλουστευμένο παράδειγμα αναγνώρισης δεδομένων (ψηφίων) σε ένα δίκτυο αυτοσυσχετιστικής μνήμης (autoassociative memory). Στις αυτοσυσχετιστικές μνήμες το επιθυμητό άνυσμα εξόδου είναι ίδιο με το άνυσμα εισόδου (t q = p q ). Τα τρία ψηφία που θα δώσουμε ως δεδομένα εισόδου και ως στόχους εμφανίζονται ως πλέγμα 6x5. Για την μετατροπή του πλέγματος σε μήτρα, θα αντιστοιχίσουμε στα λευκά τετράγωνα (pixels) το «-1» και στα σκούρα το «1».

22 Εφαρμογή Το άνυσμα p 1 που αντιστοιχεί π.χ. στο ψηφίο «0» θα έχει διαστάσεις 30x1, όλες οι στήλες των τετραγώνων στην σειρά, θα είναι: p 1 = T Με βάση τον κανόνα του Hebb και καθώς (t q = p q ), η μήτρα βαρών θα είναι: W = TP T = p 1 p 1 T + p 2 p 2 T + p 3 p 3 T

23 Εφαρμογή Καθώς οι τιμές της εξόδου=στόχου είναι δύο («-1» ή «1»), ο γραμμικός συσχετιστής που θα χρησιμοποιηθεί μπορεί να χρησιμοποιηθεί με συνάρτηση ενεργοποίησης Hard Limit: Είσοδοι Γραμμικό Στρώμα Hard Limit 30 p 30x1 W 30x30 n 30x1 30 a 30x1 a = hardlims Wp

24 Εφαρμογή Για να ελέγξουμε την λειτουργία του δικτύου θα το τροφοδοτήσουμε με δεδομένα (ψηφία) τα οποία έχουν παραμορφωθεί. Αρχικά η παραμόρφωση έχει να κάνει με την αφαίρεση του κάτω μισού ψηφίου. Το δίκτυο θα μας δώσει ως έξοδο το σωστό ψηφίο.

25 Εφαρμογή Συνεχίζοντας θα προχωρήσουμε μεγαλώνοντας την παραμόρφωση αφαιρώντας τα 2/3 του ψηφίου στο κάτω μέρος. Το δίκτυο θα μας δώσει την σωστή έξοδο μόνο για το ψηφίο «1», ενώ για τα άλλα δύο ψηφία μας δίνει εξόδους που δεν ανταποκρίνονται στα δεδομένα εισόδου. Αυτό είναι ένα χαρακτηριστικό και συνηθισμένο πρόβλημα των συσχετιστικών μνημών.

26 Εφαρμογή Στην τρίτη περίπτωση παραμορφώνουμε με θόρυβο τα ψηφία εισόδου, αλλάζοντας τυχαία 7 από τα pixels του καθενός. Το δίκτυο αναγνωρίζει επιτυχώς και τα τρία ψηφία.

27 Εφαρμογή Το παράδειγμα δίδεται στο Matlab με τον τίτλο nnd7sh. Neural Network DESIGN Supervised Hebb Pattern 1 Pattern 2 Pattern 3 Click on the green grids to define target. patterns. Click on the gray grid to define a test pattern. Select the rule to calculate the netw ork w eights below : Test Pattern Response Pattern Chapter 7

28 Εφαρμογή Μπορούμε στο εν λόγω παράδειγμα να δοκιμάσουμε και με δικά μας patterns. Π.χ. εδώ δημιουργούμε το γράμμα Κ.

29 Παραλλαγές Χεμπιανών Μοντέλων Μάθησης Φιλτραρισμένη εκμάθηση Ένα πρόβλημα του Χεμπιανού μοντέλου μάθησης είναι πως οδηγεί σε μήτρες βαρών με πολύ μεγάλα στοιχεία, όταν έχουμε πολλά πρότυπα δεδομένων. Ο βασικός κανόνας εκμάθησης είναι: W new = W old + t q p q T Μια θετική παράμετρος a < 1 (συντελεστής εκμάθησης) μπορεί να χρησιμοποιηθεί για να περιορίζει την αύξηση των στοιχείων της μήτρας βαρών: W new = W old + a t q p q T Μπορούμε επίσης να προσθέσουμε έναν όρο απομείωσης (γ < 1 ), ώστε η εκμάθηση να συμπεριφέρεται σαν φίλτρο εξομάλυνσης και να «θυμάται» τις πιο πρόσφατες εισόδους: W new = W old + a t q p q T γw old = 1 γ W old + a t q p q T

30 Παραλλαγές Χεμπιανών Μοντέλων Μάθησης Φιλτραρισμένη εκμάθηση Όσο το γ πλησιάζει προς το μηδέν (0) ο κανόνας εκμάθησης ανάγεται στον τυπικό κανόνα. Όσο το γ πλησιάζει στο 1, τόσο η εκμάθηση «ξεχνάει» τις παλιές εισόδους και «θυμάται» τις πιο πρόσφατες. Αυτό κρατάει την -χωρίς όρια- αύξηση της μήτρας βαρών. W new = 1 γ W old + a t q p q T Κανόνας Δέλτα Εάν αντικαταστήσουμε την επιθυμητή τιμή στόχο με την διαφορά μεταξύ στόχου και πραγματικής τιμής, τότε έχουμε έναν νέο κανόνα εκμάθησης, τον Κανόνα Δέλτα, γνωστό και ως αλγόριθμο Widrow-Hoff: W new = W old + a t q a q p T q

31 Παραλλαγές Χεμπιανών Μοντέλων Μάθησης Κανόνας Δέλτα Ο κανόνας αυτός ρυθμίζει τα βάρη, για να ελαχιστοποιηθεί το MSE, όπως γίνεται και με τον κανόνα εκμάθησης της ψευδοαντίστροφης μήτρας. Το πλεονέκτημα του κανόνα Δέλτα είναι ότι, μπορεί να επικαιροποιεί τα βάρη, μετά από κάθε νέο δεδομένο εισόδου, ενώ με την ψευδοαντίστοφη μήτρα τα βάρη υπολογίζονται σε ένα βήμα, αφού περάσουν όλα τα ζεύγη εισόδων/στόχων. Αυτό δίνει την δυνατότητα προσαρμογής στο μεταβαλλόμενο περιβάλλον.

32 Παραλλαγές Χεμπιανών Μοντέλων Μάθησης Κανόνας Hebb χωρίς επίβλεψη Ο κανόνας Hebb μπορεί να χρησιμοποιηθεί επίσης και στην μάθηση χωρίς επίβλεψη εάν αντικαταστήσουμε στην τιμή στόχου την πραγματική τιμή της εξόδου a q : W new = W old + aa q p q T Αυτή η εκδοχή του κανόνα του Hebb, για μάθηση χωρίς επίβλεψη, δεν απαιτεί την γνώση της τιμής στόχου. Υπ αυτή την έννοια, αποτελεί πιο άμεση ερμηνεία του αρχικού Κανόνα του Hebb, σε σχέση με αυτόν της μάθησης με επίβλεψη.

33 Εκπαιδευόμενη Διανυσματική Κβάντιση Learning Vector Quantization (LVQ) Κβάντιση (Quantization) Κβάντιση είναι η προσεγγιστική αναπαράσταση πληροφορίας, όπου επιλέγονται μερικές (μεταξύ πολλών συνεχών τιμών ενός συνόλου). Ο κβαντιστής είναι μια μηχανή που δέχεται μια τιμή X και δίνει μια προσέγγιση q X του X, η οποία q X προέρχεται από ένα πεπερασμένο σύνολο τιμών. Εάν π.χ. θέλουμε να παραστήσουμε μια τυχαία μεταβλητή X που παίρνει τιμές μεταξύ 0 και 1, με 10 τιμές: c 0 = 0,05, c 1 = 0,15, c 2 = 0,25, c 3 = 0,35, c 4 = 0,45, c 5 = 0,55, c 6 = 0,65, c 7 = 0,75, c 8 = 0,85, c 9 = 0,95.

34 Εκπαιδευόμενη Διανυσματική Κβάντιση Learning Vector Quantization (LVQ) Κβάντιση (Quantization) c 0 c 1 c 2 c 3 c 4 c 5 c 6 c 7 c 8 c 9 0 0,1 0,2 0,3 0,4 0,5 0,6 0,7 0,8 0,9 1 Οι τιμές c i λέγονται κέντρα. Κάθε τιμή στο διάστημα [0,1] προσεγγίζει στο κοντινότερο κέντρο. Οι τιμές που έχουν το ίδιο κέντρο λέγονται γειτονιές. Π.χ. η τιμή X = 0, προσεγγίζεται από την τιμή c 4 = 0,35 και η X = 0,6892 προσεγγίζεται από την τιμή c 7 = 0,65.

35 Εκπαιδευόμενη Διανυσματική Κβάντιση (LVQ) Η διαδικασία αυτή απόδοσης της κάθε τιμής στο κέντρο της, λέγεται κβάντιση. Στην περίπτωση απλών αριθμών, βαθμωτή κβάντιση. Προφανώς η κβάντιση δημιουργεί ένα σφάλμα προσέγγισης (απώλεια ακρίβειας), αλλά είναι απαραίτητη προκειμένου οι τιμές να κωδικοποιηθούν, να μεταδοθούν, ή να αποθηκευθούν με λιγότερα bits, για λόγους οικονομίας. Για την κωδικοποίηση π.χ. των 10 κέντρων αρκούν 4 bits: c ,,c , ενώ η κωδικοποίηση των αρχικών αριθμών θα απαιτούσε πολλαπλάσια.

36 Εκπαιδευόμενη Διανυσματική Κβάντιση (LVQ) Διανυσματική Κβάντιση (Vector Quantization) Είναι μια αντίστοιχη διαδικασία της βαθμωτής κβάντισης. Εάν π.χ. έχουμε ένα άνυσμα x = x 1 x 2 T στον δισδιάστατο χώρο, η κβάντισή του σε δύο κέντρα c 1, c 2, θα δημιουργούσε δύο γειτονιές. Οι γειτονιές διαχωρίζονται από την μεσοκάθετο της ευθείας που ενώνει τα κέντρα c 1, c 2. Τα ανύσματα x που βρίσκονται στα αριστερά της είναι πιο κοντά στο κέντρο c 1 και στα δεξιά της το c 2. Για περισσότερα κέντρα και περισσότερες γειτονιές, ισχύουν κατ αναλογία, τα ίδια πράγματα. Οι γειτονιές που δημιουργούνται από Ν κέντρα κβάντισης σε έναν n-διάστατο χώρο λέγονται περιοχές Voronoi.

37 Εκπαιδευόμενη Διανυσματική Κβάντιση (LVQ) c 1 c 2

38 Εκπαιδευόμενη Διανυσματική Κβάντιση (LVQ) c 3 c 1 c 2 c 4

39 Το δίκτυο SOM ως Κβαντιστής Η επιλογή των κέντρων κβάντισης έχει στόχο την ελαχιστοποίηση του σφάλματος προσέγγισης. Συνήθως το πλήθος τους είναι γνωστό και καθορίζεται από το πλήθος των bits που έχουμε για την αναπαράσταση του σήματος. Ζητούμενο είναι ο ορισμός της πιο κατάλληλης θέσης τους για την ελαχιστοποίηση του σφάλματος. Εάν c i είναι το πλησιέστερο κέντρο στο άνυσμα x, θα έχουμε: c i x c j x j i Η αναπαράσταση του x γίνεται καλύτερα από το c i, και η έξοδος του κβαντιστή: q x = c i. Το σφάλμα προσέγγισης είναι: q x x 2.

40 Το δίκτυο SOM ως Κβαντιστής Αν p x είναι η πυκνότητα πιθανότητας του x, η μέση τιμή του σφάλματος θα είναι: J = E q x x 2 = x q x x 2 p x dx Η σχέση αυτή (η τιμή του ολοκληρώματος δηλαδή) λέει πως εκεί που η πυκνότητα πιθανότητας p x είναι μικρή, το σφάλμα q x x 2 δεν παίζει σημαντικό ρόλο. Αντίθετα, το σφάλμα πρέπει να είναι μικρό εκεί που η πιθανότητα p x είναι μεγάλη. Δηλαδή εκεί που η κατανομή του x είναι πυκνή, πρέπει να έχουμε πολλά κέντρα ώστε οι γειτονιές να είναι μικρές και να έχουμε μικρό σφάλμα προσέγγισης. Αντίθετα εκεί που η κατανομή του x είναι αραιή (ή και ανύπαρκτη), τα κέντρα πρέπει να τοποθετηθούν αραιά ή ακόμα και καθόλου.

41 Υπάρχουν πολλές μέθοδοι κβαντοποίησης που δεν χρησιμοποιούν τα ΝΝ. Η πιο γνωστή: LBG: Linde-Buzo-Gray Ελαχιστοποιεί το σφάλμα J. Απαιτεί δύο προϋποθέσεις: Για κάθε διάνυσμα εισόδου x η κβάντιση q x επιλέγεται να είναι το κέντρο που βρίσκεται πιο κοντά στο x. Κάθε κέντρο c είναι ο Μ.Ο. των διανυσμάτων που βρίσκονται πιο κοντά του. Το SOM με μέγεθος γειτονιάς Γ=1, συμπεριφέρεται ακριβώς με τον ίδιο τρόπο, αφού: Ο νευρώνας που νικά και εκπαιδεύεται είναι αυτός που έχει το άνυσμα των βαρών του w πιο κοντά στο άνυσμα εισόδου x. Ο κανόνας εκπαίδευσης συγκλίνει στον Μ.Ο. των ανυσμάτων x. Το δίκτυο SOM ως Κβαντιστής

42 Εκπαίδευση στην βέλτιστη LVQ Η εκπαίδευση στην LVQ συνίσταται στην εύρεση της βέλτιστης τοποθέτησης των κέντρων για διανυσματική κβάντιση σε n διαστάσεις. Μοιάζει μαθηματικά με τον αλγόριθμο SOM μόνο που εδώ έχουμε μάθηση με επίβλεψη, αφού γνωρίζουμε την κλάση j στην οποία ανήκει το κάθε διάνυσα εισόδου x. Έχουμε M κλάσεις και N κέντρα: w 1, w 2, w N. Όπου (N M) Σε κάθε κλάση μπορεί να αντιστοιχούν παραπάνω από ένα κέντρα. Μπορεί επίσης να είναι N = k. M, δηλαδή να έχουμε k κέντρα για κάθε κλάση. Κάθε πρότυπο εισόδου ταξινομείται στην κλάση με το πλησιέστερο κέντρο w j.

43 Εκπαίδευση στην βέλτιστη LVQ Σκοπός της εκπαίδευσης είναι η εύρεση των θέσεων των Ν κέντρων, ώστε να περιγράφονται, όσο καλύτερα γίνεται, όλες οι κλάσεις. Η επίδοση της μεθόδου εξάγεται από το σφάλμα ταξινόμησης, δηλαδή το επί % των περιπτώσεων όπου το πρότυπο ταξινομείται σε διαφορετική κλάση από αυτήν στην οποία ανήκει. Ο αλγόριθμος που πραγματοποιεί αυτή την διαδικασία ονομάζεται LVQ1 και έχει σαν στόχο: a. να μετακινεί τα κέντρα προς τα κοντινά πρότυπα της ίδιας κλάσης b. και να τα απομακρύνει από τα κοντινά πρότυπα των άλλων κλάσεων Το βήμα εκπαίδευσης β n φθίνει σταδιακά με τις επαναλήψεις (π.χ. από το 0,1 στο 0).

44 Αλγόριθμος LVQ1 Είσοδοι: Τα διανυσματικά πρότυπα x 1, x P Οι δείκτες: Label (x 1 ), Label (x P ) των κλάσεων στις οποίες ανήκουν τα πρότυπα αυτά Οι αρχικές τιμές των κέντρων w 1, w 2, w N Έξοδοι: Οι εκπαιδευμένες τιμές των κέντρων w 1, w 2, w N

45 Μέθοδος: n = 0 Για κάθε εποχή { Για κάθε πρότυπο p = 1, P { n n + 1 j = label x p } Αλγόριθμος LVQ1 w i είναι το πλησιέστερο κέντρο στο x p Εκπαίδευσε μόνο το w i ως εξής: a. Φέρε το w i πιο κοντά στο x, αν έγινε σωστή ταξινόμηση (δηλαδή το w i αντιστοιχεί στην κλάση j: w i n + 1 = w i n + β n x w i n b. Απομάκρυνε το w i από το x, αν έγινε λάθος ταξινόμηση: w i n + 1 = w i n β n x w i n }

46 Αλγόριθμος ΟLVQ1 Είναι παραλλαγή του αλγορίθμου LVQ1. Τα βήματα εκπαίδευσης για κάθε κέντρο ορίζονται ξεχωριστά. Για το κέντρο w i που είναι πιο κοντά στο πρότυπο εισόδου x το βήμα εκπαίδευσης β i n δεν είναι σταθερό, αλλά ρυθμίζεται αναδρομικά ως εξής: β i n 1 Αν έγινε σωστή ταξινόμηση 1 + β i n 1 β i n = β i n 1 Αν έγινε λάθος ταξινόμηση 1 β i n 1 Δηλαδή το βήμα β i n μειώνεται κάθε φορά που έχουμε σωστή ταξινόμηση και αυξάνεται κάθε φορά που έχουμε λάθος.

47 Έτσι, τα κέντρα που βρίσκονται στο κέντρο της κλάσης, και κοντά σε πολλά πρότυπα, τείνουν να χάνουν τον ρυθμό της εκπαίδευσης (γίνονται πιο δυσκίνητα), ενώ αυτά που βρίσκονται μακριά από τα πρότυπα της κλάσης τους (και φταίνε για τις λάθος ταξινομήσεις) τείνουν να αυξάνουν ρυθμό εκπαίδευσης (γίνονται πιο ευκίνητα). Ο OLVQ1 δεν έχει καλή επίδοση όταν τα δεδομένα δεν συσσωρεύονται γύρω από ένα σημείο, αλλά σε περισσότερα. Ο Kohonen πρότεινε άλλους 2 αλγόριθμους, τους LVQ2 και LVQ3. Με τον LVQ2 γίνεται διόρθωση μόνο στα 2 πιο κοντινά κέντρα w i και w j : w i n + 1 = w i n β n x w i n w j n + 1 = w j n + β n x w j n Υπό τις προϋποθέσεις: Αλγόριθμος ΟLVQ1

48 Αλγόριθμος ΟLVQ2 a. Τα κέντρα w i και w j αντιστοιχούν σε διαφορετικές κλάσεις X i, X j b. Το πρότυπο x ανήκει στην κλάση X j αλλά το πλησιέστερο κέντρο είναι το w i της κλάσης X i c. Το πρότυπο x ανήκει σε μια περιοχή πλάτους w στο κέντρο της απόστασης μεταξύ w i και w j Οι προϋποθέσεις αυτές κάνουν τις διορθώσεις αρκετά σπάνιες και πάντα σε ζευγάρια κέντρων. Ο LVQ2 τείνει να υπερδιορθώνει τα κέντρα απομακρύνοντάς τα από την διαχωριστική επιφάνεια μεταξύ κλάσεων, γι αυτό και δεν συνιστάται η χρήση του για πολλές επαναλήψεις (π.χ. πλήθος εποχών 100 φορές το πλήθος των κέντρων).

49 Αλγόριθμος ΟLVQ3 Ο LVQ3 προσθέτει μια επί πλέον βελτίωση. Αν τα δύο πλησιέστερα κέντρα w i και w j αντιστοιχούν σε διαφορετικές κλάσεις, εφαρμόζουμε τον LVQ2. Αν όμως τα w i και w j αντιστοιχούν στην ίδια κλάση που ανήκει και το x τότε διορθώνονται σύμφωνα με: w i n + 1 = w i n + εβ n w j n + 1 = w j n + β n x w i n x w j n Όπου ε μια μικρή σταθερά (π.χ. ε = 0,1). Εδώ δεν χρησιμοποιείται το παράθυρο πλάτους w το οποίο χρησιμοποιείται μόνο στην περίπτωση των διαφορετικών κλάσεων.

50 Αλγόριθμος LVQ1 (παράδειγμα) κέντρα/κλάση. Τα κέντρα είναι πιο κοντά όταν έχουμε μεγάλη πυκνότητα δεδομένων και πιο αραιά στα πιο αραιά δεδομένα.

51 Στρώμα με επίβλεψη (Grossberg) Το δίκτυο Counterpropagation y 1 y 2 y K Στρώμα χωρίς επίβλεψη (Kohonen) x

52 Το δίκτυο Counterpropagation Είναι συνδυασμός ενός δικτύου με επίβλεψη και ενός χωρίς επίβλεψη, σε δύο στρώματα, τα οποία εκπαιδεύονται χωριστά. Το 1 ο στρώμα είναι ένα δίκτυο SOM, το οποίο κάνει κατηγοριοποίηση των προτύπων σε ομάδες (Clustering), και στο 2 ο στρώμα εφαρμόζεται η λογική του νευρώνα «νικητή». Οι δυαδικές έξοδοι a j του 1 ου στρώματος αποτελούν εισόδους για το 2 ο στρώμα (στρώμα Grossberg), που έχει Κ νευρώνες (όσες και οι κλάσεις).

53 Το δίκτυο Counterpropagation Η έξοδος του i-στού νευρώνα είναι: y i = w ij a j, i = 1, K. Καθώς a j = 1 μόνο για τον νευρώνα-νικητή (j = j ), έχουμε y i = w ij. Το 2 ο στρώμα εκπαιδεύεται με επίβλεψη, με τους στόχους d i με τον κανόνα που χρησιμοποιείται στο δίκτυο ADALINE: Δw ij = β d i y i a j = β d i w ij, αν j = j 0, διαφορετικά

54 Το δίκτυο Counterpropagation Οι στόχοι είναι συνήθως της μορφής: d 1 d 2 d K κλάση κλάση κλάση Κ Το δίκτυο πραγματοποιεί έναν ταξινομητή. Το τμήμα του χωρίς επίβλεψη κάνει την ομαδοποίηση των προτύπων κι αυτό με επίβλεψη κωδικοποιεί την απόφαση σε ποια κλάση ανήκει το πρότυπο.

55 Βασίζεται στην Θεωρία του Αυτοπροσαρμοζόμενου Συντονισμού (Adaptive Resonance Theory) του Grossberg. Θεωρία: Τα πραγματικά βιολογικά συστήματα διαθέτουν: Πλαστικότητα (plasticity): Μαθαίνουν αυτοπροσαρμοζόμενα στα νέα και σημαντικά ερεθίσματα από το περιβάλλον. Σταθερότητα (stability): Δεν τροποποιούνται διαρκώς, πέφτοντας σε κατάσταση αστάθειας, όταν δέχονται ασήμαντα ή άσχετα ερεθίσματα από το περιβάλλον. Το δίκτυο ART

56 Το δίκτυο ART Ένα καλό ΝΝ πρέπει να μπορεί να δημιουργεί νέες καταστάσεις ισορροπίας, όντας ικανό να απομνημονεύει καινούργια πρότυπα (πλαστικότητα), χωρίς όμως να επανακωδικοποιεί ακατάπαυστα τις καταστάσεις ισορροπίας (σταθερότητα). Χρειάζεται δηλαδή μια συμφωνία μεταξύ πλαστικότητας και σταθερότητας (στα MLP π.χ., όλα τα συναπτικά βάρη, μπορούν να αλλάξουν ανά πάσα στιγμή).

57 Οι Carpenter & Grossberg ανέπτυξαν τα ART-1, ART-2, ART-3, για να λύσουν αυτό το πρόβλημα: Κάθε κλάση αντιπροσωπεύεται από το διάνυσμα των συναπτικών βαρών ενός νευρώνα (διάνυσμα αρχέτυπο). Κάθε διάνυσμα εισόδου γίνεται αποδεκτό σε μια κλάση, μόνο εφ όσον μοιάζει αρκετά με το αρχέτυπό της (δηλαδή το διάνυσμα εισόδου συντονίζεται με την κλάση: Resonates). Το αρχέτυπο τροποποιείται κατάλληλα κάθε φορά που ένα νέο πρότυπο εισέρχεται στην κλάση, έτσι ώστε να παραμένει πάντα αντιπροσωπευτικό της κλάσης αυτής. Το δίκτυο ART

58 Το δίκτυο ART Αν το διάνυσμα δεν συντονίζεται με καμιά κλάση, τότε δημιουργεί από μόνο του μια νέα κλάση, της οποίας είναι το αρχέτυπο. Στο μέλλον μπορεί να έρθουν κι άλλα πρότυπα. Έτσι δημιουργείται η σταθερότητα, αφού άσχετα πρότυπα δεν επηρεάζουν το αρχέτυπο, αλλά και πλαστικότητα, αφού το αρχέτυπο κάθε κλάσης προσαρμόζεται ανάλογα με τα πρότυπα που ταιριάζουν στην κλάση του.

59 Ερωτήματα: a. Πως αποφασίζουμε ότι ένα διάνυσμα εισόδου x συντονίζεται με μια κλάση C i ή όχι; Για την αποδοχή ενός προτύπου στην κλάση (συντονισμός) χρησιμοποιείται μια παράμετρος επαγρύπνησης ρ (vigilance parameter) που είναι το κατώφλι αποδοχής ενός προτύπου στην κλάση (0 < ρ < 1). b. Πως τροποποιείται το αρχέτυπο διάνυσμα w i της κλάσης C i όταν γίνεται αποδεκτό ένα νέο διάνυσμα x στην κλάση αυτή; Αλγόριθμος ART-1 (παράδειγμα με δυαδικά διανύσματα εισόδου). Το δίκτυο ART

60 Είσοδος: Δυαδικά (0/1) διανύσματα εισόδου x 1, x P n διαστάσεων Παράμετρος ρ (0 < ρ < 1) Έξοδος: Αρχέτυπα διανύσματα w 1, w K που αντιπροσωπεύουν Κ κλάσεις Μέθοδος: Διαθέτουμε στο σύνολο N νευρώνες με διανύσματα βαρών: w 1, w N Ενεργοποιούμε όλους τους νευρώνες με αρχικές τιμές: w i = 1, 1,, 1 T με i = 1, 2,, N Για κάθε νέο διάνυσμα εισόδου x P { Αλγόριθμος ART-1

61 Βήμα 1: Ονόμασε νικητή τον νευρώνα i για τον οποίο w i T x p = max w i T x p, (η σύγκριση γίνεται μόνο i ανάμεσα στους ενεργούς νευρώνες i και w i = (ε =μικρός θετικός αριθμός) Αλγόριθμος ART-1 w i ε+ j w ij ) Βήμα 2: Ήλεγξε αν το x p ανήκει στην κλάση i (συντονισμός) r = w i T x p ρ συντονισμός j x j p < ρ όχι συντονισμός Όπου r το κλάσμα των bits=1 του x p που είναι 1 και στο w i

62 Αλγόριθμος ART-1 Βήμα 3: Αν υπάρχει συντονισμός ενημέρωσε το αρχέτυπο με την διαδικασία masking: w i w i AND x p Αν δεν υπάρχει συντονισμός απενεργοποίησε τον νευρώνα i και πήγαινε στο Βήμα 1. } Μέχρι να τελειώσουν τα διανύσματα εισόδου ή να μην υπάρχουν άλλοι ενεργοί νευρώνες.

63 Αλγόριθμος ART-1 Ο ART-1 ξεκινάει έχοντας ένα πλήθος ενεργών νευρώνων N που είναι υποψήφιοι για τον ρόλο του αρχέτυπου κάποιας κλάσης (Αρχικοποίηση: w i = 1, 1,, 1 T που σημαίνει πως ο νευρώνας δεν είναι δεσμευμένος σε καμιά κλάση). Όταν εισάγεται ένα δυαδικό διάνυσμα x, οι ενεργοί νευρώνες ανταγωνίζονται με βάση το κανονικοποιημένο εσωτερικό γινόμενο μεταξύ των νευρώνων και του διανύσματος εισόδου.

Το μοντέλο Perceptron

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Το μοντέλο Perceptron Αποτελείται από έναν μόνο νευρώνα McCulloch-Pitts w j x x 1, x2,..., w x T 1 1 x 2 w 2 Σ u x n f(u) Άνυσμα Εισόδου s i x j x n w n -θ w w 1, w2,..., w n T Άνυσμα Βαρών 1 Το μοντέλο

Τεχνητά Νευρωνικά Δίκτυα. Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης

Τεχνητά Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης Ο Βιολογικός Νευρώνας Δενδρίτες Συνάψεις Πυρήνας (Σώμα) Άξονας 2 Ο Βιολογικός Νευρώνας 3 Βασικά Χαρακτηριστικά

Τεχνητά Τσιριγώτης Γεώργιος Τμήμα Μηχανικών Πληροφορικής ΤΕΙ Ανατολικής Μακεδονίας & Θράκης Ο Βιολογικός Νευρώνας Δενδρίτες Συνάψεις Πυρήνας (Σώμα) Άξονας 2 Ο Βιολογικός Νευρώνας 3 Βασικά Χαρακτηριστικά

Συμπίεση Δεδομένων

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Άσκηση 5.1 Για ένα σήμα που έχει τη σ.π.π. του σχήματος να υπολογίσετε: μήκος του δυαδικού κώδικα για Ν επίπεδα κβάντισης για σταθερό μήκος λέξης;

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Άσκηση 5.1 Για ένα σήμα που έχει τη σ.π.π. του σχήματος να υπολογίσετε: μήκος του δυαδικού κώδικα για Ν επίπεδα κβάντισης για σταθερό μήκος λέξης;

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM Μάθηση χωρίς επίβλεψη (unsupervised learning) Σύνολο εκπαίδευσης D={(x n )}, n=1,,n. x n =(x n1,, x nd ) T, δεν υπάρχουν τιμές-στόχοι t n. Προβλήματα μάθησης χωρίς

ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΜΑΘΗΣΗ ΔΙΚΤΥA LVQ και SOM Μάθηση χωρίς επίβλεψη (unsupervised learning) Σύνολο εκπαίδευσης D={(x n )}, n=1,,n. x n =(x n1,, x nd ) T, δεν υπάρχουν τιμές-στόχοι t n. Προβλήματα μάθησης χωρίς

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP)

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Μοντέλο Perceptron πολλών στρωμάτων Multi Layer Perceptron (MLP) x -0,5 a x x 2 0 0 0 0 - -0,5 y y 0 0 x 2 -,5 a 2 θ η τιμή κατωφλίου Μία λύση του προβλήματος XOR Multi Layer Perceptron (MLP) x -0,5 Μία

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ. Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα. Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε.

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες Χρήσης Το

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΥΦΥΗΣ ΕΛΕΓΧΟΣ Ενότητα #12: Εισαγωγή στα Nευρωνικά Δίκτυα Αναστάσιος Ντούνης Τμήμα Μηχανικών Αυτοματισμού Τ.Ε. Άδειες Χρήσης Το

4.3. Γραµµικοί ταξινοµητές

Γραµµικοί ταξινοµητές Γραµµικός ταξινοµητής είναι ένα σύστηµα ταξινόµησης που χρησιµοποιεί γραµµικές διακριτικές συναρτήσεις Οι ταξινοµητές αυτοί αναπαρίστανται συχνά µε οµάδες κόµβων εντός των οποίων

Γραµµικοί ταξινοµητές Γραµµικός ταξινοµητής είναι ένα σύστηµα ταξινόµησης που χρησιµοποιεί γραµµικές διακριτικές συναρτήσεις Οι ταξινοµητές αυτοί αναπαρίστανται συχνά µε οµάδες κόµβων εντός των οποίων

3. O ΑΛΓΟΡΙΘΜΟΣ ΤΟΥ PERCEPTRON

3. O ΑΛΓΟΡΙΘΜΟΣ ΤΟΥ PERCEPRON 3. ΕΙΣΑΓΩΓΗ: Το Perceptron είναι η απλούστερη μορφή Νευρωνικού δικτύου, το οποίο χρησιμοποιείται για την ταξινόμηση ενός ειδικού τύπου προτύπων, που είναι γραμμικά διαχωριζόμενα.

3. O ΑΛΓΟΡΙΘΜΟΣ ΤΟΥ PERCEPRON 3. ΕΙΣΑΓΩΓΗ: Το Perceptron είναι η απλούστερη μορφή Νευρωνικού δικτύου, το οποίο χρησιμοποιείται για την ταξινόμηση ενός ειδικού τύπου προτύπων, που είναι γραμμικά διαχωριζόμενα.

Αριθμητική Ανάλυση & Εφαρμογές

Αριθμητική Ανάλυση & Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 2017-2018 Υπολογισμοί και Σφάλματα Παράσταση Πραγματικών Αριθμών Συστήματα Αριθμών Παράσταση Ακέραιου

Αριθμητική Ανάλυση & Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 2017-2018 Υπολογισμοί και Σφάλματα Παράσταση Πραγματικών Αριθμών Συστήματα Αριθμών Παράσταση Ακέραιου

Υπολογιστική Νοημοσύνη. Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

Υπολογιστική Νοημοσύνη Μάθημα 13: Αναδρομικά Δίκτυα - Recurrent Networks Γενικά Ένα νευρωνικό δίκτυο λέγεται αναδρομικό, εάν υπάρχει έστω και μια σύνδεση από έναν νευρώνα επιπέδου i προς έναν νευρώνα επιπέδου

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 5 o Φροντιστήριο

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

ΘΕΜΑ ο 2.5 µονάδες ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 2 Οκτωβρίου 23 ιάρκεια: 2 ώρες Έστω το παρακάτω γραµµικώς

ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

ΤΕΙ Δυτικής Μακεδονίας ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ 2015-2016 Τεχνητή Νοημοσύνη Νευρώνας Perceptron Διδάσκων: Τσίπουρας Μάρκος Εκπαιδευτικό Υλικό: Τσίπουρας Μάρκος Τζώρτζης Γρηγόρης Περιεχόμενα Εισαγωγή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

οµή δικτύου ΣΧΗΜΑ 8.1

8. ίκτυα Kohonen Το µοντέλο αυτό των δικτύων προτάθηκε το 1984 από τον Kοhonen, και αφορά διαδικασία εκµάθησης χωρίς επίβλεψη, δηλαδή δεν δίδεται καµία εξωτερική επέµβαση σχετικά µε τους στόχους που πρέπει

8. ίκτυα Kohonen Το µοντέλο αυτό των δικτύων προτάθηκε το 1984 από τον Kοhonen, και αφορά διαδικασία εκµάθησης χωρίς επίβλεψη, δηλαδή δεν δίδεται καµία εξωτερική επέµβαση σχετικά µε τους στόχους που πρέπει

Συμπίεση Δεδομένων

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Αναλογικά Ψηφιακά Σήματα Αναλογικό Σήμα x t, t [t min, t max ], x [x min, x max ] Δειγματοληψία t n, x t x n, n = 1,, N Κβάντιση x n x(n) 3 Αλφάβητο

Συμπίεση Δεδομένων 2014-2015 Κβάντιση Δρ. Ν. Π. Σγούρος 2 Αναλογικά Ψηφιακά Σήματα Αναλογικό Σήμα x t, t [t min, t max ], x [x min, x max ] Δειγματοληψία t n, x t x n, n = 1,, N Κβάντιση x n x(n) 3 Αλφάβητο

ΔΙΚΤΥO RBF. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

ΔΙΚΤΥO RBF Αρχιτεκτονική δικτύου RBF Δίκτυα RBF: δίκτυα συναρτήσεων πυρήνα (radial basis function networks). Πρόσθιας τροφοδότησης (feedforward) για προβλήματα μάθησης με επίβλεψη. Εναλλακτικό του MLP.

Τι είναι βαθμωτό μέγεθος? Ένα μέγεθος που περιγράφεται μόνο με έναν αριθμό (π.χ. πίεση)

TETY Εφαρμοσμένα Μαθηματικά Ενότητα ΙΙ: Γραμμική Άλγεβρα Ύλη: Διανυσματικοί χώροι και διανύσματα, μετασχηματισμοί διανυσμάτων, τελεστές και πίνακες, ιδιοδιανύσματα και ιδιοτιμές πινάκων, επίλυση γραμμικών

TETY Εφαρμοσμένα Μαθηματικά Ενότητα ΙΙ: Γραμμική Άλγεβρα Ύλη: Διανυσματικοί χώροι και διανύσματα, μετασχηματισμοί διανυσμάτων, τελεστές και πίνακες, ιδιοδιανύσματα και ιδιοτιμές πινάκων, επίλυση γραμμικών

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Component Analysis, PCA)

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

Α.Τ.ΕΙ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΠΟΛΥΜΕΣΩΝ. ΕΡΓΑΣΤΗΡΙΟ ΤΕΧΝΗΤΩΝ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ

Α.Τ.ΕΙ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΠΟΛΥΜΕΣΩΝ. ΕΡΓΑΣΤΗΡΙΟ ΤΕΧΝΗΤΩΝ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΕΚΜΑΘΗΣΗ ΤΑ ΔΙΚΤΥΑ KOHONEN A. ΕΙΣΑΓΩΓΗ Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα

Α.Τ.ΕΙ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΠΟΛΥΜΕΣΩΝ. ΕΡΓΑΣΤΗΡΙΟ ΤΕΧΝΗΤΩΝ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ ΑΝΤΑΓΩΝΙΣΤΙΚΗ ΕΚΜΑΘΗΣΗ ΤΑ ΔΙΚΤΥΑ KOHONEN A. ΕΙΣΑΓΩΓΗ Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα

Θεώρημα κωδικοποίησης πηγής

Κωδικοποίηση Kωδικοποίηση πηγής Θεώρημα κωδικοποίησης πηγής Καθορίζει ένα θεμελιώδες όριο στον ρυθμό με τον οποίο η έξοδος μιας πηγής πληροφορίας μπορεί να συμπιεσθεί χωρίς να προκληθεί μεγάλη πιθανότητα

Κωδικοποίηση Kωδικοποίηση πηγής Θεώρημα κωδικοποίησης πηγής Καθορίζει ένα θεμελιώδες όριο στον ρυθμό με τον οποίο η έξοδος μιας πηγής πληροφορίας μπορεί να συμπιεσθεί χωρίς να προκληθεί μεγάλη πιθανότητα

1 Αριθμητική κινητής υποδιαστολής και σφάλματα στρογγύλευσης

1 Αριθμητική κινητής υποδιαστολής και σφάλματα στρογγύλευσης Στη συγκεκριμένη ενότητα εξετάζουμε θέματα σχετικά με την αριθμητική πεπερασμένης ακρίβειας που χρησιμοποιούν οι σημερινοί υπολογιστές και τα

1 Αριθμητική κινητής υποδιαστολής και σφάλματα στρογγύλευσης Στη συγκεκριμένη ενότητα εξετάζουμε θέματα σχετικά με την αριθμητική πεπερασμένης ακρίβειας που χρησιμοποιούν οι σημερινοί υπολογιστές και τα

Αριθμητική εύρεση ριζών μη γραμμικών εξισώσεων

Αριθμητική εύρεση ριζών μη γραμμικών εξισώσεων Με τον όρο μη γραμμικές εξισώσεις εννοούμε εξισώσεις της μορφής: f( ) 0 που προέρχονται από συναρτήσεις f () που είναι μη γραμμικές ως προς. Περιέχουν δηλαδή

Αριθμητική εύρεση ριζών μη γραμμικών εξισώσεων Με τον όρο μη γραμμικές εξισώσεις εννοούμε εξισώσεις της μορφής: f( ) 0 που προέρχονται από συναρτήσεις f () που είναι μη γραμμικές ως προς. Περιέχουν δηλαδή

Εισαγωγή στις Τηλεπικοινωνίες. Δομή της παρουσίασης

1 Oct 16 ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΙΡΑΙΩΣ ΣΧΟΛΗ ΤΕΧΝΟΛΟΓΙΩΝ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΕΠΙΚΟΙΝΩΝΙΩΝ ΤΜΗΜΑ ΨΗΦΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ ΕΡΓΑΣΤΗΡΙΟ ΤΗΛΕΠΙΚΟΙΝΩΝΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ Εισαγωγή στις Τηλεπικοινωνίες Διάλεξη 4 η Γεωμετρική Αναπαράσταση

1 Oct 16 ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΙΡΑΙΩΣ ΣΧΟΛΗ ΤΕΧΝΟΛΟΓΙΩΝ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΕΠΙΚΟΙΝΩΝΙΩΝ ΤΜΗΜΑ ΨΗΦΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ ΕΡΓΑΣΤΗΡΙΟ ΤΗΛΕΠΙΚΟΙΝΩΝΙΑΚΩΝ ΣΥΣΤΗΜΑΤΩΝ Εισαγωγή στις Τηλεπικοινωνίες Διάλεξη 4 η Γεωμετρική Αναπαράσταση

ΒΑΣΙΚΑ ΣΤΟΙΧΕΙΑ ΘΕΩΡΙΑΣ ΤΗΣ ΜΕΘΟΔΟΥ SIMPLEX

ΒΑΣΙΚΑ ΣΤΟΙΧΕΙΑ ΘΕΩΡΙΑΣ ΤΗΣ ΜΕΘΟΔΟΥ SIMPLEX Θεμελιώδης αλγόριθμος επίλυσης προβλημάτων Γραμμικού Προγραμματισμού που κάνει χρήση της θεωρίας της Γραμμικής Άλγεβρας Προτάθηκε από το Dantzig (1947) και πλέον

ΒΑΣΙΚΑ ΣΤΟΙΧΕΙΑ ΘΕΩΡΙΑΣ ΤΗΣ ΜΕΘΟΔΟΥ SIMPLEX Θεμελιώδης αλγόριθμος επίλυσης προβλημάτων Γραμμικού Προγραμματισμού που κάνει χρήση της θεωρίας της Γραμμικής Άλγεβρας Προτάθηκε από το Dantzig (1947) και πλέον

6. Στατιστικές μέθοδοι εκπαίδευσης

6. Στατιστικές μέθοδοι εκπαίδευσης Μία διαφορετική μέθοδος εκπαίδευσης των νευρωνικών δικτύων χρησιμοποιεί ιδέες από την Στατιστική Φυσική για να φέρει τελικά το ίδιο αποτέλεσμα όπως οι άλλες μέθοδοι,

6. Στατιστικές μέθοδοι εκπαίδευσης Μία διαφορετική μέθοδος εκπαίδευσης των νευρωνικών δικτύων χρησιμοποιεί ιδέες από την Στατιστική Φυσική για να φέρει τελικά το ίδιο αποτέλεσμα όπως οι άλλες μέθοδοι,

Αριθμητική Ανάλυση και Εφαρμογές

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Αριθμητική Παραγώγιση Εισαγωγή Ορισμός 7. Αν y f x είναι μια συνάρτηση ορισμένη σε ένα διάστημα

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Αριθμητική Παραγώγιση Εισαγωγή Ορισμός 7. Αν y f x είναι μια συνάρτηση ορισμένη σε ένα διάστημα

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 26 Ιανουαρίου 2004 ιάρκεια: 2 ώρες (9:00-:00) Στην παρακάτω

ΘΕΜΑ ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 26 Ιανουαρίου 2004 ιάρκεια: 2 ώρες (9:00-:00) Στην παρακάτω

Γραµµικοί Ταξινοµητές

ΚΕΣ 3: Αναγνώριση Προτύπων και Ανάλυση Εικόνας KEΣ 3 Αναγνώριση Προτύπων και Ανάλυση Εικόνας Γραµµικοί Ταξινοµητές ΤµήµαΕπιστήµης και Τεχνολογίας Τηλεπικοινωνιών Πανεπιστήµιο Πελοποννήσου 7 Ncolas sapatsouls

ΚΕΣ 3: Αναγνώριση Προτύπων και Ανάλυση Εικόνας KEΣ 3 Αναγνώριση Προτύπων και Ανάλυση Εικόνας Γραµµικοί Ταξινοµητές ΤµήµαΕπιστήµης και Τεχνολογίας Τηλεπικοινωνιών Πανεπιστήµιο Πελοποννήσου 7 Ncolas sapatsouls

Το Πολυεπίπεδο Perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

Το Πολυ Perceptron Δίκτυα Πρόσθιας Τροφοδότησης (feedforward) Tο αντίστοιχο γράφημα του δικτύου δεν περιλαμβάνει κύκλους: δεν υπάρχει δηλαδή ανατροφοδότηση της εξόδου ενός νευρώνα προς τους νευρώνες από

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ

ΘΕΜΑ 1 ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 21 Σεπτεµβρίου 2004 ιάρκεια: 3 ώρες Το παρακάτω σύνολο

ΘΕΜΑ 1 ο (2.5 µονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕ ΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΙΚΤΥΑ Τελικές εξετάσεις 21 Σεπτεµβρίου 2004 ιάρκεια: 3 ώρες Το παρακάτω σύνολο

Μάθηση και Γενίκευση. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

Βασικές αρχές εκπαίδευσης ΤΝΔ: το perceptron Βιολογικός Νευρώνας Δενδρίτες, που αποτελούν τις γραμμές εισόδου των ερεθισμάτων (βιολογικών σημάτων) Σώμα, στο οποίο γίνεται η συσσώρευση των ερεθισμάτων και

ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ

ΘΕΜΑ 1 ο (2,5 μονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Τελικές εξετάσεις Πέμπτη 21 Ιουνίου 2012 16:30-19:30 Υποθέστε ότι θέλουμε

ΘΕΜΑ 1 ο (2,5 μονάδες) ΠΑΝΕΠΙΣΤΗΜΙΟ ΜΑΚΕΔΟΝΙΑΣ ΟΙΚΟΝΟΜΙΚΩΝ ΚΑΙ ΚΟΙΝΩΝΙΚΩΝ ΕΠΙΣΤΗΜΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Τελικές εξετάσεις Πέμπτη 21 Ιουνίου 2012 16:30-19:30 Υποθέστε ότι θέλουμε

HY213. ΑΡΙΘΜΗΤΙΚΗ ΑΝΑΛΥΣΗ ΕΛΑΧΙΣΤΑ ΤΕΤΡΑΓΩΝΑ AΝΑΛΥΣΗ ΙΔΙΑΖΟΥΣΩΝ ΤΙΜΩΝ

HY3. ΑΡΙΘΜΗΤΙΚΗ ΑΝΑΛΥΣΗ ΕΛΑΧΙΣΤΑ ΤΕΤΡΑΓΩΝΑ AΝΑΛΥΣΗ ΙΔΙΑΖΟΥΣΩΝ ΤΙΜΩΝ Π. ΤΣΟΜΠΑΝΟΠΟΥΛΟΥ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΕΣΣΑΛΙΑΣ ΤΜΗΜΑ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ & ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ Μέθοδος ελαχίστων τετραγώνων Τα σφάλματα

HY3. ΑΡΙΘΜΗΤΙΚΗ ΑΝΑΛΥΣΗ ΕΛΑΧΙΣΤΑ ΤΕΤΡΑΓΩΝΑ AΝΑΛΥΣΗ ΙΔΙΑΖΟΥΣΩΝ ΤΙΜΩΝ Π. ΤΣΟΜΠΑΝΟΠΟΥΛΟΥ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΕΣΣΑΛΙΑΣ ΤΜΗΜΑ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ & ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ Μέθοδος ελαχίστων τετραγώνων Τα σφάλματα

Χρήστος Ξενάκης. Πανεπιστήμιο Πειραιώς, Τμήμα Ψηφιακών Συστημάτων

ΘΕΩΡΙΑ ΠΛΗΡΟΦΟΡΙΑΣ Κεφάλαιο 10 : Κωδικοποίηση καναλιού Χρήστος Ξενάκης Πανεπιστήμιο Πειραιώς, Τμήμα Ψηφιακών Συστημάτων Περιεχόμενα Ομιλίας Απόσταση και βάρος Hamming Τεχνικές και κώδικες ανίχνευσης &

ΘΕΩΡΙΑ ΠΛΗΡΟΦΟΡΙΑΣ Κεφάλαιο 10 : Κωδικοποίηση καναλιού Χρήστος Ξενάκης Πανεπιστήμιο Πειραιώς, Τμήμα Ψηφιακών Συστημάτων Περιεχόμενα Ομιλίας Απόσταση και βάρος Hamming Τεχνικές και κώδικες ανίχνευσης &

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

Τεχνικές Μείωσης Διαστάσεων. Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Ασκήσεις μελέτης της 19 ης διάλεξης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Πληροφοριακά Συστήματα Διοίκησης

Πληροφοριακά Συστήματα Διοίκησης Τρεις αλγόριθμοι μηχανικής μάθησης ΠΜΣ Λογιστική Χρηματοοικονομική και Διοικητική Επιστήμη ΤΕΙ Ηπείρου @ 2018 Μηχανική μάθηση αναγνώριση προτύπων Η αναγνώριση προτύπων

Πληροφοριακά Συστήματα Διοίκησης Τρεις αλγόριθμοι μηχανικής μάθησης ΠΜΣ Λογιστική Χρηματοοικονομική και Διοικητική Επιστήμη ΤΕΙ Ηπείρου @ 2018 Μηχανική μάθηση αναγνώριση προτύπων Η αναγνώριση προτύπων

Αριθμητική Ανάλυση και Εφαρμογές

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Πεπερασμένες και Διαιρεμένες Διαφορές Εισαγωγή Θα εισάγουμε την έννοια των διαφορών με ένα

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Πεπερασμένες και Διαιρεμένες Διαφορές Εισαγωγή Θα εισάγουμε την έννοια των διαφορών με ένα

Κεφάλαιο 4: Επιλογή σημείου παραγωγής

Κ4.1 Μέθοδος ανάλυσης νεκρού σημείου για την επιλογή διαδικασίας παραγωγής ή σημείου παραγωγής Επιλογή διαδικασίας παραγωγής Η μέθοδος ανάλυσης νεκρού για την επιλογή διαδικασίας παραγωγής αναγνωρίζει

Κ4.1 Μέθοδος ανάλυσης νεκρού σημείου για την επιλογή διαδικασίας παραγωγής ή σημείου παραγωγής Επιλογή διαδικασίας παραγωγής Η μέθοδος ανάλυσης νεκρού για την επιλογή διαδικασίας παραγωγής αναγνωρίζει

Αριθμητική Ανάλυση και Εφαρμογές

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Αριθμητική Ολοκλήρωση Εισαγωγή Έστω ότι η f είναι μία φραγμένη συνάρτηση στο πεπερασμένο

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Αριθμητική Ολοκλήρωση Εισαγωγή Έστω ότι η f είναι μία φραγμένη συνάρτηση στο πεπερασμένο

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 4

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 4 ΤΟ ΔΙΚΤΥΟ PERCEPTRON I. Αρχιτεκτονική του δικτύου Το δίκτυο Perceptron είναι το πρώτο νευρωνικό δίκτυο το οποίο

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 4 ΤΟ ΔΙΚΤΥΟ PERCEPTRON I. Αρχιτεκτονική του δικτύου Το δίκτυο Perceptron είναι το πρώτο νευρωνικό δίκτυο το οποίο

Κινητά Δίκτυα Επικοινωνιών. Συμπληρωματικό υλικό. Προσαρμοστική Ισοστάθμιση Καναλιού

Κινητά Δίκτυα Επικοινωνιών Συμπληρωματικό υλικό Προσαρμοστική Ισοστάθμιση Καναλιού Προσαρμοστικοί Ισοσταθμιστές Για να υπολογίσουμε τους συντελεστές του ισοσταθμιστή MMSE, απαιτείται να λύσουμε ένα γραμμικό

Κινητά Δίκτυα Επικοινωνιών Συμπληρωματικό υλικό Προσαρμοστική Ισοστάθμιση Καναλιού Προσαρμοστικοί Ισοσταθμιστές Για να υπολογίσουμε τους συντελεστές του ισοσταθμιστή MMSE, απαιτείται να λύσουμε ένα γραμμικό

E[ (x- ) ]= trace[(x-x)(x- ) ]

![E[ (x- ) ]= trace[(x-x)(x- ) ] E[ (x- ) ]= trace[(x-x)(x- ) ]](/thumbs/55/36021260.jpg) 1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

1 ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτό το μέρος της πτυχιακής θα ασχοληθούμε λεπτομερώς με το φίλτρο kalman και θα δούμε μια καινούρια έκδοση του φίλτρου πάνω στην εφαρμογή της γραμμικής εκτίμησης διακριτού

Εισαγωγή στην επιστήμη των υπολογιστών

Εισαγωγή στην επιστήμη των υπολογιστών Υπολογιστές και Δεδομένα Κεφάλαιο 3ο Αναπαράσταση Αριθμών www.di.uoa.gr/~organosi 1 Δεκαδικό και Δυαδικό Δεκαδικό σύστημα 2 3 Δεκαδικό και Δυαδικό Δυαδικό Σύστημα

Εισαγωγή στην επιστήμη των υπολογιστών Υπολογιστές και Δεδομένα Κεφάλαιο 3ο Αναπαράσταση Αριθμών www.di.uoa.gr/~organosi 1 Δεκαδικό και Δυαδικό Δεκαδικό σύστημα 2 3 Δεκαδικό και Δυαδικό Δυαδικό Σύστημα

Τμήμα Μηχανικών Η/Υ και Πληροφορικής

Τμήμα Μηχανικών Η/Υ και Πληροφορικής Εργαστήριο Επεξεργασίας Σημάτων και Τηλεπικοινωνιών Ασύρματες και Κινητές Επικοινωνίες Κωδικοποίηση καναλιού Τι θα δούμε στο μάθημα Σύντομη εισαγωγή Γραμμικοί κώδικες

Τμήμα Μηχανικών Η/Υ και Πληροφορικής Εργαστήριο Επεξεργασίας Σημάτων και Τηλεπικοινωνιών Ασύρματες και Κινητές Επικοινωνίες Κωδικοποίηση καναλιού Τι θα δούμε στο μάθημα Σύντομη εισαγωγή Γραμμικοί κώδικες

[1] είναι ταυτοτικά ίση με το μηδέν. Στην περίπτωση που το στήριγμα μιας συνάρτησης ελέγχου φ ( x)

![[1] είναι ταυτοτικά ίση με το μηδέν. Στην περίπτωση που το στήριγμα μιας συνάρτησης ελέγχου φ ( x) [1] είναι ταυτοτικά ίση με το μηδέν. Στην περίπτωση που το στήριγμα μιας συνάρτησης ελέγχου φ ( x)](/thumbs/52/30132893.jpg) [] 9 ΣΥΝΑΡΤΗΣΙΑΚΟΙ ΧΩΡΟΙ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΣ FOURIER Η «συνάρτηση» δέλτα του irac Η «συνάρτηση» δέλτα ορίζεται μέσω της σχέσης φ (0) αν 0 δ[ φ ] = φ δ dx = (9) 0 αν 0 όπου η φ είναι μια συνάρτηση που ανήκει

[] 9 ΣΥΝΑΡΤΗΣΙΑΚΟΙ ΧΩΡΟΙ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΣ FOURIER Η «συνάρτηση» δέλτα του irac Η «συνάρτηση» δέλτα ορίζεται μέσω της σχέσης φ (0) αν 0 δ[ φ ] = φ δ dx = (9) 0 αν 0 όπου η φ είναι μια συνάρτηση που ανήκει

Εθνικό και Καποδιστριακό Πανεπιστήμιο Αθηνών Τμήμα Φυσικής Εισαγωγή στα Συστήματα Τηλεπικοινωνιών Συστήματα Παλμοκωδικής Διαμόρφωσης

Εθνικό και Καποδιστριακό Πανεπιστήμιο Αθηνών Τμήμα Φυσικής Εισαγωγή στα Συστήματα Τηλεπικοινωνιών Συστήματα Παλμοκωδικής Διαμόρφωσης Καθηγητής Ι. Τίγκελης itigelis@phys.uoa.gr ΚΒΑΝΤΙΣΗ Διαδικασία με την

Εθνικό και Καποδιστριακό Πανεπιστήμιο Αθηνών Τμήμα Φυσικής Εισαγωγή στα Συστήματα Τηλεπικοινωνιών Συστήματα Παλμοκωδικής Διαμόρφωσης Καθηγητής Ι. Τίγκελης itigelis@phys.uoa.gr ΚΒΑΝΤΙΣΗ Διαδικασία με την

ΤΕΙ ΣΕΡΡΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΕΠΙΚΟΙΝΩΝΙΩΝ ΕΞΕΤΑΣΗ ΣΤΟ ΜΑΘΗΜΑ «ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ» ΔΕ. 11 ΙΟΥΝΙΟΥ 2012

ΔΕ. ΙΟΥΝΙΟΥ Δίνονται τα εξής πρότυπα: [ ] [ ] [ ] [ ] Άσκηση η ( μονάδες) Χρησιμοποιώντας το κριτήριο της ομοιότητας να απορριφθεί ένα χαρακτηριστικό με βάσει το συντελεστή συσχέτισης. (γράψτε ποιο χαρακτηριστικό

ΔΕ. ΙΟΥΝΙΟΥ Δίνονται τα εξής πρότυπα: [ ] [ ] [ ] [ ] Άσκηση η ( μονάδες) Χρησιμοποιώντας το κριτήριο της ομοιότητας να απορριφθεί ένα χαρακτηριστικό με βάσει το συντελεστή συσχέτισης. (γράψτε ποιο χαρακτηριστικό

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 4 o Φροντιστήριο

Ασκήσεις Φροντιστηρίου 4 o Φροντιστήριο Πρόβλημα 1 ο Ο πίνακας συσχέτισης R x του διανύσματος εισόδου x( στον LMS αλγόριθμο 1 0.5 R x = ορίζεται ως: 0.5 1. Ορίστε το διάστημα των τιμών της παραμέτρου μάθησης

Ασκήσεις Φροντιστηρίου 4 o Φροντιστήριο Πρόβλημα 1 ο Ο πίνακας συσχέτισης R x του διανύσματος εισόδου x( στον LMS αλγόριθμο 1 0.5 R x = ορίζεται ως: 0.5 1. Ορίστε το διάστημα των τιμών της παραμέτρου μάθησης

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΙΑ ΣΥΜΒΑΣΗ: Προκειμένου να καταστήσουμε πιο συμπαγή το συμβολισμό H : ορίζουμε Ετσι έχουμε *=[ ] an *=[ ]. H : * * ΣΗΜΕΙΩΣΗ: Στη συνέχεια εκτός αν ορίζεται

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΙΑ ΣΥΜΒΑΣΗ: Προκειμένου να καταστήσουμε πιο συμπαγή το συμβολισμό H : ορίζουμε Ετσι έχουμε *=[ ] an *=[ ]. H : * * ΣΗΜΕΙΩΣΗ: Στη συνέχεια εκτός αν ορίζεται

ιαφορική εντροπία Σεραφείµ Καραµπογιάς

ιαφορική εντροπία Σεραφείµ Καραµπογιάς Για πηγές διακριτού χρόνου µε συνεχές αλφάβητο, των οποίων οι έξοδοι είναι πραγµατικοί αριθµοί, ορίζεται µια άλλη ποσότητα που µοιάζει µε την εντροπία και καλείται

ιαφορική εντροπία Σεραφείµ Καραµπογιάς Για πηγές διακριτού χρόνου µε συνεχές αλφάβητο, των οποίων οι έξοδοι είναι πραγµατικοί αριθµοί, ορίζεται µια άλλη ποσότητα που µοιάζει µε την εντροπία και καλείται

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis)

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis) Η μέθοδος PCA (Ανάλυση Κύριων Συνιστωσών), αποτελεί μία γραμμική μέθοδο συμπίεσης Δεδομένων η οποία συνίσταται από τον επαναπροσδιορισμό των συντεταγμένων ενός

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis) Η μέθοδος PCA (Ανάλυση Κύριων Συνιστωσών), αποτελεί μία γραμμική μέθοδο συμπίεσης Δεδομένων η οποία συνίσταται από τον επαναπροσδιορισμό των συντεταγμένων ενός

Νευρωνικά ίκτυα και Εξελικτικός

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα Μη επιβλεπόµενη Μάθηση Ανταγωνιστική Μάθηση Αλγόριθµος Leader-follower clusterng Αυτοοργανούµενοι χάρτες Kohonen Ανταγωνισµός Συνεργασία

Νευρωνικά ίκτυα και Εξελικτικός Προγραµµατισµός Σηµερινό Μάθηµα Μη επιβλεπόµενη Μάθηση Ανταγωνιστική Μάθηση Αλγόριθµος Leader-follower clusterng Αυτοοργανούµενοι χάρτες Kohonen Ανταγωνισµός Συνεργασία

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν.

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης Ελαχιστοποίηση συνάρτησης σφάλματος Εκπαίδευση ΤΝΔ: μπορεί να διατυπωθεί ως πρόβλημα ελαχιστοποίησης μιας συνάρτησης σφάλματος E(w)

Εκπαίδευση ΤΝΔ με ελαχιστοποίηση του τετραγωνικού σφάλματος εκπαίδευσης Ελαχιστοποίηση συνάρτησης σφάλματος Εκπαίδευση ΤΝΔ: μπορεί να διατυπωθεί ως πρόβλημα ελαχιστοποίησης μιας συνάρτησης σφάλματος E(w)

Ανταγωνιστική Εκμάθηση Δίκτυα Kohonen. Κυριακίδης Ιωάννης 2013

Ανταγωνιστική Εκμάθηση Δίκτυα Kohonen Κυριακίδης Ιωάννης 2013 Εισαγωγή Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα, υπήρχε μια διαδικασία εκπαίδευσης του δικτύου, κατά την οποία είχαμε διανύσματα

Ανταγωνιστική Εκμάθηση Δίκτυα Kohonen Κυριακίδης Ιωάννης 2013 Εισαγωγή Στα προβλήματα που έχουμε αντιμετωπίσει μέχρι τώρα, υπήρχε μια διαδικασία εκπαίδευσης του δικτύου, κατά την οποία είχαμε διανύσματα

Σ ΤΑΤ Ι Σ Τ Ι Κ Η. Statisticum collegium iv

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium iv Στατιστική Συμπερασματολογία Ι Σημειακές Εκτιμήσεις Διαστήματα Εμπιστοσύνης Στατιστική Συμπερασματολογία (Statistical Inference) Το πεδίο της Στατιστικής Συμπερασματολογία,

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium iv Στατιστική Συμπερασματολογία Ι Σημειακές Εκτιμήσεις Διαστήματα Εμπιστοσύνης Στατιστική Συμπερασματολογία (Statistical Inference) Το πεδίο της Στατιστικής Συμπερασματολογία,

Γραμμικός Προγραμματισμός Μέθοδος Simplex

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ Επιχειρησιακή Έρευνα Γραμμικός Προγραμματισμός Μέθοδος Simplex Η παρουσίαση προετοιμάστηκε από τον Ν.Α. Παναγιώτου Περιεχόμενα Παρουσίασης 1. Πρότυπη Μορφή ΓΠ 2. Πινακοποίηση

ΕΘΝΙΚΟ ΜΕΤΣΟΒΙΟ ΠΟΛΥΤΕΧΝΕΙΟ Επιχειρησιακή Έρευνα Γραμμικός Προγραμματισμός Μέθοδος Simplex Η παρουσίαση προετοιμάστηκε από τον Ν.Α. Παναγιώτου Περιεχόμενα Παρουσίασης 1. Πρότυπη Μορφή ΓΠ 2. Πινακοποίηση

Κεφάλαιο 4: Επιλογή σημείου παραγωγής

Κεφάλαιο 4: Επιλογή σημείου παραγωγής Κ4.1 Μέθοδος ανάλυσης νεκρού σημείου για την επιλογή διαδικασίας παραγωγής ή σημείου παραγωγής Επιλογή διαδικασίας παραγωγής Η μέθοδος ανάλυσης νεκρού για την επιλογή

Κεφάλαιο 4: Επιλογή σημείου παραγωγής Κ4.1 Μέθοδος ανάλυσης νεκρού σημείου για την επιλογή διαδικασίας παραγωγής ή σημείου παραγωγής Επιλογή διαδικασίας παραγωγής Η μέθοδος ανάλυσης νεκρού για την επιλογή

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος Χιωτίδης Γεώργιος Τμήμα Λογιστικής και Χρηματοοικονομικής Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

Ποσοτικές Μέθοδοι στη Διοίκηση Επιχειρήσεων ΙΙ Σύνολο- Περιεχόμενο Μαθήματος Χιωτίδης Γεώργιος Τμήμα Λογιστικής και Χρηματοοικονομικής Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

Αναγνώριση Προτύπων (Pattern Recognition) Μπεϋζιανή Θεωρία Αποφάσεων (Bayesian Decision Theory) Π. Τσακαλίδης

Αναγνώριση Προτύπων (Pattern Recognton Μπεϋζιανή Θεωρία Αποφάσεων (Bayesan Decson Theory Π. Τσακαλίδης ΠΑΝΕΠΙΣΤΗΜΙΟ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΠΙΣΤΗΜΗΣ ΥΠΟΛΟΓΙΣΤΩΝ Μπεϋζιανή Θεωρία Αποφάσεων (Bayes Decson theory Στατιστικά

Αναγνώριση Προτύπων (Pattern Recognton Μπεϋζιανή Θεωρία Αποφάσεων (Bayesan Decson Theory Π. Τσακαλίδης ΠΑΝΕΠΙΣΤΗΜΙΟ ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΠΙΣΤΗΜΗΣ ΥΠΟΛΟΓΙΣΤΩΝ Μπεϋζιανή Θεωρία Αποφάσεων (Bayes Decson theory Στατιστικά

Ψηφιακές Τηλεπικοινωνίες

Ψηφιακές Τηλεπικοινωνίες Κωδικοποίηση Αναλογικής Πηγής: Κβάντιση Εισαγωγή Αναλογική πηγή: μετά από δειγματοληψία γίνεται διακριτού χρόνου άπειρος αριθμός bits/έξοδο για τέλεια αναπαράσταση Θεωρία Ρυθμού-Παραμόρφωσης

Ψηφιακές Τηλεπικοινωνίες Κωδικοποίηση Αναλογικής Πηγής: Κβάντιση Εισαγωγή Αναλογική πηγή: μετά από δειγματοληψία γίνεται διακριτού χρόνου άπειρος αριθμός bits/έξοδο για τέλεια αναπαράσταση Θεωρία Ρυθμού-Παραμόρφωσης

ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - 02/07/08) ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ

Ονοματεπώνυμο:......... Α.Μ....... Ετος... ΑΙΘΟΥΣΑ:....... I. (περί τις 55μ. = ++5++. Σωστό ή Λάθος: ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - //8 ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ (αʹ Αν AB = BA όπου A, B τετραγωνικά και

Ονοματεπώνυμο:......... Α.Μ....... Ετος... ΑΙΘΟΥΣΑ:....... I. (περί τις 55μ. = ++5++. Σωστό ή Λάθος: ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - //8 ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ (αʹ Αν AB = BA όπου A, B τετραγωνικά και

Επίλυση Συστήματος Γραμμικών Διαφορικών Εξισώσεων

Επίλυση Συστήματος Γραμμικών Διαφορικών Εξισώσεων. Γραμμικοί Μετασχηματισμοί Ανυσμάτων Θεωρούμε χώρο δύο διαστάσεων και συμβατικά ένα ορθογώνιο σύστημα αξόνων για την περιγραφή κάθε ανύσματος του χώρου

Επίλυση Συστήματος Γραμμικών Διαφορικών Εξισώσεων. Γραμμικοί Μετασχηματισμοί Ανυσμάτων Θεωρούμε χώρο δύο διαστάσεων και συμβατικά ένα ορθογώνιο σύστημα αξόνων για την περιγραφή κάθε ανύσματος του χώρου

ΗΜΥ 100 Εισαγωγή στην Τεχνολογία

ΗΜΥ 100 Εισαγωγή στην Τεχνολογία Δρ. Στέλιος Τιμοθέου ΤΜΗΜΑ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ ΚΑΙ ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ ΠΟΛΥΤΕΧΝΙΚΗ ΣΧΟΛΗ ΠΑΝΕΠΙΣΤΗΜΙΟ ΚΥΠΡΟΥ ΤΑ ΘΕΜΑΤΑ ΜΑΣ ΣΗΜΕΡΑ Αναλογικά και ψηφιακά συστήματα Μετατροπή

ΗΜΥ 100 Εισαγωγή στην Τεχνολογία Δρ. Στέλιος Τιμοθέου ΤΜΗΜΑ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ ΚΑΙ ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ ΠΟΛΥΤΕΧΝΙΚΗ ΣΧΟΛΗ ΠΑΝΕΠΙΣΤΗΜΙΟ ΚΥΠΡΟΥ ΤΑ ΘΕΜΑΤΑ ΜΑΣ ΣΗΜΕΡΑ Αναλογικά και ψηφιακά συστήματα Μετατροπή

Σ ΤΑΤ Ι Σ Τ Ι Κ Η. Statisticum collegium Iii

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium Iii Η Κανονική Κατανομή Λέμε ότι μία τυχαία μεταβλητή X, ακολουθεί την Κανονική Κατανομή με παραμέτρους και και συμβολίζουμε X N, αν έχει συνάρτηση πυκνότητας

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i Statisticum collegium Iii Η Κανονική Κατανομή Λέμε ότι μία τυχαία μεταβλητή X, ακολουθεί την Κανονική Κατανομή με παραμέτρους και και συμβολίζουμε X N, αν έχει συνάρτηση πυκνότητας

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

ΤΕΙ ΣΕΡΡΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΕΠΙΚΟΙΝΩΝΙΩΝ ΕΞΕΤΑΣΗ ΣΤΟ ΜΑΘΗΜΑ «ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ» ΠΑ. 7 ΣΕΠΤΕΜΒΡΙΟΥ 2012

ΠΑ. 7 ΣΕΠΤΕΜΒΡΙΟΥ Δίνονται τα εξής πρότυπα: [ ] [ ] [ ] [ ] Άσκηση η (3 μονάδες) Χρησιμοποιώντας το κριτήριο της ομοιότητας να απορριφθεί ένα χαρακτηριστικό με βάση το συντελεστή συσχέτισης. (γράψτε ποιο

ΠΑ. 7 ΣΕΠΤΕΜΒΡΙΟΥ Δίνονται τα εξής πρότυπα: [ ] [ ] [ ] [ ] Άσκηση η (3 μονάδες) Χρησιμοποιώντας το κριτήριο της ομοιότητας να απορριφθεί ένα χαρακτηριστικό με βάση το συντελεστή συσχέτισης. (γράψτε ποιο

Παρουσίαση 2 η : Αρχές εκτίμησης παραμέτρων Μέρος 1 ο

Εφαρμογές Ανάλυσης Σήματος στη Γεωδαισία Παρουσίαση η : Αρχές εκτίμησης παραμέτρων Μέρος ο Βασίλειος Δ. Ανδριτσάνος Αναπληρωτής Καθηγητής Γεώργιος Χλούπης Επίκουρος Καθηγητής Τμήμα Μηχανικών Τοπογραφίας

Εφαρμογές Ανάλυσης Σήματος στη Γεωδαισία Παρουσίαση η : Αρχές εκτίμησης παραμέτρων Μέρος ο Βασίλειος Δ. Ανδριτσάνος Αναπληρωτής Καθηγητής Γεώργιος Χλούπης Επίκουρος Καθηγητής Τμήμα Μηχανικών Τοπογραφίας

Συμπίεση Δεδομένων

Συμπίεση Δεδομένων 014-015 Μοναδικά Αποκωδικοποιήσιμοι Κώδικες Δρ. Ν. Π. Σγούρος Έλεγος μοναδικής Αποκωδικοποίησης Γενικοί ορισμοί Έστω δύο κωδικές λέξεις α,β με μήκη,m και

Συμπίεση Δεδομένων 014-015 Μοναδικά Αποκωδικοποιήσιμοι Κώδικες Δρ. Ν. Π. Σγούρος Έλεγος μοναδικής Αποκωδικοποίησης Γενικοί ορισμοί Έστω δύο κωδικές λέξεις α,β με μήκη,m και

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας. Version 2

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΗ ΓΡΑΜΜΙΚΟΙ ΤΑΞΙΝΟΜΗΤΕΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Η παραπάνω ανάλυση ήταν χρήσιμη προκειμένου να κατανοήσουμε τη λογική των δικτύων perceptrons πολλών επιπέδων

Σέργιος Θεοδωρίδης Κωνσταντίνος Κουτρούμπας Verson ΜΗ ΓΡΑΜΜΙΚΟΙ ΤΑΞΙΝΟΜΗΤΕΣ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ Η παραπάνω ανάλυση ήταν χρήσιμη προκειμένου να κατανοήσουμε τη λογική των δικτύων perceptrons πολλών επιπέδων

Μέθοδοι πολυδιάστατης ελαχιστοποίησης

Μέθοδοι πολυδιάστατης ελαχιστοποίησης με παραγώγους Μέθοδοι πολυδιάστατης ελαχιστοποίησης Δ. Γ. Παπαγεωργίου Τμήμα Μηχανικών Επιστήμης Υλικών Πανεπιστήμιο Ιωαννίνων dpapageo@cc.uoi.gr http://pc64.materials.uoi.gr/dpapageo

Μέθοδοι πολυδιάστατης ελαχιστοποίησης με παραγώγους Μέθοδοι πολυδιάστατης ελαχιστοποίησης Δ. Γ. Παπαγεωργίου Τμήμα Μηχανικών Επιστήμης Υλικών Πανεπιστήμιο Ιωαννίνων dpapageo@cc.uoi.gr http://pc64.materials.uoi.gr/dpapageo

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ. Σχήμα 1 Η λειτουργία του νευρώνα

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 1 Ο Νευρώνας Τα τεχνικά νευρωνικά δίκτυα αποτελούν μια προσπάθεια μαθηματικής προσομοίωσης της λειτουργίας του ανθρώπινου

Α.Τ.Ε.Ι ΚΡΗΤΗΣ ΤΜΗΜΑ ΕΦΑΡΜΟΣΜΕΝΗΣ ΠΛΗΡΟΦΟΡΙΚΗΣ & ΠΟΛΥΜΕΣΩΝ ΕΡΓΑΣΤΗΡΙΟ ΝΕΥΡΩΝΙΚΩΝ ΔΙΚΤΥΩΝ 1 Ο Νευρώνας Τα τεχνικά νευρωνικά δίκτυα αποτελούν μια προσπάθεια μαθηματικής προσομοίωσης της λειτουργίας του ανθρώπινου

HMY 795: Αναγνώριση Προτύπων. Διαλέξεις 15-16

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

HMY 795: Αναγνώριση Προτύπων Διαλέξεις 15-16 Νευρωνικά Δίκτυα(Neural Networks) Fisher s linear discriminant: Μείωση διαστάσεων (dimensionality reduction) y Τ =w x s + s =w S w 2 2 Τ 1 2 W ( ) 2 2 ( ) m2

Εισαγωγή στην επιστήμη των υπολογιστών. Πράξεις με μπιτ

Εισαγωγή στην επιστήμη των υπολογιστών Πράξεις με μπιτ 1 Πράξεις με μπιτ 2 Αριθμητικές Πράξεις σε Ακέραιους Πρόσθεση, Αφαίρεση, Πολλαπλασιασμός, Διαίρεση 3 Πρόσθεση στη μορφή συμπληρώματος ως προς δύο

Εισαγωγή στην επιστήμη των υπολογιστών Πράξεις με μπιτ 1 Πράξεις με μπιτ 2 Αριθμητικές Πράξεις σε Ακέραιους Πρόσθεση, Αφαίρεση, Πολλαπλασιασμός, Διαίρεση 3 Πρόσθεση στη μορφή συμπληρώματος ως προς δύο

E [ -x ^2 z] = E[x z]

![E [ -x ^2 z] = E[x z] E [ -x ^2 z] = E[x z]](/thumbs/69/60621176.jpg) 1 1.ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτήν την διάλεξη θα πάμε στο φίλτρο με περισσότερες λεπτομέρειες, και θα παράσχουμε μια νέα παραγωγή για το φίλτρο Kalman, αυτή τη φορά βασισμένο στην ιδέα της γραμμικής

1 1.ΦΙΛΤΡΟ KALMAN ΔΙΑΚΡΙΤΟΥ ΧΡΟΝΟΥ Σε αυτήν την διάλεξη θα πάμε στο φίλτρο με περισσότερες λεπτομέρειες, και θα παράσχουμε μια νέα παραγωγή για το φίλτρο Kalman, αυτή τη φορά βασισμένο στην ιδέα της γραμμικής

ΕΙΣΑΓΩΓΗ ΣΤΗΝ ΠΛΗΡΟΦΟΡΙΚΗ

ΤΕΙ ΙΟΝΙΩΝ ΝΗΣΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΓΩΝ ΠΛΗΡΟΦΟΡΙΚΗΣ ΣΤΗ ΔΙΟΙΚΗΣΗ ΚΑΙ ΣΤΗΝ ΟΙΚΟΝΟΜΙΑ 7 Ο ΜΑΘΗΜΑ ΕΙΣΑΓΩΓΗ ΣΤΗΝ ΠΛΗΡΟΦΟΡΙΚΗ ΑΠΟΣΤΟΛΙΑ ΠΑΓΓΕ Περιεχόμενα 2 Δυαδικό Σύστημα Προσημασμένοι δυαδικοί αριθμοί Αφαίρεση

ΤΕΙ ΙΟΝΙΩΝ ΝΗΣΩΝ ΤΜΗΜΑ ΕΦΑΡΜΟΓΩΝ ΠΛΗΡΟΦΟΡΙΚΗΣ ΣΤΗ ΔΙΟΙΚΗΣΗ ΚΑΙ ΣΤΗΝ ΟΙΚΟΝΟΜΙΑ 7 Ο ΜΑΘΗΜΑ ΕΙΣΑΓΩΓΗ ΣΤΗΝ ΠΛΗΡΟΦΟΡΙΚΗ ΑΠΟΣΤΟΛΙΑ ΠΑΓΓΕ Περιεχόμενα 2 Δυαδικό Σύστημα Προσημασμένοι δυαδικοί αριθμοί Αφαίρεση

Α.Τ.Ε.Ι. ΜΑΚΕΔΟΝΙΑΣ Τμήμα πληροφορικής και επικοινωνιών. Συμπίεση ψηφιακών εικόνων με ανάλυση κύριων συνιστωσών και χρήση νευρωνικού δικτύου.

ΑΤΕΙ ΜΑΚΕΔΟΝΙΑΣ Τμήμα πληροφορικής και επικοινωνιών Συμπίεση ψηφιακών εικόνων με ανάλυση κύριων συνιστωσών και χρήση νευρωνικού δικτύου Ψηφιακή είκόνα Η ψηφιακή εικόνα είναι ένα πεπερασμένο σύνολο περιοχών

ΑΤΕΙ ΜΑΚΕΔΟΝΙΑΣ Τμήμα πληροφορικής και επικοινωνιών Συμπίεση ψηφιακών εικόνων με ανάλυση κύριων συνιστωσών και χρήση νευρωνικού δικτύου Ψηφιακή είκόνα Η ψηφιακή εικόνα είναι ένα πεπερασμένο σύνολο περιοχών

Υπολογιστική Νοημοσύνη. Μάθημα 4: Μάθηση στον απλό τεχνητό νευρώνα (2)

Υπολογιστική Νοημοσύνη Μάθημα 4: Μάθηση στον απλό τεχνητό νευρώνα (2) Ο κανόνας Δέλτα για συνεχείς συναρτήσεις ενεργοποίησης (1/2) Για συνεχείς συναρτήσεις ενεργοποίησης, θα θέλαμε να αλλάξουμε περισσότερο

Υπολογιστική Νοημοσύνη Μάθημα 4: Μάθηση στον απλό τεχνητό νευρώνα (2) Ο κανόνας Δέλτα για συνεχείς συναρτήσεις ενεργοποίησης (1/2) Για συνεχείς συναρτήσεις ενεργοποίησης, θα θέλαμε να αλλάξουμε περισσότερο

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 4: Νευρωνικά Δίκτυα στην Ταξιμόμηση Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό

Αναγνώριση Προτύπων Ι Ενότητα 4: Νευρωνικά Δίκτυα στην Ταξιμόμηση Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό

ΕΡΩΤΗΣΕΙΣ ΘΕΩΡΙΑΣ ΜΑΘΗΜΑΤΙΚΑ Β ΓΥΜΝΑΣΙΟΥ. ΜΕΡΟΣ 1ο ΑΛΓΕΒΡΑ

1. Τι καλείται μεταβλητή; ΕΡΩΤΗΣΕΙΣ ΘΕΩΡΙΑΣ ΜΑΘΗΜΑΤΙΑ Β ΓΥΜΝΑΣΙΟΥ ΜΕΡΟΣ 1ο ΑΛΓΕΒΡΑ Μεταβλητή είναι ένα γράμμα (π.χ., y, t, ) που το χρησιμοποιούμε για να παραστήσουμε ένα οποιοδήποτε στοιχείο ενός συνόλου..

1. Τι καλείται μεταβλητή; ΕΡΩΤΗΣΕΙΣ ΘΕΩΡΙΑΣ ΜΑΘΗΜΑΤΙΑ Β ΓΥΜΝΑΣΙΟΥ ΜΕΡΟΣ 1ο ΑΛΓΕΒΡΑ Μεταβλητή είναι ένα γράμμα (π.χ., y, t, ) που το χρησιμοποιούμε για να παραστήσουμε ένα οποιοδήποτε στοιχείο ενός συνόλου..

ΕΡΓΑΣΤΗΡΙΑΚΕΣ ΑΣΚΗΣΕΙΣ C ΣΕΙΡΑ 1 η

Δ.Π.Θ. - Πολυτεχνική Σχολή Τμήμα Μηχανικών Παραγωγής & Διοίκησης Ακαδ. έτος 2016-2017 Τομέας Συστημάτων Παραγωγής Εξάμηνο Β Αναπληρωτής Καθηγητής Στέφανος Δ. Κατσαβούνης ΜΑΘΗΜΑ : ΔΟΜΗΜΕΝΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ

Δ.Π.Θ. - Πολυτεχνική Σχολή Τμήμα Μηχανικών Παραγωγής & Διοίκησης Ακαδ. έτος 2016-2017 Τομέας Συστημάτων Παραγωγής Εξάμηνο Β Αναπληρωτής Καθηγητής Στέφανος Δ. Κατσαβούνης ΜΑΘΗΜΑ : ΔΟΜΗΜΕΝΟΣ ΠΡΟΓΡΑΜΜΑΤΙΣΜΟΣ

3.7 Παραδείγματα Μεθόδου Simplex

3.7 Παραδείγματα Μεθόδου Simplex Παράδειγμα 1ο (Παράδειγμα 1ο - Κεφάλαιο 2ο - σελ. 10): Το πρόβλημα εκφράζεται από το μαθηματικό μοντέλο: max z = 600x T + 250x K + 750x Γ + 450x B 5x T + x K + 9x Γ + 12x

3.7 Παραδείγματα Μεθόδου Simplex Παράδειγμα 1ο (Παράδειγμα 1ο - Κεφάλαιο 2ο - σελ. 10): Το πρόβλημα εκφράζεται από το μαθηματικό μοντέλο: max z = 600x T + 250x K + 750x Γ + 450x B 5x T + x K + 9x Γ + 12x

4. Μέθοδοι αναγνώρισης ταξινοµητές µε επόπτη

ΑΕΙ Σερρών 4. Μέθοδοι αναγνώρισης ταξινοµητές µε επόπτη 4.. Αναγνώριση µε βάση τα κέντρα των τάξεων Είναι µια απλοϊκή µέθοδος αναγνώρισης µε επόπτη σύµφωνα µε την οποία κατά την εκµάθηση υπολογίζεται η

ΑΕΙ Σερρών 4. Μέθοδοι αναγνώρισης ταξινοµητές µε επόπτη 4.. Αναγνώριση µε βάση τα κέντρα των τάξεων Είναι µια απλοϊκή µέθοδος αναγνώρισης µε επόπτη σύµφωνα µε την οποία κατά την εκµάθηση υπολογίζεται η

Αναλογικά & Ψηφιακά Κυκλώματα ιαφάνειες Μαθήματος ρ. Μηχ. Μαραβελάκης Εμ.

Αναλογικά & Ψηφιακά Κυκλώματα ιαφάνειες Μαθήματος ρ. Μηχ. Μαραβελάκης Εμ. 1 Εισαγωγή Αναλογικό σήμα (analog signal): συνεχής συνάρτηση στην οποία η ανεξάρτητη μεταβλητή και η εξαρτημένη μεταβλητή (π.χ.

Αναλογικά & Ψηφιακά Κυκλώματα ιαφάνειες Μαθήματος ρ. Μηχ. Μαραβελάκης Εμ. 1 Εισαγωγή Αναλογικό σήμα (analog signal): συνεχής συνάρτηση στην οποία η ανεξάρτητη μεταβλητή και η εξαρτημένη μεταβλητή (π.χ.

Εισαγωγή στην Πληροφορική & τον Προγραμματισμό

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα Εισαγωγή στην Πληροφορική & τον Προγραμματισμό Ενότητα 3 η : Κωδικοποίηση & Παράσταση Δεδομένων Ι. Ψαρομήλιγκος Χ. Κυτάγιας Τμήμα

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα Εισαγωγή στην Πληροφορική & τον Προγραμματισμό Ενότητα 3 η : Κωδικοποίηση & Παράσταση Δεδομένων Ι. Ψαρομήλιγκος Χ. Κυτάγιας Τμήμα

ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ. ΕΝΟΤΗΤΑ: Γραμμικές Συναρτήσεις Διάκρισης. ΔΙΔΑΣΚΟΝΤΕΣ: Βλάμος Π. Αυλωνίτης Μ. ΙΟΝΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ

ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΕΝΟΤΗΤΑ: Γραμμικές Συναρτήσεις Διάκρισης ΙΟΝΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΔΙΔΑΣΚΟΝΤΕΣ: Βλάμος Π. Αυλωνίτης Μ. Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΕΝΟΤΗΤΑ: Γραμμικές Συναρτήσεις Διάκρισης ΙΟΝΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΔΙΔΑΣΚΟΝΤΕΣ: Βλάμος Π. Αυλωνίτης Μ. Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες χρήσης

Συνήθεις διαφορικές εξισώσεις προβλήματα οριακών τιμών

Συνήθεις διαφορικές εξισώσεις προβλήματα οριακών τιμών Οι παρούσες σημειώσεις αποτελούν βοήθημα στο μάθημα Αριθμητικές Μέθοδοι του 5 ου εξαμήνου του ΤΜΜ ημήτρης Βαλουγεώργης Καθηγητής Εργαστήριο Φυσικών

Συνήθεις διαφορικές εξισώσεις προβλήματα οριακών τιμών Οι παρούσες σημειώσεις αποτελούν βοήθημα στο μάθημα Αριθμητικές Μέθοδοι του 5 ου εξαμήνου του ΤΜΜ ημήτρης Βαλουγεώργης Καθηγητής Εργαστήριο Φυσικών

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

HMY 795: Αναγνώριση Προτύπων Διάλεξη 2 Επισκόπηση θεωρίας πιθανοτήτων Τυχαίες μεταβλητές: Βασικές έννοιες Τυχαία μεταβλητή: Μεταβλητή της οποίας δε γνωρίζουμε με βεβαιότητα την τιμή (σε αντίθεση με τις

2. Ανάλυση και Σύνθεση κυματομορφών με την μέθοδο Fourier

2.1 2. Ανάλυση και Σύνθεση κυματομορφών με την μέθοδο Fourier 2.1 Εισαγωγή Η βασική ιδέα στην ανάλυση των κυματομορφών με την βοήθεια της μεθόδου Fourier συνίσταται στο ότι μία κυματομορφή μιας οποιασδήποτε

2.1 2. Ανάλυση και Σύνθεση κυματομορφών με την μέθοδο Fourier 2.1 Εισαγωγή Η βασική ιδέα στην ανάλυση των κυματομορφών με την βοήθεια της μεθόδου Fourier συνίσταται στο ότι μία κυματομορφή μιας οποιασδήποτε

ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ Ενότητα: Αναγνώριση Διεργασίας - Προσαρμοστικός Έλεγχος (Process Identification) Αλαφοδήμος Κωνσταντίνος

ΕΛΛΗΝΙΚΗ ΔΗΜΟΚΡΑΤΙΑ Ανώτατο Εκπαιδευτικό Ίδρυμα Πειραιά Τεχνολογικού Τομέα ΕΛΕΓΧΟΣ ΠΑΡΑΓΩΓΙΚΩΝ ΔΙΕΡΓΑΣΙΩΝ Ενότητα: Αναγνώριση Διεργασίας - Προσαρμοστικός Έλεγχος (Process Identification) Αλαφοδήμος Κωνσταντίνος

Σ ΤΑΤ Ι Σ Τ Ι Κ Η ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ Κατανομή Δειγματοληψίας του Δειγματικού Μέσου Ο Δειγματικός Μέσος X είναι μια Τυχαία Μεταβλητή. Καθώς η επιλογή και χρήση διαφορετικών δειγμάτων από έναν

Σ ΤΑΤ Ι Σ Τ Ι Κ Η i ΤΜΗΜΑ ΔΙΟΙΚΗΣΗΣ ΕΠΙΧΕΙΡΗΣΕΩΝ Κατανομή Δειγματοληψίας του Δειγματικού Μέσου Ο Δειγματικός Μέσος X είναι μια Τυχαία Μεταβλητή. Καθώς η επιλογή και χρήση διαφορετικών δειγμάτων από έναν

Εισαγωγή στους Νευρώνες. Κυριακίδης Ιωάννης 2013

Εισαγωγή στους Νευρώνες Κυριακίδης Ιωάννης 2013 Τι είναι τα Τεχνητά Νευρωνικά Δίκτυα; Είναι μια προσπάθεια μαθηματικής προσομοίωσης της λειτουργίας του ανθρώπινου εγκεφάλου. Είναι ένα υπολογιστικό μοντέλο

Εισαγωγή στους Νευρώνες Κυριακίδης Ιωάννης 2013 Τι είναι τα Τεχνητά Νευρωνικά Δίκτυα; Είναι μια προσπάθεια μαθηματικής προσομοίωσης της λειτουργίας του ανθρώπινου εγκεφάλου. Είναι ένα υπολογιστικό μοντέλο

Οι Εξελικτικοί Αλγόριθμοι (ΕΑ) είναι καθολικοί στοχαστικοί αλγόριθμοι βελτιστοποίησης, εμπνευσμένοι από τις βασικές αρχές της φυσικής εξέλιξης.

Οι Εξελικτικοί Αλγόριθμοι (ΕΑ) είναι καθολικοί στοχαστικοί αλγόριθμοι βελτιστοποίησης, εμπνευσμένοι από τις βασικές αρχές της φυσικής εξέλιξης. Ένα από τα γνωστότερα παραδείγματα των ΕΑ είναι ο Γενετικός

Οι Εξελικτικοί Αλγόριθμοι (ΕΑ) είναι καθολικοί στοχαστικοί αλγόριθμοι βελτιστοποίησης, εμπνευσμένοι από τις βασικές αρχές της φυσικής εξέλιξης. Ένα από τα γνωστότερα παραδείγματα των ΕΑ είναι ο Γενετικός

Ακαδημαϊκό Έτος , Χειμερινό Εξάμηνο Διδάσκων Καθ.: Νίκος Τσαπατσούλης

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΛΟΠΟΝΝΗΣΟΥ, ΤΜΗΜΑ ΤΕΧΝΟΛΟΓΙΑΣ ΤΗΛΕΠΙΚΟΙΝΩΝΙΩΝ ΚΕΣ 3: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΚΑΙ ΑΝΑΛΥΣΗ ΕΙΚΟΝΑΣ Ακαδημαϊκό Έτος 7 8, Χειμερινό Εξάμηνο Καθ.: Νίκος Τσαπατσούλης ΕΡΩΤΗΣΕΙΣ ΕΠΑΝΑΛΗΨΗΣ Το παρόν

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΛΟΠΟΝΝΗΣΟΥ, ΤΜΗΜΑ ΤΕΧΝΟΛΟΓΙΑΣ ΤΗΛΕΠΙΚΟΙΝΩΝΙΩΝ ΚΕΣ 3: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΚΑΙ ΑΝΑΛΥΣΗ ΕΙΚΟΝΑΣ Ακαδημαϊκό Έτος 7 8, Χειμερινό Εξάμηνο Καθ.: Νίκος Τσαπατσούλης ΕΡΩΤΗΣΕΙΣ ΕΠΑΝΑΛΗΨΗΣ Το παρόν

Ένα αναλογικό σήμα περιέχει άπειρες πιθανές τιμές. Για παράδειγμα ένας απλός ήχος αν τον βλέπαμε σε ένα παλμογράφο θα έμοιαζε με το παρακάτω:

Σημειώσεις Δικτύων Αναλογικά και ψηφιακά σήματα Ένα αναλογικό σήμα περιέχει άπειρες πιθανές τιμές. Για παράδειγμα ένας απλός ήχος αν τον βλέπαμε σε ένα παλμογράφο θα έμοιαζε με το παρακάτω: Χαρακτηριστικά

Σημειώσεις Δικτύων Αναλογικά και ψηφιακά σήματα Ένα αναλογικό σήμα περιέχει άπειρες πιθανές τιμές. Για παράδειγμα ένας απλός ήχος αν τον βλέπαμε σε ένα παλμογράφο θα έμοιαζε με το παρακάτω: Χαρακτηριστικά