Αριστοτελειο Πανεπιστημιο Θεσσαλονικης

|

|

|

- Ἁλκυόνη Βασιλείου

- 8 χρόνια πριν

- Προβολές:

Transcript

1 Αριστοτελειο Πανεπιστημιο Θεσσαλονικης Τμημα Πληροφορικης Κατευθυνση Ψηφιακων Μεσων Εφαρμογές Τυχαίων Περίπατων στην Κατηγοριοποίηση και στην Μείωση Διάστασης Δεδομένων Διπλωματικη Εργασια του Γαβριηλιδη Βασιλη Επιβλέπων: Αναστάσιος Τέφας Επ. Καθηγητής Α.Π.Θ. Εργαστηριο Τεχνητης Νοημοσυνης και Αναλυσης Πληροφοριων Θεσσαλονίκη, Σεπτέμβριος 2013

2

3 Αριστοτέλειο Πανεπιστήμιο Θεσσαλονίκης Τμήμα Πληροφορικής Κατεύθυνση Ψηφιακών Μέσων Εργαστήριο Τεχνητής Νοημοσύνης και Ανάλυσης Πληροφοριών Εφαρμογές Τυχαίων Περίπατων στην Κατηγοριοποίηση και στην Μείωση Διάστασης Δεδομένων Διπλωματικη Εργασια του Γαβριηλίδη Βασίλη Επιβλέπων: Αναστάσιος Τέφας Επ. Καθηγητής Α.Π.Θ. Εργαστηριο Τεχνητης Νοημοσυνης και Αναλυσης Πληροφοριων Θεσσαλονίκη, Σεπτέμβριος 2013

4

5 5 (Υπογραφή)... Γαβριηλιδης Βασιλειος Φοιτητής Τμήματος Πληροφορικής Αριστοτελείου Πανεπιστημίου Θεσσαλονίκης c 2013 All rights reserved

6

7 Αριστοτέλειο Πανεπιστήμιο Θεσσαλονίκης Τμήμα Πληροφορικής Κατεύθυνση Ψηφιακών Μέσων Εργαστήριο Τεχνητής Νοημοσύνης και Ανάλυσης Πληροφοριών Copyright c 2013 All rights reserved Γαβριηλίδης Βασίλειος. Με επιφύλαξη παντός δικαιώματος. Απαγορεύεται η αντιγραφή, αποθήκευση και διανομή της παρούσας εργασίας, εξ ολοκλήρου ή τμήματος αυτής, για εμπορικό σκοπό. Επιτρέπεται η ανατύπωση, αποθήκευση και διανομή για σκοπό μη κερδοσκοπικό, εκπαιδευτικής ή ερευνητικής φύσης, υπό την προϋπόθεση να αναφέρεται η πηγή προέλευσης και να διατηρείται το παρόν μήνυμα. Ερωτήματα που αφορούν τη χρήση της εργασίας για κερδοσκοπικό σκοπόπρέπεινα απευθύνονται προς τον συγγραφέα.

8

9 Στην οικογένειά μου

10

11 Ευχαριστίες Θα ήθελα να ευχαριστήσω τον επιβλέποντα καθηγητή μου κ. Αναστάσιο Τέφα, για την καθοδήγηση, την υπομονή που έδειξε και την πολύτιμη βοήθεια που μου προσέφερε με τις γνώσεις του καθ όλη τη διάρκεια της εργασίας. 1

12

13 Περίληψη Στην παρούσα εργασία, οκύριοςστόχοςήτανηενασχόληση μενέους πυρήνες και χρησιμοποίησή τους για κατηγοριοποίηση δεδομένων. Οι προτεινόμενοι πίνακες πυρήνα δημιουργούνται χρησιμοποιώντας δυνάμεις ήδη γνωστών πινάκων πυρήνα. Τέτοιες μέθοδοι παραγωγής πινάκων πυρήνα έχουν χρησιμοποιηθεί και στο παρελθόν αλλά δεν έχουν δημοσιευτεί ποτέ αποτελέσματα κατηγοριοποίησης. Διεξήχθησαν πειράματα σε διάφορα σύνολα δεδομένων και χρησιμοποιήθηκαν στατιστικά τεστ για την σύγκριση του προτεινόμενου τρόπου χρήσης πινάκων πυρήνα έναντι του κλασικού τρόπου χρήσης που μπορούν να χρησιμοποιηθούν στις μηχανές διανυσμάτων υποστήριξης (Support Vector Machines - SVM). Επίσης, παρουσιάζονται αποτελέσματα κατηγοριοποίησης σε πραγματικές βάσεις δεδομένων όπως είναι η αναγνώριση δραστηριότητας ανθρώπων (activity recognition). Ακόμη προτείνουμε μια μέθοδο για μείωση διάστασης δεδομένων η οποία μπορεί να ενσωματωθεί σε ένα ενιαίο πλαίσιο μείωσης διάστασης, και παρουσιάζουμε κάποιες αξιοσημείωτες προβολές δεδομένων. Λέξεις Κλειδιά Διανύσματα Υποστήριξης Μηχανής (Support Vector Machines), Τυχαίοι Περίπατοι, Πίνακας Πυρήνα, Μείωση Διάστασης 3

14

15 Abstract Novel Kernel Matrices that reflect on the general structure of data are proposed for classification. The proposed Matrices are generated using powers of already known Kernel Matrices. This technique has already been mentioned but no application to classification has ever been shown. Experiments on various datasets are conducted and statistical test are performed comparing our proposed approach against current Kernel Matrices used on support vector machines. We show classification results to real database problems such as activity recognition. Lastly we show some noteworthy projections using our kernel matrix when it is embedded in a famous dimensionality reduction framework. Keywords Support Vector Machines, Random Walk, Kernel Matrix, Dimensionality Reduction 5

16

17 Περιεχόμενα Ευχαριστίες 1 Περίληψη 3 Abstract 5 Περιεχόμενα 8 1 Εισαγωγή 9 2 Κατηγοριοποίηση (Classification) Μηχανές διανυσμάτων υποστήριξης (SVM) Χρήση Πυρήνα (Kernel Methods) Προτεινόμενες μέθοδοι Γραμμικός Πυρήνας (Linear Kernel) μη Γραμμικός Πυρήνας (non Linear Kernel) Διαθέσιμες Προσεγγίσεις Πέρασμα από όλα τα δεδομένα (Pass through All, PA) Πέρασμα από τα δεδομένα εκπαίδευσης (Pass through Train, PT)

18 8 Περιεχόμενα Πέρασμα από τα διανύσματα υποστήριξης (Pass through Support Vectors, PSV) Πειράματα Εφαρμογές στην μάθηση δραστηριότητας (activity learning) Εφαρμογές στην μείωση διάστασης δεδομένων (dimensionality reduction) Συμπεράσματα 67 Βιβλιογραφία 69 Κατάλογος Σχημάτων 77 Κατάλογος Πινάκων 79 Κατάλογος Αλγορίθμων 81

19 Κεφάλαιο 1 Εισαγωγή Στην σημερινή εποχή υπάρχει μια πληθώρα από δεδομένα, τα οποία κυρίως αποτελούνται από ήχο, εικόνες και βίντεο. Οολοένακαιαυξανόμενος ρυθμός παραγωγής των ψηφιακών μέσων μας προτρέπει να τα επεξεργαστούμε με γρήγορο τρόπο και αποδοτικά ώστε να βγάλουμε χρήσιμα συμπεράσματα με τελικό στόχο τηνκαλυτέρευση της ανθρώπινης καθημερινότητας και γενικότερα της ανθρώπινης ζωής. Οόγκοςτων δεδομένων είναι τέτοιος που ο ανθρώπινος εγκέφαλος δεν είναι σεθέσηναταεπε- ξεργαστεί. Είναι αναγκαίο λοιπόν, να αναλυθεί όλη η διαθέσιμη πληροφορία, αυτό το σκοπό αναλαμβάνει η μηχανική μάθηση. Ημηχανικήμάθησηείναιμιαπεριοχήτηςτεχνητήςνοημοσύνηςη οποία αφορά αλγορίθμους και μεθόδους που επιτρέπουν στους υπολογιστές να μάθουν. Οι αλγόριθμοι λειτουργούν με αυτοματοποιημένη ανάλυση συνόλων δεδομένων καιόχιαπόδιαίσθηση που οι άνθρωποι διακατέχουν. Με τη μηχανική μάθηση έχουμε την δυνατότητανααναλύσουμε σύνολα δεδομένων με τρόπο που ο άνθρωπος δεν μπορεί. Προβλήματα όμως συνεχίζουν και υπάρχουν, τα συμπεράσματα που βγάζουμε με την μηχανικήμάθηση δεν είναι αλάνθαστα και συνεχώς ερευνώνται νέοι αλγόριθμοι για βελτίωση απόδοσης και ταχύτητας. Στην μηχανική μάθηση υπάρχουν πολλοί αλγόριθμοι που χρησιμοποιούν ομοιότητες 9

20 10 Κεφάλαιο 1. Εισαγωγή ήανομοιότητες. Στην τεχνητή όραση, ηαπόστασηεφαπτομένης(tangent distance) [16], η απόσταση ελαχίστου έργου (earth mover s distance) [38], ηαπόστασηται- ριάσματος σχήματος (shape matching distance) [4] το ταίριασμα πυραμίδας (pyramid match kernel) [21],είναι όλοι τους αλγόριθμοι που χρησιμοποιούν την ομοιότητα α- νάμεσα σε εικόνες, που με τη σειρά τους χρησμοποιούνται για ανάκτηση εικόνων και αναγνώριση αντικειμένων. Κατ αναλογία στην βιοπληροφορική υπάρχουν διάσημοι αλγόριθμοι που χρησιμοποιούνται για τον υπολογισμό αποστάσεων για κατηγοριοποίηση πρωτεϊνών [43, 30, 1]. Για περισσότερες πληροφορίες για κατηγοριοποίηση μέσω ομοιότητας αναφερθείτε στο [12]. Οι πίνακες ομοιότητας μπορούν να δημιουργηθούν εφαρμόζοντας οποιαδήποτε γνωστή μετρική στα δεδομένα. Η πιο συνηθισμένη είναι το εσωτερικό γινόμενο (inner product) και η ομοιότητα συνημιτόνου (cosine similarity). Επιπλέον, ένας πίνακας ο- μοιότητας S μπορεί να χρησιμοποιηθεί ως πυρήνας Kernel matrix, K, αντικαθιστώντας απλώς το K με S αγνοώντας το γεγονός ότι S μπορεί να μην είναι θετικά ορισμένος. Αυτό δεν είναι πάντα σωστό, ως εκ τούτου, υπάρχουν πολλές εξελιγμένες μέθοδοι τροποποίησης του S ώστε να γίνει θετικά ορισμένος - αποθυρύβωση (denoise) [19, 34], αναστροφή (flip) [19],διάχυση (diffuse) [22]και μετατόπιση (shift) [36]. Μια λεπτομερής συζήτηση μπορεί να βρεθεί στο [52]. Οι μέθοδοι πυρήνα έχουν λάβει σημαντική προσοχή, κυρίως λόγω τηςαυξημένης δημοτικότητας των μηχανών διανυσμάτων υποστήριξης (Support Vector Machines) και υπάρχουν πολλές μέθοδοι πυρήνα [41, 42]. Οι λειτουργίες του πυρήνα μπορούν να χρησιμοποιηθούν σε πολλές εφαρμογές καθώς παρέχουν ένα μετασχηματισμό από τη γραμμικότητα σε μη-γραμμικότητα και μπορεί να εκφραστεί με όρους εσωτερικού γινόμενου κάνοντας χρήση του κόλπου πυρήνα (kernel trick). Οι πιο συνήθεις πυρήνες είναι γραμμικοί πυρήνες και ο Gaussian πυρήνας ο οποίος είναι ένας μη γραμμικός πυρήνας.

21 11 Μια άλλη αναπαράσταση, που βασίζεται στην ομοιότητα μεταξύ όλων των δειγμάτων ανά δύο είναι τα γραφήματα. Τα γραφήματα προσφέρουν μια γενικήαίσθηση της ομοιότητας μεταξύ των αντικειμένων που απεικονίζουν ολόκληρη την δομή των δεδομένων. Στην μείωση διάστασης δεδομένων χρησιμοποιείται ευρέως η έννοια των γραφημάτων [37, 53]. Ανάλογα με τις επιθυμητές στατιστικές ή γεωμετρικές ιδιότητες που θέλουμε να κρατήσουμε και ποιες να αποφύγουμε στα δεδομένα μας, μια τεχνική μείωσης διάστασης των δεδομένων μπορεί να δημιουργηθεί. Για το σκοπό αυτό, ένα γράφημα δημιουργείται το οποίο περιλαμβάνει την κατασκευή ενός γραφήματος k πλησιέστερων γειτόνων. Ωστόσο, αυτό το είδος της της ομοιότητας δεν μπορεί να εφαρμοστεί σε αλγορίθμους ταξινόμησης που χρησιμοποιούν όλα τα ζεύγη αποστάσεων, όπως σεμηχανέςδιανυ- σμάτων υποστήριξης (SVM). Ιδανικά, θα θέλαμε να έχουμε ένα πλήρως συνδεδεμένο γράφημα έτσι ώστε κάθε ζεύγος δείγματος να συνδέεται και να έχει μια συγκεκριμένη τιμή ομοιότητας. Επιπλέον, τα γραφήματα έχουν πολλές ιδιότητες και χρησιμοποιούνται ευρέως [13]. Μια από τις ιδιότητες ενός γραφήματος, την οποία θα χρησιμοποιήσουμε στην παρούσα εργασία, είναι ότι αν W αναπαριστά τον πίνακα γειτνίασης (adjacency matrix) μεταξύ των κόμβων όπου W (i, j) =1αν οι κόμβοι i, j συνδέονται και W (i, j) =0διαφορετικά, τότε η p οστή δύναμη του πίνακα γειτνίασης W p (i, j) δίνει τον αριθμό των μονοπατιών μήκους p ανάμεσα στους κόμβους i και j. Ηέννοιααυτήμπορείναχρησιμοποιηθείσε κατευθυνόμενα ή μη γραφήματα και μπορεί επίσης να επεκταθεί σε γραφήματα με βάρη W (i, j) [0, 1]. Προτείνουμε την εφαρμογή της τελευταίας ιδιότητας ενός γραφήματος, σε γραμμικούς και μη γραμμικούς πίνακες πυρήνα για κατηγοριοποίηση δεδομένωνχρησιμοποιώντας τις μηχανές διανυσμάτων υποστήριξης (SVM) ως ταξινομητή, και για μείωση διάστασης των δεδομένων μέσω του πλαισίου ενσωμάτωσης γραφήματος (graph em-

22 12 Κεφάλαιο 1. Εισαγωγή bedding framework). Ηδομήτηςεργασίαςέχειωςεξής: Στο κεφάλαιο 2 εισάγουμε το πρόβλημα που λύνουμε και συζητάμε για μια οικογένεια πινάκων πυρήνα που είναι γνωστοί ως πυρήνες τυχαίων μονοπατιών (random walk kernel) οι οποίοι έχουν ήδη προταθεί. Στη συνέχεια, στο κεφάλαιο 3 εισάγουμε την δική μας μέθοδο για κατηγοριοποίηση παρέχοντας, κάποιο θεωρητικό υπόβαθρο και κάποιες μαθηματικές αποδείξεις, και περιγράφουμε τις τρεις προσεγγίσεις μας. Στο κεφάλαιο 4 εξηγούμε πως διεξήχθησαν τα πειράματα και παρουσιάζουμε αποτελέσματα κατηγοριοποίησης σε διάφορα σύνολα δεδομένων εκτελώντας κατάλληλα στατιστικά τεστ. Επιπλέον παρέχουμε αποτελέσματα κατηγοριοποίησης δεδομένων σε σύνολα δεδομένων αναγνώρισης δραστηριότητας ανθρώπων και στη συνέχεια δείχνουμε κάποιες ενδιαφέρουσες προβολές μείωσης διάστασης (dimensionality reduction projections) συνόλων δεδομένων χρησιμοποιώντας την δική μας μέθοδο. Τέλος στο 5 κεφάλαιο δίνουμε κάποιες τελικές παρατηρήσεις και συζητάμε μελλοντικές κατευθύνσεις έρευνας.

23 Κεφάλαιο 2 Κατηγοριοποίηση (Classification) Στην μηχανική μάθηση και στην αναγνώριση προτύπων ο όρος κατηγοριοποίηση αναφέρεται στην αλγοριθμική διαδικασία η οποία αντιστοιχεί δεδομέναεισόδουσεδιαφορετικές κατηγορίες. Ενας αλγόριθμος ο οποίος υλοποιεί αυτή τη διαδικασία ονομάζεται κατηγοριοποιητής ή ταξινομητής. Τα δεδομένα εισόδου είναι γνωστά ως πρότυπα (instances) ήδείγματα(samples) και οι κατηγορίες στις οποίες ανήκουν ονομάζονται κλάσεις (labels, classes). Επομένως, το πρόβλημα της δυαδικής κατηγοριοποίησης είναι να ορίσουμε μία α- πεικόνιση της μορφής f : X Y, για ένα σύνολο αντικειμένων X =[x 1, x 2,...,x N ] όπου x i R D και ένα σύνολο από κατηγορίες Y = {y 1,y 2,...,y N }, όπου y i { 1, 1} είναι η κατηγορία που ανήκει το x i δείγμα, και i =1,...,N. ΟαριθμόςN είναι το πλήθος των δειγμάτων και D είναι η διάσταση των δεδομένων. Ολες οι προσεγγίσεις στην εκτέλεση της κατηγοριοποίησης προϋποθέτουν κάποια γνώση των δεδομένων. Συχνά ένα σύνολο εκπαίδευσης χρησιμοποιείται για να καθορίσει τις συγκεκριμένες παραμέτρους που απαιτούνται από τηντεχνική. Τα δεδομένα εκπαίδευσης αποτελούνται από ένα δείγμα δεδομένων της εισόδου όπως επίσης και από την κατηγοριοποίηση που έχει δοθεί σε αυτά τα δεδομένα. Συνήθως η κατηγοριοποίηση αποτελείται από δύο στάδια: 13

24 14 Κεφάλαιο 2. Κατηγοριοποίηση (Classification) Στάδιο 1: Εκπαίδευση (Training) Το στάδιο εκμάθησης του αλγορίθμου με βάση ένα σύνολο ήδη κατηγοριοποιημένων παραδειγμάτων το οποίο ονομάζεται σύνολο εκπαίδευσης (Training set). Στάδιο 2: Ελεγχος (Testing) Ελεγχος της απόδοσης του κατηγοριοποιητή (classifier) σε ένα νέο σύνολο δεδομένων το οποίο ονομάζεται σύνολο ελέγχου (Testing set). Για το στάδιο της εκπαίδευσης χρειάζεται να έχουμε κάποια μέτρα ομοιότητας ή απόστασης για να ορίσουμε την ομοιότητα διαφορετικών στοιχείων στην βάση δεδομένων. Το πιο συνηθισμένο μέτρο που χρησιμοποιούμε είναι αυτό της Ευκλείδιας απόστασης η οποία για δύο σημεία στον D-διάσταστο χώρο, x 1 και x 2 R D ορίζεται ως εξής: ( D ) 1/2 d = x 1i x 2i 2 i=1 (2.1) Φυσικά μπορούν να χρησιμοποιηθούν και άλλες αποστάσεις όπως οιαποστάσεις Mahalanobis ή Hamming [31], [23]. Οι αποστάσεις είναι μέτρα ανομοιότητας μεταξύ των δειγμάτων, ωστόσο το ίδιο συχνά χρησιμοποιούνται μέτρα ομοιότητας. Τα μέτρα ομοιότητας συνήθως εκφράζονται με την μορφή ενός τετραγωνικού πίνακα ομοιοτήτων (similarity matrix) S ήπυρήνα,(kernel matrix), K, μεγέθους N N και η θέση K(i, j) ήαντίστοιχαηs(i, j) εκφράζει την ομοιότητα μεταξύ του δείγματος x i και του x j. Περισσότερα για τους πυρήνες θα πούμε παρακάτω. 2.1 Μηχανές διανυσμάτων υποστήριξης (SVM) Οι μηχανές διανυσμάτων υποστήριξης SVM είναι ένας δυαδικός ταξινομητής και αναπτύχθηκε πρώτη φορά το 1992 από τους Boser, Guyon, και Vapnik [6]. Οι μηχανές διανυσμάτων υποστήριξης είναι ένα σύνολο μεθόδων που χρησιμοποιούνται για

25 2.1 Μηχανές διανυσμάτων υποστήριξης (SVM) 15 ταξινόμηση και παλινδρόμηση δεδομένων. Ανήκουν σε μια οικογένεια γενικευμένων γραμμικών κατηγοριοποιητών και βασίζεται στην ελαχιστοποίηση του δομικού κινδύνου [7]. Αν θεωρήσουμε ένα πρόβλημα ταξινόμησης δύο κλάσεων C 0, C 1 όπως επάνω οι οποίες είναι γραμμικά διαχωρίσιμες τότε υπάρχει ένα διάνυσμα w και ένα κατώφλι w 0, τέτοιο ώστε: < 0, αν x C 0 w T x + w 0 (2.2) > 0, αν x C 1 Είναι σαφές ότι δεν υπάρχει μια μόνο λύση σε αυτό το πρόβλημα ταξινόμησης. Υπάρχουν πολλά ζεύγη (w,w 0 ) που μπορούν να διαχωρίσουν τις δυο κλάσεις. Το ερώτημα λοιπόν είναι με ποιο κριτήριο επιλέγουμε ένα ζευγάρι λύσης. Ενα τέτοιο κριτήριο είναι το λεγόμενο περιθώριο ταξινόμησης γ, μεταξύ των δυο κλάσεων, το οποίο ορίζεται ως το άθροισμα: γ = γ 0 + γ 1 (2.3) μεταξύ των δυο παρακάτω περιθωρίων: w T x + w 0 (w T x + w 0 ) γ 0 = min = min x C 0 w x C 0 w w T x + w 0 (w T x + w 0 ) γ 1 = min = min x C 1 w x C 1 w (2.4) (2.5) Παρατηρούμε ότι η τιμή w T x / w είναι ανάλογη με την απόσταση του δείγματος x από τη γραμμική διαχωριστική επιφάνεια: w T x + w 0 =0 (2.6) Συνεπώς τα περιθώρια γ 0 και γ 1 αντιστοιχούν στην απόσταση του πιο κοντινού προτύπου της κάθε κλάσης από τη διαχωριστική επιφάνεια. Οσο ητιμήτουγ 0 πλησιάζει πιο κοντά στο μηδέν τόσο πιο οριακή είναι η σωστή ταξινόμηση των προτύπων της κλάσης C 0, αντίστοιχα το ίδιο ισχύει για το γ 1. Ηεξίσωση(2.6) περιέχει αρκετό

26 16 Κεφάλαιο 2. Κατηγοριοποίηση (Classification) πλεονασμό, εφόσον οι κλιμακώσεις των w, w 0 δεν παίζουν ρόλο, οπότε ορίζεται το κανονικό διαχωριστικό υπερεπίπεδο που ενσωματώνει και τις κλιμακώσεις των μεταβλητών ώστε: 1, αν x C 0 w T x + w 0 (2.7) 1, αν x C 1 Συνεπώς, σύμφωνα με την (2.7), για ένα κανονικό διαχωριστικό υπερεπίπεδο έχουμε min x C0 w T x + w 0 = min x C1 w T x + w 0 =1και γ 0 = γ 1 =1/ w, οπότε: γ = 2 w (2.8) και οι ανισότητες που περιγράφονται στην (2.7), μετατρέπονται στην εξής μορφή: y i (w T x + w 0 ) 1, i =1,...,N (2.9) Σύμφωνα λοιπόν με την (2.8) ημεγιστοποίησητουπεριθωρίου γ, ισοδυναμεί με την ελαχιστοποίηση της νόρμας w. Ετσι η αναζήτηση καταλληλότερης λύσης, μετατρέπεται στον παρακάτω πρόβλημα βελτιστοποίησης το οποίο ανήκειστηνπεριοχή του τετραγωνικού προγραμματισμού: J(w,w 0 )= 1 2 w 2 (2.10) υπό τους N περιορισμούς της σχέσης (2.9) Ηελαχιστοποίησητηςτετραγωνικήςσχέσης(2.10) υπό τους περιορισμούς (2.9) γίνεται με τη χρήση πολλαπλασιαστών Langrange, δημιουργώντας την παρακάτω συνάρτηση κόστους: L(w,w 0, α 1,...,α N )= 1 N 2 w 2 α i [y i (w T x + w 0 ) 1] (2.11) όπου έχουμε εισάγει από ένα συντελεστή α i, i =1,...,N για κάθε περιορισμό της (2.9). Επειδή οι περιορισμοί αυτοί είναι με τη μορφή ανισότητας, οι πολλαπλασιαστές i=1

27 2.2 Χρήση Πυρήνα (Kernel Methods) 17 Langrange πρέπει να ικανοποιούν τις ανισότητες: α i 0, i =1,...,N (2.12) Μετά από απλές πράξεις, βρίσκουμε ότι ελαχιστοποίηση της τετραγωνικής σχέσης (2.10) μεταφράζεται στις παρακάτω εξισώσεις: w = Με βάση τα παραπάνω έχουμε: N α i y i =0 (2.13) i=1 N α i y i x i (2.14) i=1 1 2 w 2 = 1 2 wt w = 1 N α i y i x T i 2 = 1 2 i=1 N i=1 j=1 N α j y j x j j=1 N α i α j y i y j x T i x j (2.15) οπότε η αντικαθιστώντας στην 2.11, παίρνουμε την παρακάτω μορφή της συνάρτησης Langrange: L(α 1,...,α N )= N α i 1 2 i=1 N N α i α j y i y j x T i x j (2.16) i=1 j=1 ηοποίαπρέπειναμεγιστοποιηθείωςπροςα. 2.2 Χρήση Πυρήνα (Kernel Methods) Σύμφωνα με τα παραπάνω είδαμε ότι οι μηχανές διανυσμάτων υποστήριξης μπορούν να δημιουργήσουν γραμμικές διαχωριστικές επιφάνειες με σκοπό τον καλύτερο δυνατό

28 18 Κεφάλαιο 2. Κατηγοριοποίηση (Classification) διαχωρισμό δυο κλάσεων. Ωστόσο, σε πολλές περιπτώσεις οι κλάσεις δεν είναι γραμμικά διαχωρίσιμες. Για αυτό το λόγο εισάγουμε ένα μη γραμμικό μετασχηματισμό των δεδομένων Φ(.). Ομετασχηματισμόςπροβάλλειταδεδομένασεέναχώρουψηλότερης διάστασης όπου ενδεχομένως να είναι γραμμικά διαχωρίσιμα και αυτό στη βιβλιογραφία είναι γνωστό ως το κόλπο πυρήνα [40]. Αν και αυτό μπορεί να φαίνεται χρονοβόρο, στην πραγματικότητα κάνουμε χρήση της εξής ιδιότητας: K(i, j) =Φ(x i ) T Φ(x j ) (2.17) Με αυτό τον τρόπο δεν μας απασχολεί τόσο η απεικόνιση που γίνεται στον υψηλότερο χώρο, όσο το εσωτερικό γινόμενο μεταξύ των δειγμάτων σε εκείνο τον χώρο. Επομένως αν εφαρμοστεί ο μετασχηματισμός των δεδομένων και χρησιμοποιώντας την εξίσωση (2.17) στην συνάρτηση Langrange (2.16) όπως φαίνεται και στο [35] ογενικός ορισμός του προβλήματος του τετραγωνικού προγραμματισμού για το πρόβλημα των μηχανών διανυσμάτων υποστήριξης μπορεί να εκφραστεί ως: max α N W (α) = α i 1 2 i=1 N N α i α j y i y j k(x i, x j ) (2.18) i=1 j=1 υπό τους περιορισμούς 0 α i C i N y i α i =0 i=1 όπου C είναι μια παράμετρος ποινής. Παρατηρούμε ότι τα δείγματα καθεαυτά δεν χρειάζονται για τον υπολογισμό της μεγιστοποίηση της εξίσωσης (2.18), παρά μόνο οι μεταξύ τους ομοιότητες με τη μορφή ενός πυρήνα. Υπάρχουν διάφοροι πυρήνες που μπορούν να χρησιμοποιηθούν, οι πιο συνηθισμένοι είναι ο γραμμικός, οπολυωνυμικός(polynomial), ογκαουσιανόςπυρήνας(rbf) και οσιγμοειδής(sigmoid). Παρακάτω φαίνονται ο τρόπος υπολογισμού τους: Γραμμικός πυρήνας ή εσωτερικό γινόμενο (Inner Product) K(x i, x j )=x T i x j (2.19)

29 2.2 Χρήση Πυρήνα (Kernel Methods) 19 Πολυωνυμικός (Polynomial) K(x i, x j )=(x T i x j + θ) p (2.20) Γκαουσιανός πυρήνας (RBF, Heat Kernel, Gauss) K(x i, x j )=e x i x j 2 2σ 2 (2.21) Σιγμοειδής πυρήνας (Sigmoid) K(x i, x j )=tanh(αx T i x j + θ) (2.22) Ακόμη υπάρχουν άλλου είδους πυρήνες όπως είναι οι πυρήνες τυχαίων περιπάτων (random walk kernel) οι οποίοι προτάθηκαν πρώτη φορά στο [45] και αργότερα, ορίστηκαν καλύτερα για ημι-επιβλεπόμενη μάθηση χρησιμοποιώντας πυρήνες συστάδων (cluster kernel) στο [11]. Ο πυρήνας τυχαίων περιπάτων υπολογίζεται σε δυο βήματα. Πρώτα υπολογίζεται ο πυρήνας RBF όπως στο φαίνεται στην σχέση (2.21), και μετά μετά ο πυρήνας κανονικοποιείται κάνοντας χρήση την παρακάτω σχέση: K = K ij k K ik (2.23) Το τελευταίο μπορεί να ερμηνευθεί ως ένας πίνακας μετάβασης ενός τυχαίου μονοπατιού σε ένα γράφημα με την πιθανότητα να μεταφερθεί το σημείο x i στο σημείο x j. Με αυτή τη προσέγγιση, οδιαγώνιοςπίνακαςοριζόμενοςως: D ij = j K ij (2.24) μπορεί να χρησιμοποιηθεί για την κατασκευή του πίνακα μετάβασης ως P = D 1 K, επομένως ο πίνακας P p =(D 1 K) p υποδηλώνει την πιθανότητα μετάβασης μετά από p βήματα. Δυστυχώς όμως, οπίνακαςp p δεν είναι συμμετρικός οπότε δεν μπορεί να

30 20 Κεφάλαιο 2. Κατηγοριοποίηση (Classification) χρησιμοποιηθεί ως πυρήνας για τα μηχανές διανυσμάτων υποστήριξης, όμως ένα κόλπο παρέχεται στο [11] για την μετατροπή του σε θετικά ορισμένο πίνακα. Επιπλέον, μια οικογένεια πυρήνων σε γραφήματα βασιζόμενα στην έννοια των τελεστώνκανονικοποίησης (regularization operators) εισάγονται στο [44] όπου προτείνεται ένα άλλο παράδειγμα πυρήνα τυχαίων περιπάτων. Ακόμη, ας ορίσουμε ένα γράφημα χωρίς βάρη G που περιλαμβάνει ένα σύνολο από κόμβους αριθμημένα από το 1 στο N να αναπαριστά τον πίνακα δεδομένων (Data Matrix) και τον πίνακα γειτνίασης W να ορίζεται ως: 1 αν τα δείγματα i και j είναι γείτονες W ij = 0 διαφορετικά (2.25) Επίσης ας ορίζουμε τον διαγώνιο πίνακα D να είναι ένας πίνακας μεγέθους N N παρόμοιος με τον πίνακα που ορίζεται στο [11] και υπολογίζεται στην εξίσωση (4.4). Ο Λαπλασιανός(Laplacian) πίνακας του G ορίζεται ως : L = D W (2.26) και ο κανονικοποιημένος Λαπλασιανός (Normalised Laplacian) υπολογίζεται ως: L = D 1 2 LD 1 2 (2.27) ΟπυρήναςτονοποίοοSmola και ο Kondor ονομάζουν p step random walk kernel, προτείνεται και υπολογίζεται ως: K =(ai L) p, a 2 (2.28) Υπόψιν ότι γενικότερα ο W δεν είναι περιορισμένος και μπορεί να επεκταθεί σε γραφήματα με βάρη επιτρέποντας W ij [0, inf]. Επίσης παρατηρούμε ότι η ύπαρξη της παραμέτρου a εξασφαλίζει στον πίνακα K την ιδιότητα του θετικά ορισμένου πίνακα. Οτρόποςπαραγωγήςτουp step random walk kernel φέρει μεγάλη ομοιότητα με

31 2.2 Χρήση Πυρήνα (Kernel Methods) 21 αλγορίθμους που αφορούν την ταξινόμηση ιστοσελίδων (scoring web pages) όπως είναι ο PageRank [33] ο HITS [29] και ο τυχαίος HITS [32] και πολύ πιθανόν από εκεί να έχει εμπνευστεί. Οπως συζητήθηκε οι πυρήνες τυχαίων περιπάτων (random walk kernels) είναι ήδη γνωστοί. Παρ όλα αυτά δεν έχουν δημοσιευτεί ποτέ αποτελέσματα κατηγοριοποίησης χρησιμοποιώντας τους. Ενας πιθανός λόγος για τον οποίο να συνέβη αυτό είναι η δυσκολία στον καθορισμό επιλογής της παραμέτρου p και ότι η εξασφάλιση θετικά ορισμένων πυρήνων απαιτεί τεχνάσματα για να μπορεί να χρησιμοποιηθεί ως πίνακας σε ένα SVM. Στο επόμενο κεφάλαιο προτείνουμε πως μπορεί να χρησιμοποιηθεί ένας πυρήνας τυχαίων περιπάτων για κατηγοριοποίηση δεδομένων χρησιμοποιώντας μηχανές διανυσμάτων υποστήριξης.

32

33 Κεφάλαιο 3 Προτεινόμενες μέθοδοι Σε αυτό το κεφάλαιο θα περιγράψουμε αναλυτικά τις προτεινόμενες μεθόδους. Οι μέθοδοι που προτείνουμε είναι πολύ απλοί και απαιτούν τον υπολογισμό ενός ήδη γνωστού πυρήνα. Οι αρχικοί πυρήνες που χρησιμοποιούμε είναι ένας γραμμικός πυρήνας, το εσωτερικό γινόμενο, και ένας μη γραμμικός πυρήνας, στη δική μας περίπτωση ο RBF. Ωστόσο, όπως θα εξηγηθεί αργότερα, οποιοσδήποτε γνωστός πυρήνας μπορεί να χρησιμοποιηθεί. Τελικά παράγουμε νέους πυρήνες που μπορούν να χρησιμοποιηθούν σε μηχανές διανυσμάτων υποστήριξης. Για αυτό το σκοπό περιγράφουμε τρεις προσεγγίσεις και κάθε μια θα περιγραφεί αναλυτικά. 3.1 Γραμμικός Πυρήνας (Linear Kernel) Ενας πίνακας ομοιότητας μπορεί να οριστεί σύμφωνα με τον ορισμό του εσωτερικού γινομένου ανάμεσα στο i-οστό δείγμα και στο j-οστό δείγμα: W (i, j) =x T i x j (3.1) ήμεμορφήπινάκωνγιαόλαταδείγματα: W = X T X (3.2) 23

34 24 Κεφάλαιο 3. Προτεινόμενες μέθοδοι Ας πούμε ότι τα δείγματα i και j αναπαριστώνται ως κόμβοι σε ένα γράφημα χωρίς βάρη, με W (i, j) =0να σημαίνει ότι τα δείγματα δεν είναι όμοια και με W (i, j) =1 να σημαίνει ότι τα δείγματα μοιάζουν, και αντίστοιχα, με όρους θεωρίας γραφημάτων, ότι αν W (i, j) =0τότε οι κόμβοι δεν συνδέονται, ενώ αν W (i, j) =1τότε οι κόμβοι συνδέονται. Με την αναπαράσταση του πίνακα ομοιότητας ως γράφημα, μπορούμε να χρησιμοποιήσουμε την ιδιότητα ότι η p οστή δύναμη του πίνακα γειτνίασης W p (i, j) δίνει τον αριθμό των μονοπατιών μήκους p ανάμεσα στους κόμβους i και j. Οπότε τώρα, προτείνουμε τον εξής πίνακα ομοιοτήτων: W p = WW...W }{{} p φορές (3.3) Μπορούμε να πούμε ότι ο όρος W p (i, j) εκφράζει την ομοιότητα ανάμεσα στα δείγματα i και j αφού επισκεφτούμε όλα τα δυνατά μονοπάτια περνώντας από p 1 ενδιάμεσους όμοιους κόμβους. Επεκτείνοντας τις διακριτές τιμές του όμοιου και του ανόμοιου (0 και 1) σε συνεχείς τιμές, ορίζουμε έναν πιο χαλαρό ορισμό για ένα γράφημαμεβάρητουοποίου οι ακμές μπορούν να πάρουν τιμή στο διάστημα [0 inf] όπου 0 είναι η μικρότερη δυνατή ομοιότητα και inf είναι η μεγαλύτερη δυνατή ομοιότητα. Με αντίστοιχο τρόπο με έννοιες θεωρίας γραφημάτων, 0 δεν συνδέονται καθόλου και inf είναι η μεγαλύτερη δυνατή σύνδεση. Με αυτό τον τρόπο όταν υπολογίζεται η ομοιότητα δύο δειγμάτων είναι διαθέσιμα περισσότερα μονοπάτια, εφόσον να μονοπάτια τα οποία δεν είναι βιώσιμα είναι εκείνα που περνάνε από έναν ενδιάμεσο κόμβο που έχει μηδέν ομοιότητα μεκάποιοάλλο. Στην πραγματικότητα, κάθε μονοπάτι περιλαμβάνεται στον υπολογισμό της ομοιότητας, αν και η ομοιότητα μεταξύ δύο δειγμάτων μπορεί να είναι μικρή, σπάνια είναι μηδέν. Οπίνακαςομοιότηταςπερνώνταςαπόένανενδιάμεσοκόμβουπολογίζεται ως: W 2 = X T XX T X (3.4)

35 3.1 Γραμμικός Πυρήνας (Linear Kernel) 25 Χωρίς να χάνεται η γενικότητα ας υποθέσουμε ότι ο πίνακας δεδομένων (data matrix) έχει μηδενική μέση τιμή, οπότε XX T = Σ όπου Σ είναι ο πίνακας μεταβλητότητας (covariance), οπότε μπορούμε να γράψουμε την εξίσωση (3.4) ως εξής: W 2 = X T ΣX (3.5) Είναι πολύ εύκολο να δείξουμε ότι στη γενική περίπτωση ισχύει το παρακάτω: W p (i, j) =x i Σ p 1 x j p 1 (3.6) ήδιαφορετικάμεμορφήπινάκων, W p = X T Σ p 1 X p 1 (3.7) Οπότε ο πίνακας W p είναι ο πίνακας ομοιότητας και η τιμή W p (i, j) εκφράζει την ομοιότητα δυο δειγμάτων αρχίζοντας από το i οστό δείγμα και καταλήγοντας στο j οστό δείγμα περνώντας ανάμεσα από p 1 ενδιάμεσους κόμβους. Το επιθυμητό αποτέλεσμα που θέλουμε να πετύχουμε είναι ότι παρόμοια δείγματα θα συνδέονται από πολλαπλά μονοπάτια. Ακόμη και αν ο πίνακας W είναι πίνακας ομοιότητας αυτό δεν σημαίνει αναγκαία ότι μπορεί να χρησιμοποιηθεί ως πυρήνας. Στη συνέχεια θα αποδείξουμε ότι εκτός από τον W οοποίοςείναιεξορισμούπυρήνας, ότι και ο W p μπορεί να χρησιμοποιηθεί ως πυρήνας. Είναι ασφαλές να χρησιμοποιήσουμε τον W ως πυρήνα, K, εφόσον είναι θετικά ορισμένος και μπορεί να αναλυθεί στα ιδιοδιανύσματα και στις ιδιοτιμέςτουk = U T ΛU, όπου U είναι ένας ορθοκανονικός πίνακας και Λ είναι ένας διαγώνιος πίνακας με πραγματικές και θετικές ιδιοτιμές, δηλαδή Λ = diag(λ 1, λ 2,...,λ D ). Οπότε τώρα ο W p μπορεί να γραφτεί ως:

36 26 Κεφάλαιο 3. Προτεινόμενες μέθοδοι W p = KK...K }{{} p φορές = U T Λ } UU {{ T } Λ } UU {{ T }...UU }{{ T } ΛU I I I = U T Λ }...Λ {{} U p φορές = U T Λ p U (3.8) και εφόσον οι ιδιοτιμές είναι θετικές λ i > 0, i =1,...,N τότε θα ισχύει και ότι λ p i > 0, i =1,...,N με το οποίο μπορούμε να συμπεράνουμε ότι xwp x T 0, x, το οποίο είναι ο ορισμός του θετικά ορισμένου πίνακα. Παρατηρούμε ότι δεν έγινε κάποια υπόθεση για τον αρχικό πυρήνα, οπότε γενικότερα ισχύει ότι κάθε πυρήνας υψωμένος σε οποιαδήποτε δύναμη είναι επίσης πυρήνας. Οπότε τώρα ο πίνακας W p μπορεί με ασφάλεια να χρησιμοποιηθεί ως προϋπολογισμένος πυρήνας σε μηχανές διανυσμάτων υποστήριξης όπως γίνεται στη βιβλιοθήκη libsvm [8]. Επιπλέον όταν χρησιμοποιείται το εσωτερικό γινόμενο ως αρχικός πυρήνα και υποθέτοντας ότι ο πίνακας δεδομένων έχει μηδενική μέση τιμή παρατηρούμε μια ενδιαφέρουσα ιδιότητα. Ο covariance Σ είναι συμμετρικός και έχει πραγματικές τιμές οπότε μπορεί να γίνει η αποσύνθεση του σε ιδιοτιμές και ιδιοδιανύσματα και μπορεί να γραφτεί ως: Σ = UDU T (3.9) Οπότε: W p =X T Σ p 1 X =X T UD p 1 U T X =(D p 1 2 U T X) T (D p 1 2 U T X) (3.10)

37 3.2 μη Γραμμικός Πυρήνας (non Linear Kernel) 27 Επομένως, αν χρησιμοποιήσουμε τον γραμμικό πυρήνα εμφανίζεται μια μορφή δυικότητας του προβλήματος. ΟπυρήναςW p μπορεί να εφαρμοστεί με διαφορετικό τρόπο μετασχηματίζοντας τα δεδομένα. Πολλαπλασιάζοντας τον πίνακα δεδομένων X με D p 1 2 U T και χρησιμοποιώντας τον γραμμικό πυρήνα επιφέρει τα ίδια αποτελέσματα χρησιμοποιώντας τα αρχικά δεδομένα με τον πυρήνα W p. Αξίζει να πούμε ότι, αυτού του είδους μετασχηματισμού των δεδομένων συναντάται συχνά στην μείωση διάστασης δεδομένων. Για παράδειγμα στην ανάλυση πρωτευουσών συνιστωσών (PCA), [28]επιλέγονται τα ιδιοδιανύσματα που αντιστοιχούν στις d μεγαλύτερες ιδιοτιμές, όπου d το πλήθος της νέας διάστασης των δεδομένων. Με αυτόν τον τρόπο μπορούμε να πούμε κατ αναλογία ότι ο μετασχηματισμός των δεδομένων σύμφωνα με την PCA είναι DU T, όπου D(i, i) =1αν η i-οστή ιδιοτιμή ανήκει στις d μεγαλύτερες και D(i, i) =0διαφορετικά. Τυπικά πρέπει να πούμε ότι αν η i-οστή ιδιοτιμή δεν είναι στις d μεγαλύτερες τότε πρέπει να αφαιρέσουμε το αντίστοιχο ιδιοδιάνυσμα, οπότε και μια αντίστοιχη διάσταση των δεδομένων, χάρη ευκολίας όμως ας το παραβλέψουμε και λέμε ότι τα χαρακτηριστικά που μηδενίζονται, αφαιρούνται. Παρατηρούμε λοιπόν ότι σύμφωνα με την δική μας μέθοδο όλα τα ιδιοδιανύσματα μαζί με τις αντίστοιχες ιδιοτιμές τους συμπεριλαμβάνονται, για αυτό άλλωστε και δεν μπορεί να θεωρηθεί ως μείωση διάστασης δεδομένων και μάλιστα ανάλογαμετην δύναμη p 1 2 της ιδιοτιμής δίνεται διαφορετικό βάρος στα αντίστοιχα ιδιοδιανύσματα. Στη συνέχεια εξετάζουμε ένα διαφορετικό αρχικό πυρήνα. 3.2 μη Γραμμικός Πυρήνας (non Linear Kernel) Ενας άλλος πυρήνας που αναφέραμε ότι χρησιμοποιείται συχνά καιθαχρησιμοποι- ήσουμε και εμείς στη παρούσα εργασία είναι ο RBF και ορίζεται ως: K(x i, x j )=e x j 2 i x 2σ 2 (3.11)

38 28 Κεφάλαιο 3. Προτεινόμενες μέθοδοι p 2 x i xj Σχήμα 3.1: Ηομοιότηταανάμεσασταx i και x j χρησιμοποιώντας τον πυρήνα K p. Κάθε κόμβος αντιστοιχεί σε ένα δείγμα και κάθε ακμή αντιστοιχεί στην ομοιότητα μεταξύ των δύο κόμβων που συνδέει. Σε κάθε επίπεδο υπάρχουν όλοι οι κόμβοι του γραφήματος, συμπεριλαμβανομένου των δειγμάτων x i και x j και η απόσταση από το ένα επίπεδο στο επόμενο προστίθεται. Η τελική απόσταση μεταξύ των δειγμάτων υπολογίζεται διασχίζοντας όλα τα δυνατά μονοπάτια για κάθε επίπεδο. Οπότε ο K p (x i,x j ),p 1 μπορεί να υπολογιστεί ως εξής: K p (x i, x j )= = N l 1 N l 1 N e x i x l1 2 l p 1 N l p 1 e 2σ 2...e x lp 1 x j 2 2σ 2 x i x l x lp 1 x j 2 2σ 2 (3.12) Παρατηρώντας την εξίσωση (3.12) βλέπουμε ότι η απόσταση ανάμεσα σε δύο δείγματα, δηλαδή κόμβοι στο γράφημα, είναι σχετική σε σχέση με όλη τηδομήτουγραφήματος, εφόσον στον υπολογισμό της ομοιότητας μεταξύ δυο κόμβων όλοι οι κόμβοι του γραφήματος συμμετέχουν. Με οπτικό τρόπο αναπαράστασης, κάποιος μπορεί να σκεφτεί την απόστασηδύο δειγμάτων να υπολογίζεται παρατηρώντας το Σχήμα 3.1 το οποίο μοιάζειμάλιστακαι

39 3.3 Διαθέσιμες Προσεγγίσεις 29 με απόσταση βασισμένη σε γραφήματα, και μετά να την μετατρέψει σε ομοιότητα με τον ανάλογο τρόπο. Τα οφέλη χρήσης ενός πυρήνα, έτσι όπως τον ορίσαμε μπορούν να είναι σημαντικά όπως θα δούμε σε επόμενα κεφάλαια, το κύριο πλεονέκτημα είναι ότιοπίνακαςk p έχει τιμές σε όλες τους τις θέσεις, διαφορετικά αν το δούμε από την άποψη των γραφημάτων, το γράφημα είναι πλήρες, και επομένως μπορεί να χρησιμοποιηθεί σε svm όπως θα δούμε. 3.3 Διαθέσιμες Προσεγγίσεις Ταξινομητές που κάνουν χρήση πυρήνων όπως είναι οι μηχανές διανυσμάτων υποστήριξης, χρησιμοποιούν τις ομοιότητες κάθε ζευγαριού δείγματος και όχι τον χώρο στο οποίο ανήκουν τα δείγματα. Για να χρησιμοποιηθούν οι ομοιότητες σε έναν προϋπολογισμένο πυρήνα σε μηχανές διανυσμάτων υποστήριξης πρέπει να έχουμε υπόψιν ότι τα δείγματα εκπαίδευσης και τα δείγματα ελέγχου χρησιμοποιούνται με διαφορετικό τρόπο. Ας υποθέσουμε λοιπόν, ένα πυρήναk που περιέχει όλες τις ομοιότητες του συνόλου δεδομένων. Οπότε το μέγεθος του είναι (N T + N t ) (N T + N t ) όπου: N T είναι το πλήθος των δειγμάτων του συνόλου εκπαίδευσης. N t είναι το πλήθος των δειγμάτων του συνόλου ελέγχου των οποίων ηκλάσηθα προβλεφθεί. Ακόμη, ας υποθέσουμε ότι οι ομοιότητες από κάθε ζευγάρι δείγματος είναι σύμφωνα με την ακόλουθη σειρά: πρώτα τα δείγματα εκπαίδευσης και ύστερα τα δείγματα

40 30 Κεφάλαιο 3. Προτεινόμενες μέθοδοι ελέγχου. Οπότε χρησιμοποιώντας υποπίνακες ο K μπορεί να εκφραστεί ως: K = A C CT (3.13) D ΟπίνακαςA μεγέθους (N T N T ) χρησιμοποιείται για τη δημιουργία του μοντέλου που πληρεί τις προϋποθέσεις της σχέσης (2.18) και ο πίνακας ομοιότητας C μεγέθους (N t N T ), οοποίοςεκφράζειτιςομοιότητεςμεταξύτωνδειγμάτωνελέγχου και των δειγμάτων εκπαίδευσης, χρησιμοποιείται για την πρόβλεψη κλάσης των δειγμάτων ελέγχου. Επομένως, τώρα το κύριο ερώτημα είναι πως χειριζόμαστε τα δεδομένα όταν ο πυρήνας είναι υψωμένος σε μια δύναμη. Προφανώς ο πίνακας D δεν χρειάζεται να υπολογιστεί αλλά γενικότερα από εδώ και στο εξής θα χρησιμοποιηθούν πράξεις πινάκων ανεξάρτητα από το αν κάποιοι υπολογισμοί πινάκων μπορούν να παραλειφθούν. Οταν υπολογίζεται μια δύναμη του πυρήνα είναι απαραίτητο να γίνειμιαδιευκρίνι- ση. Οτρόποςμετονοποίοηκλάσητωνδειγμάτωνελέγχουπροβλέπεται, μπορεί να ποικίλει. Σκεπτόμενοι την ύψωση σε δύναμη του πυρήνα με τον τρόπο που περιγράφεται στο Σχήμα 3.1 είναι βοηθητικό. Στη συνέχεια θα προτείνουμε τρεις τρόπους με τους οποίους μπορούμε να χειριστούμε τα δεδομένα ελέγχου, κάθε ένας βασίζεται στο γεγονός ότι μπορούμε να ελέγξουμε το πλήθος των μονοπατιών ομοιότητας και σε δύο τρόπους χειριζόμαστε διαφορετικά τα δείγματα ελέγχου, και σε ένα τρόπο χειριζόμαστε διαφορετικά τα δείγματα εκπαίδευσης και τα δείγματα ελέγχου. Επιπλέον μόνο δύο τρόποι μπορούν να δεχθούν δεδομένα εκτός του συνόλου χωρίς την επανεκπαίδευση των αλγορίθμων out of sample [5].

41 3.3 Διαθέσιμες Προσεγγίσεις Πέρασμα από όλα τα δεδομένα (Pass through All, PA) Ηπροσέγγισηαυτήείναιηπιοαπλοϊκήαλλάμπορείναφανείχρήσιμη όπως θα δούμε αργότερα στα αποτελέσματα κατηγοριοποίησης. Υποθέτουμε ότι όλα τα δεδομένα είναι διαθέσιμα, όχι μόνο το σύνολο εκπαίδευσης αλλά και το σύνολο ελέγχου. Κάθε φορά που η κλάση ενός ή παραπάνω δείγματος πρέπει να προβλεφθεί, δημιουργούμε νέο μοντέλο εκπαιδευμένο με όλα τα δείγματα, συμπεριλαμβανομένου και των δειγμάτων ελέγχου, υπολογίζοντας τον πίνακα K p. Σε αυτό το σημείο να διευκρινίσουμε ότι οι κλάσεις του συνόλου ελέγχου δεν χρησιμοποιούνται. Αυτό που χρησιμοποιούμε από το σύνολο ελέγχου είναι η δημιουργία ολόκληρου του πίνακα ομοιότητας K p. Στη συνέχεια επιλέγουμε τον υποπίνακα του K p οοποίοςπεριέχειτιςn T πρώτες γραμμές και τις N T πρώτες στήλες και χρησιμοποιείται για την εκπαίδευση. Τέλος, ο υποπίνακας του K p που χρησιμοποιείται για την πρόβλεψη της κλάσης των δειγμάτων ελέγχου περιέχει τις γραμμές [N T +1,N T +2,...,N T +1+N t ] και τις N T πρώτες στήλες. Δηλαδή αν ο K = K p εκφραστεί ως: K = Ã C C T D (3.14) τότε χρησιμοποιείται ο Ã για την εκπαίδευση και ο C για τον έλεγχο. Αξίζει να αναφέρουμε ότι ο τρόπος χειρισμού του συνόλου ελέγχου μοιάζει με τεχνικές ημι επιβλεπόμενης μάθησης, όπου ένα γνωστό, εκ των προτέρων, σαν το σύνολο ελέγχου συμμετέχει για την πρόβλεψη νέων δειγμάτων χρησιμοποιώντας την γνώση που υπάρχει στο σύνολο εκπαίδευσης και στο σύνολο ελέγχου που υπάρχει στην κατοχή μας [10]. Στη δική μας περίπτωση όμως η γνώση για τα δεδομένα χρησιμοποιείται μόνο για την πρόβλεψη του συνόλου ελέγχου που έχουμε ήδη στην κατοχή μας και όχι για νέα δεδομένα. Ωστόσο η προσέγγιση PA θα μπορούσε να επεκταθεί

42 32 Κεφάλαιο 3. Προτεινόμενες μέθοδοι σε ημι επιβλεπόμενη μάθηση αν συνδυαστεί με τις μεθόδους που θααναφέρουμεστη συνέχεια Πέρασμα από τα δεδομένα εκπαίδευσης (Pass through Train, PT) ΟτρόποςαυτόςείναιπαρόμοιοςμετονPA, μόνο που ο PT είναι πιο ευέλικτος εφόσον ο πίνακας που χρησιμοποιείται στην εκπαίδευση δεν απαιτεί την ύπαρξη των δεδομένων ελέγχου. Πρώτα, ας ορίσουμε ένα πίνακα περιορισμών, (restriction kernel matrix). Ο πίνακας αυτός εκφράζει τα μονοπάτια ομοιότητας τα οποία είναι διαθέσιμα και ορίζεται με τον ίδιο τρόπο που ορίζεται ο πυρήνας K όμως αντικαθιστώντας τις τελευταίες N t γραμμές του με μηδέν, έτσι επιτρέπουμε στα μονοπάτια ομοιότητας να περνάν αποκλειστικά από τα δείγματα εκπαίδευσης. Οπίνακαςπεριορισμώνμπορείναεκφραστείως: K r = A CT (3.15) 0 0 Τώρα υπολογίζοντας την p δύναμη του πυρήνα με τον παρακάτω τρόπο, έχουμε: K p =KK p 1 r p 1 = A CT A CT C D 0 0 = A CT Ap 1 A p 2 C T C D 0 0 = Ap A p 1 C T CA p 1 CA p 2 C T Τέλος, ουποπίνακαςa p χρησιμοποιείται για την εύρεση του μοντέλου κατά την εκπαίδευση και ο υποπίνακας CA p 1 χρησιμοποιείται για την πρόβλεψη της κλάσης των

43 3.3 Διαθέσιμες Προσεγγίσεις 33 δεδομένων ελέγχου. Παρατηρούμε ότι τα δείγματα ελέγχου δεν περιλαμβάνονται στην διαδικασία εκπαίδευσης, οπότε με αυτό τον τρόπο υπολογισμού τηςδύναμηςτουπυρήνα μπορούν να ελεγχθούν δεδομένα που δεν είναι διαθέσιμα και επομένως η προσέγγιση του PT είναι πιο ευέλικτη σε σχέση με τον PA Πέρασμα από τα διανύσματα υποστήριξης (Pass through Support Vectors, PSV) Οσυγκεκριμένοςτρόποςείναιπιοπερίπλοκοςκαιπεριλαμβάνει ένα επιπλέον βήμα κατά την εκπαίδευση. Χρησιμοποιώντας τον πυρήνα A που περιέχει τις ομοιότητες μεταξύ των δεδομένων εκπαίδευσης, δημιουργείται ένα αρχικό μοντέλο. Το επόμενο βήμα είναι ο χειρισμός των δειγμάτων που ήταν διανύσματα υποστήριξης με διαφορετικό τρόπο από τι τα δείγματα που δεν ήταν. Ηδιαφοράστονχειρισμότουςείναιότιυπολογίζονταιμόνοταμονοπάτια που περνάνε μέσα από τα δείγματα που ήταν διανύσματα υποστήριξης. Ας υποθέσουμεότιτα δείγματα στον υπολογισμό του K p είναι ταξινομημένα με την ακόλουθη σειρά: πρώτα τα δείγματα εκπαίδευσης που είναι διανύσματα υποστήριξης, μετά τα δείγματα εκπαίδευσης που δεν είναι διανύσματα υποστήριξης και τέλος τα δείγματα ελέγχου. Επομένως οπίνακαςa, περιέχει να εκφραστεί με τη βοήθεια 4 υποπινάκων ως: όπου: A = A S A NSS A T NSS A NS (3.16) A S περιέχει τις ομοιότητες ανάμεσα στα δείγματα εκπαίδευσης που ήταν διανύσματα υποστήριξης και στα δείγματα εκπαίδευσης που ήταν διανύσματα υποστήριξης. A NSS περιέχει τις ομοιότητες ανάμεσα στα δείγματα εκπαίδευσης που ήταν δια-

44 34 Κεφάλαιο 3. Προτεινόμενες μέθοδοι νύσματα υποστήριξης και στα δείγματα εκπαίδευσης που δεν ήταν διανύσματα υποστήριξης. A NS περιέχει τις ομοιότητες ανάμεσα στα δείγματα εκπαίδευσης που δεν ήταν διανύσματα υποστήριξης και στα δείγματα εκπαίδευσης που δεν ήταν διανύσματα υποστήριξης. Επίσης μπορούμε να εκφράσουμε τον πίνακα K με υποπίνακες ως: A T NSS A S K = A NSS A NS ] [C S C NS D CT S C T NS όπου: C S περιέχει τις ομοιότητες ανάμεσα στα δείγματα ελέγχου και στα δείγματα εκπαίδευσης που ήταν διανύσματα υποστήριξης. C NS περιέχει τις ομοιότητες ανάμεσα στα δείγματα ελέγχου και στα δείγματα εκπαίδευσης που δεν ήταν διανύσματα υποστήριξης. Με παρόμοιο τρόπο όπως στη προσέγγιση PT, ο πίνακας περιορισμών υπολογίζεται όπως ο πυρήνας K αλλά αντικαθιστώντας τις γραμμές που αντιστοιχούν στα δείγματα ελέγχου και στις γραμμές που αντιστοιχούν στα δείγματα εκπαίδευσης που δεν ήταν διανύσματα υποστήριξης με μηδέν και ορίζεται ως: A T NSS A S K r = 0 0 [ ] CT S (3.17)

45 3.3 Διαθέσιμες Προσεγγίσεις 35 Μπορούμε επίσης να υπολογίσουμε ότι: K p 1 r = A T NSS A S 0 0 [ ] 0 0 = Ap 1 S A p 2 S 0 0 [ ] 0 0 CT S A T NSS 0 0 p 1 Ap 2 S Τέλος, η p δύναμη του πυρήνα υπολογίζεται ως εξής: 0 0 C T S K p =KK p 1 r A p S = A NSS A p 1 S [ C S A p 1 S A p 1 S A T NSS A NS A p 2 S A NS ] C S A p 2 S A NSS Ap 1 S C T S A NSS A p 2 S C S C S A p 2 S C S Στη συνέχεια χρησιμοποιούμε τον υποπίνακα: A p S A NSS A p 1 S A p 1 S A T NSS A NS A p 2 S A NS μεγέθους (N T N T ) για την εύρεση μοντέλου κατά τη διαδικασία της εκπαίδευσης, και οι ομοιότητες ανάμεσα στα δείγματα ελέγχου και τα στα δείγματα εκπαίδευσης υπολογίζονται μέσω του υποπίνακα: [ C S A p 1 S C S A p 2 S A NSS ] μεγέθους (N t N T ) οοποίοςχρησιμοποιείταιγιατηνπρόβλεψηκλάσηςτωνδειγμάτων ελέγχου. Παρατηρούμε ότι, αν και τα δείγματα εκπαίδευσης που δεν συμμετέχουν στα μονοπάτια ομοιότητας, λαμβάνονται υπόψιν κατά τη διαδικασία πρόβλεψης των κλάσεων των δειγμάτων ελέγχου.

46 36 Κεφάλαιο 3. Προτεινόμενες μέθοδοι Μέθοδος Πίνακας 3.1: Συνοπτική περιγραφή των προσεγγίσεων με πίνακες πίνακας για εκπαίδευση (N T N T ) πίνακας για έλεγχο (N t N T ) πίνακας περιορισμών K r (N T + N t) (N T + N t) svm A C - χωρίς περιορισμούς PA Ã C A CT C D PT A p CA p 1 A CT 0 0 A p PSV S A p 1 S A T [ ] A S A T NSS CT S NSS A NSS A p 1 S A NS A p 2 C S A p 1 S C S A p 2 S A NSS S A NS [ ] Συνοπτικά οι πίνακες που χρησιμοποιούνται για εκπαίδευση και έλεγχο, καθώς και οι πίνακες περιορισμού, αν υπάρχουν, για τις 3 προσεγγίσεις που προτείνονται καθώς και για τα απλά svm φαίνονται στον Πίνακα 3.1.

47 Κεφάλαιο 4 Πειράματα Σε αυτό το κεφάλαιο παρουσιάζουμε αποτελέσματα κατηγοριοποίησης σε διάφορα σύνολα δεδομένων. Τα περισσότερα σύνολα δεδομένων υπάρχουν στοuci machine learning repository και τα υπόλοιπα στην ιστοσελίδα της βιβλιοθήκης libsvm. Τα σύνολα δεδομένων και τα χαρακτηριστικά τους φαίνονται στον Πίνακα 4.1. Τα τελευταία τρία σύνολα δεδομένων είναι τεχνητά σύνολα δεδομένων, όπως επίσης και τα σύνολα Balance1 και Balance3 των οποίων ο τρόπος παραγωγής θα εξηγηθεί αργότερα. Για την αξιολόγηση των ποσοστών επιτυχίας της ταξινόμησης στα διάφορα πειράματα χρησιμοποιήσαμε 5 φορές τυχαία διαμέριση στη μέση δηλαδή 5 2 fold cross validation. Πιο συγκεκριμένα σε κάθε επανάληψη τα δεδομένα μας χωρίζονται σε δύο υποσύνολα S 1 και S 2 του αρχικού τα οποία είναι και ξένα μεταξύ τους, βεβαιώνοντας ότι τα δείγματα κάθε κλάσης μοιράζονται δίκαια στα υποσύνολα στημέση. Εφαρμόζουμε τον εκάστοτε αλγόριθμο στο υποσύνολο εκπαίδευσης S 1 και ελέγχουμε στο υποσύνολο ελέγχου S 2, στη συνέχεια εφαρμόζουμε το αντίθετο θεωρώντας το S 2 σαν τα δεδομένα εκπαίδευσης και το S 1 για δεδομένα ελέγχου. Το ποσοστό ελέγχου σωστής ταξινόμησης υπολογίζεται μέσω του μέσου όρου όλων των 5 2 αποτελεσμάτων. Ημορφήτουαλγόριθμουτου5 2 fold cross validation, δίνεται στον αλγόριθμο 1 και όλες οι τυχαίες διαμερίσεις κρατιούνται ίδιες για όλους τους αλγόριθμους για να 37

48 38 Κεφάλαιο 4. Πειράματα Πίνακας 4.1: Χαρακτηριστικά των 31 συνόλων δεδομένων Σύνολο δεδομένων Πλήθος δειγμάτων Διαστάσεις Κλάσεις Heartscale Ionosph sonar australian breast-cancer diabetes fourclass german liver-dis mamographic colon PlanRelax habberman bloodtransfusion Wine Iris Balance Balance Balance svmguide seeds vehicle Glass Ecoli cnae Yale Libras FacesMat halfmoon cocentral swissroll

49 39 έχουμε δίκαια σύγκριση. Αλγόριθμος fold cross validation 1: r =0{η τελική απόδοση του αλγορίθμου} 2: Για j =1 Εως 5 Επανέλαβε 3: Χώρισμα του συνόλου δεδομένων σε δύο ίσα υποσύνολα S j1 και S j2 4: Εκπαίδευση του αλγορίθμου στο S j1 5: r j1 {Αποτέλεσμα ταξινόμησης του αλγορίθμου στο S j2 } 6: Εκπαίδευση του αλγορίθμου στο S j2 7: r j2 {Αποτέλεσμα ταξινόμησης του αλγορίθμου στο S j1 } 8: r = r + r j1 + r j2 9: Τέλος Επανάληψης 10: r = r 10 Ηαποτελεσματικότηταενόςμοντέλουτωνμηχανώνδιανυσμάτωνυποστήριξηςεξαρτάται από τις παραμέτρους που χρησιμοποιούνται κατά την εκπαίδευση. Ο πιο συνηθισμένος τρόπος επιλογής παραμέτρων είναι η επιλογή μέσα από την εξαντλητική δοκιμή πλέγματος παραμέτρων grid search. Πιο συγκεκριμένα εκπαιδεύουμε με εκθετικά αυξανόμενες τιμές για το C {2 5,...,2 15 } και για το γ {2 15,...,2 3 }, όπου γ = 1 σ 2. Προφανώς το εσωτερικό γινόμενο στη περίπτωση του γραμμικού πυρήνα χρειάζεται μόνο την παράμετρο C ενώ στη περίπτωση του μη γραμμικού πυρήνα, ο rbf χρειάζεται και τις δυο παραμέτρους C και γ. Οπως συνηθίζεται, κάθε συνδυασμός παραμέτρων ελέγχεται χρησιμοποιώντας την μέθοδο διασταυρωμένης επικύρωσης (cross validation), στη δική μας περίπτωση 5 fold cross validation. Στο τέλος επιλέγονται οι παράμετροι με την καλύτερη ακρίβεια. Οπως πριν, όλες οι τυχαίες διαμερίσεις κρατιούνται ίδιες για όλους τους αλγόριθμους για να έχουμε δίκαια σύγκριση. Το τελικό μοντέλο το οποίο χρησιμοποιείται και κατά την διαδικασία της πρόβλεψης νέων δεδομένων, εκπαιδεύεται σε όλο το σύνολο δειγμάτων

50 40 Κεφάλαιο 4. Πειράματα Πίνακας 4.2: Συνδυασμοί στην διαδικασία grid search Μέθοδος Inner Product Heat Kernel svm C {2 5,...,2 15 } C {2 5,...,2 15 } γ {2 15,...,2 3 } PA C {2 5,...,2 15 } p {1, 2,...,7} C {2 5,...,2 15 } γ {2 15,...,2 3 } p {1, 2,...,7} PT C {2 5,...,2 15 } p {1, 2,...,7} C {2 5,...,2 15 } γ {2 15,...,2 3 } p {1, 2,...,7} PSV C {2 5,...,2 15 } p {1, 2,...,7} C {2 5,...,2 15 } γ {2 15,...,2 3 } p {1, 2,...,7} εκπαίδευσης χρησιμοποιώντας τις παραμέτρους που επιλέχθηκαν όπως περιγράφεται στο [47]. Επιπλέον, στην προτεινόμενη μέθοδο χρειάζεται να επιλέξουμε την τιμή της παραμέτρου p. Χρησιμοποιούμε την ίδια διαδικασία με πριν, προσθέτοντας την σειρά p {1, 2,...,7}. Παρατηρούμε ότι αν p =1, τότε οι πίνακες πυρήνα δεν αλλάζουν σε σχέση με τον κλασικό τρόπο που χρησιμοποιούνται στις μηχανές διανυσμάτων υ- ποστήριξης. Οπότε μπορούμε να πούμε ότι ο κλασικός τρόπος μηχανών διανυσμάτων υποστήριξης είναι μια υποπερίπτωση της δική μας μεθόδου. Για τηνακρίβειααυτό ισχύει μόνο για τις προσεγγίσεις του PA και PT. Συνοπτικά οι δυνατοί συνδυασμοί ανά μέθοδο και ανά πυρήνα φαίνονται στον Πίνακα 4.2. Ενα άλλο πρόβλημα το οποίο πρέπει να αναφέρουμε είναι η ευαισθησία του αλγορίθμου LIBSVM στο εύρος τιμών του πυρήνα. Για αυτό το λόγο επιλέξαμε να κανονικοποιήσουμε τις τιμές του πυρήνα σύμφωνα με τον τρόπο που περιγράφεται στο [20] και υπολογίζεται ως: K p (x i, x j )= K p (x i, x j ) Kp (x i, x i )K p (x j, x j ) (4.1) Πρέπει να λάβουμε υπόψιν ότι η κανονικοποίηση του πυρήνα εφαρμόζεται στον πίνακα KK p 1 r οοποίοςκαιστιςτρειςπροσεγγίσειςπουπροτείναμεείναιτετραγωνικός, συμμετρικός και οι διαγώνιες τιμές είναι διαφορετικές του μηδενός. Ακόμη, κάποια σύνολα δεδομένων έχουν παραπάνω από 2 κλάσεις, το οποίο μετατρέπει το πρόβλημα από δυαδικό σε κατηγοριοποίηση πολλών κλάσεων (multiclass).

51 41 Παρ όλα αυτά η βιβλιοθήκη LIBSVM μπορεί και χειρίζεται αυτά τα προβλήματα ως πρόβλημα ενός εναντίον ενός (one versus one) δημιουργώντας k(k 1)/2 δυαδικά μοντέλα μηχανών διανυσμάτων υποστήριξης, όπου k είναι ο αριθμός των κλάσεων. Στη συνέχεια εκτιμούμε την απόδοση των απλών μηχανών διανυσμάτων υποστήριξης εναντίον των προτεινόμενων μεθόδων PA, PT, PSV εκτελώντας πειράματα για γραμμικούς και μη γραμμικούς πυρήνες και τα αποτελέσματα φαίνονται στους Πίνακες 4.3 και 4.4 αντιστοίχως. Τα αποτελέσματα στις στήλες 1-4 εκτιμήθηκαν χρησιμοποιώντας grid search, η 5η στήληείναιίδιαμετην1η καιστιςστήλες6 έως 8 φαίνεται ηαπόδοσηχρησιμοποιώνταςτηνκαλύτερηδύναμητουπυρήνα. Η σύγκριση που κάνουμε είναι εναντίον του κλασικού SVM. 1ηστήληεναντίοντωνστηλών2,3,4 και η 5η στήληεναντίοντωνστηλών6,7,8. Ητελευταίασειράσυγκρίνει την ολική απόδοση των αλγορίθμων μετρώντας το πλήθος των συνόλων δεδομένων που κέρδισε, έχασε, ή ήρθε ισοπαλία. Κάθε φορά η σύγκριση γίνεται εναντίον των κλασικών SVM. Το σύνολο δεδομένων Balance όπως περιγράφεται στο [2] έχει δημιουργηθεί με 4 χαρακτηριστικά για κάθε δείγμα, το κάθε χαρακτηριστικό παίρνει τιμές από το 1 έως το 5 με αποτέλεσμα όλους τους πιθανούς συνδυασμούς δειγμάτων, 5 4 =625. Ηκλάση η οποία γίνεται ανάθεση στο κάθε δείγμα υπολογίζεται συγκρίνοντας το γινόμενο των δυο πρώτων χαρακτηριστικών με το γινόμενο των δύο τελευταίωνχαρακτηριστικών, μέσω της σύγκρισης προκύπτουν 3 κλάσεις, μεγαλύτερο, ίσο ή μικρότερο. Επεκτείνοντας την έννοια αυτή σε 2 και 6 χαρακτηριστικά δημιουργήσαμε τα σύνολα δεδομένων Balance1 και Balance3 αντίστοιχα. Στην Balance1 δύο χαρακτηριστικά παίρνουν τιμές από το 1 έως το 20 και όλοι οι συνδυασμοί είναι 20 2 =400και στην Balance3 έξι χαρακτηριστικά παίρνουν τιμές από το 1 έως το 3 και όλοι οι συνδυασμοί είναι 3 6 =729. Οι κλάσεις των δειγμάτων υπολογίζονται συγκρίνοντας τα 2 χαρακτηριστικά και το γινόμενο των 3 πρώτων χαρακτηριστικών με το 3 τελευταίων χαρακτηριστικών για τα σύνολα δεδομένων Balance1 και Balance3 αντίστοιχα, καθορίζοντας αν τα

52 Πίνακας 4.3: Αποτελέσματα Ταξινόμησης Inner product 31 datasets Inner Product - Grid Search Inner Product - Best power Σύνολο δεδομένων απλό PA PT PSV απλό PA PT PSV Heartscale Ionosph sonar australian breast-cancer diabetes fourclass german liver-dis mamographic colon PlanRelax habberman bloodtransfusion Wine Iris Balance Balance Balance svmguide seeds vehicle Glass Ecoli cnae Yale Libras FacesMat halfmoon cocentral swissroll Νίκες/Ισοπαλίες/ Ηττες εναντίον του απλού - 9/14/9 6/16/10 6/16/10-17/4/11 17/4/11 17/4/11 42 Κεφάλαιο 4. Πειράματα

53 Πίνακας 4.4: Αποτελέσματα Ταξινόμησης Heat kernel 31 datasets Heat kernel - Grid Search Heat kernel - Best power Σύνολο δεδομένων απλό PA PT PSV απλό PA PT PSV Heartscale Ionosph sonar australian breast-cancer diabetes fourclass german liver-dis mamographic colon PlanRelax habberman bloodtransfusion Wine Iris Balance Balance Balance svmguide seeds vehicle Glass Ecoli cnae Yale Libras FacesMat halfmoon cocentral swissroll Νίκες/Ισοπαλίες/ Ηττες εναντίον του απλού - 12/4/16 10/6/16 7/11/14-22/3/7 21/3/8 14/5/13 43

54 44 Κεφάλαιο 4. Πειράματα γινόμενα είναι μεγαλύτερα, ίσα ή μικρότερα για τις τρεις κλάσεις. Για την σύγκριση των αλγορίθμων όπως γίνεται στην διεθνή βιβλιογραφία χρησιμοποιείται κάποιο στατιστικό τεστ. Στη παρούσα εργασία, το στατιστικό τεστ που χρησιμοποιήσαμε το οποίο υπολογίζει αν η διαφορά απόδοσης σε ένασύνολοδεδομέ- νων ανάμεσα σε δύο αλγορίθμους είναι στατιστικά σημαντική ήταν το στατιστικό τεστ 5x2cv και περιγράφεται στο [15]. Συγκεκριμένα το τεστ υπολογίζει το εξής: f = 5 2 i=1 j=1 (d(j) i ) i=1 s2 i (4.2) όπου d (j) i είναι η διαφορά των αποτελεσμάτων ταξινόμησης στην i οστή επανάληψη του j οστού διαχωρισμού των δεδομένων στον αλγόριθμο 5 2 fold cross validation, και s i η διασπορά των αποτελεσμάτων των επιμέρους διαχωρισμών τους. Για να θεωρηθεί στατιστικά σημαντική η διαφορά θα πρέπει f>4.74. Επιπλέον, χρησιμοποιήσαμε τις αποδόσεις των αλγορίθμων για να συγκρίνουμε τις προτεινόμενες μεθόδους εναντίον του απλού svm όπως περιγράφεται στο [14] χρησιμοποιώντας το στατιστικό τεστ του wilcoxon [50] και το στατιστικό τεστ sign test [39]. Το στατιστικό τεστ του wilcoxon είναι μια μη παραμετρική μέθοδος, εναλλακτική του τεστ paired t test, η οποία ταξινομεί τις διαφορές στις αποδόσεις των δυο κατηγοριοποιητών για όλα τα σύνολα δεδομένων, αγνοώντας το πρόσημο και συγκρίνει την ταξινόμηση των διαφορών για θετικές ή αρνητικές διαφορές. Ας υποθέσουμε ό- τι d i είναι η διαφορά ανάμεσα στις αποδόσεις των δυο κατηγοριοποιητών στο i οστό σύνολο δεδομένων ανάμεσα στα N σύνολα δεδομένων. Οι διαφορές ταξινομούνται με βάση τις απόλυτες τιμές τους, στη περίπτωση ισοπαλίας εισάγεται ο μέσος όρος. Ας ορίσουμε το R + να είναι το άθροισμα της σειράς ταξινόμησης στα σύνολα δεδομένων που ο δεύτερος αλγόριθμος κέρδισε τον πρώτο και το R να είναι το άθροισμα της

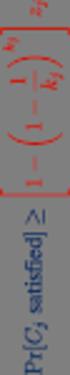

55 45 αντίθετης περίπτωσης. Ησειράταξινόμησηςότανd i =0χωρίζεται στη μέση στα δύο αθροίσματα και αν υπάρχει μονός αριθμός τότε αγνοείται, επομένως: R + = rank(d i )+ 1 rank(d i ) 2 d i >0 d i =0 R = rank(d i )+ 1 rank(d i ) 2 d i <0 Ας υποθέσουμε ότι το T είναι το μικρότερο από τα δύο αθροίσματα, δηλαδή T = min(r +,R ). Για μεγάλο πλήθος συνόλων δεδομένων η παρακάτω κατανομή είναι κανονική: d i =0 z = 1 24 T 1 N(N +1) 4 N(N +1)(2N +1) Τελικά με βαθμό εμπιστοσύνης 95%, ημηδενικήυπόθεσημπορείνα απορριφθεί αν z< Το στατιστικό τεστ sign test συγκρίνει των αριθμό των νικών/ηττών ανάμεσα στους δύο κατηγοριοποιητές. Αν οι δυο υπό σύγκριση αλγόριθμοι θεωρηθούν παρόμοιοι υποστηρίζοντας την μηδενική υπόθεση τότε κάθε ένας πρέπει να επικρατεί περίπου στα μισά σύνολα δεδομένων. Το πλήθος των νικών ακολουθεί διωνυμική κατανομή, οπότε αν το πλήθος των συνόλων δεδομένων είναι αρκετά μεγάλο τότε για να είναι καλύτερος ο ένας αλγόριθμος από τον άλλον πρέπει με 95% βαθμό εμπιστοσύνης να επικρατεί τουλάχιστον στα (N/ N/2) σύνολα δεδομένων. Στη δική μας περίπτωση το σύνολο των δεδομένων είναι 31 οπότε πρέπει να επικρατεί σε τουλάχιστον 21 σύνολα δεδομένων. Παρατηρώντας την ολική απόδοση των αλγορίθμων στους πίνακες 4.3 και 4.4 μπορούμε να πούμε ότι το grid search δεν παρουσιάζει πολλές διαφορές σε σχέση με το απλό svm. Στη πραγματικότητα μόνο η προσέγγιση PA στον γραμμικό πυρήνα καταφέρνει να έχει τηνίδια ολική απόδοση με το απλόsvm. Παρόλα αυτά χρησιμοποιήθηκαν

56 46 Κεφάλαιο 4. Πειράματα τα στατιστικά τεστ wilcoxon και sign test και δεν παρουσιάζεται κάποια στατιστικά σημαντική διαφορά. Αντιθέτως, αν επιλέξουμε την καλύτερη δύναμη του πυρήνα για κάθε σύνολο δεδομένων, όλες οι προσεγγίσεις μας έχουν καλύτερη ολική απόδοση, αυτό συμβαίνει και στον γραμμικό και στον μη γραμμικό πυρήνα. Επιπροσθέτως, σύμφωνα και με δύο στατιστικά τεστ οι μέθοδοι PA και PT διαφέρουν από το απλό svm με 95% βαθμό εμπιστοσύνης. Ωστόσο, το πρόβλημα με την επιλογή τουp είναι ότι δεν είναι απλή, και δεν υπάρχει αιτιολόγηση για το ποιο p πρέπει να χρησιμοποιήσουμε. Παρ όλα αυτά μπορούμε να πούμε ότι υπάρχει μια δύναμη πυρήνα που αν χρησιμοποιηθεί για κατηγοριοποίηση θα φέρει αποτελέσματα που θα είναι στατιστικώς καλύτερα με 95% βαθμό εμπιστοσύνης. Πιο αναλυτικά, στον γραμμικό πυρήνα εκτελέσαμε το στατιστικό τεστ 5x2cv για όλα τα σύνολα δεδομένων και για όλους τους αλγόριθμους και η μόνη στατιστικά σημαντική διαφορά βρέθηκε στο σύνολο δεδομένων cocentral. Σε όλες τις προτεινόμενες μεθόδους, η τιμή του στατιστικού τεστ ήταν πάνω από 9. Η μορφή των δεδομένων είναι τρεις ομόκεντροι κύκλοι. Είναι προφανές ότι το απλό svm αποτυγχάνει να διαχωρίσει τους τρεις κύκλους, εφόσον τα δεδομένα είναι μη γραμμικά διαχωρίσιμα. Ολες οι προσεγγίσεις καταφέρνουν καλύτερη διαχωρισιμότητα των δεδομένων από τι μπορεί να διαχωρίσει συνήθως ένας γραμμικός πυρήνας. Αξίζει να αναρωτηθεί κανείς πως γίνεται και διαχωρίζονται τα δεδομένα στατιστικώς καλύτερα. Ενας λόγος για τον οποίο να συμβαίνει αυτό είναι σκεπτόμενοι την δική μας προσέγγιση ως μετασχηματισμό δεδομένων όπως δείξαμε στο κεφάλαιο 3, όπου δείξαμε ότι ο γραμμικός πυρήνας υψωμένος σε κάποια δύναμη είναι σαν να μετασχηματίζει τα δεδομένα πολλαπλασιάζοντας τον data matrix X, με D p 1 2 U T. Ακόμη, το σύνολο δεδομένων Balance1 είναι εύκολο να διαχωριστεί όταν χρησιμοποιείται γραμμικός πυρήνας εφόσον τα δείγματα είναι γραμμικώς διαχωρίσιμα, για αυτό άλλωστε και η απόδοση είναι άψογη. Παρόλα αυτά όπως μπορούμε να δούμε

57 47 στον πίνακα 4.4 όταν χρησιμοποιηθεί ο πυρήνας RBF ομηγραμμικόςμετασχηματι- σμός των δεδομένων επιφέρει αρνητικά αποτελέσματα. Ευτυχώςότανχρησιμοποιηθούν οι προτεινόμενοι πυρήνες στις προσεγγίσεις PA και PT το πρόβλημα επιλύεται. Αυτό μπορεί να παρατηρηθεί σε όλα τα σύνολα δεδομένων τύπου balance. Για την ακρίβεια, ηδιαφοράστιςαποδόσειςχρησιμοποιώνταςτονορισμότουdietterich είναι στατιστικά σημαντικές για τις προσεγγίσεις PA και PT με τις τιμές του τεστ να είναι πάνω από 78, 30 και 62 για τα σύνολα των δεδομένων Balance1, Balance, και Balance3 αντιστοίχως. Επιπλέον παρατηρούμε ότι η απόδοση των αλγορίθμων PA χρησιμοποιώντας τον πυρήνα RBF στα σύνολα δεδομένων Balance και Balance3 είναι καλύτερη ακόμη και από την απόδοση του γραμμικού πυρήνα, αν και δείγματα στα σύνολα δεδομένων τύπου balance είναι δυνητικά γραμμικά διαχωρίσιμα. Στη συνέχεια θα μιλήσουμε για το υπολογιστικό κόστος του απλού svm και των δικών μας μεθόδων. Γενικότερα η υπολογιστική πολυπλοκότητα ενός svm είναι O(n 3 ) [9]. Επιπλέον, θεωρητικά η πολυπλοκότητα στον πολλαπλασιασμό πινάκων είναι O(n ) [51], αν και θα μπορούσαμε να εκτελέσουμε p 1 πολλαπλασιασμούς με κόστος O((p 1)n ), στην πράξη, την εύρεση μια δύναμης ενός πίνακα την βρίσκουμε διαφορετικά. Επειδή στη δική μας μέθοδο υψώνουμε τον πυρήνα σε πολλές διαφορετικές δυνάμεις, στην πράξη είναι συντομότερο να χωρίσουμε τον πυρήνα K αναλύοντας τον σε ιδιοδιανύσματα και ιδιοτιμές K = UDU T, το οποίο έχει υπολογιστικό κόστος O(n 3 ) και μετά χρησιμοποιούμε την ιδιότητα K p = UD p U T. Με τον τελευταίο τρόπο το υπολογιστικό κόστος εύρεσης μιας δύναμης εφόσον έχουμε ήδηυπολογίσειτην ιδιοανάλυση του είναι αμελητέο. Οπότε η κύρια διαφορά απλού svm σε σχέση με τις δικές μας προτεινόμενες μέθοδοι είναι το επιπλέον κόστος για τον πολλαπλασιασμό πινάκων του πυρήνα. Οπότε μπορούμε να πούμε ότι το υπολογιστικό κόστος είναι O(n 3 + n 3 ) για τις μεθόδους PA και PT ενώ για την PSV είναι O(n 3 + n 3 + n 3 ), εφόσον στην τελευταία απαιτείται

58 48 Κεφάλαιο 4. Πειράματα ηγνώσητωνδιανυσμάτωνυποστήριξης. Οπότε με ασφάλεια μπορούμε να πούμε ότι ηδικήμαςμέθοδοιέχουντηνίδιατάξηπολυπλοκότηταςμετοαπλό svm, στην πράξη όμως οι μέθοδοι μας είναι είναι πιο αργοί. Οπως είπαμε η εύρεση του p δεν είναι απλή επομένως αν κατευθυνθούμε στο grid search για την εύρεση της κατάλληλης δύναμης κάνουμε περίπου l φορές πιο αργή εκπαίδευση όπου l είναι το πλήθος των διαφορετικών δυνάμεων του πυρήνα που δοκιμάζουμε. Ωστόσο δεν υπάρχει απόδειξη ότι ο χρόνος εκπαίδευσης για κάθε δύναμη είναι ίδιος, οπότε αν πούμε ότι είναι ακριβώς l φορές αργότερο θα ήταν παραπλανητικό. Κάθε δύναμη οδηγεί σε διαφορετικό πρόβλημα βελτιστοποίησης οπότε και σε διαφορετικό χρόνο εκτέλεσης. 4.1 Εφαρμογές στην μάθηση δραστηριότητας (activity learning) Η αναγνώριση δραστηριότητας είναι μια σημαντική τεχνολογία επειδήμπορείναε- φαρμοστεί σε πολλά καθημερινά ανθρωποκεντρικά προβλήματα όπως είναι περίθαλψη ηλικιωμένων και γενικότερα στο χώρο της υγείας. Πετυχημένεςέρευνεςεστίαζανστην αναγνώριση απλών ανθρώπινων ενεργειών. Ηαναγνώρισηπερίπλοκων δραστηριοτήτων παραμένει ανοιχτό πρόβλημα και ενεργό πεδίο έρευνας. Ηφύσητου προβλήματος είναι τέτοια που θέτει περιορισμούς. Τα προβλήματα που συναντώνται σε σύνθετες δραστηριότητες είναι ότι οι άνθρωποι μπορούν να κάνουν περισσότερες από μια δραστηριότητες ταυτόχρονα, κάποιες δραστηριότητες μπορεί να διακοπούν από κάποιεςάλλες, τέλος σε κάποιες δραστηριότητες μπορεί να συμμετέχουν 2 ήπερισσότερα άτομα. Στην προηγούμενη ενότητα χρησιμοποιήσαμε κλασικά σύνολα δεδομένων, στην παρούσα ενότητα θα χρησιμοποιήσουμε κάποια πραγματικά προβλήματα κατηγοριοποίησης. Συμπεριλάβαμε στα πειράματα μας κάποια σύνολα δεδομένων για αναγνώριση δραστηριότητας, στα οποία άνθρωποι κάνουν διάφορες δραστηριότητες το οποίο έχει

59 4.1 Εφαρμογές στην μάθηση δραστηριότητας (activity learning) 49 Σχήμα 4.1: Ενα άτομο κατά τη διάρκεια του γεύματος στο σύνολο δεδομένων mobiserv. ως αποτέλεσμα το πρόβλημα να είναι κατηγοριοποίηση με πολλαπλές ετικέτες multilabeled. Ωστόσο, το πρόβλημα που επιλέξαμε να επιλύσουμε είναι αυτό της αναγνώρισης της δραστηριότητας που κάνει το κάθε άτομο, χωρίς να μας ενδιαφέρει ποιος/ποια α- πεικονίζεται. Κάποια χαρακτηριστικά τους φαίνονται συνοπτικά στον Πίνακα 4.5. Το σύνολο δεδομένων mobiserv [25] περιλαμβάνει δώδεκα άτομα, έξι γυναίκες και έξι άντρες, να γευματίζουν. Ηκάμερατοποθετήθηκεδύομέτραμακριά από τα άτομα. Τέσσερα γεύματα καταγράφηκαν για το κάθε άτομο σε τέσσερις διαφορετικές ημέρες. Οι δραστηριότητες που εμφανίζονται στο σύνολο δεδομένων είναι: τρώω, πίνω, απραξία. Κάθε άτομο, σε ένα γεύμα, εκτέλεσε διαφορετικό αριθμό από τις δραστηριότητεςπου μόλις αναφέραμε. Τέλος, δύο εικόνες που απεικονίζουν ένα άτομο κατά τη διάρκεια του γεύματος φαίνεται στο Σχήμα 4.1. Η i3dpost [18] αποτελείται από 64 υψηλής ανάλυσης εικονοσειρές και απεικονίζουν οχτώ άτομα, δύο γυναίκες και έξι άντρες, να εκτελούν οχτώ δραστηριότητες. Οχτώ κάμερες, κάθε μια καλύπτει 45 μοίρες, συνολικά καλύπτουν 360 μοίρες δημιουργώντας έναν κύκλο διαμέτρου οχτώ μέτρων, σε ύψος 2 μέτρα πάνω από το πάτωμα. Το στούντιο καλύφθηκε με μπλε φόντο (background). Οι δραστηριότητες που περιλαμβάνονται στο σύνολο δεδομένων είναι: περπάτημα, τρέξιμο, επιτόπιο άλμα, εμπρόσθιο άλμα, σκύψιμο, κάθισμα κάτω, κάθισμα σε καρέκλα, χαιρετισμός με ένα χέρι. Οχτώ

60 50 Κεφάλαιο 4. Πειράματα Πίνακας 4.5: Χαρακτηριστικά συνόλων δεδομένων αναγνώρισης δραστηριότητας Σύνολο δεδομένων Πλήθος δειγμάτων Διαστάσεις Κλάσεις Άτομα mobiserv mobiserv mobiserv mobiserv mobiserv i3dpoststips i3dpoststips i3dpoststips i3dpoststips i3dpoststips i3dpostmasks i3dpostmasks i3dpostmasks i3dpostmasks i3dpostmasks ixmas ixmas ixmas ixmas ixmas

61 4.1 Εφαρμογές στην μάθηση δραστηριότητας (activity learning) 51 Σχήμα 4.2: 8 εικόνες που απεικονίζουν ένα άτομο του συνόλου δεδομένων i3dpost από 8 διαφορετικές γωνίες. συγχρονισμένες εικόνες απεικονίζοντας το ίδιο άτομο να εκτελεί την ίδια δραστηριότητα φαίνονται στο Σχήμα 4.2. Το σύνολο δεδομένων IXMAS, [49][48]περιλαμβάνει 12 άτομα να εκτελούν 13 δραστηριότητες, την μια δραστηριότητα δεν την συμπεριλάβαμε, και καταγράφηκαν από 5 κάμερες, από 3 διαφορετικές φορές. Τα άτομα ήταν ελεύθερα να αλλάζουν τον προσανατολισμό τους και δεν υπήρχαν ιδιαίτερες οδηγίες για το πως να εκτελέσουν τις δραστηριότητες τους. Κάποιες δραστηριότητες των ατόμων φαίνονται στο Σχήμα 4.3. Κάθε σύνολο δεδομένων που αναφέραμε μπορεί να αναπαρασταθεί από ένα πλήθος διαφορετικών διαστάσεων, για περισσότερες πληροφορίες δείτε τις εργασίες [26] και [25]. Για τη διαμέριση των συνόλων δεδομένων σε σύνολο εκπαίδευσης καισύνολοελέγ-

62 52 Κεφάλαιο 4. Πειράματα Σχήμα 4.3: Διάφορες δραστηριότητες 3 ατόμων στο σύνολο δεδομένων IXMAS. χου εκτελέσαμε όπως αναφέρεται στη βιβλιογραφία την μέθοδο Leave One Person Out δημιουργούμε P folds, όπου P είναι το πλήθος των ανθρώπων σε κάθε σύνολο δεδομένων. Σε κάθε fold το σύνολο ελέγχου απαρτίζεται από τις δραστηριότητες ενός ατόμου και στο σύνολο εκπαίδευσης περιέχονται οι δραστηριότητες των υπόλοιπων P 1 ατόμων. Ητελικήαπόδοσηκατηγοριοποίησηςδίνεταιαπότονμέσο όρο της απόδοσης σε κάθε ένα σύνολο ελέγχου. Ημορφήτουαλγόριθμου φαίνεται στον αλγόριθμο 2. Τα αποτελέσματα κατηγοριοποίησης φαίνονται στους Πίνακες 4.6 και 4.7. Περισσότερο στον γραμμικό πυρήνα και λιγότερο στο heat kernel, μπορούμε να δούμε ότι ημέθοδοςμαςείναικαλύτερητουαπλούsvm. Ημορφήτωνδεδομένωνενδεχομένως να είναι περίπλοκη, οπότε μία απλή απόσταση δεν είναι αντιπροσωπευτική ολόκληρης την δομής των δεδομένων. Οι δικές μας μέθοδοι έχουν καταφέρει νακρατήσουνπιο αποδοτικά την μορφή των δεδομένων, το οποίο φαίνεται γενικότερα από τις αποδόσεις στις κατηγοριοποιήσεις των δεδομένων. Ωστόσο, δεν μπορούμε να βγάλουμε κάποιο συμπέρασμα χρησιμοποιώντας στατιστικά τεστ καθώς τα σύνολα δεδομένωνδενείναι ανεξάρτητα μεταξύ τους οπότε τα στατιστικά τεστ wilcoxon και sign test δεν μπορούν να χρησιμοποιηθούν.

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Μέθοδοι Μηχανών Μάθησης για Ευφυή Αναγνώριση και ιάγνωση Ιατρικών εδοµένων Εισηγητής: ρ Ηλίας Ζαφειρόπουλος Εισαγωγή Ιατρικά δεδοµένα: Συλλογή Οργάνωση Αξιοποίηση Data Mining ιαχείριση εδοµένων Εκπαίδευση

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Πανεπιστήµιο Κύπρου Πολυτεχνική Σχολή Τµήµα Ηλεκτρολόγων Μηχανικών και Μηχανικών Υπολογιστών ΗΜΜΥ 795: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ Ακαδηµαϊκό έτος 2010-11 Χειµερινό Εξάµηνο Τελική εξέταση Τρίτη, 21 εκεµβρίου 2010,

Ζητήματα ηήμ με τα δεδομένα

Ζητήματα ηήμ με τα δεδομένα Ποιότητα Απαλοιφή θορύβου Εντοπισμός ανωμαλιών λώ Ελλιπείς τιμές Μετασχηματισμός Κβάντωση Μείωση μεγέθους Γραμμών: ειγματοληψία Στηλών: Ιδιοδιανύσματα, Επιλογή χαρακτηριστικών

Ζητήματα ηήμ με τα δεδομένα Ποιότητα Απαλοιφή θορύβου Εντοπισμός ανωμαλιών λώ Ελλιπείς τιμές Μετασχηματισμός Κβάντωση Μείωση μεγέθους Γραμμών: ειγματοληψία Στηλών: Ιδιοδιανύσματα, Επιλογή χαρακτηριστικών

ΒΑΣΙΚΑ ΣΤΟΙΧΕΙΑ ΘΕΩΡΙΑΣ ΤΗΣ ΜΕΘΟΔΟΥ SIMPLEX

ΒΑΣΙΚΑ ΣΤΟΙΧΕΙΑ ΘΕΩΡΙΑΣ ΤΗΣ ΜΕΘΟΔΟΥ SIMPLEX Θεμελιώδης αλγόριθμος επίλυσης προβλημάτων Γραμμικού Προγραμματισμού που κάνει χρήση της θεωρίας της Γραμμικής Άλγεβρας Προτάθηκε από το Dantzig (1947) και πλέον

ΒΑΣΙΚΑ ΣΤΟΙΧΕΙΑ ΘΕΩΡΙΑΣ ΤΗΣ ΜΕΘΟΔΟΥ SIMPLEX Θεμελιώδης αλγόριθμος επίλυσης προβλημάτων Γραμμικού Προγραμματισμού που κάνει χρήση της θεωρίας της Γραμμικής Άλγεβρας Προτάθηκε από το Dantzig (1947) και πλέον

Επαγωγικές Μηχανές Διανυσμάτων Στήριξης και εφαρμογή σε προβλήματα ταξινόμησης

ΑΡΙΣΤΟΤΕΛΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΕΣΣΑΛΟΝΙΚΗΣ ΤΜΗΜΑ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ ΚΑΙ ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ ΤΟΜΕΑΣ ΗΛΕΚΤΡΟΝΙΚΗΣ ΚΑΙ ΗΛΕΚΤΡΟΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ ΔΙΠΛΩΜΑΤΙΚΗ ΕΡΓΑΣΙΑ Επαγωγικές Μηχανές Διανυσμάτων Στήριξης

ΑΡΙΣΤΟΤΕΛΕΙΟ ΠΑΝΕΠΙΣΤΗΜΙΟ ΘΕΣΣΑΛΟΝΙΚΗΣ ΤΜΗΜΑ ΗΛΕΚΤΡΟΛΟΓΩΝ ΜΗΧΑΝΙΚΩΝ ΚΑΙ ΜΗΧΑΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ ΤΟΜΕΑΣ ΗΛΕΚΤΡΟΝΙΚΗΣ ΚΑΙ ΗΛΕΚΤΡΟΝΙΚΩΝ ΥΠΟΛΟΓΙΣΤΩΝ ΔΙΠΛΩΜΑΤΙΚΗ ΕΡΓΑΣΙΑ Επαγωγικές Μηχανές Διανυσμάτων Στήριξης

Τεχνητή Νοημοσύνη. 18η διάλεξη ( ) Ίων Ανδρουτσόπουλος.

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Τεχνητή Νοημοσύνη 18η διάλεξη (2016-17) Ίων Ανδρουτσόπουλος http://www.aueb.gr/users/ion/ 1 Οι διαφάνειες αυτής της διάλεξης βασίζονται: στο βιβλίο Machine Learning του T. Mitchell, McGraw- Hill, 1997,

Ακαδημαϊκό Έτος , Χειμερινό Εξάμηνο Διδάσκων Καθ.: Νίκος Τσαπατσούλης

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΛΟΠΟΝΝΗΣΟΥ, ΤΜΗΜΑ ΤΕΧΝΟΛΟΓΙΑΣ ΤΗΛΕΠΙΚΟΙΝΩΝΙΩΝ ΚΕΣ 3: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΚΑΙ ΑΝΑΛΥΣΗ ΕΙΚΟΝΑΣ Ακαδημαϊκό Έτος 7 8, Χειμερινό Εξάμηνο Καθ.: Νίκος Τσαπατσούλης ΕΡΩΤΗΣΕΙΣ ΕΠΑΝΑΛΗΨΗΣ Το παρόν

ΠΑΝΕΠΙΣΤΗΜΙΟ ΠΕΛΟΠΟΝΝΗΣΟΥ, ΤΜΗΜΑ ΤΕΧΝΟΛΟΓΙΑΣ ΤΗΛΕΠΙΚΟΙΝΩΝΙΩΝ ΚΕΣ 3: ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΚΑΙ ΑΝΑΛΥΣΗ ΕΙΚΟΝΑΣ Ακαδημαϊκό Έτος 7 8, Χειμερινό Εξάμηνο Καθ.: Νίκος Τσαπατσούλης ΕΡΩΤΗΣΕΙΣ ΕΠΑΝΑΛΗΨΗΣ Το παρόν

z = c 1 x 1 + c 2 x c n x n

Τεχνολογικό Εκπαιδευτικό Ιδρυμα Κεντρικής Μακεδονίας - Σέρρες Τμήμα Μηχανικών Πληροφορικής Γραμμικός Προγραμματισμός & Βελτιστοποίηση Δρ. Δημήτρης Βαρσάμης Καθηγητής Εφαρμογών Δρ. Δημήτρης Βαρσάμης Μάρτιος

Τεχνολογικό Εκπαιδευτικό Ιδρυμα Κεντρικής Μακεδονίας - Σέρρες Τμήμα Μηχανικών Πληροφορικής Γραμμικός Προγραμματισμός & Βελτιστοποίηση Δρ. Δημήτρης Βαρσάμης Καθηγητής Εφαρμογών Δρ. Δημήτρης Βαρσάμης Μάρτιος

Τεχνικές Μείωσης Διαστάσεων. Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Τεχνικές Μείωσης Διαστάσεων Ειδικά θέματα ψηφιακής επεξεργασίας σήματος και εικόνας Σ. Φωτόπουλος- Α. Μακεδόνας 1 Εισαγωγή Το μεγαλύτερο μέρος των δεδομένων που καλούμαστε να επεξεργαστούμε είναι πολυδιάστατα.

Ασκήσεις μελέτης της 19 ης διάλεξης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Οικονομικό Πανεπιστήμιο Αθηνών, Τμήμα Πληροφορικής Μάθημα: Τεχνητή Νοημοσύνη, 2016 17 Διδάσκων: Ι. Ανδρουτσόπουλος Ασκήσεις μελέτης της 19 ης διάλεξης 19.1. Δείξτε ότι το Perceptron με (α) συνάρτηση ενεργοποίησης

Θεωρία Αποφάσεων ο. 4 Φροντιστήριο. Λύσεις των Ασκήσεων

Θεωρία Αποφάσεων ο Φροντιστήριο Λύσεις των Ασκήσεων Άσκηση Έστω ένα πρόβλημα ταξινόμησης μιας διάστασης με δύο κατηγορίες, όπου για κάθε κατηγορία έχουν συλλεχθεί τα παρακάτω δεδομένα: D = {, 2,,,,7 }

Θεωρία Αποφάσεων ο Φροντιστήριο Λύσεις των Ασκήσεων Άσκηση Έστω ένα πρόβλημα ταξινόμησης μιας διάστασης με δύο κατηγορίες, όπου για κάθε κατηγορία έχουν συλλεχθεί τα παρακάτω δεδομένα: D = {, 2,,,,7 }

ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - 02/07/08) ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ

Ονοματεπώνυμο:......... Α.Μ....... Ετος... ΑΙΘΟΥΣΑ:....... I. (περί τις 55μ. = ++5++. Σωστό ή Λάθος: ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - //8 ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ (αʹ Αν AB = BA όπου A, B τετραγωνικά και

Ονοματεπώνυμο:......... Α.Μ....... Ετος... ΑΙΘΟΥΣΑ:....... I. (περί τις 55μ. = ++5++. Σωστό ή Λάθος: ΓΡΑΜΜΙΚΗ ΑΛΓΕΒΡΑ (Εξ. Ιουνίου - //8 ΕΠΙΛΕΓΜΕΝΕΣ ΑΠΑΝΤΗΣΕΙΣ (αʹ Αν AB = BA όπου A, B τετραγωνικά και

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Bayesian decision Minimum misclassificaxon rate decision: διαλέγουμε την κατηγορία Ck για

ΤΕΧΝΟΛΟΓΙΚΟ ΕΚΠΑΙΔΕΥΤΙΚΟ ΙΔΡΥΜΑ ΚΕΝΤΡΙΚΗΣ ΜΑΚΕΔΟΝΙΑΣ ΣΧΟΛΗ ΤΜΗΜΑ. Μαθηματικά 1. Σταύρος Παπαϊωάννου

ΤΕΧΝΟΛΟΓΙΚΟ ΕΚΠΑΙΔΕΥΤΙΚΟ ΙΔΡΥΜΑ ΚΕΝΤΡΙΚΗΣ ΜΑΚΕΔΟΝΙΑΣ ΣΧΟΛΗ ΤΜΗΜΑ Μαθηματικά Σταύρος Παπαϊωάννου Ιούνιος 05 Τίτλος Μαθήματος Περιεχόμενα Χρηματοδότηση.. Σφάλμα! Δεν έχει οριστεί σελιδοδείκτης. Σκοποί Μαθήματος

ΤΕΧΝΟΛΟΓΙΚΟ ΕΚΠΑΙΔΕΥΤΙΚΟ ΙΔΡΥΜΑ ΚΕΝΤΡΙΚΗΣ ΜΑΚΕΔΟΝΙΑΣ ΣΧΟΛΗ ΤΜΗΜΑ Μαθηματικά Σταύρος Παπαϊωάννου Ιούνιος 05 Τίτλος Μαθήματος Περιεχόμενα Χρηματοδότηση.. Σφάλμα! Δεν έχει οριστεί σελιδοδείκτης. Σκοποί Μαθήματος

Διακριτά Μαθηματικά ΙΙ Χρήστος Νομικός Τμήμα Μηχανικών Η/Υ και Πληροφορικής Πανεπιστήμιο Ιωαννίνων 2018 Χρήστος Νομικός ( Τμήμα Μηχανικών Η/Υ Διακριτά

Διακριτά Μαθηματικά ΙΙ Χρήστος Νομικός Τμήμα Μηχανικών Η/Υ και Πληροφορικής Πανεπιστήμιο Ιωαννίνων 2018 Χρήστος Νομικός ( Τμήμα Μηχανικών Η/Υ Διακριτά και Πληροφορικής Μαθηματικά Πανεπιστήμιο ΙΙ Ιωαννίνων

Διακριτά Μαθηματικά ΙΙ Χρήστος Νομικός Τμήμα Μηχανικών Η/Υ και Πληροφορικής Πανεπιστήμιο Ιωαννίνων 2018 Χρήστος Νομικός ( Τμήμα Μηχανικών Η/Υ Διακριτά και Πληροφορικής Μαθηματικά Πανεπιστήμιο ΙΙ Ιωαννίνων

Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων»

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Τμήμα Πληροφορικής και Τηλεπικοινωνιών Πρόγραμμα Μεταπτυχιακών Σπουδών Διπλωματική Εργασία: «Συγκριτική Μελέτη Μηχανισμών Εκτίμησης Ελλιπούς Πληροφορίας σε Ασύρματα Δίκτυα Αισθητήρων» Αργυροπούλου Αιμιλία

Λυμένες ασκήσεις στροφορμής

Λυμένες ασκήσεις στροφορμής Θα υπολογίσουμε τη δράση των τελεστών κλίμακας J ± σε μια τυχαία ιδιοκατάσταση j, m των τελεστών J και Jˆ. Λύση Δείξαμε ότι η κατάσταση Jˆ± j, m είναι επίσης ιδιοκατάσταση των

Λυμένες ασκήσεις στροφορμής Θα υπολογίσουμε τη δράση των τελεστών κλίμακας J ± σε μια τυχαία ιδιοκατάσταση j, m των τελεστών J και Jˆ. Λύση Δείξαμε ότι η κατάσταση Jˆ± j, m είναι επίσης ιδιοκατάσταση των

3.7 Παραδείγματα Μεθόδου Simplex

3.7 Παραδείγματα Μεθόδου Simplex Παράδειγμα 1ο (Παράδειγμα 1ο - Κεφάλαιο 2ο - σελ. 10): Το πρόβλημα εκφράζεται από το μαθηματικό μοντέλο: max z = 600x T + 250x K + 750x Γ + 450x B 5x T + x K + 9x Γ + 12x

3.7 Παραδείγματα Μεθόδου Simplex Παράδειγμα 1ο (Παράδειγμα 1ο - Κεφάλαιο 2ο - σελ. 10): Το πρόβλημα εκφράζεται από το μαθηματικό μοντέλο: max z = 600x T + 250x K + 750x Γ + 450x B 5x T + x K + 9x Γ + 12x

Μηχανισµοί & Εισαγωγή στο Σχεδιασµό Μηχανών Ακαδηµαϊκό έτος: Ε.Μ.Π. Σχολή Μηχανολόγων Μηχανικών - Εργαστήριο υναµικής και Κατασκευών - 3.

ΜΗΧΑΝΙΣΜΟΙ & ΕΙΣΑΓΩΓΗ ΣΤΟ ΣΧΕ ΙΑΣΜΟ ΜΗΧΑΝΩΝ - 3.1 - Cpright ΕΜΠ - Σχολή Μηχανολόγων Μηχανικών - Εργαστήριο υναµικής και Κατασκευών - 2012. Με επιφύλαξη παντός δικαιώµατος. All rights reserved. Απαγορεύεται

ΜΗΧΑΝΙΣΜΟΙ & ΕΙΣΑΓΩΓΗ ΣΤΟ ΣΧΕ ΙΑΣΜΟ ΜΗΧΑΝΩΝ - 3.1 - Cpright ΕΜΠ - Σχολή Μηχανολόγων Μηχανικών - Εργαστήριο υναµικής και Κατασκευών - 2012. Με επιφύλαξη παντός δικαιώµατος. All rights reserved. Απαγορεύεται

ΔΙΑΧΕΙΡΙΣΗ ΠΕΡΙΕΧΟΜΕΝΟΥ ΠΑΓΚΟΣΜΙΟΥ ΙΣΤΟΥ ΚΑΙ ΓΛΩΣΣΙΚΑ ΕΡΓΑΛΕΙΑ. Data Mining - Classification

ΔΙΑΧΕΙΡΙΣΗ ΠΕΡΙΕΧΟΜΕΝΟΥ ΠΑΓΚΟΣΜΙΟΥ ΙΣΤΟΥ ΚΑΙ ΓΛΩΣΣΙΚΑ ΕΡΓΑΛΕΙΑ Data Mining - Classification Data Mining Ανακάλυψη προτύπων σε μεγάλο όγκο δεδομένων. Σαν πεδίο περιλαμβάνει κλάσεις εργασιών: Anomaly Detection:

ΔΙΑΧΕΙΡΙΣΗ ΠΕΡΙΕΧΟΜΕΝΟΥ ΠΑΓΚΟΣΜΙΟΥ ΙΣΤΟΥ ΚΑΙ ΓΛΩΣΣΙΚΑ ΕΡΓΑΛΕΙΑ Data Mining - Classification Data Mining Ανακάλυψη προτύπων σε μεγάλο όγκο δεδομένων. Σαν πεδίο περιλαμβάνει κλάσεις εργασιών: Anomaly Detection:

Μάθηση και Γενίκευση. "Τεχνητά Νευρωνικά Δίκτυα" (Διαφάνειες), Α. Λύκας, Παν. Ιωαννίνων

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

Μάθηση και Γενίκευση Το Πολυεπίπεδο Perceptron (MultiLayer Perceptron (MLP)) Έστω σύνολο εκπαίδευσης D={(x n,t n )}, n=1,,n. x n =(x n1,, x nd ) T, t n =(t n1,, t np ) T Θα πρέπει το MLP να έχει d νευρώνες

21 a 22 a 2n. a m1 a m2 a mn

Παράρτημα Α Βασική γραμμική άλγεβρα Στην ενότητα αυτή θα παρουσιαστούν με συνοπτικό τρόπο βασικές έννοιες της γραμμικής άλγεβρας. Ο στόχος της ενότητας είναι να αποτελέσει ένα άμεσο σημείο αναφοράς και

Παράρτημα Α Βασική γραμμική άλγεβρα Στην ενότητα αυτή θα παρουσιαστούν με συνοπτικό τρόπο βασικές έννοιες της γραμμικής άλγεβρας. Ο στόχος της ενότητας είναι να αποτελέσει ένα άμεσο σημείο αναφοράς και

Παραδείγματα Ιδιοτιμές Ιδιοδιανύσματα

Παραδείγματα Ιδιοτιμές Ιδιοδιανύσματα Παράδειγμα Να βρείτε τις ιδιοτιμές και τα αντίστοιχα ιδιοδιανύσματα του πίνακα A 4. Επίσης να προσδιοριστούν οι ιδιοχώροι και οι γεωμετρικές πολλαπλότητες των ιδιοτιμών.

Παραδείγματα Ιδιοτιμές Ιδιοδιανύσματα Παράδειγμα Να βρείτε τις ιδιοτιμές και τα αντίστοιχα ιδιοδιανύσματα του πίνακα A 4. Επίσης να προσδιοριστούν οι ιδιοχώροι και οι γεωμετρικές πολλαπλότητες των ιδιοτιμών.

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αναγνώριση Προτύπων Ι Ενότητα 3: Στοχαστικά Συστήματα Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται σε άδειες

Αριθμητική Ανάλυση και Εφαρμογές

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Αριθμητική Ολοκλήρωση Εισαγωγή Έστω ότι η f είναι μία φραγμένη συνάρτηση στο πεπερασμένο

Αριθμητική Ανάλυση και Εφαρμογές Διδάσκων: Δημήτριος Ι. Φωτιάδης Τμήμα Μηχανικών Επιστήμης Υλικών Ιωάννινα 07-08 Αριθμητική Ολοκλήρωση Εισαγωγή Έστω ότι η f είναι μία φραγμένη συνάρτηση στο πεπερασμένο

Ασκήσεις Φροντιστηρίου «Υπολογιστική Νοημοσύνη Ι» 5 o Φροντιστήριο

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Πρόβλημα ο Ασκήσεις Φροντιστηρίου 5 o Φροντιστήριο Δίνεται το παρακάτω σύνολο εκπαίδευσης: # Είσοδος Κατηγορία 0 0 0 Α 2 0 0 Α 0 Β 4 0 0 Α 5 0 Β 6 0 0 Α 7 0 Β 8 Β α) Στον παρακάτω κύβο τοποθετείστε τα

Αναγνώριση Προτύπων Ι

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

Αναγνώριση Προτύπων Ι Ενότητα 1: Μέθοδοι Αναγνώρισης Προτύπων Αν. Καθηγητής Δερματάς Ευάγγελος Τμήμα Ηλεκτρολόγων Μηχανικών και Τεχνολογίας Υπολογιστών Άδειες Χρήσης Το παρόν εκπαιδευτικό υλικό υπόκειται

4. ΚΕΦΑΛΑΙΟ ΕΦΑΡΜΟΓΕΣ ΤΟΥ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΥ FOURIER

4. ΚΕΦΑΛΑΙΟ ΕΦΑΡΜΟΓΕΣ ΤΟΥ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΥ FOURIER Σκοπός του κεφαλαίου είναι να παρουσιάσει μερικές εφαρμογές του Μετασχηματισμού Fourier (ΜF). Ειδικότερα στο κεφάλαιο αυτό θα περιγραφούν έμμεσοι τρόποι

4. ΚΕΦΑΛΑΙΟ ΕΦΑΡΜΟΓΕΣ ΤΟΥ ΜΕΤΑΣΧΗΜΑΤΙΣΜΟΥ FOURIER Σκοπός του κεφαλαίου είναι να παρουσιάσει μερικές εφαρμογές του Μετασχηματισμού Fourier (ΜF). Ειδικότερα στο κεφάλαιο αυτό θα περιγραφούν έμμεσοι τρόποι

Κοινωνικά Δίκτυα Αναζήτηση Πληροφοριών σε Δίκτυα

Κοινωνικά Δίκτυα Αναζήτηση Πληροφοριών σε Δίκτυα Ν. Μ. Σγούρος Τμήμα Ψηφιακών Συστημάτων, Παν. Πειραιώς sgouros@unipi.gr Δομή του WWW Ορισμός Προβλήματος Υποθέτουμε ότι οι πηγές πληροφοριών αναπριστώνται

Κοινωνικά Δίκτυα Αναζήτηση Πληροφοριών σε Δίκτυα Ν. Μ. Σγούρος Τμήμα Ψηφιακών Συστημάτων, Παν. Πειραιώς sgouros@unipi.gr Δομή του WWW Ορισμός Προβλήματος Υποθέτουμε ότι οι πηγές πληροφοριών αναπριστώνται

Εξόρυξη γνώμης πολιτών από ελεύθερο κείμενο

Δίκαρος Νίκος Δ/νση Μηχανογράνωσης κ Η.Ε.Σ. Υπουργείο Εσωτερικών. Τελική εργασία Κ Εκπαιδευτικής Σειράς Ε.Σ.Δ.Δ. Επιβλέπων: Ηρακλής Βαρλάμης Εξόρυξη γνώμης πολιτών από ελεύθερο κείμενο Κεντρική ιδέα Προβληματισμοί

Δίκαρος Νίκος Δ/νση Μηχανογράνωσης κ Η.Ε.Σ. Υπουργείο Εσωτερικών. Τελική εργασία Κ Εκπαιδευτικής Σειράς Ε.Σ.Δ.Δ. Επιβλέπων: Ηρακλής Βαρλάμης Εξόρυξη γνώμης πολιτών από ελεύθερο κείμενο Κεντρική ιδέα Προβληματισμοί

Τι είναι βαθμωτό μέγεθος? Ένα μέγεθος που περιγράφεται μόνο με έναν αριθμό (π.χ. πίεση)

TETY Εφαρμοσμένα Μαθηματικά Ενότητα ΙΙ: Γραμμική Άλγεβρα Ύλη: Διανυσματικοί χώροι και διανύσματα, μετασχηματισμοί διανυσμάτων, τελεστές και πίνακες, ιδιοδιανύσματα και ιδιοτιμές πινάκων, επίλυση γραμμικών

TETY Εφαρμοσμένα Μαθηματικά Ενότητα ΙΙ: Γραμμική Άλγεβρα Ύλη: Διανυσματικοί χώροι και διανύσματα, μετασχηματισμοί διανυσμάτων, τελεστές και πίνακες, ιδιοδιανύσματα και ιδιοτιμές πινάκων, επίλυση γραμμικών

Δρ. Βασίλειος Γ. Καμπουρλάζος Δρ. Ανέστης Γ. Χατζημιχαηλίδης

Μάθημα 5 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

Μάθημα 5 ο Δρ. Ανέστης Γ. Χατζημιχαηλίδης Τμήμα Μηχανικών Πληροφορικής Τ.Ε. ΤΕΙ Ανατολικής Μακεδονίας και Θράκης 2016-2017 Διευρυμένη Υπολογιστική Νοημοσύνη (ΥΝ) Επεκτάσεις της Κλασικής ΥΝ. Μεθοδολογίες

ΤΕΙ ΣΕΡΡΩΝ ΤΜΗΜΑ ΠΛΗΡΟΦΟΡΙΚΗΣ ΚΑΙ ΕΠΙΚΟΙΝΩΝΙΩΝ ΕΞΕΤΑΣΗ ΣΤΟ ΜΑΘΗΜΑ «ΑΝΑΓΝΩΡΙΣΗ ΠΡΟΤΥΠΩΝ ΝΕΥΡΩΝΙΚΑ ΔΙΚΤΥΑ» ΔΕ. 11 ΙΟΥΝΙΟΥ 2012

ΔΕ. ΙΟΥΝΙΟΥ Δίνονται τα εξής πρότυπα: [ ] [ ] [ ] [ ] Άσκηση η ( μονάδες) Χρησιμοποιώντας το κριτήριο της ομοιότητας να απορριφθεί ένα χαρακτηριστικό με βάσει το συντελεστή συσχέτισης. (γράψτε ποιο χαρακτηριστικό

ΔΕ. ΙΟΥΝΙΟΥ Δίνονται τα εξής πρότυπα: [ ] [ ] [ ] [ ] Άσκηση η ( μονάδες) Χρησιμοποιώντας το κριτήριο της ομοιότητας να απορριφθεί ένα χαρακτηριστικό με βάσει το συντελεστή συσχέτισης. (γράψτε ποιο χαρακτηριστικό

ΕΙΣΑΓΩΓΗ ΣΤΗ ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ ΣΥΣΤΗΜΑΤΩΝ

ΥΠΕΥΘΥΝΟΣ ΚΑΘΗΓΗΤΗΣ Α. Ντούνης ΔΙΔΑΣΚΩΝ ΑΚΑΔ. ΥΠΟΤΡΟΦΟΣ Χ. Τσιρώνης ΕΙΣΑΓΩΓΗ ΣΤΗ ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ ΣΥΣΤΗΜΑΤΩΝ ΜΑΘΗΜΑ ΔΕΥΤΕΡΟ - Διανύσματα - Πράξεις με πίνακες - Διαφορικός λογισμός (1D) ΜΑΘΗΜΑΤΙΚΟ ΥΠΟΒΑΘΡΟ

ΥΠΕΥΘΥΝΟΣ ΚΑΘΗΓΗΤΗΣ Α. Ντούνης ΔΙΔΑΣΚΩΝ ΑΚΑΔ. ΥΠΟΤΡΟΦΟΣ Χ. Τσιρώνης ΕΙΣΑΓΩΓΗ ΣΤΗ ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ ΣΥΣΤΗΜΑΤΩΝ ΜΑΘΗΜΑ ΔΕΥΤΕΡΟ - Διανύσματα - Πράξεις με πίνακες - Διαφορικός λογισμός (1D) ΜΑΘΗΜΑΤΙΚΟ ΥΠΟΒΑΘΡΟ

Ανάκληση Πληποφοπίαρ. Διδάζκων Δημήηριος Καηζαρός

Ανάκληση Πληποφοπίαρ Διδάζκων Δημήηριος Καηζαρός Διάλεξη 18η: 17/05/2017 1 Η μέθοδος BrowseRank 2 Εισαγωγή Η page importance, που αναπαριστά την αξία μιας σελίδας του Web, είναι παράγων-κλειδί για την

Ανάκληση Πληποφοπίαρ Διδάζκων Δημήηριος Καηζαρός Διάλεξη 18η: 17/05/2017 1 Η μέθοδος BrowseRank 2 Εισαγωγή Η page importance, που αναπαριστά την αξία μιας σελίδας του Web, είναι παράγων-κλειδί για την

HMY 795: Αναγνώριση Προτύπων

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Διαχωριστικές συναρτήσεις Ταξινόμηση κανονικών

HMY 795: Αναγνώριση Προτύπων Διάλεξη 5 Κατανομές πιθανότητας και εκτίμηση παραμέτρων Κατανομές πιθανότητας και εκτίμηση παραμέτρων δυαδικές τυχαίες μεταβλητές Διαχωριστικές συναρτήσεις Ταξινόμηση κανονικών

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Component Analysis, PCA)

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

ΣΤΟΧΑΣΤΙΚΕΣ ΔΙΕΡΓΑΣΙΕΣ & ΒΕΛΤΙΣΤΟΠΟΙΗΣΗ Αίθουσα 005 - Νέα Κτίρια ΣΗΜΜΥ Ε.Μ.Π. Ανάλυση Κυρίων Συνιστωσών (Principal-Coponent Analysis, PCA) καθ. Βασίλης Μάγκλαρης aglaris@netode.ntua.gr www.netode.ntua.gr

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis)

Η ΜΕΘΟΔΟΣ PCA (Principle Component Analysis) Η μέθοδος PCA (Ανάλυση Κύριων Συνιστωσών), αποτελεί μία γραμμική μέθοδο συμπίεσης Δεδομένων η οποία συνίσταται από τον επαναπροσδιορισμό των συντεταγμένων ενός